Как создавалась лицевая анимация персонажей в Marvel’s Guardians of the Galaxy

Полный цикл работы аниматоров Eidos Montreal.

На GDC 2022 ведущий технический аниматор Eidos Montreal Саймон Хабиб выступил с докладом о полном цикле создания лицевой анимации персонажей Marvel’s Guardians of the Galaxy, начиная от процесса сканирования актёров и заканчивая интеграцией контента в игру. Редакция «Геймдев» Skillbox Media делится основными тезисами из лекции. Во время просмотра видеовставок в этой статье не забудьте включить звук.

Из этого материала вы узнаете:

- на чём основывалось видение аниматоров Eidos Montreal;

- подробности процессов фотограмметрии и мокап-съёмок;

- каким образом отсканированные данные переносят в анимацию;

- как команда нашла баланс между количеством и качеством, разработав критерии бронзового, серебряного и золотого уровней анимаций.

Краткая информация о спикере и его вкладе в игру

Первые 10 лет своей карьеры Саймон Хабиб работал специалистом по риггингу. В спектр его задач входило создание ригов для лицевой анимации, двуногих персонажей, животных и транспорта, скиннинг, симуляция физики и разработка пайплайнов для риггеров.

В 2015 году Саймон занялся наработками в области лицевой анимации. Он всегда интересовался играми с упором на нарратив и хотел создавать анимации, которые бы передавали живые эмоции персонажей и вызывали отклик у игроков. Marvel’s Guardians of the Galaxy стала идеальным для этого проектом.

Игра получила хорошие оценки от критиков и пользователей. Например, сайт Rock, Paper, Shotgun отметил, что лицевая анимация персонажей ничуть не уступает оригинальным фильмам Marvel, а автор VG247 и вовсе посчитал её одной из лучших, что ему когда-либо приходилось видеть в играх такого плана.

Видео: доклад Саймона Хабиба на GDC 2022 / YouTube

Чем руководствовалась команда Eidos Montreal во время создания анимации

Повествование, сфокусированное на игре актёров

Приступая к работе над Marvel’s Guardians of the Galaxy, аниматоры понимали, что это сюжетная игра с акцентом на кинематографичность и пять главных персонажей, сражающихся плечом к плечу, будут в центре внимания. Несмотря на то, что для сходства с прототипами из комиксов герои были стилизованы, они должны были выглядеть убедительно в кадре, включая антропоморфных Ракету и Грута. Этого удалось добиться благодаря хорошо переданным живым эмоциям, сыгранным актёрами.

Технические инновации и подход к съёмкам

Команда проанализировала наработки мокапа в индустрии и выделила четыре технические инновации, которые и легли в основу анимаций будущих персонажей.

- Фотограмметрия. Как правило, во время разработки художники по персонажам создают новые образы на основе референсов. Фотограмметрия даёт возможность получить готовую отсканированную внешность реального человека, которая вполне подойдёт в качестве основы для будущего героя.

- Анимация на основе отснятых видеоматериалов. Во многих играх для создания лицевой анимации используют звуковые дорожки. Через звук можно реализовать точную синхронизацию движений губ, но возникает вопрос, как подтянуть к такой анимации остальные мышцы лица. Обычно в этом процессе задействована процедурная генерация, которая не всегда даёт удовлетворительные результаты. В случае, когда анимацию делают на основе видео, мимика персонажа получается более живой и утончённой.

- Наличие собственной студии мокапа и привлечение местных актёров. Аренда студии всегда замедляет производство, так как нужно рассчитать время на бронирование сеансов и обработку отснятых данных.

- Преимущества полного захвата актёрской игры. Как правило, многие разработчики игр записывают мокап и озвучку по отдельности, а затем объединяют все данные во время сборки кат-сцен. Но такой подход не всегда гарантирует целостность кадра. При производстве Marvel’s Guardians of the Galaxy запись голосов, лиц и движений актёров происходила одновременно, обеспечивая максимальную синхронность и естественность.

Количество и качество

Перед разработчиками нередко встаёт выбор между количеством и качеством. Работая над лицевой анимацией персонажей Marvel’s Guardians of the Galaxy, команда доказала, что можно найти компромиссное решение, если поделить контент на несколько уровней качества.

- Бронзовый уровень предполагает создание полностью автоматизированного рига, который практически не требует ручной доработки. Этот вид анимаций создан на основе машинного обучения с дальнейшим подбором эмоций под каждую реплику. Такие анимации использовали во время внутриигровых диалогов.

- Серебряный уровень наиболее близок к исходной актёрской игре, но, чтобы его добиться, нужна техническая и художественная доработка специалистов. Используется в большинстве кат-сцен.

- Золотой уровень получается за счёт доработки серебряных анимаций непосредственно в движке. Используется в ключевых моментах игры и для промоматериалов.

Ознакомившись с основными принципами аниматоров Eidos Montreal, рассмотрим подробнее каждый этап их рабочего процесса.

Процесс фотограмметрии

Фотограмметрия — это процесс получения сотен сканов объекта с разных ракурсов и создания 3D-модели на их основе. Так как в Marvel’s Guardians of the Galaxy стилизованная графика, внешность актёров не требовалось переносить на модели персонажей полностью. Перед командой встал выбор: либо сразу подобрать подходящего актёра и на его основе разработать концепт-арт героя, либо, наоборот, начать с дизайна, а затем подобрать модель под нарисованный типаж. Аниматоры остановились на втором варианте.

Кадр: доклад Саймона Хабиба на GDC / YouTube

Сканирование актёров проходило в специальной кабине, оборудованной компанией Pixel Light Effects. В этом помещении одновременно работало 40 зеркальных камер, а 5 софтбоксов обеспечивали хорошее рассеянное освещение без резких теней. В общей сложности команда провела 13 сеансов сканирования — по одному на каждого персонажа.

Перед сеансами на лицо модели чёрной подводкой для глаз наносили около 100 маркеров, благодаря которым художники по персонажам более детально отслеживали все изменения лицевых мышц во время съёмок. Модели изобразили 25 эмоций, на основе которых было создано 138 блендшейпов для дальнейшего риггинга.

С технической точки зрения процесс фотограмметрии происходил следующим образом:

- Полученные с камер снимки в расширении .cr2 проходили коррекцию цвета и тона в Lightroom Classic.

- Затем отредактированные изображения переносили в RealityCapture — программу, которая генерирует облако точек для объектов на снимке и создаёт меши высокого уровня детализации на их основе. В дальнейшем специалисты автоматизировали этот процесс.

- После этого команда конвертировала полученные меши во Wrap3, переносила на базовый меш персонажа, а затем дорабатывала стилизацию и расставляла акценты в ZBrush.

Ниже показана предварительная анимация на основе блендшейпов в Maya. Цель первого тестирования заключалась в том, чтобы максимально приблизить оцифрованную модель к внешности реального человека перед этапом стилизации.

В правом верхнем углу представлено несколько эмоций, показанных актёром, а чуть ниже — подборка эмоций, созданных на основе блендшейпов.

Захват актёрской игры

Для Marvel’s Guardians of the Galaxy разработчики использовали три типа захвата движений. Рассмотрим их подробнее.

Мокап для кат-сцен

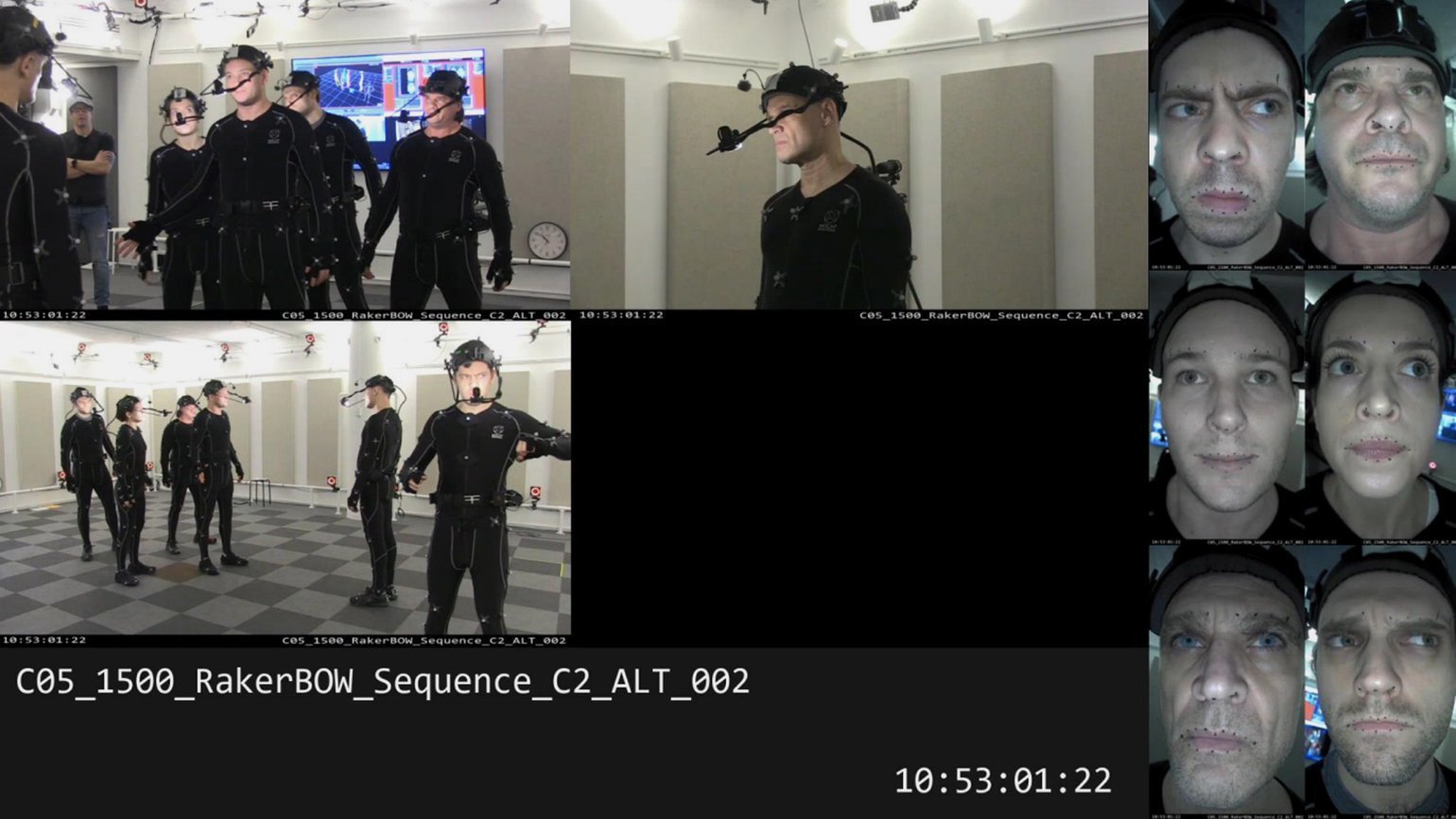

На снимке ниже показана комната, в которой проводились все сеансы мокапа для кат-сцен.

Кадр: доклад Саймона Хабиба на GDC / YouTube

По сравнению с павильонами, в которых обычно проходят съёмки мокапа других AAA-студий, помещение Eidos Montreal было относительно небольшим, но оно идеально подошло для записи диалогов, простых движений и даже некоторых трюков. В сеансах мокапа могли участвовать до семи человек одновременно. Почти все они носили на голове специальные крепления с камерой, которая находилась перед лицом актёра и фиксировала его мимику на видео. В наличии у студии было всего шесть таких устройств.

Захват движений был записан на систему OptiTrack, а лицевая анимация — с помощью Faceware. На фотографии выше видно, что у всех актёров с гарнитурой на голове также есть небольшой микрофон на креплении. Таким образом команда могла записывать звуковые дорожки, а затем объединять их в один аудиофайл.

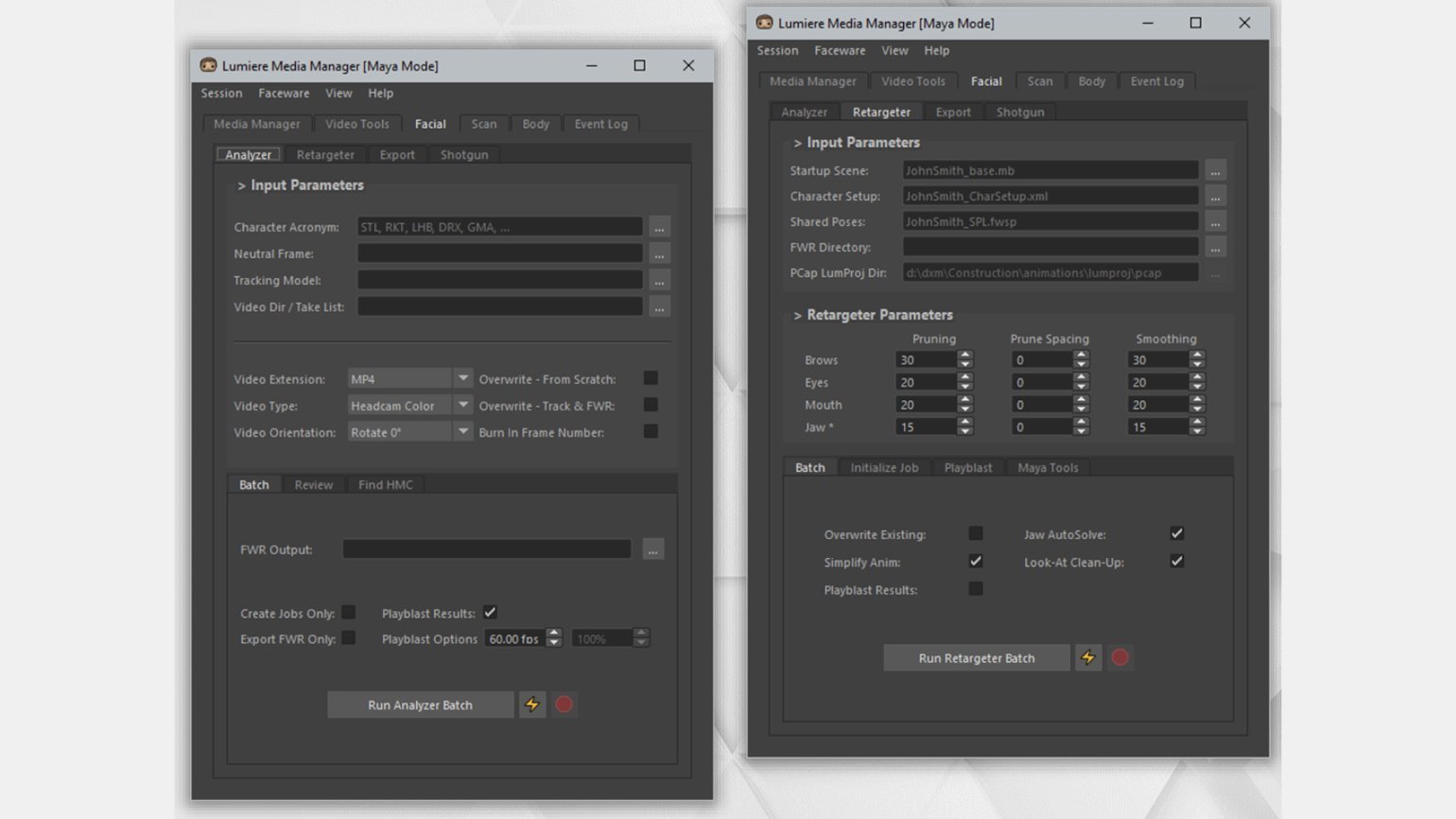

Во время съёмок важно синхронизировать данные захвата движений и лицевой анимации всех актёров, а также аудиодорожек и трёх референс-камер, расставленных по периметру помещения, — для этого в работе использовались общие тайм-коды. Кроме того, требовалось обеспечить одновременную запись на всех устройствах и сгруппировать файлы в определённой последовательности. Для этих задач команда разработала собственный плагин Lumiere.

Обычно за сеансом мокапа наблюдало около пяти человек: продюсер, директор по кат-сценам, специалист по мокапу, звукорежиссёр и, наконец, сам Саймон. Кроме того, на съёмочной площадке находились ассистенты, которые помогали актёрам надевать мокап-костюмы.

Несмотря на то, что съёмки проходили в комфортных условиях, последний год производства выдался достаточно напряжённым. Из-за пандемии коллективу пришлось соблюдать ряд ограничений и строгие правила социальной дистанции, включая ношение масок и защитных экранов и регулярное использование санитайзеров для рук. В студии установили камеру, которая записывала всё, что происходило на площадке; записи по необходимости транслировались в Zoom, что позволяло некоторым сотрудникам удалённо управлять съёмочным процессом прямо из дома и давать обратную связь через Slack.

На коллаже ниже представлена модель камеры Mark III от Faceware с креплением на шлем. Несмотря на то, что на момент производства Marvel’s Guardians of the Galaxy уже вышла четвёртая итерация устройства, аниматоры Eidos Montreal использовали в работе третью версию.

Кадр: доклад Саймона Хабиба на GDC / YouTube

Прикреплённая к шлему RGB камера обеспечивала картинку с разрешением 720p и частотой 60 кадров в секунду. Светодиодная подсветка с регулируемой яркостью, расположенная под камерой, смягчала жёсткий свет от фоновых осветительных приборов и сводила тени к минимуму. Для лучшей калибровки на лице актёра отмечали 27 точек, которые помогали отслеживать мимику в специальном ПО, — как в случае с фотограмметрией.

При необходимости специалисты периодически включали режим наложения сетки на мониторах и проверяли, что гарнитура не сместилась, а лицо актёра находится ровно в центре кадра. В перерывах между съёмками команда настраивала фокус объективов, чтобы поддерживать чёткость изображения для лучшего трекинга.

В процессе съёмки было важно, чтобы актёры чувствовали себя комфортно, и Mark III хорошо справлялась с этой задачей. Её вес был значительно меньше, чем у аналогичных девайсов, а из-за низкого расположения передней камеры и источников света она не перекрывала обзор актёру, позволяя лучше отыграть роль.

Кадр: доклад Саймона Хабиба на GDC / YouTube

На кадре выше справа расположены шесть вертикальных видео, записанных с помощью передней камеры, а в центре — подборка кадров с трёх референс-камер. Внизу указано название съёмки и тайм-код, который помогает синхронизировать все медиафайлы, в том числе отдельно записанные звуковые дорожки.

Видео: доклад Саймона Хабиба на GDC 2022 / YouTube

Данные фрагменты видео объединены через автоматизированный скрипт с использованием FFmpeg-команд. Режиссёр кат-сцен просматривает контент и склеивает лучшие дубли для первого чернового монтажа.

Разговорные сеансы

Другой тип захвата актёрской игры команда условно обозначила как «разговорные сеансы». На протяжении всей игры Стражи Галактики обмениваются репликами не только в кат-сценах, но и во время геймплея. Обычно при записи такого контента актёр находится в изолированной кабине и зачитывает строки одну за другой; при этом ему необязательно взаимодействовать с коллегами по съёмочной площадке. Но для Marvel’s Guardians of the Galaxy актёры записывали реплики вместе, находясь в одном пространстве. Такой подход помог сохранить химию между героями, а сами диалоги получились более искренними и динамичными.

Всего было записано 23 тысячи диалоговых строк. В процессе на актёрах всегда были надеты те самые шлемы с передней камерой. Отснятые видео с лицами использовались для создания лицевой анимации героев во время перемещения по локациям, боевых сцен и внутриигровых диалогов. Для того чтобы сопоставить аудио с соответствующим фрагментом из записанного видео, специалистам достаточно было проверить метаданные тайм-кода, встроенного в аудиодорожку.

Несмотря на то, что видеосъёмка фиксировала всю мимику, аниматоры в основном использовали только нижнюю часть лицевых мышц для синхронизации губ. Полные данные, снятые с лиц актёров, загружали в систему машинного обучения, которая отслеживала различные эмоции.

Кадр: доклад Саймона Хабиба на GDC / YouTube

Внутриигровые диалоги часто записывают с помощью стационарного или подвесного микрофона, и актёр всегда должен говорить в него, ограничивая себя в движении. Озвучка Marvel’s Guardians of the Galaxy и здесь была реализована иначе: микрофоны были прикреплены к шлемам, поэтому актёры могли свободно перемещаться во время сеансов записи и их движения никак не влияли на качество звука.

Видео: доклад Саймона Хабиба на GDC 2022 / YouTube

Несмотря на то, что подобные сессии могут длиться долго, на съёмках царила позитивная атмосфера. Саймон отмечает, что во время работы актёры часто смеялись и подшучивали друг над другом. Было заметно, что актёрам нравились их роли и они в них вжились.

Захват эмоций

Третий и последний тип захвата движений, который использовала команда, — захват эмоций. Во время этих сессий аниматоры просили актёров изобразить диапазон различных эмоций с разной степенью интенсивности. Полученный контент распределяли на четыре группы состояния персонажа: довольный, злой, нервный и грустный.

Во время разговора люди выражают эмоции в том числе с помощью невербальных жестов, причём так делают не только говорящие, но и слушающие, а жесты иногда зависят и от положения тела. Помня об этом, актёров распределили по парам, и они записывали свои беседы не только стоя, но и сидя. Благодаря этому у аниматоров появилась большая подборка различных жестов, отснятых в разных позах.

Как упоминалось ранее, выражения лиц, записанные во время разговорных сеансов, могли использоваться для отслеживания эмоции через машинное обучение: это помогало определить интенсивность эмоционального состояния персонажа. Программа подбирала соответствующую анимацию из библиотеки и переносила её на верхнюю часть лица и жесты. Подробнее об этом процессе можно узнать из доклада коллеги Саймона, Ромена Трачела.

Видео: выступление Саймона Хабиба на вебинаре Faceware / YouTube

На видео заметно, что движения губ, в том числе у антропоморфного персонажа, синхронизированы с репликами, а взгляд, шея и туловище автоматически поворачиваются в сторону говорящего. Этот процесс генерируется автоматически, и Саймон относит его к бронзовому уровню качества.

Пакетная обработка

Все данные с трёх типов сеансов преобразовывали в анимацию с помощью пакетной обработки. Это режим, который анализирует тысячи видеоматериалов, автоматически находит подходящую лицевую анимацию актёра и применяет её пробный вариант к соответствующему ригу персонажа. Для этого необходимо обучить ПО распознавать выражения лиц. Чтобы программа могла распознать, что та или иная анимация относится к определённому цифровому персонажу, за каждым актёром был закреплён так называемый профиль.

В рамках процесса машинного обучения создавалась модель трекинга, представляющая собой подборку мимики и форм губ, которые камера фиксировала на протяжении всей записи.

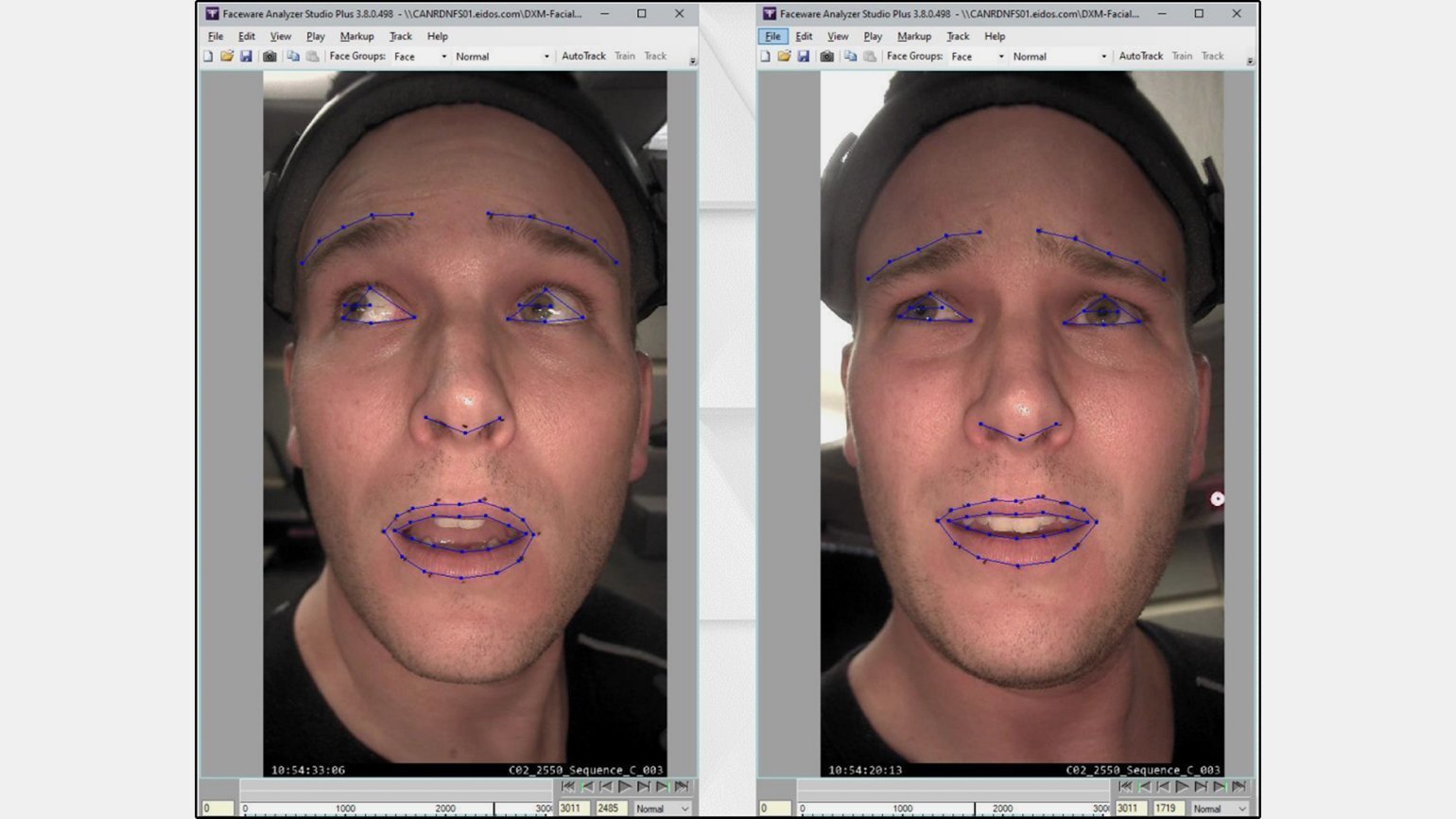

Кадр: GDC / YouTube

Саймон отмечает, что в машинном обучении важно придерживаться правила «меньше — больше», то есть идентифицировать только обучающие кадры, на которых выражение лица достигает пиковой точки. Таким образом лишние кадры не будут перегружать процесс и программе будет проще выполнять интерполяцию между различными выражениями лиц. Главное — соблюдать последовательность. Если в схожих выражениях будут какие-то расхождения, программа не поймёт, что с ними делать, и конечный результат трекинга может оказаться ненадёжным.

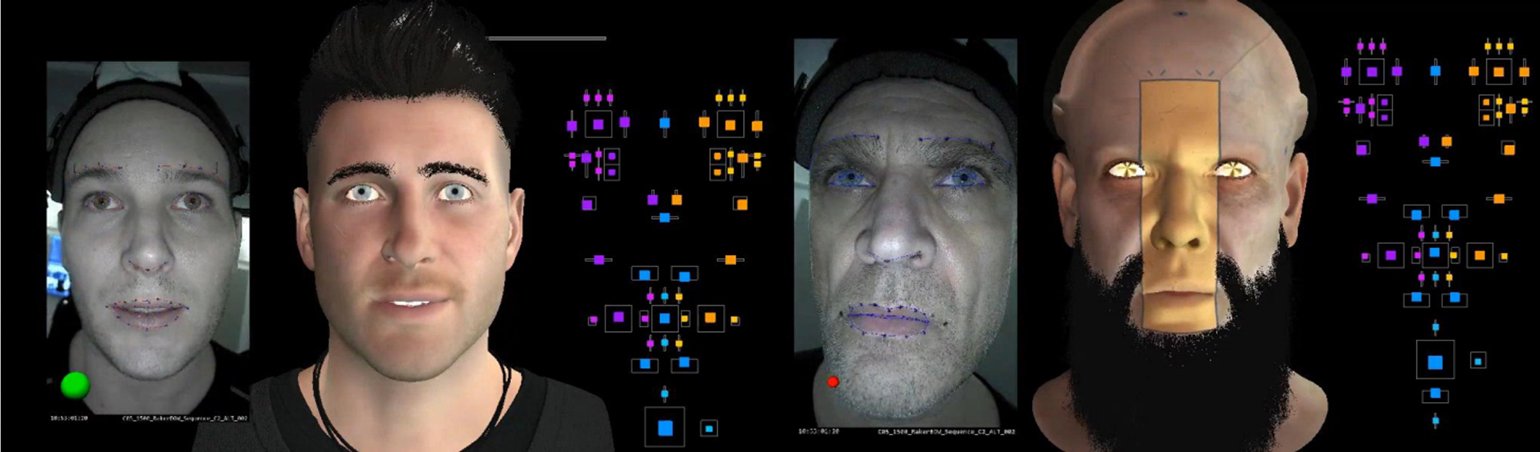

После обработки видео аниматоры повторяли аналогичный процесс в плагине Faceware Retargeter для Maya, чтобы создать библиотеку поз с соответствующими выражениями лиц для цифровых персонажей. В библиотеку вошло много ярко выраженных эмоций, но для расширения диапазона добавили и более умеренные. Также команда сохранила в мимике немного асимметрии. В итоге получилось 20 профилей персонажей, созданных благодаря технологии Faceware.

Кадр: доклад Саймона Хабиба на GDC / YouTube

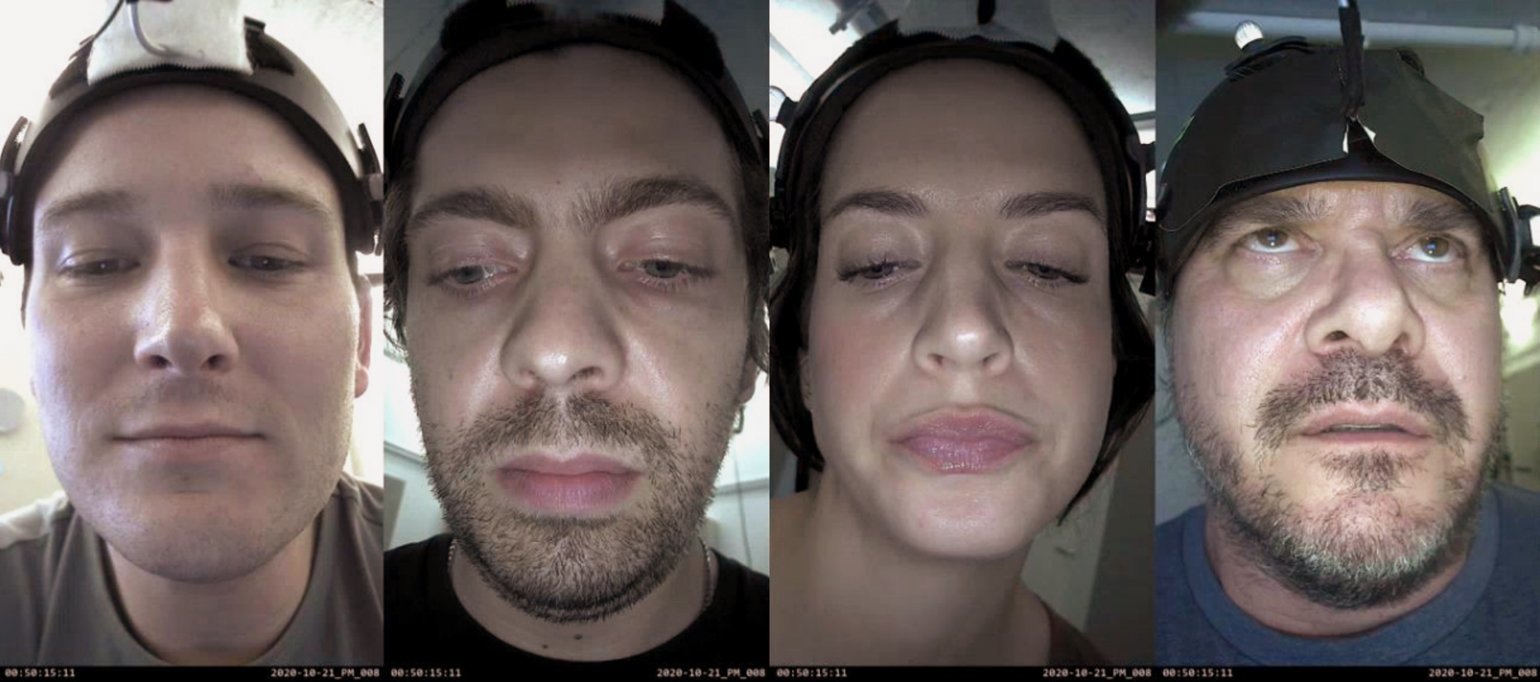

Запись диапазона мимики

Для создания каждого профиля в Faceware команда записывала лицевой ROM или диапазон мимики. Этот процесс происходил следующим образом.

Группе актёров давали задания изобразить различные эмоции. Сеанс записи начинался с простых движений глаз, бровей и губ по отдельности и заканчивался тем, что люди изображали эмоции с задействованием всех мышц лица. Общее время записи занимало около пяти минут.

Видео: доклад Саймона Хабиба на GDC 2022 / YouTube

Хотя подобные записи в основном проводились для создания профилей персонажей, в ходе съёмок обнаружились и другие плюсы. Во-первых, это неплохая вокальная разминка для актёров в начале рабочего дня. Во-вторых, на таких сеансах можно быстро настроить звук и проверить работу триггера одновременной записи на нескольких устройствах, включая встроенный тайм-код.

Именно поэтому команда Eidos Montreal проводила записи мимики перед каждой сессией, даже если уже не было необходимости снимать материал для новых профилей. Некоторые персонажи использовали один и тот же профиль лицевой анимации, созданный ещё в начале проекта. Потребность в новых профилях возникала в том случае, если к актёрскому составу присоединялся новый человек и его мимику требовалось перенести на цифровое альтер-эго.

Кинематографическая доработка

Этот этап подразумевал доработку существующих анимаций в техническом и художественном плане для достижения максимально точного и правдоподобного результата.

Саймон и ещё три человека из подразделения, отвечающего за кат-сцены, выполняли различные задачи, связанные с мокапом, — от помощи актёрам с мокап-снаряжением до настройки профилей в MotionBuilder. Полученные анимации чистились и переносились на соответствующий риг.

Для лицевой анимации использовали профили Faceware на базе диапазона мимики. Такой подход дал возможность произвести пакетную обработку анимаций бронзового уровня.

Производство лицевых анимаций серебряного уровня состояло из двух этапов. На технической стадии команда добивалась максимального сходства с мимикой актёров. Так как Faceware не отслеживает движения языка, его анимацию делали на основе ключевых кадров для сцен, где персонажи показаны крупным планом. На художественной стадии команда расставляла акценты на выражениях лиц персонажей в комичных моментах и добавляла асимметрию, полученную в результате пакетной обработки.

На видео ниже представлены два вида одной и той же лицевой анимации. Слева — бронзовая, сгенерированная автоматически, без ручной доработки. Справа — серебряная, после технической и художественной стадий.

Видео: выступление Саймона Хабиба на вебинаре Faceware / YouTube

Специалисты дорабатывали лицевой риг каждого персонажа по отдельности в пустой сцене без декораций, чтобы получить максимальную частоту кадров и не отвлекаться на окружение.

Кадр: доклад Саймона Хабиба на GDC / YouTube

В левом нижнем углу вертикальных видео можно заметить цветной круг. Этот индикатор помогает специалистам определить и доработать риг, когда лицо актёра выбивается из среднего крупного плана.

Закончив работу с данными мокапа и анимациями серебряного уровня, команда передавала готовый материал аниматорам кат-сцен, которые дорабатывали его непосредственно в движке. Они доводили анимацию до золотого уровня качества и собирали сцену, заполняя её персонажами, предметами, транспортом, попутно расставляя камеры в нужных ракурсах. Итоговый контент использовался не только в кат-сценах, но и в маркетинговых материалах.

В задачу специалистов по кат-сценам также входила работа с анимацией антропоморфных существ и животных, для которой нельзя напрямую использовать мокап человека. Например, для анимации Космо команда не делала мокап собачьей морды — однако в нескольких сценах участвовал четвероногий помощник Диего, которого одели в специальное снаряжение для захвата движения.

Кадры: WeRateDogs / Twitter

Кадры: WeRateDogs / Twitter

Кадры: WeRateDogs / Twitter

Стоит отметить, что пропорции антропоморфных персонажей кардинально отличаются от пропорций реального человека, поэтому аниматоры вручную дорабатывали риг таких персонажей, как Ракета.

Итог

Саймон и его команда проделали огромную работу, соблюдая баланс между количеством и качеством:

Видео: выступление Саймона Хабиба на вебинаре Faceware / YouTube

В перспективе аниматоры Eidos Montreal надеются, что общее качество анимаций, созданных на базе мокапа, станет ещё выше, а контент ниже золотого уровня можно будет дорабатывать непосредственно в сцене. Возможность предварительного просмотра анимаций в движке с готовым освещением и шейдерами значительно ускорит процесс, в отличие от предварительного рендеринга в Maya.