Цитата недели: «Такие задания больше использовать нельзя»

Эксперт по цифровизации образования — о том, как искусственный интеллект уже сейчас вынуждает менять подходы к преподаванию.

Иван Карлов

Руководитель лаборатории цифровой трансформации образования Института образования НИУ ВШЭ

Источник: «РБК+»

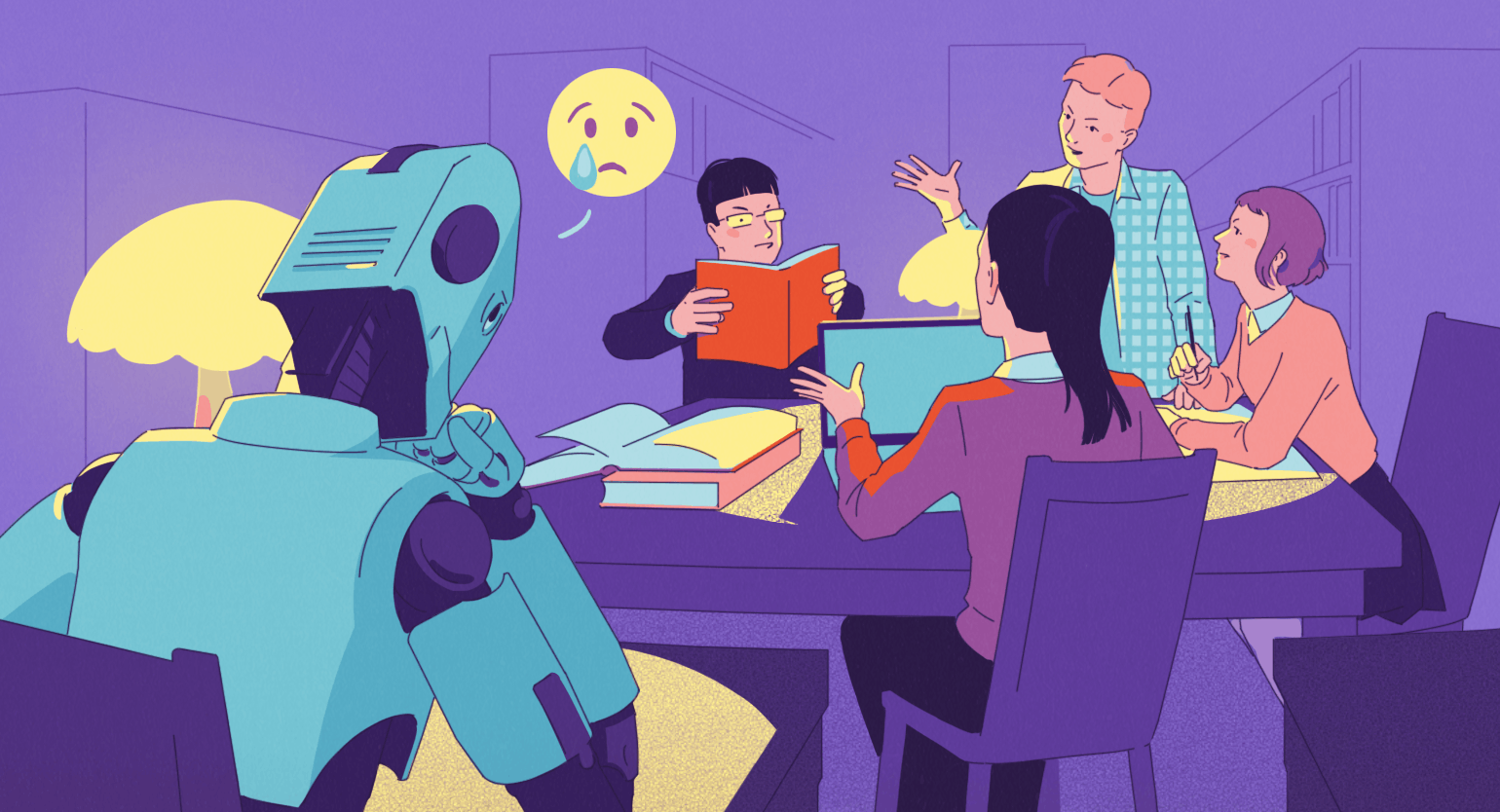

— Я некоторое время назад провёл эксперимент и выполнил с помощью нейросети задания, которые даю студентам. По трём из семи работ я получил такие ответы, за которые поставил бы высокую оценку, а значит, такие задания больше использовать нельзя. Придётся больше внимания уделять живому общению, применять другие формы контроля. Например, вместо линейного текста делать некие ментальные карты, которые покажут понимание взаимосвязей между понятиями, уровень систематизации знаний и так далее.

Контекст

В колонке для «РБК+» Иван Карлов высказал мнение, как быть с тем, что технологии генеративного искусственного интеллекта (ГИИ), способные в ответ на простой запрос выдавать тексты, изображения, видео и другой контент, ставят традиционные педагогические практики в «зону риска».

Речь о проблеме, которую за рубежом, прежде всего в США, заметили уже после релиза первой версии чат-бота ChatGPT: дело в том, что многие образовательные практики, особенно в гуманитарных предметах, «завязаны» на тексте — традиционно студентам дают много письменных заданий, таких как эссе, рефераты, курсовые. Выпускные квалификационные (дипломные) работы — тоже письменные. И такие учебные задания попросту перестали работать, потому что студенты и школьники теперь могут генерировать их с помощью нейросетей — и результаты зачастую неотличимы от качественной работы человека.

«Если раньше мы предполагали, что в сданном преподавателю тексте студент демонстрирует собственный навык написания эссе и аналитической работы, то при использовании студентом ГИИ-инструментов мы можем оценить только то, насколько с таким заданием хорошо справляется нейросеть», — так сформулировал эту проблему Иван Карлов.

Конечно, проблемы были и до появления технологий ГИИ — не секрет, что многие списывали или вообще покупали готовые работы. Просто ГИИ, похоже, окончательно «дисквалифицировали» такие задания, которые позволяют жульничать. Как справедливо заметил в прошлом году Евгений Патаракин, профессор департамента информатики, управления и технологий МГПУ, ведущий эксперт Лаборатории цифровой трансформации образования НИУ ВШЭ: «В самом студенческом читинге ничего не меняется. Ведь если студенту выгодно выдать чужой труд за свой, то какая разница, чем он воспользуется — купит работу, наймёт человека или запустит ChatGPT. Значит, надо строить обучение таким образом, чтобы это было невыгодно».

Что с этим делать? Нужно перестраивать работу, причём на нескольких уровнях:

- Преподавателям нужно разрабатывать задания, ответы на которые студенты не смогут просто так скопировать из диалогов с чат-ботами.

- На уровне целых университетов уже распространяются практики, когда использование ГИИ при подготовке курсовых и дипломных работ не только не запрещено, но даже поощряется (запрещать бессмысленно, так как студенты всё равно будут обходить эти запреты).

Например, в НИУ ВШЭ в этом году организовали среди студентов выпускных курсов конкурс лучших дипломных работ, выполненных с помощью нейросетей. В целом в вузе разрешено применять ГИИ, но при сдаче работы требуется указать, какие именно задачи и почему студент передал нейросетям. И «Вышка» в этом не одинока среди российских вузов: ранее о разрешении применять генеративные нейросети при подготовке учебных работ сообщали в МГПУ и в САФУ.

Однако есть причины, по которым перестроить так образовательные практики трудно. Иван Карлов их перечислил:

- Преподавателям требуется дополнительная подготовка для работы в новых условиях. Кстати, по данным недавнего опроса, проведённого исследователями из РАНХиГС, всего 16% преподавателей российских вузов сейчас регулярно используют ИИ в собственной работе. Существенно выше их доля только среди тех, кто преподаёт компьютерные науки, — 34%.

- Переход к новым типам заданий означает, что студенты будут применять навыки, для оценки которых ещё нет проверенных методик. Иван Карлов приводит пример с подготовкой дипломной работы: теперь не надо тратить время на написание текста — вместо этого студенту нужно быстро и правильно составлять промпты для нейросети, редактировать и верифицировать её ответы. Получается, и проверять необходимо именно эти навыки, а не сам текст. Но сложившейся и тиражируемой практики для того, чтобы оценивать качество работы с ИИ-инструментами, в образовании ещё нет, и это проблема.

Когда удастся преодолеть эти проблемы, большой вопрос. Диана Королёва, завлабораторией инноваций в образовании Института образования НИУ ВШЭ, однажды метко высказалась на эту тему так: «За 20 лет система образования не успела переварить Google, а тут у нас появляется новый чудовищный враг — ChatGPT, который не просто даёт ответ на прямой вопрос, а может и вопрос с подковыркой решить». А Михаил Кушнир, сотрудник Института общественных наук РАНХиГС, член правления Лиги образования и соавтор программ развития руководителей образования, отметил общую ригидность системы образования — она всегда очень медленно и трудно перестраивается на другие подходы.

Но игнорировать поставленные проблемы тоже нельзя. Дело в том, что феномен ГИИ ставит под сомнение актуальность самой идеи, на которой до сих пор строилась система образования и, соответственно, актуальность организации системы образования в целом — эту идею высказал год назад Павел Сорокин, завлабораторией исследований человеческого потенциала и образования Института образования ВШЭ.

Больше интересного про образование ― в нашем телеграм-канале. Подписывайтесь!

Читайте также:

- Российские эксперты представили три сценария внедрения ИИ в высшее образование

- «Яндекс Образование» и ВШЭ выпустили руководство по промптингу для преподавателей

- Нобелевский лауреат: эссе ChatGPT показывают студентам, как не надо думать

- Для преподавателей российских вузов составили карту полезных ИИ-инструментов