«Китайская комната» Джона Сёрла

Почему у ИИ до сих пор нет сознания и когда его ждать?

Современные нейросети пишут, спорят и даже шутят настолько убедительно, что их порой трудно отличить от человека. Но пока мы уверены, что они не осознают смысла своих слов. А если технологии будут развиваться, то когда у нейросетей появится это понимание?

Профессор Джон Сёрл задался тем же вопросом и опубликовал материал о мысленном эксперименте «Китайская комната». В этой статье мы рассмотрим его предпосылки, суть и основные аргументы критиков.

Но предупреждаем: можно поддерживать эксперимент, можно с ним не соглашаться, но пройти мимо сложно. Поэтому, если вы интересуетесь ИИ, после этой статьи у вас наверняка появится своё мнение о «Китайской комнате». Так что готовьтесь к горячим спорам с друзьями.

Содержание

- Как появилась идея машинного разума

- В чём суть мысленного эксперимента «Китайская комната»

- Аргументы критиков «Китайской комнаты»

- Чего не хватает ИИ — и почему важен 2045 год

Как появилась идея машинного разума

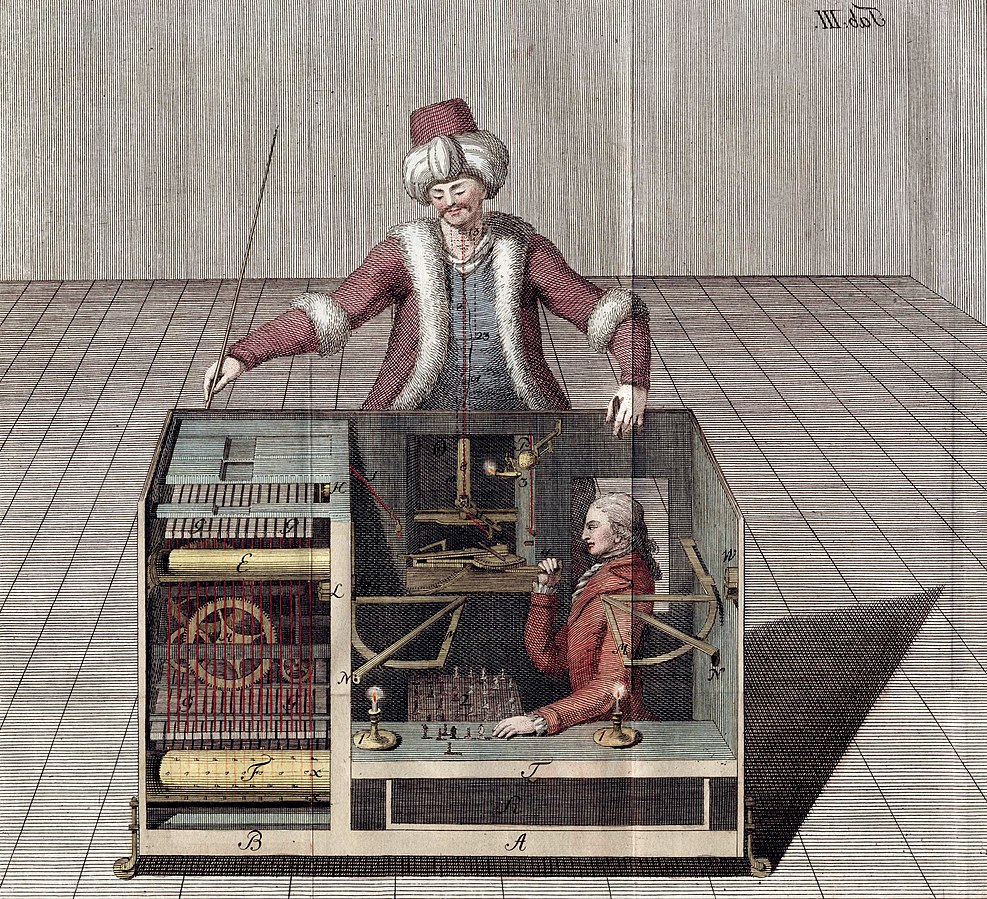

Представьте, что вы оказались в конце XVIII века, за двести с лишним лет до появления первого компьютера Apple. Чтобы развлечься, вы могли бы сыграть партию в шахматы против «Механического турка» — автомата, который самостоятельно передвигает фигуры и, на первый взгляд, осмысленно реагирует на ваши ходы. Этот необычный механизм создал венгерский изобретатель Вольфганг фон Кемпелен в 1770 году, чтобы впечатлить австрийскую императрицу Марию Терезию.

Конечно, на самом деле «Турок» был искусно спроектированным механизмом, маскирующим человека внутри. Однако, несмотря на это, его история стала одним из первых случаев, когда люди всерьёз задумались о реальной возможности создания искусственного разума.

Изображение: Joseph Racknitz / Wikimedia Commons

В 1950 году идея искусственного разума приобрела современные очертания благодаря статье «Вычислительные машины и разум». В этой работе математик Алан Тьюринг предположил, что способность машины мыслить можно определить по её поведению в разговоре с человеком, без сложных философских дискуссий о природе сознания.

Тогда же он предложил такой тест: если в переписке судья не может определить, общается ли он с программой или с другим человеком, то такую машину можно считать способной имитировать мышление.

Изображение: Juan Alberto Sánchez Margallo / Wikimedia Commons

После работ Тьюринга наступила эпоха ИИ-оптимизма, и одним из её первых представителей стал Джон Маккарти. В 1956 году он вместе с группой исследователей предположил, что человеческий разум можно формально описать как вычислительную систему, а все мыслительные процессы представить с помощью математических алгоритмов.

Эта идея вдохновила сотни исследователей и привела к появлению различных систем, которые довольно успешно имитировали поведение специалистов в разных областях. Например, в 1970-х появилась программа Mycin, которая помогала диагностировать инфекционные заболевания. Если врач вводил симптомы пациента с менингитом, Mycin могла предложить диагноз и порекомендовать оптимальную антибиотиковую терапию с учётом возможных аллергических реакций.

Некоторые учёные считали, что это первый шаг к созданию машин, которые смогут понимать и мыслить подобно человеку. Однако были и противники этой идеи: они сомневались, что имитации поведения достаточно для наличия подлинного мышления или сознания.

Читайте также:

В чём суть мысленного эксперимента «Китайская комната»

В 1980 году философ Джон Сёрл предложил эксперимент «Китайская комната», чтобы поставить под сомнение идею того, что любая программа, которая ведёт себя как человек, обладает сознанием. Например, если программа проходит тест Тьюринга, означает ли это, что она понимает смысл своих ответов?

Джон Сёрл делил искусственный интеллект на слабый и сильный. Слабый ИИ, по его мнению, — это когда компьютер лишь имитирует разумное поведение и решает узкоспециализированные задачи, как, например, система Mycin. А вот сильный ИИ — это уже машина, которая не просто имитирует поведение, но осознаёт происходящее.

Например, если чат-бот отвечает на вопросы о Шекспире, то, согласно концепции сильного ИИ, он должен не только генерировать правильные ответы на основе заложенных данных, но и действительно понимать содержание пьес, оценивать литературные приёмы и формировать собственные суждения, как это делает человек. Эксперимент Сёрла был направлен именно против такого понимания искусственного интеллекта.

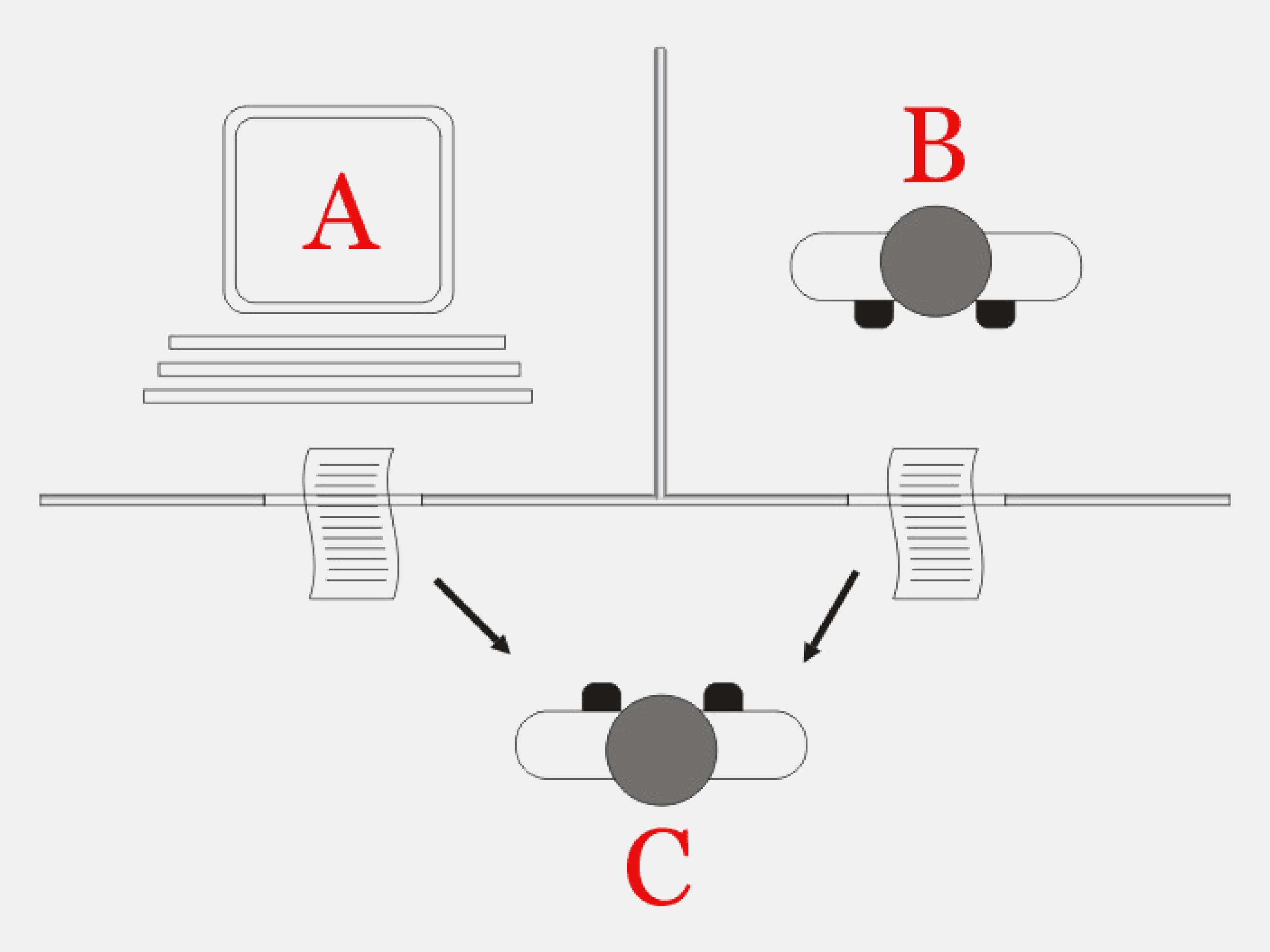

Представьте комнату, в которой вы полностью изолированы от внешнего мира. К вам поступают записки с текстами на китайском языке, которого вы не понимаете. Однако у вас есть подробная инструкция на русском языке: когда в комнату передают определённые китайские иероглифы, вы должны согласно инструкции написать в ответ другие иероглифы.

Допустим, вам передают фразу: 你好吗. Вы находите её в инструкции и видите, что нужно ответить: 我很好. Вы переписываете этот ответ и передаёте обратно. На самом деле вам задали вопрос: «Как дела?», а вы ответили: «У меня всё хорошо», при этом не поняв ни слова.

Иллюстрация: Polina Vari для Skillbox Media

Из эксперимента Джон Сёрл делает вывод, что имитация понимания — это не настоящее понимание. Человек в комнате действует чисто механически, не осмысливая ни вопрос, ни содержание ответа.

Так же и программа манипулирует символами, но не понимает их значения. Для неё существует только синтаксис, а не семантика, — формальная структура знаков, но не их смысл. Поэтому, даже если программа внешне выглядит как мыслящее существо, это не означает, что внутри неё возникнет подлинное понимание смысла.

Читайте также:

Аргументы критиков «Китайской комнаты»

С момента публикации в 1980 году эксперимент Джона Сёрла критикуют буквально за всё: за методологию, за неудачный выбор комнаты как метафоры, за её «китайскость», а также за то, что его аргументы устарели и неприменимы к современным нейросетям.

Тем не менее за 45 лет ни один критик не смог окончательно опровергнуть доводы Сёрла. Его эксперимент остаётся актуальным и часто упоминается в философских дискуссиях об искусственном интеллекте. Давайте рассмотрим основные возражения против позиции Сёрла и то, как он сам или его сторонники на них отвечают.

Эмерджентное понимание

Этот аргумент опирается на концепцию эмерджентности — появления новых свойств у целого, которых нет у отдельных частей. Например, в мозге ни один нейрон сам по себе не обладает сознанием, но их совокупность порождает сознание. Из-за этого неважно, понимает ли человек в комнате китайский язык. Главное, что вся система в целом (человек, инструкция, окружение) демонстрирует поведение, которое идентично пониманию.

То есть, когда мы говорим, что компьютер «распознал лицо» на фотографии, сам процессор ничего не «видит». Однако камера, алгоритмы обработки изображений, программное обеспечение и дисплей — вся система может вести себя так, что внешне её действия не отличить от распознавания. Поэтому система способна формировать осмысленные ответы на основе полученной информации.

Сёрл отвечает: предположим, я выучу все правила и буду выполнять их в уме. Однако даже тогда я не пойму ни слова по-китайски — я лишь научусь манипулировать символами по заданным алгоритмам. И если я, как часть системы, не понимаю смысла, то и вся система не обладает этим пониманием. Получается, что внешне согласованное поведение не доказывает наличие подлинного осознания.

Аналогично система «человек — инструкция — комната» может демонстрировать признаки понимания китайского языка на системном уровне, даже если отдельный человек внутри неё механически манипулирует символами, не осознавая их смысла

Изображение: Yewenyi / Wikimedia Commons

Функционализм и машинное мышление

Сторонники функционализма считают, что сознание — это функция, а не материя. По их мнению, если система проявляет мыслительное поведение, значит, она мыслит. При этом неважно, из чего она состоит: из нейронов, микросхем или других компонентов. Если результат одинаков, то и природа сознания считается идентичной.

Это как с часами: они могут быть механическими, электронными или песочными, но все выполняют одну и ту же функцию — измеряют время. Так же и сознание можно реализовать на разных носителях.

Сёрл возражает: симуляция сознания — это не само сознание. Например, модель желудка может точно воспроизводить процесс пищеварения, но сама пищу не переваривает. Или, например, авиатренажёр может имитировать полёт, но физически не отрывается от земли. Как бы точно ни была создана симуляция, она всегда остаётся имитацией, а не настоящим процессом.

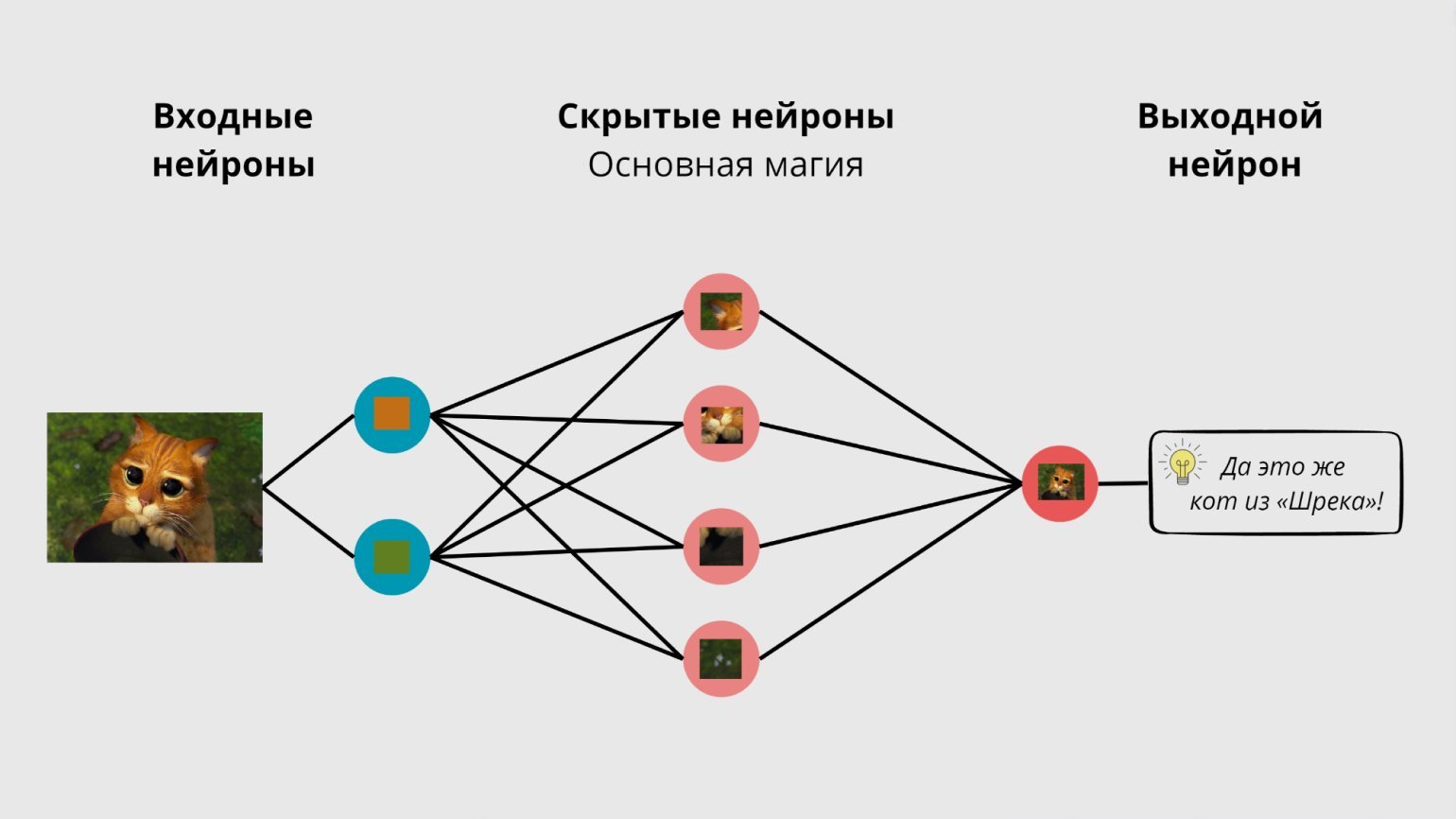

Эволюция генеративных моделей

Джон Сёрл предложил эксперимент в 1980 году, когда программы работали по символическим правилам и манипулировали знаками по принципу «если X, то Y». Например: «видишь иероглиф 水 — ответь „вода“». Такие системы не понимали, что 水 действительно означает воду или что вода — это жидкость, необходимая для жизни.

Современные нейросети учатся на огромных массивах текстов, используют вероятностные модели с миллиардами параметров и анализируют сложные связи между словами. Например, GPT-4 не просто следует правилу «если символ X, то символ Y», а формирует многомерные векторные представления значений слов и на их основе предсказывает наиболее уместное продолжение текста — с учётом контекста, стиля, темы и даже намерений собеседника.

Например, фразы «я набираю воду в ванну» и «я набираю номер телефона» содержат слово «набираю», но его значение зависит от контекста. Современные модели умеют различать такие нюансы и выбирать подходящее продолжение для каждой ситуации. С технической точки зрения это принципиально отличается от простых символьных манипуляций, о которых писал Джон Сёрл.

Сторонники Сёрла возражают: несмотря на сложность и масштаб современных моделей, их принцип работы остался прежним. Даже самые совершенные нейросети не обладают пониманием смысла слов — они рассчитывают вероятности последовательностей на основе статистических паттернов. По сути, это всё та же манипуляция символами, только гораздо более сложная и быстрая.

Изображение: Skillbox Media

Чего не хватает ИИ — и почему важен 2045 год

В момент публикации этой статьи аргументы Джона Сёрла выглядят вполне убедительно: нет доказательств и предпосылок к тому, что у современных ИИ может появиться сознание. Однако есть отдельная категория критиков, доводы которых, на наш взгляд, заслуживают особого внимания. Они предлагают рассматривать проблему в перспективе — с учётом возможного развития технологий в будущем.

Представьте, что инженеры создали чипы, которые способны имитировать работу нейронов мозга. Если постепенно заменять нейроны на такие устройства, человек будет продолжать ощущать себя прежним — его память, поведение и восприятие не изменятся. Например, если заменить 10%, 50%, а затем все 100% нейронов, мы, скорее всего, не заметим момент, когда сознание «выключится». В итоге мозг станет цифровым, но сохранит свою идентичность.

Критики утверждают, что если личность и сознание сохраняются на каждом этапе замены нейронов, то нет причин считать, что полная цифровизация создаст лишь симуляцию. По их мнению, сознание определяется не материалом, а структурой и организацией процессов. Это напоминает наше восприятие музыки — неважно, звучит ли она с пластинки, компакт-диска или цифрового файла, мелодия остаётся той же самой, пока сохраняется её структура.

Джон Сёрл считает себя сторонником теории биологического натурализма. По его мнению, сознание — реальное биологическое явление, возникающее благодаря специфическим процессам в мозге. Как желудок переваривает пищу, так и мозг порождает сознание в сложных нейробиологических процессах, которые пока невозможно имитировать никакой программой, независимо от её сложности.

Однако даже Сёрл допускает, что наука может однажды раскрыть физические механизмы, которые лежат в основе сознания. И если эти механизмы удастся точно воспроизвести в искусственной системе, тогда программа теоретически сможет обрести подлинное сознание. Возможно, это будут микрочипы, имитирующие работу нейронов мозга, а возможно, совершенно иной механизм.

Но пока природа этих нейробиологических процессов неизвестна, все цифровые системы, по мнению Сёрла, представляют собой лишь сложную симуляцию сознания, а не его настоящего носителя.

Иллюстрация: Polina Vari для Skillbox

Специалисты по-разному прогнозируют срок появления сильного ИИ. На наш взгляд, внимания заслуживает мнение Рэя Курцвейла — известного футуролога, чьи предсказания сбывались с точностью около 86%. По его прогнозу, к 2029 году ИИ достигнет человеческого уровня, сможет уверенно пройти тест Тьюринга и станет почти неотличим от человека в общении и решении сложных задач.

Курцвейл считает, что в 2045 году наступит сингулярность — момент, когда ИИ превзойдёт человеческий интеллект и начнёт самосовершенствоваться с недостижимой скоростью (появится Супер-ИИ). По его мнению, к этому времени искусственный интеллект станет главным драйвером всех инноваций и радикально преобразит мир — гораздо масштабнее, чем когда-то это сделал интернет. Не знаем, как вам, а нам страшно и безумно интересно.

Читайте также:

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!