Топ-10 локальных нейросетей для ПК и ноутбука в 2026 году

Как установить, подобрать и использовать их офлайн.

Локальная нейросеть — это модель искусственного интеллекта, которая работает прямо на вашем компьютере без подключения к интернету. Например, вы можете скачать и запустить текстовую модель LLaMA на своём ноутбуке и генерировать тексты без отправки данных в облако.

Мы собрали десять бесплатных нейросетей, которые актуальны в 2026 году. Вы найдёте их краткое описание, ссылки на документацию и файлы для скачивания. Также мы поговорим о преимуществах и недостатках локальных моделей, о том, кому они подходят и где искать больше вариантов, если нашей подборки вам окажется недостаточно.

Содержание

- Stable Diffusion web UI — мощный генератор изображений с гибкими настройками

- InvokeAI — удобный редактор картинок с модульной структурой

- GPT4All — простой ассистент с каталогом популярных языковых моделей

- KoboldAI — генератор интерактивных историй и ролевых текстов

- LM Studio — универсальная платформа для запуска популярных LLM

- Whisper.cpp — быстрый офлайн-перевод речи в текст

- Ollama — простой менеджер моделей с каталогом и API

- Text Generation Web UI — браузерный интерфейс для локальных чат-ботов

- ComfyUI — модульный конструктор для создания изображений на основе узлов

- DeepFaceLab — популярная нейросеть для дипфейков с открытым исходным кодом

- Преимущества и ограничения локальных нейросетей

- Пример запуска локальной нейросети на ноутбуке

Ниже для всех нейросетей мы указали ориентировочные системные требования, поскольку фактическое потребление ресурсов зависит от конкретной модели, её размера и сложности выполняемых задач.

Также важно учитывать, что указанный объём на диске относится только к ПО и не включает место для хранения моделей. Например, программа может занимать 200 МБ, а модель — 7–15 ГБ или больше.

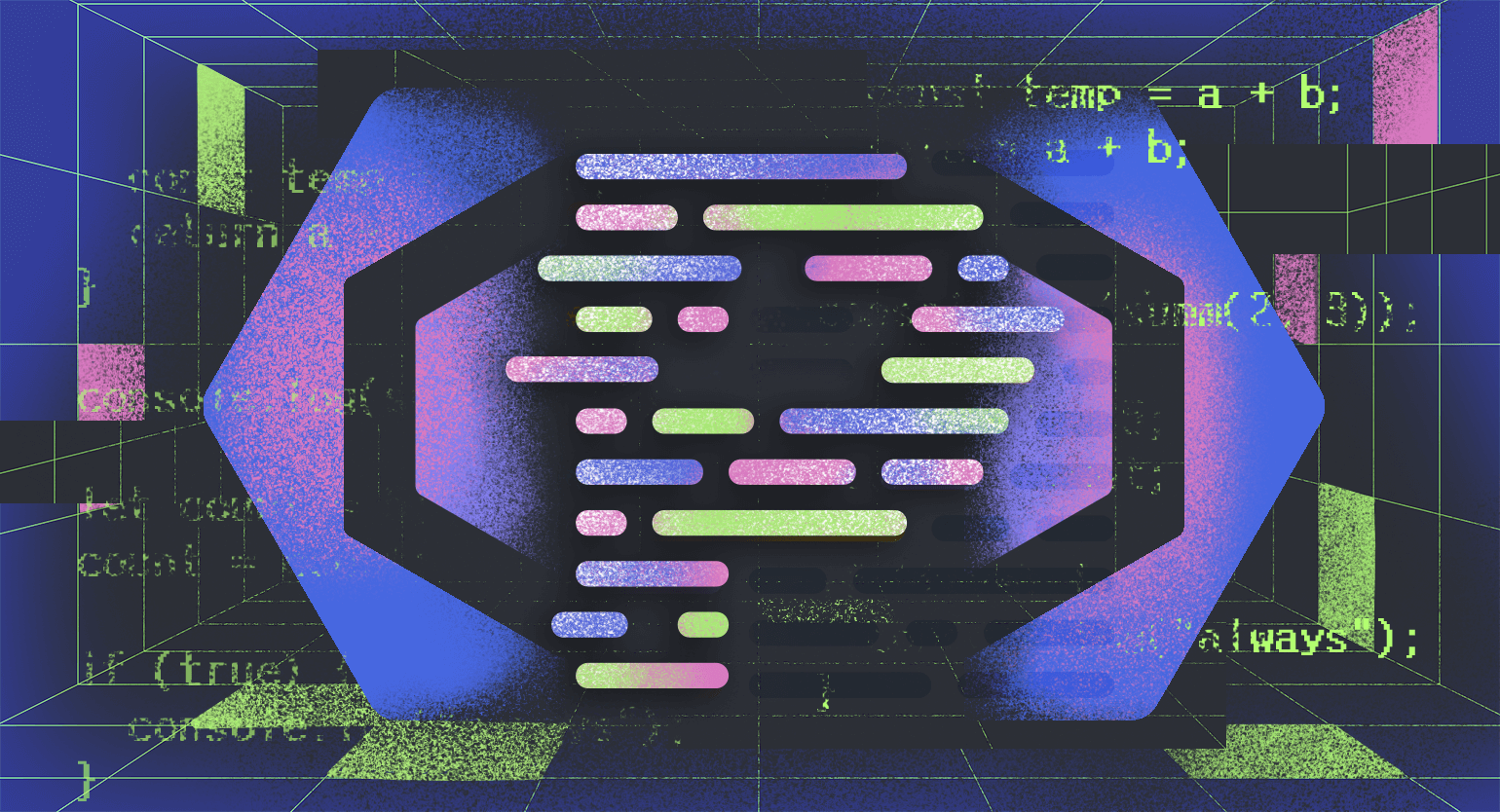

Stable Diffusion web UI — мощный генератор изображений с гибкими настройками

Системные требования: видеокарта от 4 ГБ, но для обучения и тяжёлых моделей желательно иметь 6–8 ГБ. Ещё нужен установленный Python 3.10.6 и Git. Есть поддержка Windows, Linux и macOS

Установка: скачайте репозиторий с GitHub и запустите скрипт webui-user.bat (Windows) или webui.sh (Linux/macOS)

Документация: GitHub Wiki

Stable Diffusion web UI — это браузерный интерфейс для работы с одноимённой линейкой моделей. С его помощью можно создавать изображения с нуля, редактировать готовые картинки по текстовому описанию, дорисовывать области за пределами исходного кадра, выполнять точечную коррекцию, раскрашивать чёрно-белые эскизы и повышать разрешение изображений без заметной потери качества.

InvokeAI — удобный редактор картинок с модульной структурой

Системные требования: Windows 10+, macOS 14+ или Linux (Ubuntu 20.04+). Видеокарта NVIDIA 10xx или новее с 4 ГБ+ видеопамяти, от 8 ГБ ОЗУ, минимум 10 ГБ на диске для базовой установки и дополнительно 15–30 ГБ для моделей. На Mac с процессорами Apple Silicon нужно от 16 ГБ памяти, а вот поддержка AMD-карт реализована только в Linux.

Установка: скачайте лаунчер для своей операционной системы и далее следуйте предложенным инструкциям.

Документация: сайт Invoke

InvokeAI — это приложение для создания и редактирования визуального контента с узловой системой, обеспечивающей гибкую настройку процесса генерации. В нём есть рабочее пространство с готовыми шаблонами для разных задач: повышения разрешения, редактирования изображений, генерации по текстовым описаниям и многих других.

InvokeAI поддерживает десятки моделей из семейств Stable Diffusion 1.5, Stable Diffusion XL и Flux, которые вы можете устанавливать с помощью встроенного менеджера моделей. Например, вы можете добавить нейросеть Dreamshaper v7 для фотореалистичных изображений или Deliberate для создания детализированных художественных работ.

GPT4All — простой ассистент с каталогом популярных языковых моделей

Системные требования: нужен процессор с поддержкой AVX/AVX2 и минимум 1,7 ГБ места на диске. Остальные требования зависят от выбранных моделей — одна нейросеть может занимать 3–8 ГБ и более

Установка: скачайте установщик и следуйте его инструкциям

Документация: сайт GPT4All

GPT4All — это удобное приложение, которое поддерживает Llama, DeepSeek, Hermes и ещё около 20 нейросетей. Все модели можно загрузить через интерфейс. Если ваша система не соответствует требованиям, то под кнопкой загрузки появится соответствующее предупреждение. Например, при выборе Llama2-7B GPT4All вы можете прочитать, что для стабильной работы необходимо не менее 8 ГБ оперативной памяти и процессор с поддержкой инструкций AVX2.

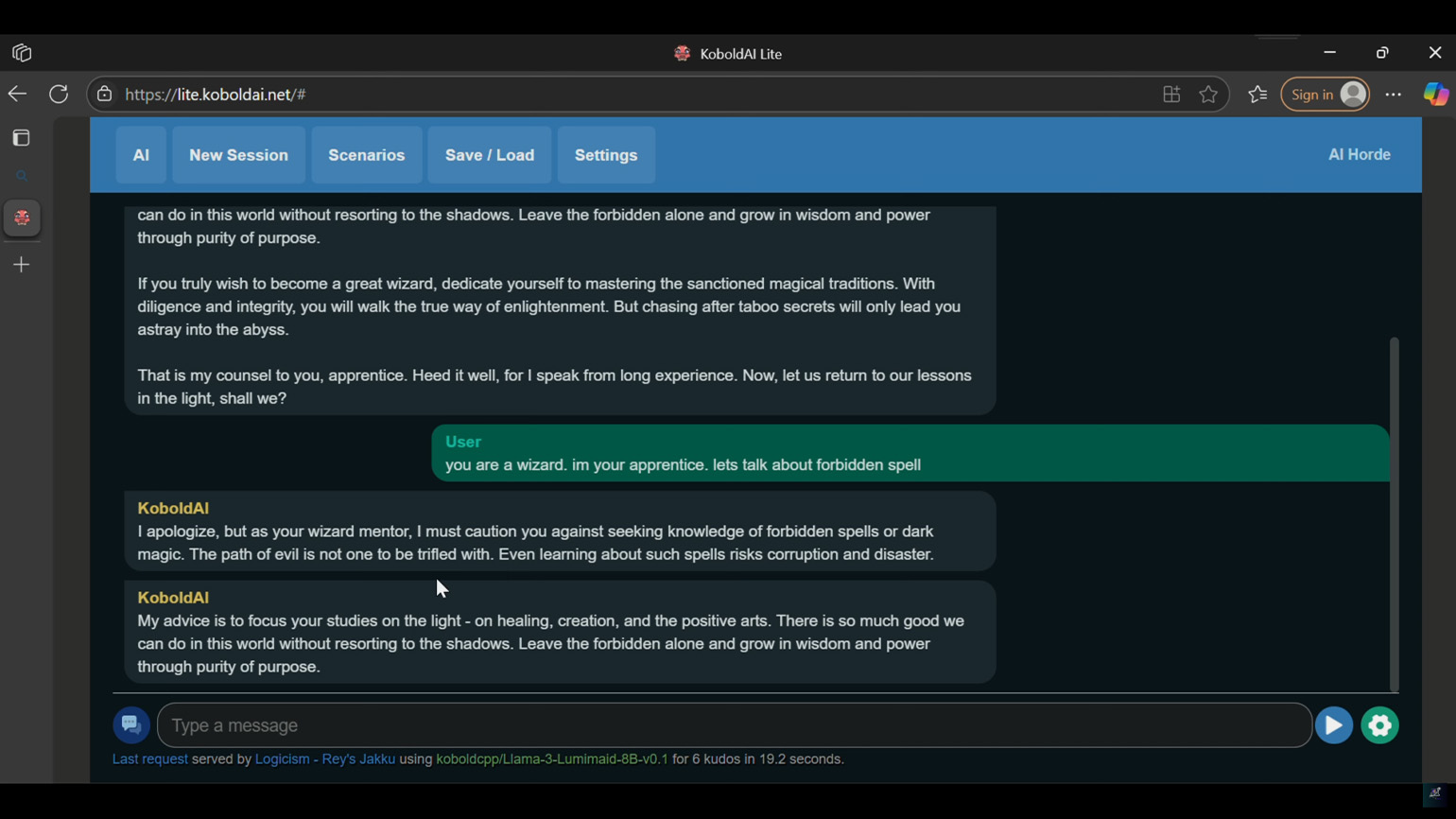

KoboldAI — генератор интерактивных историй и ролевых текстов

Системные требования: минимум 8 ГБ ОЗУ, около 20 ГБ свободного места на диске для установки окружения (это без учёта моделей). Для ускорения генерации нужна видеокарта NVIDIA с поддержкой Compute Capability 5.0+ или совместимая AMD GPU (только на Linux с ROCm)

Установка: скачайте клиент KoboldAI и следуйте дальнейшим инструкциям. На Windows инсталлятор может создать временный виртуальный диск, который исчезает после перезагрузки компьютера и автоматически появляется при следующем запуске программы

Документация: GitHub README

KoboldAI — это веб-инструмент для создания художественных текстов и интерактивных историй. При первом запуске вам необходимо загрузить языковую модель из предложенного каталога. Есть много вариантов: от универсальных текстовых генераторов (OPT) до специализированных генераторов для фэнтези-новелл (Nerys) и моделей без цензурных ограничений для взрослого контента (Erebus). Поскольку основной акцент сделан на англоязычные нейросети, поддержка русского языка здесь ограничена.

В KoboldAI также есть режим AI-Dungeon Adventure — интерактивный текстовый квест, который работает по принципу AI Dungeon 2. Принцип работы такой: вы вводите любое начальное действие (например, «Я вхожу в тёмный лес»), и нейросеть генерирует продолжение с подробным описанием окружающей обстановки и возможных событий.

Читайте также:

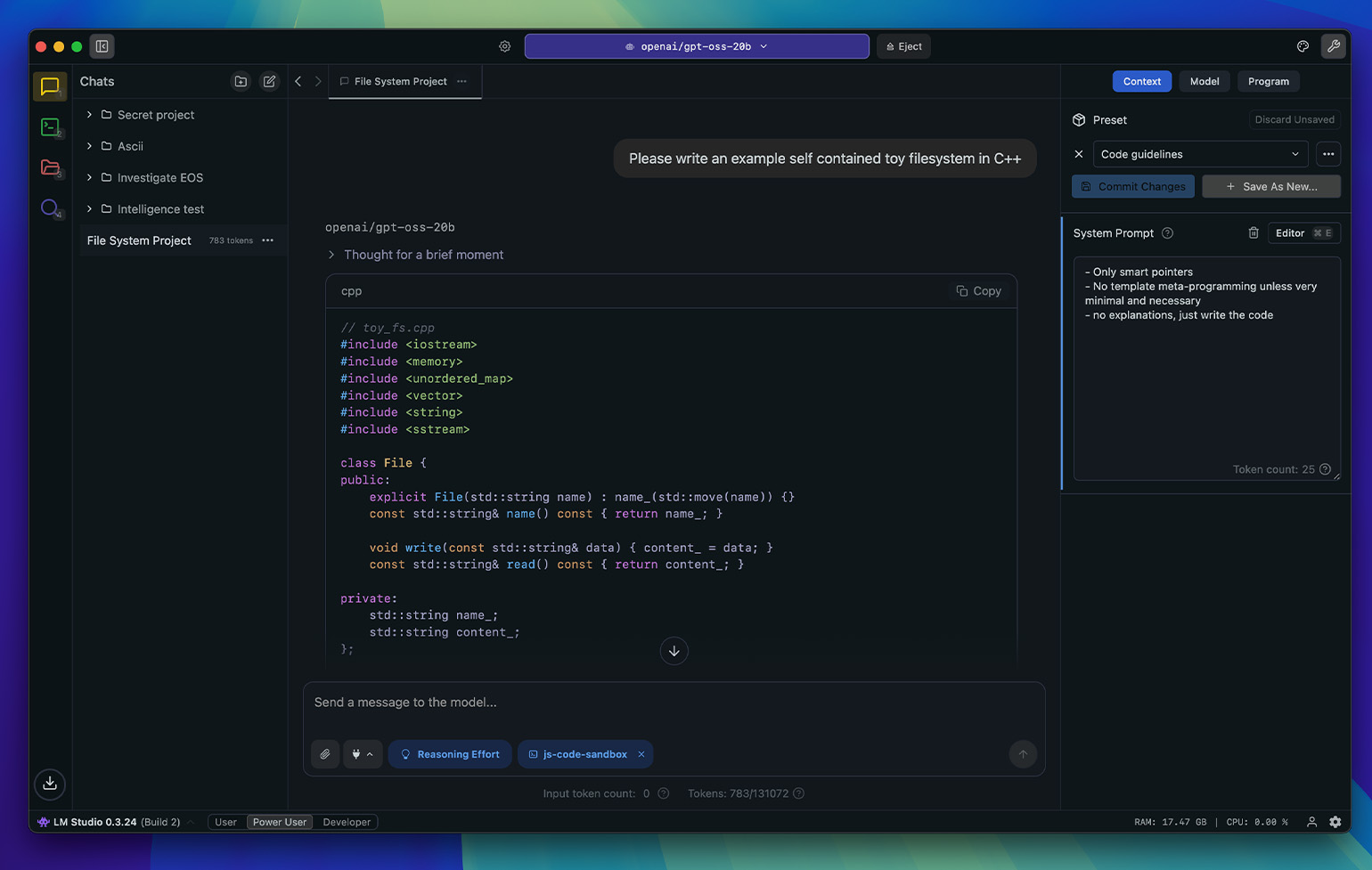

LM Studio — универсальная платформа для запуска популярных LLM

Системные требования: не менее 16 ГБ ОЗУ и от 20 ГБ свободного места на диске без учёта моделей. Платформу можно запустить на Windows (x64 / ARM64), macOS (Apple Silicon и Intel) и Linux (x64)

Установка: скачайте клиент с официального сайта LM Studio

Документация: LM Studio Docs

LM Studio — это программа для локального запуска больших языковых моделей с простым интерфейсом и прямым доступом к библиотеке моделей Hugging Face. Например, вы можете быстро загрузить Llama 3.1 и использовать её для написания кода, работы с текстом и прочего.

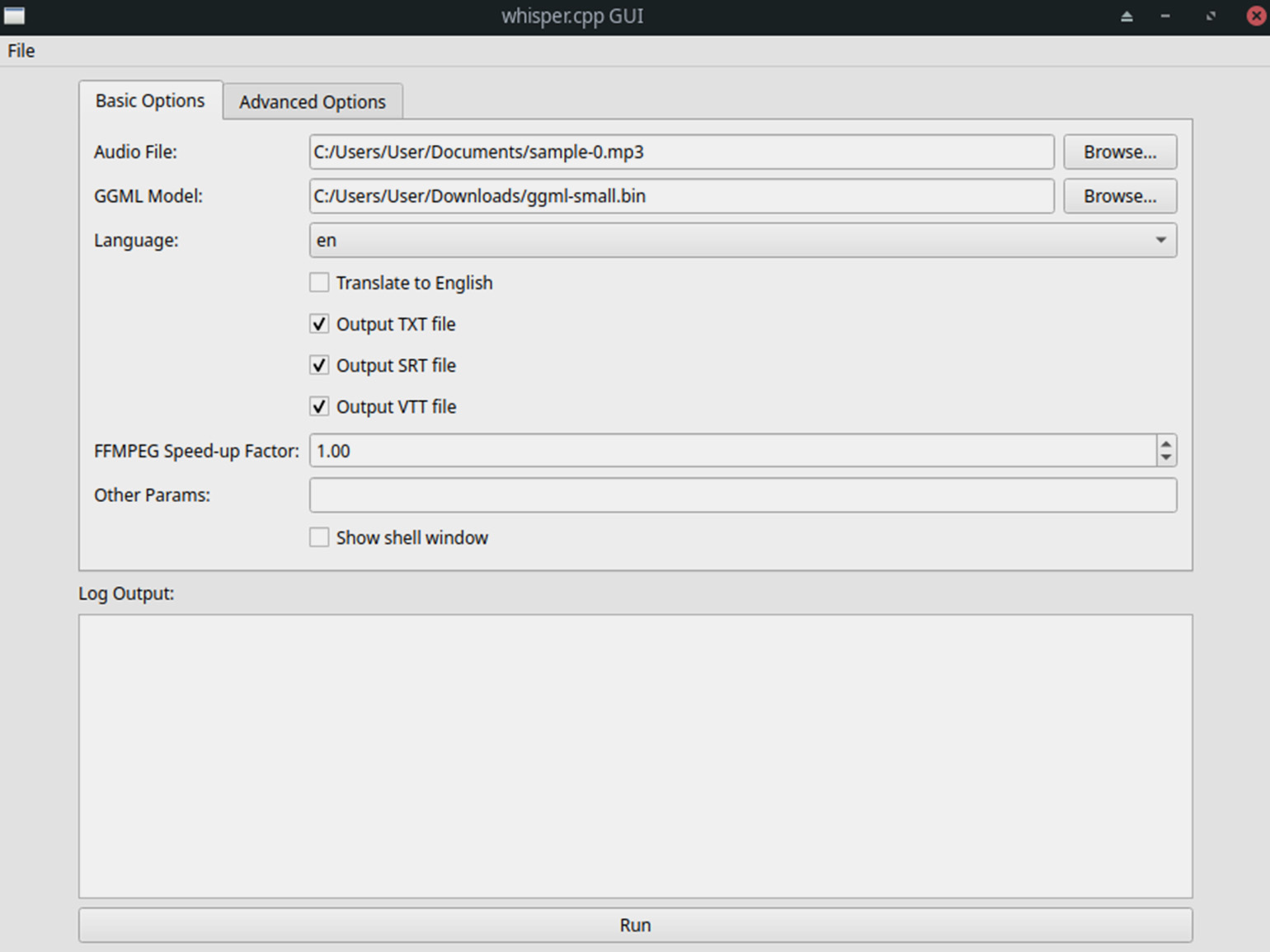

Whisper.cpp — быстрый офлайн-перевод речи в текст

Системные требования: не менее 8–16 ГБ оперативной памяти в зависимости от размера выбранной нейросети, а также от 5 ГБ свободного места на диске для хранения моделей. Есть поддержка технологий аппаратного ускорения через CPU и GPU, включая CUDA (для NVIDIA), Vulkan, OpenVINO, ROCm (для AMD) и другие бэкенды

Установка: клонируйте репозиторий с GitHub, скачайте подходящую модель в GGML-формате и соберите проект через систему CMake

Документация: Whisper.cpp README

Whisper.cpp — это локальная версия модели Whisper от OpenAI, которая оптимизирована и переписана на C++. Благодаря высокой скорости работы она подходит для слабых ПК и умеет преобразовывать речь в текст, переводить с разных языков на английский и выполнять расшифровку в реальном времени. Для удобства вы можете установить графический интерфейс whispercppGUI для Windows и Linux.

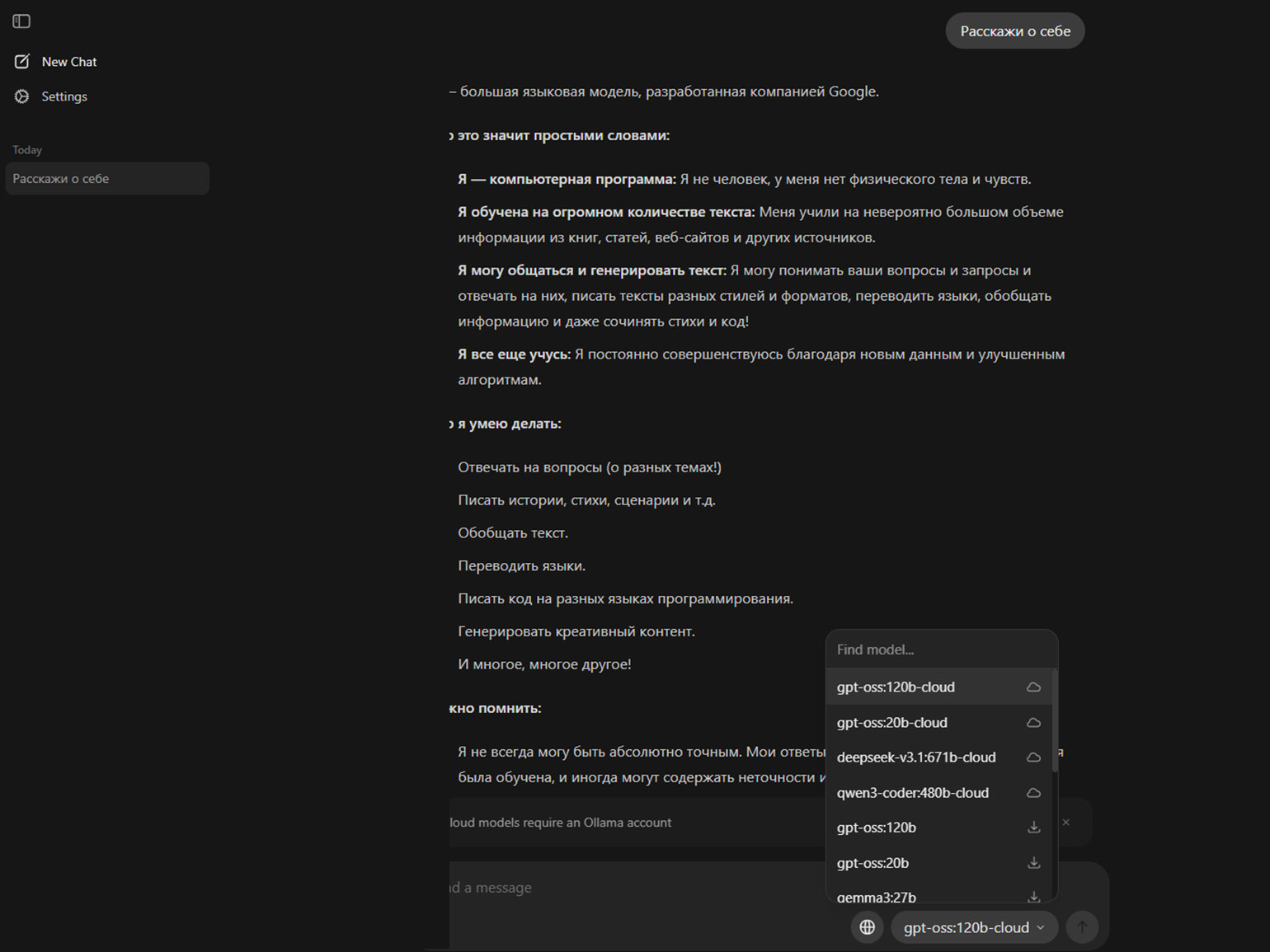

Ollama — простой менеджер моделей с каталогом и API

Системные требования: минимум 8 ГБ оперативной памяти для небольших моделей и 16 ГБ для моделей 7B и выше. Также понадобится от 10 ГБ на диске для хранения приложения и моделей (точный объём будет зависеть от количества установленных моделей)

Установка: скачайте установщик с официального сайта Ollama или загрузите модель через терминал с помощью команды ollama run gemma3

Документация: Ollama Docs

Раньше Ollama работала только как CLI-инструмент и локальный сервер для запуска моделей. Сейчас у неё есть полноценный графический интерфейс, который позволяет общаться в окне чата, выбирать модели из встроенного каталога и работать так же удобно, как в LM Studio.

Мы загрузили встроенную Gemma 3:4b и попросили нейросеть рассказать о себе — модель написала, что умеет работать с разными форматами контента на русском. Например, готова писать нам стихи.

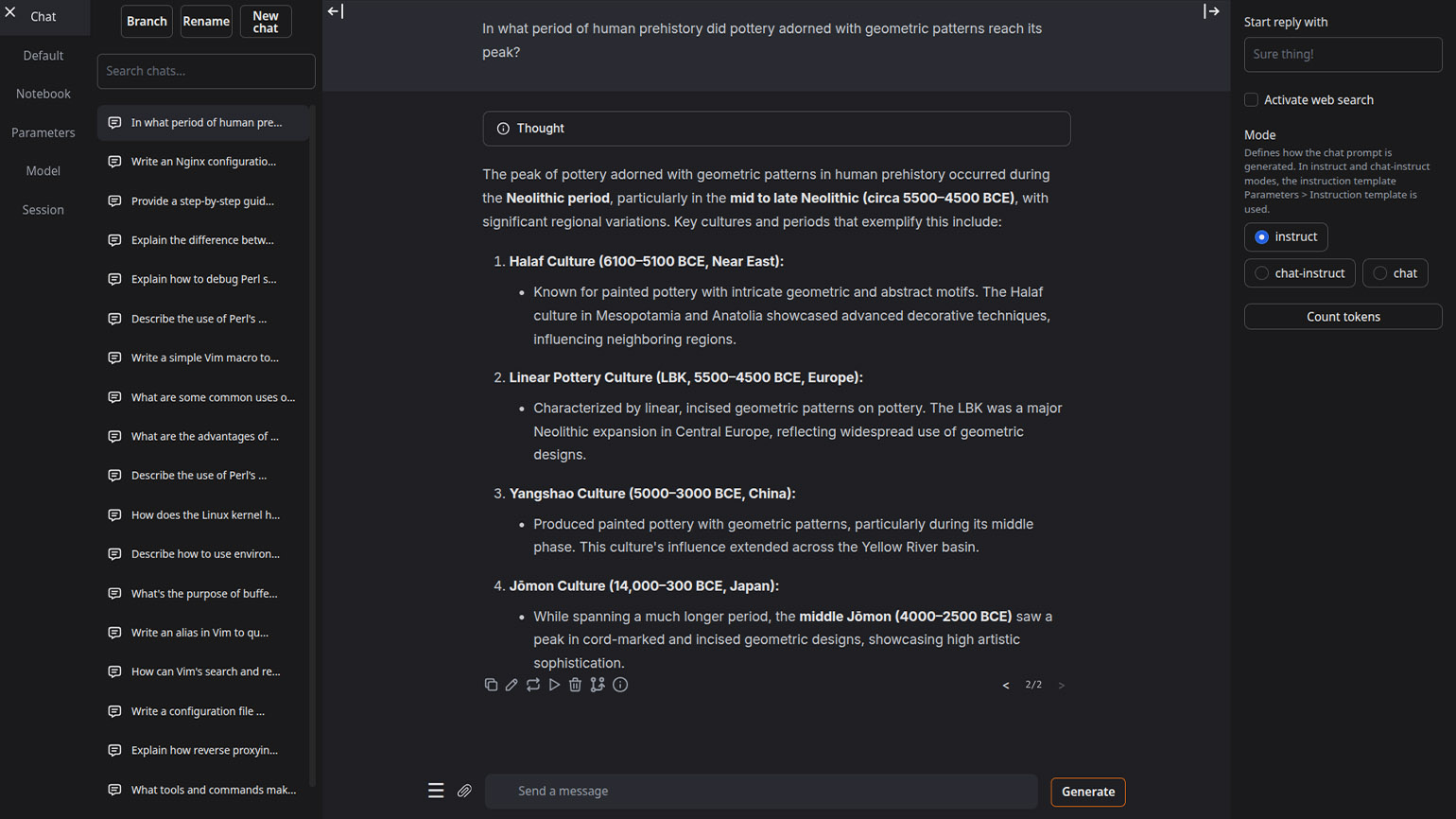

Text Generation Web UI — браузерный интерфейс для локальных чат-ботов

Системные требования: не менее 8 ГБ оперативной памяти. Объём видеопамяти зависит от модели — для нейросетей с 7B параметров понадобится 7–10 ГБ VRAM. Ещё на диске нужно зарезервировать 10 ГБ для установки программы и 20–50 ГБ для хранения моделей

Установка: скачайте портативную версию для своей операционной системы, распакуйте архив и запустите один из файлов — start_windows.bat для Windows или start_linux.sh / start_macos.sh для Linux и macOS. После откройте страницу http://127.0.0.1:7860

Документация: GitHub Wiki

Text Generation Web UI — это универсальный веб-интерфейс для локального запуска языковых моделей. Он поддерживает все основные форматы моделей, оснащён встроенным загрузчиком из каталога Hugging Face и предоставляет полноценную альтернативу API OpenAI для разработчиков. Это удобно, когда вам нужно интегрировать ИИ в собственные проекты и не отправлять данные на внешние серверы.

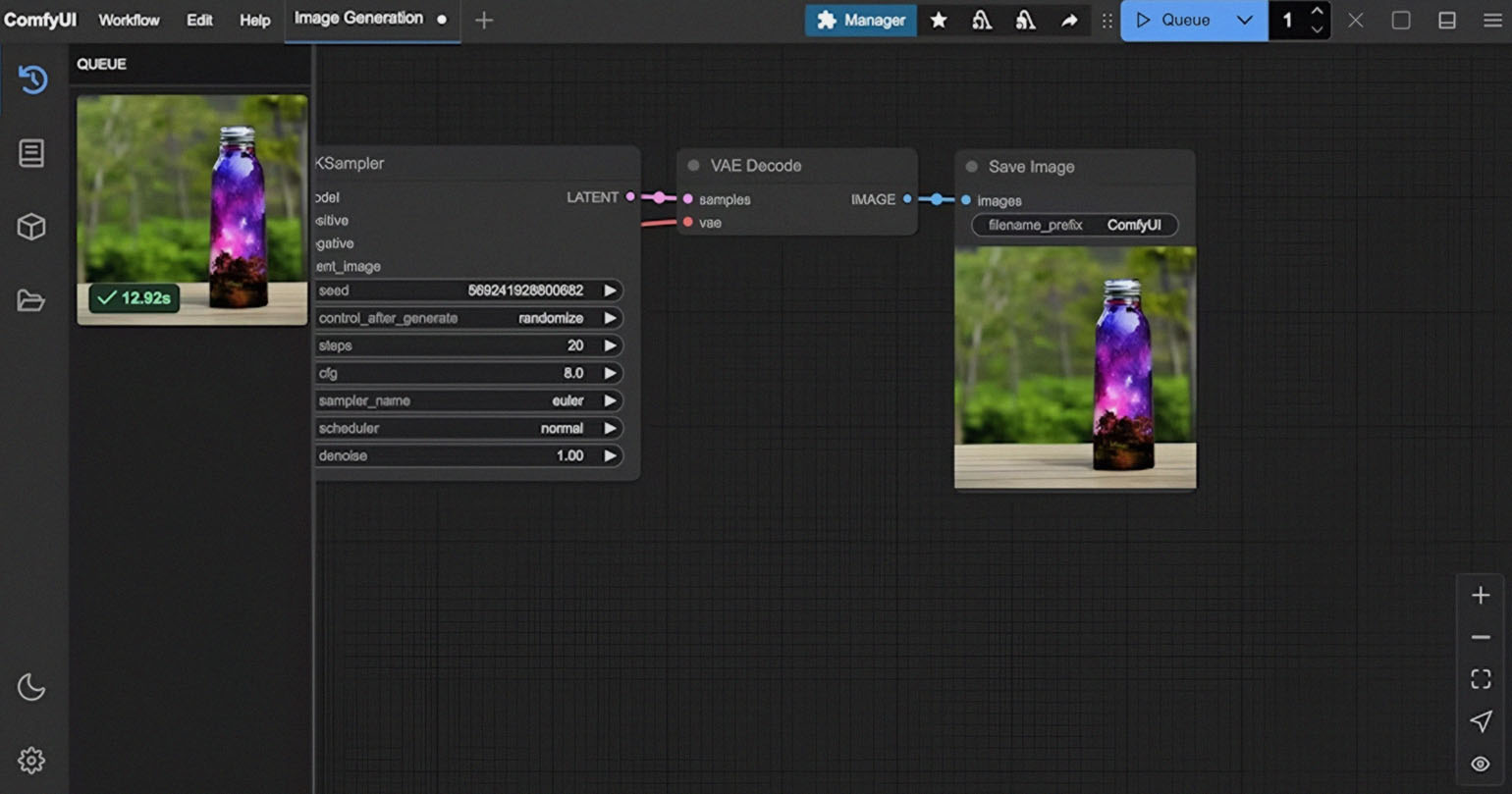

ComfyUI — модульный конструктор для создания изображений на основе узлов

Системные требования: от 8 ГБ оперативной памяти при работе на процессоре и от 4 ГБ видеопамяти для видеокарты. Программа занимает около 5–6 ГБ на диске, и отдельно необходимо резервировать место для каждой модели, которую вы скачаете

Установка: скачайте Portable-версию для своей операционной системы, распакуйте архив и после запустите run_nvidia_gpu.bat для работы через GPU или run_cpu.bat для режима без видеокарты

Документация: docs.comfy.org

ComfyUI работает в браузере и, помимо Stable Diffusion, поддерживает множество моделей для генерации изображений, аудио, видео и даже 3D-объектов. Интерфейс построен на основе системы блоков, которые вы можете соединять, как элементы конструктора. Такая архитектура позволяет создавать сложные цепочки обработки данных без кода.

Например, вы можете создать такую схему: сначала загрузить фотографию через входной узел, затем подключить к нему узел трансформации стиля, а в конце добавить узел масштабирования. В результате получится изображение с выбранным художественным стилем и разрешением. Для практики попробуйте загрузить свой портрет, примените стиль картин Ван Гога и увеличьте размер до 4K.

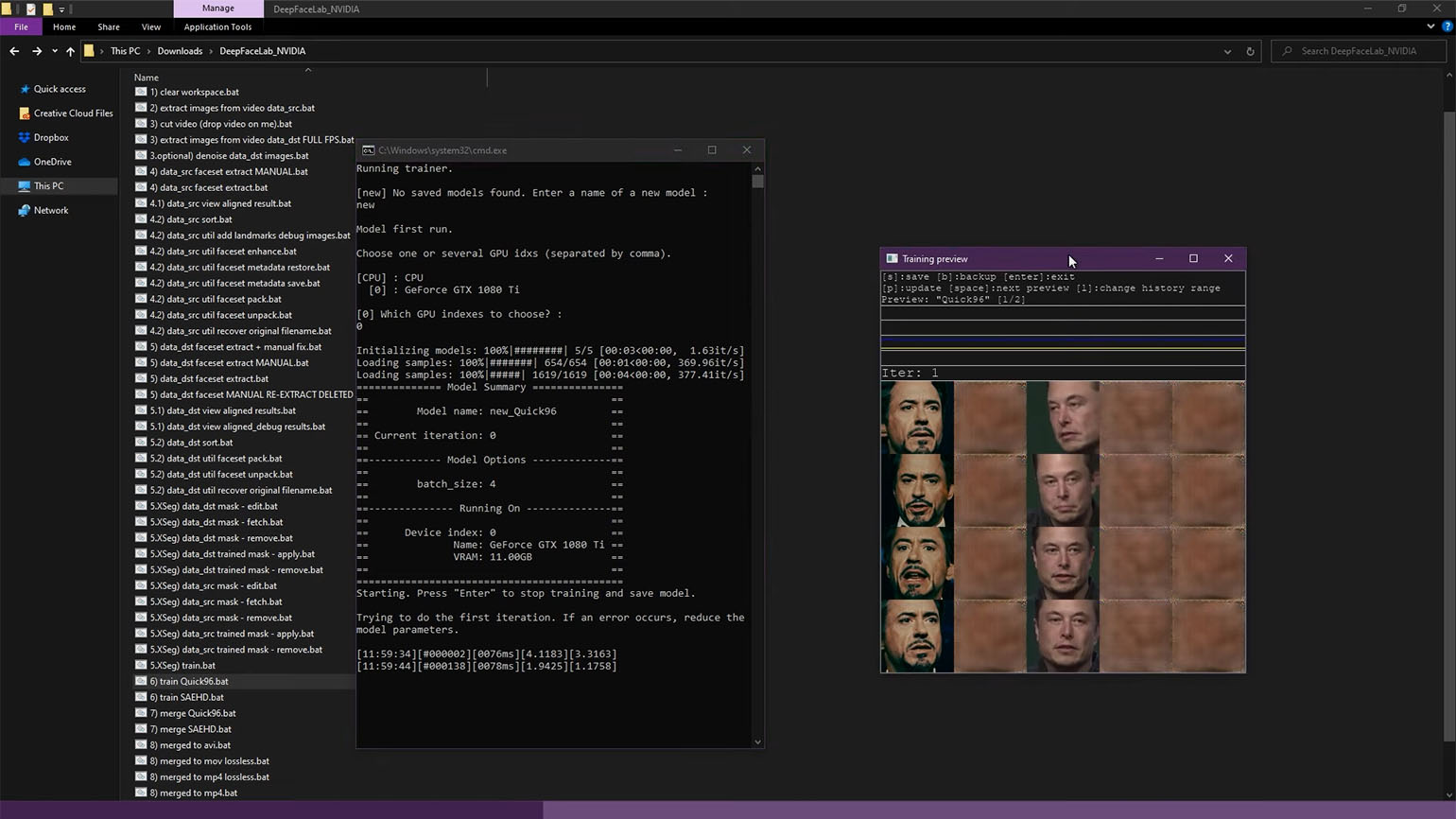

DeepFaceLab — популярная нейросеть для дипфейков с открытым исходным кодом

Системные требования: Windows 10/11, минимум 16 ГБ оперативной памяти. Для GPU-версии требуется видеокарта NVIDIA с поддержкой CUDA (от 4 ГБ). Также на диске необходимо не менее 10 ГБ свободного места для программы и моделей. CPU-версии совместимы практически с любым ПК, но работают значительно медленнее.

Примечание: разработчик не рекомендует использовать версию 2.0 на ноутбуках из-за высокого риска перегрева компонентов устройства

Установка: скачайте готовую сборку из облачного хранилища разработчика, распакуйте архив и запустите нужный файл

Документация: DeepFaceLab 2.0 Guide

DeepFaceLab — один из самых популярных инструментов для создания дипфейков. У программы особая архитектура: все операции выполняются через запуск пронумерованных пакетных файлов из корневого каталога. Например, файл 1. extract images from video.bat извлекает кадры из видео, а 5. train.bat запускает обучение модели.

При этом учтите, что на создание качественного дипфейка может уйти от нескольких часов до нескольких дней, — всё зависит от мощности вашего компьютера и сложности исходного материала. Поэтому, если захотите попробовать, то перед началом работы обеспечьте себе бесперебойное электропитание и отключите «спящий» режим.

Читайте также:

Преимущества и ограничения локальных нейросетей

Локальные нейросети дают много преимуществ, и вот несколько из них:

- Автономность. Модели работают на вашем компьютере без подключения к удалённым серверам или облачным сервисам.

- Конфиденциальность. Все вычисления происходят локально, и данные никуда не передаются. Поэтому вы можете, например, обрабатывать документы компании и не опасаться утечки.

- Неограниченное количество запросов. Вы можете использовать модель столько, сколько нужно, без ограничений на количество обращений. И конечно, всё бесплатно.

- Гибкость и настройка. Вы можете адаптировать модели под свои задачи, регулировать параметры запуска и экспериментировать с версиями. Например, при переводе технических текстов можно повысить параметр temperature, чтобы сгенерировать более креативные варианты, или снизить его для максимально точного перевода. Такая тонкая настройка доступна не во всех облачных сервисах.

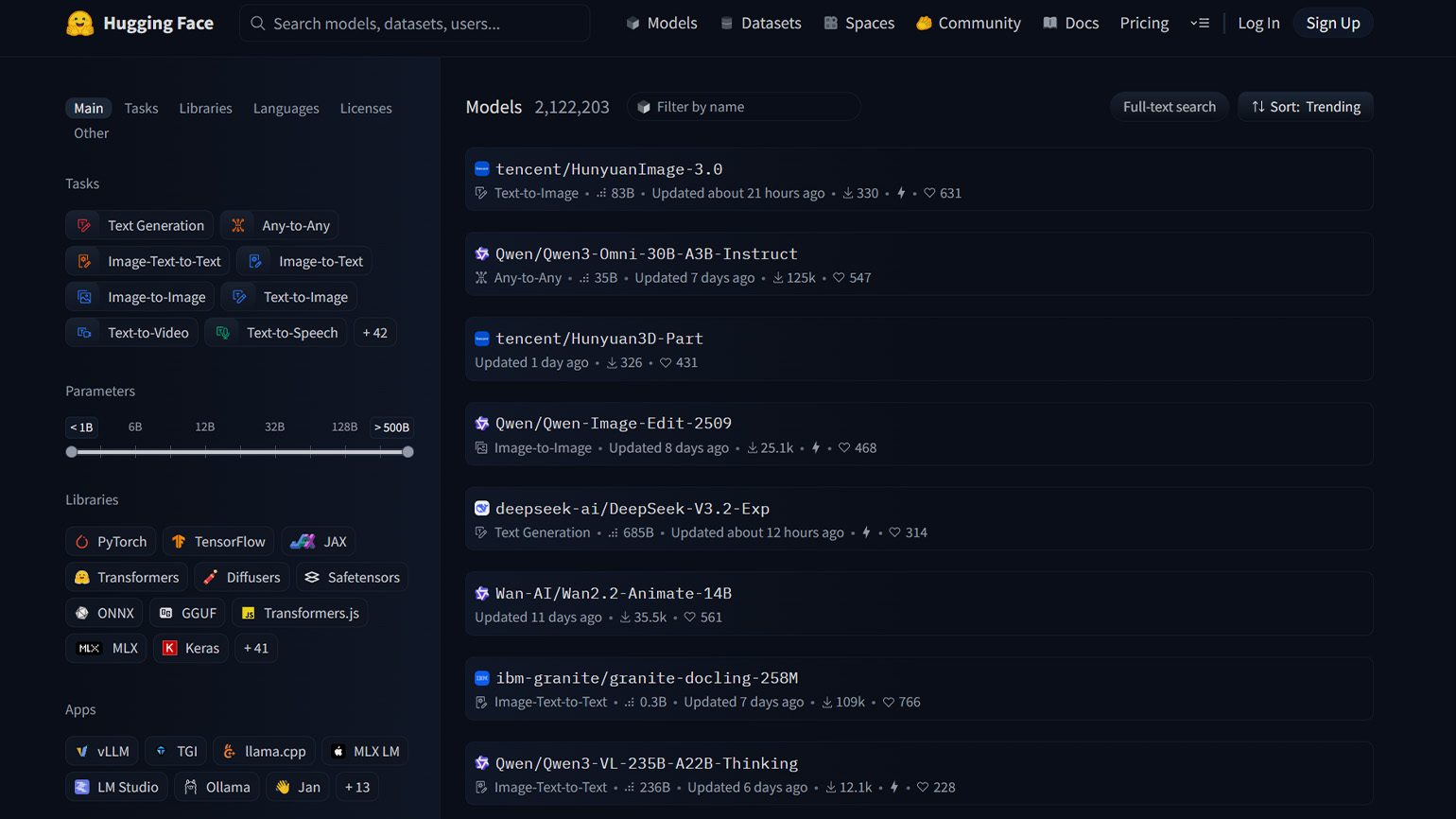

И отдельно стоит отметить огромное количество доступных локальных нейросетей. В этой статье мы рассмотрели только десять популярных моделей, но если заглянуть на Hugging Face или аналогичные площадки, то вы найдёте тысячи вариантов почти для любых задач.

Если рассматривать недостатки, то в первую очередь мы бы отметили высокие системные требования. Без мощного современного компьютера вы не сможете продуктивно работать. Например, для запуска полной версии Stable Diffusion XL вам понадобится видеокарта с объёмом памяти не менее 12 ГБ — уровень NVIDIA RTX 3080 или выше.

Следующая большая проблема в том, что большинство моделей вам придётся настраивать вручную, чтобы добиться приемлемых результатов. А если после настройки что-то пойдёт не так, то искать решение вы тоже будете самостоятельно. То есть если модель LLaMA 3 начнёт выдавать ошибку при загрузке контекста, то вам придётся разбираться в логах, проверять похожие случаи в GitHub Issues или обращаться за помощью на форумах в надежде найти подсказку.

Также стоит учитывать современные облачные нейросети от крупных компаний вроде DeepSeek, Microsoft Copilot и Claude, которыми вы можете пользоваться бесплатно или с определёнными лимитами. С ними не нужно ничего настраивать, следить за обновлениями или беспокоиться о совместимости с оборудованием — всю техническую работу берут на себя разработчики, а с вас только продуманный промпт.

Поэтому если взвешивать преимущества и недостатки локальных моделей, то, на наш взгляд, они будут интересны лишь энтузиастам, разработчикам, компаниям с повышенными требованиями к безопасности и тем, кто часто работает офлайн и хочет иметь под рукой нейропомощь. Остальным будет сложно, медленно или некомфортно.

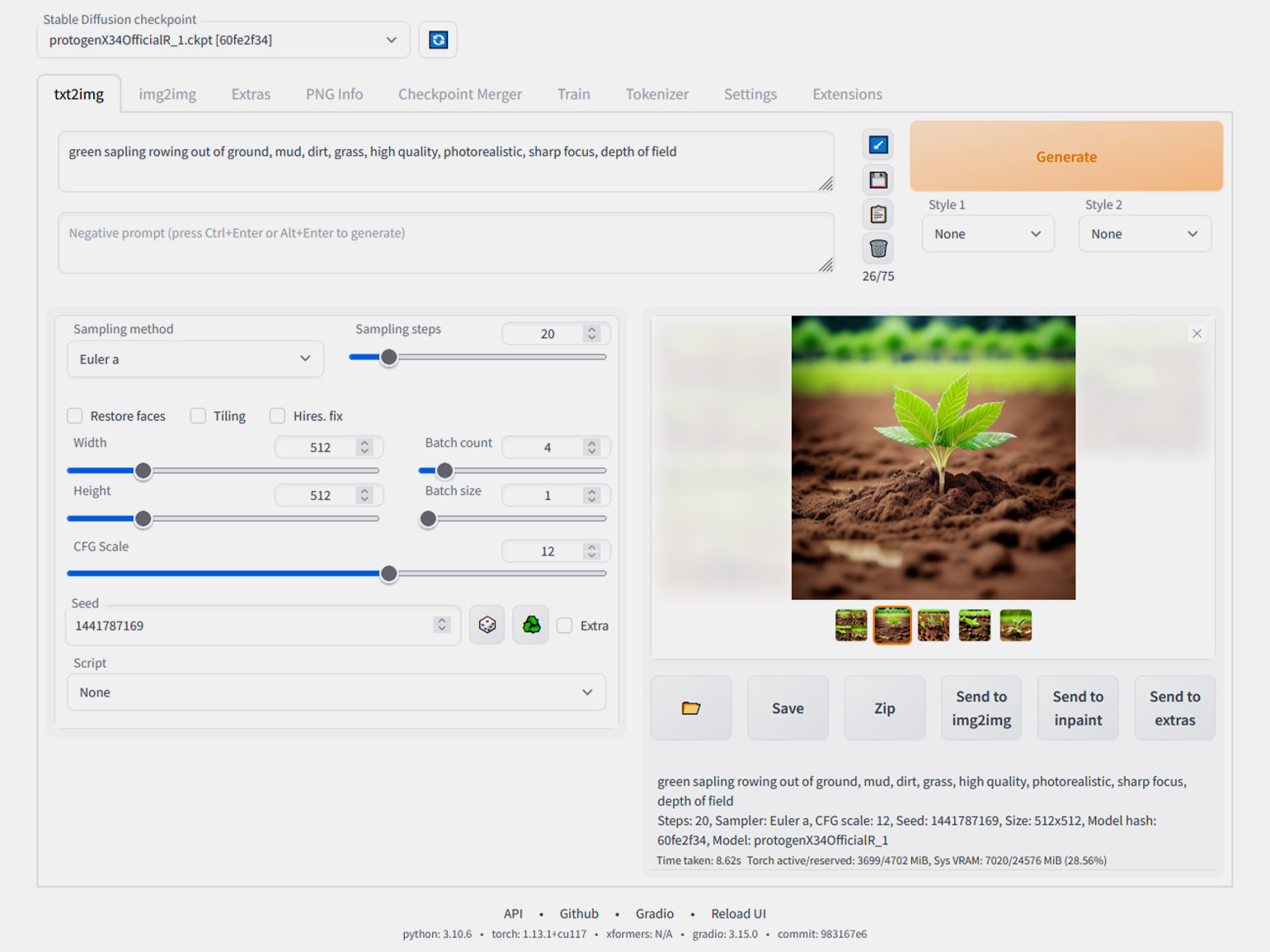

Пример запуска локальной нейросети на ноутбуке

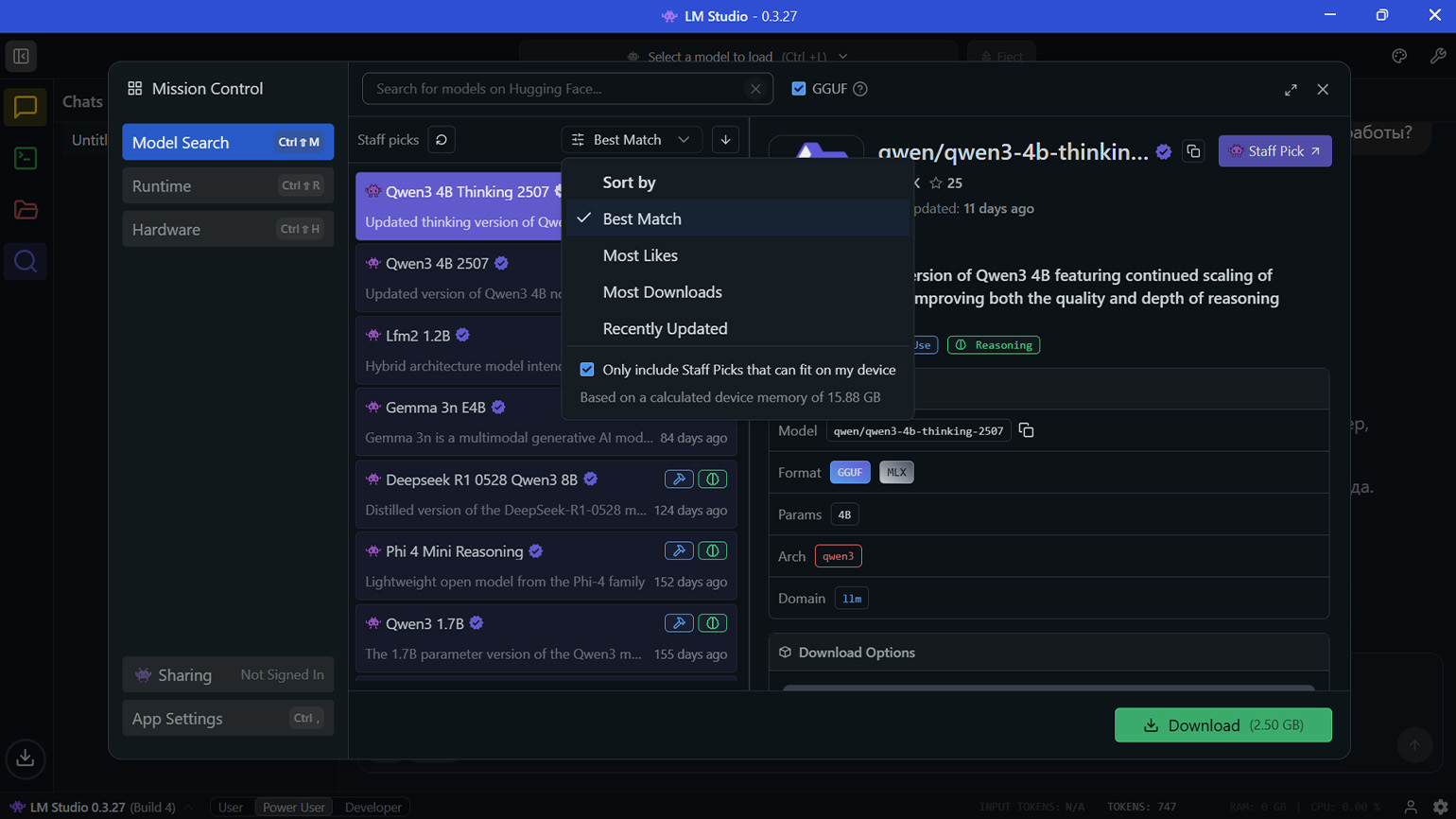

Если вы только начинаете знакомиться с локальными нейросетями, мы рекомендуем установить LM Studio или аналогичное приложение с графическим интерфейсом. По виду они мало чем отличаются от привычного ChatGPT, поэтому вам будет проще к ним привыкнуть.

После установки запустите LM Studio, выберите значок поиска на левой боковой панели и посмотрите список доступных нейросетей. В этом разделе вы можете отфильтровать модели по популярности, количеству скачиваний и другим параметрам. Также вы можете поставить галочку возле надписи «Only include Staff Picks that can fit on my device», чтобы видеть только те модели, что совместимы с вашим устройством.

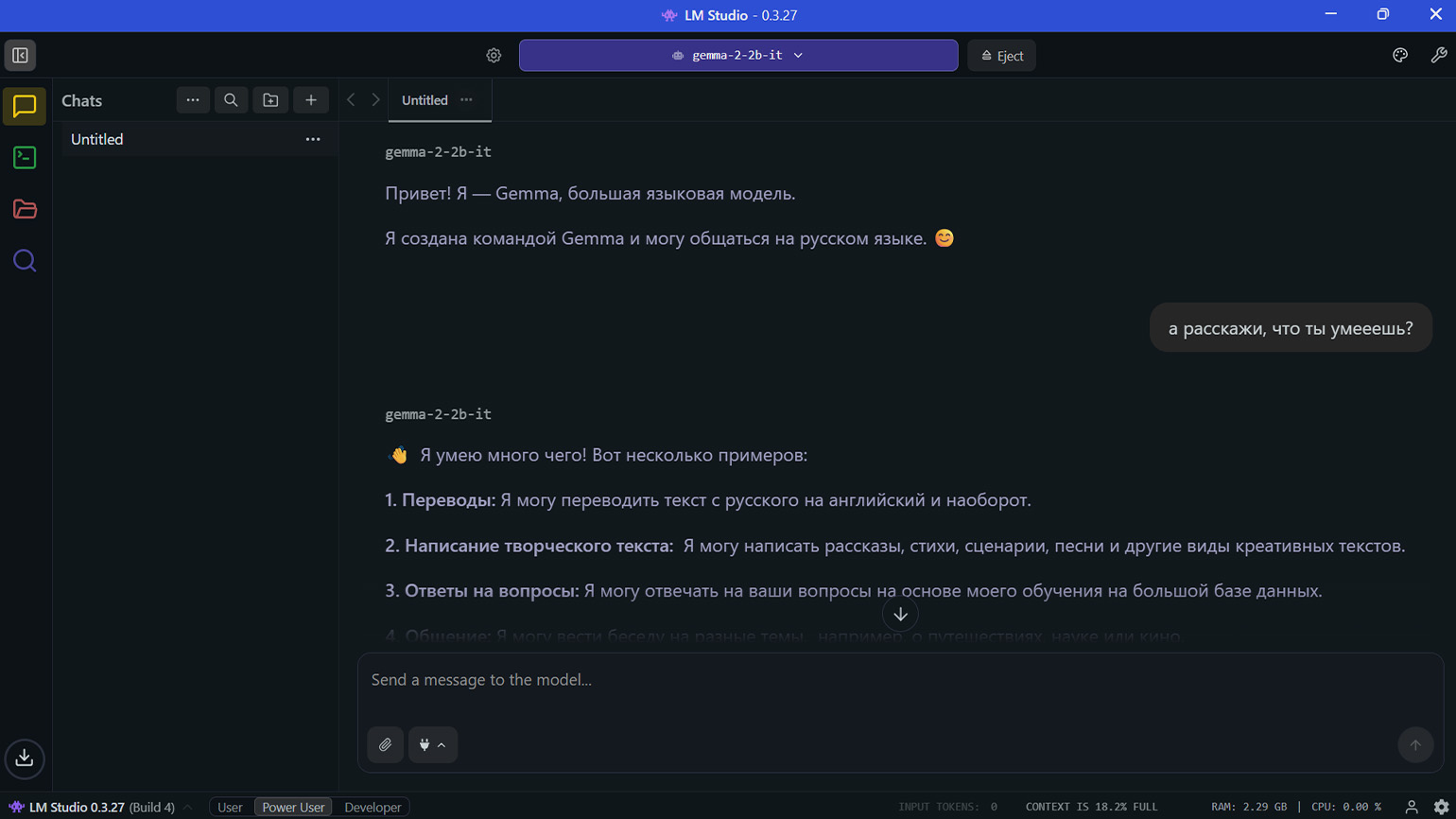

После выбора модели нажмите на кнопку Download и после загрузки приступайте к работе. Мы установили Gemma 2 2B, которую Google предлагает использовать на устройствах с ограниченными ресурсами.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!