Во время конференции АI Journey инженеры Sber AI представили обновление модели машинного обучения для генерации изображений Kandinsky 3.0 и выпустил новую нейросеть Kandinsky Video для создания коротких видео. Обе нейросети уже доступны пользователям.

Скриншот: Fusion Brain / Skillbox Media

Kandinsky 3.0

Для обучения модели Kandinsky 3.0 разработчики использовали большой датасет, состоящий из пар по схеме «текст — изображение». Инженеры собирали картинки в интернете и пропускали через многочисленные фильтры. К примеру, оценивали эстетичность изображения, разрешение, соотношение сторон и соответствие описания. В новый датасет добавили картинки, содержащие элементы русской культуры.

Процесс обучения Kandinsky 3.0 разделили на несколько этапов:

- на первом этапе модель училась на 1,1 млрд пар «текст — картинка» с разрешением 256 × 256;

- далее разработчики перешли на использование 768 млн пар с разрешением 384 × 384;

- после — использовали 450 млн изображений в разрешении 512 × 512;

- затем инженеры повысили разрешение картинок в парах до 768 × 768 — это 224 млн изображений;

- на финальном этапе модель обучалась по 280 млн самых больших изображений с разрешением 768 × 1024.

Итоговую модель Kandinsky 3.0 сравнили с прошлой версией 2.2. Для этого обе нейросети генерировали изображения по одному и тому же промпту, а исследователи сравнивали соответствие картинки текстовому описанию и оценивали визуальное качество.

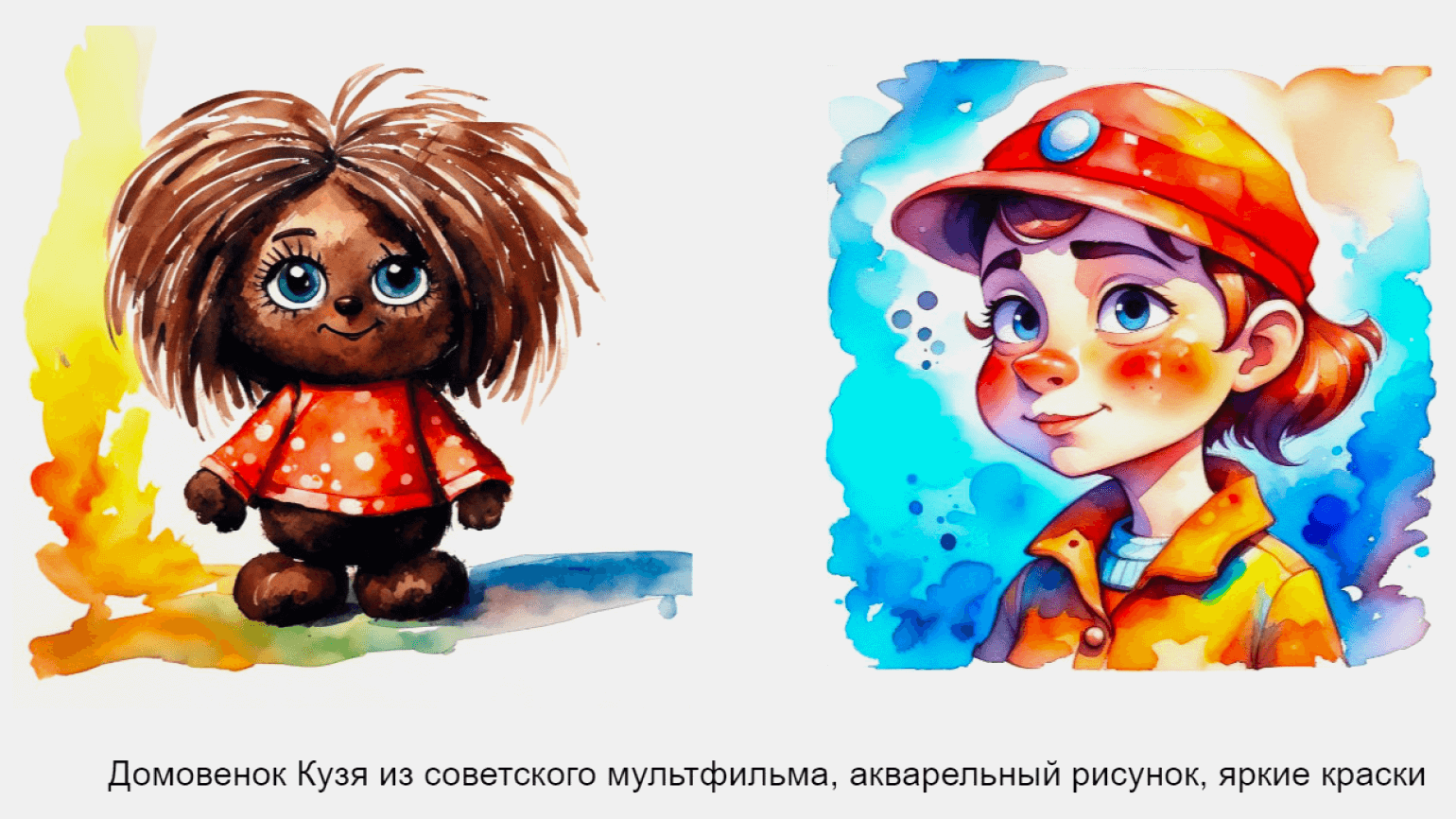

Изображение: «Сбер» / «Хабр»

Главным преимуществом новой версии Kandinsky стало лучшее понимание пользовательского запроса. Кроме того, улучшилось представление модели об отечественном культурном коде.

Изображение: «Сбер» / «Хабр»

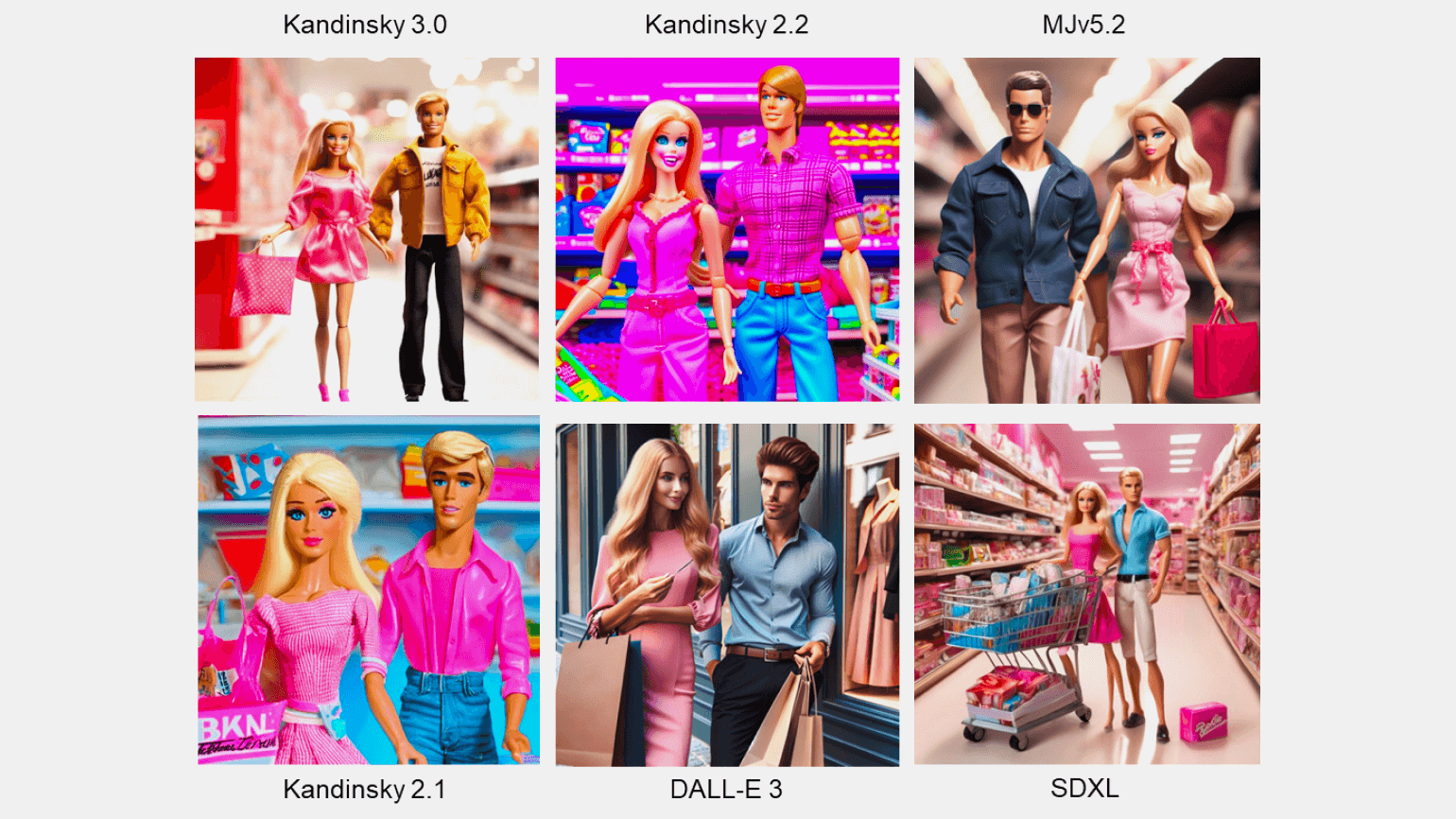

Исследователи сравнили Kandinsky 3.0 и с другими популярными моделями машинного обучения для генерации изображения, включая DALL-E 3 и Midjourney 5.2. В представленных тестах решение инженеров Sber AI не уступает аналогам и в некоторых случаях превосходит их.

Изображение: «Сбер» / «Хабр»

Вместе с этим исследователи разработали модели для режимов inpainting и outpainting. С их помощью пользователи могут редактировать изображения, меняя в них объекты, или расширять границы, создавая панорамы. Модели учитывают не только текстовое описание, но и известные части редактируемого изображения.

Изображение: «Сбер» / «Хабр»

Нейросеть Kandinsky 3.0 уже доступна пользователям на платформе Fusion Brain, ruDALL-E и в телеграм-боте. Код моделей опубликован в открытом репозитории GitHub, а их веса — на платформе Hugging Face.

Kandinsky Video

Во время конференции AI Journey команда Sber AI рассказала, что Kandinsky Video стала первой российской моделью машинного обучения для генерации коротких видеороликов. Для её обучения использовали набор из 220 тысяч пар «текст — видео».

На первом этапе создания видео нейросеть генерирует ключевые кадры с помощью предобученной модели Kandinsky 3.0. Эти кадры задают основную сюжетную линию, но результат больше похож на слайд-шоу. Для придания плавности необходима генерация интерполяционных кадров на втором этапе.

Модель сравнивает два последовательных ключевых кадра и предсказывает набор из трёх кадров между этой парой. С помощью этого сохраняется сюжет видео и задаётся плавность движения.

Изображение: «Сбер» / «Хабр»

Kandinsky Video может генерировать видео с разрешением 512 × 512 пикселей и продолжительностью до восьми секунд с частотой 30 кадров в секунду. Создание одного видео занимает до трёх минут. Исследователи Sber AI отмечают, что находятся на первом этапе развития технологии, поэтому пока рано говорить о высоком качестве результата.

Попробовать Kandinsky Video можно на платформе Fusion Brain и в телеграм-боте. Код и веса модели доступны в GitHub-репозитории.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!