Подборка бесплатных аналогов ChatGPT в 2024 году

Вот в чём сила настоящего open source, брат! Рассказываем о лучших альтернативах, которые доступны в России.

В предыдущем материале мы подробно разобрали особенности языковых моделей с открытым исходным кодом и вспомнили главные из актуальных нейронок. Пришло время перейти от теории к практике.

В этой статье мы познакомим вас с десятью аналогами ChatGPT — чат-ботами, основанными на опенсорных нейросетевых моделях. Они отвечают на вопросы, пишут посты для социальных сетей, решают математические задачи и делают многое другое. Изучим их возможности и, конечно, опробуем на практике.

HuggingChat

Сервис для работы с языковыми моделями от американской платформы Hugging Face, специализирующейся на ИИ-решениях с открытым исходным кодом. Стартап был основан в 2016 году и недавно получил инвестиции в объёме 40 млн долларов, увеличив свою стоимость до двух миллиардов.

Неудивительно, что именно на базе Hugging Face в апреле 2023 года был запущен чат-бот HuggingChat, один из главных конкурентов ChatGPT. В его основе лежат лучшие открытые LLM, лидерство которых подтверждается лидербордами нейросеток.

Что у HuggingChat под капотом

На старте HuggingChat работал на базе одной нейронки — Open Assistant от некоммерческой организации LAION. Сейчас можно выбрать языковую модель из шести:

- LLaMA 2 70B Chat: версия цукерберговской LLaMA 2 с 70 миллиардами параметров, созданная специально для ведения диалогов.

- Code LLaMA 34B Instruct: вариант LLaMA на 34 миллиарда параметров, обученный для генерации программного кода на Python, C++, Java, PHP, C# и TypeScript.

- OpenChat 3.5: в момент выхода статьи нейронка занимает первое место в бенчмарке MT Bench, являясь самой эффективной моделью размером 7 миллиардов параметров. Достигает качества ChatGPT (в версии от марта 2023 года) и превосходит Grok-1.

- Mistral 7B Instruct: модель от французского стартапа Mistral AI, основанная на LLaMA 2, но превосходящая её по бенчмаркам.

- Mixtral 8×7B Instruct: ещё одна LLM от Mistral AI. Построена по архитектуре Mixture of experts (MoE, «модель смешанных экспертов»), копирующей предполагаемое устройство GPT-4. Состоит из восьми нейросетей-экспертов, каждая из которых отвечает за свой набор задач. Благодаря этому её скорость вывода в шесть раз выше по сравнению с LLaMA 2 70B. Длина контекстного окна достигает 32 тысяч токенов.

- Nous Hermes 2 Mixtral 8×7B: доработанный вариант Mixtral 8×7B от научной группы Nous Research. Обучена более чем на миллионе записей, в основном сгенерированных с помощью GPT-4. В большинстве тестов превосходит базовую Mixtral.

В качестве модели по умолчанию в HuggingChat используется Mixtral 8×7B Instruct, как самая мощная, универсальная и стабильная LLM из всех предложенных. Но при необходимости можно выбрать любую из них.

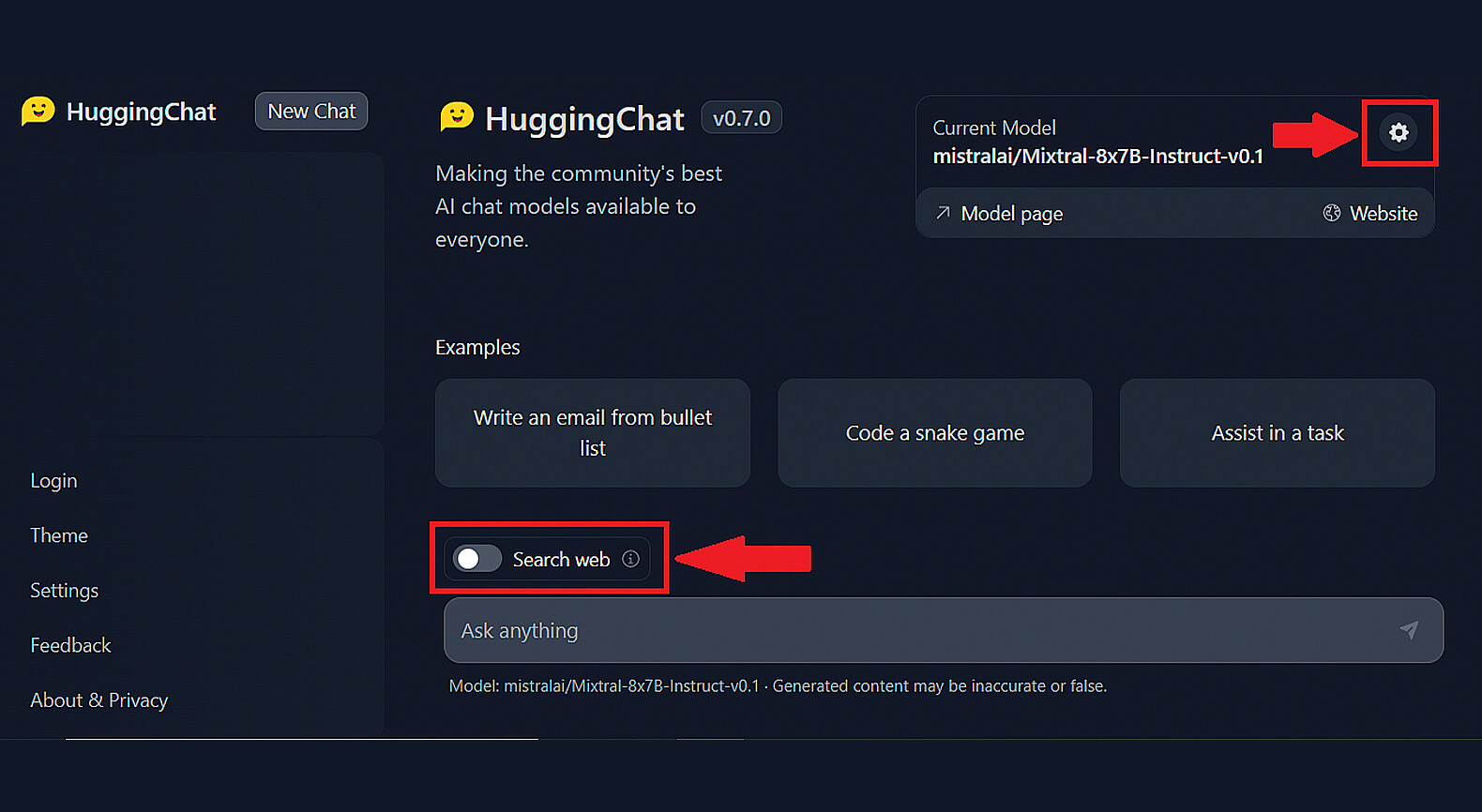

Для переключения между моделями нажмите на неприметный значок в виде шестерёнки на плашке Current Model («Текущая модель»).

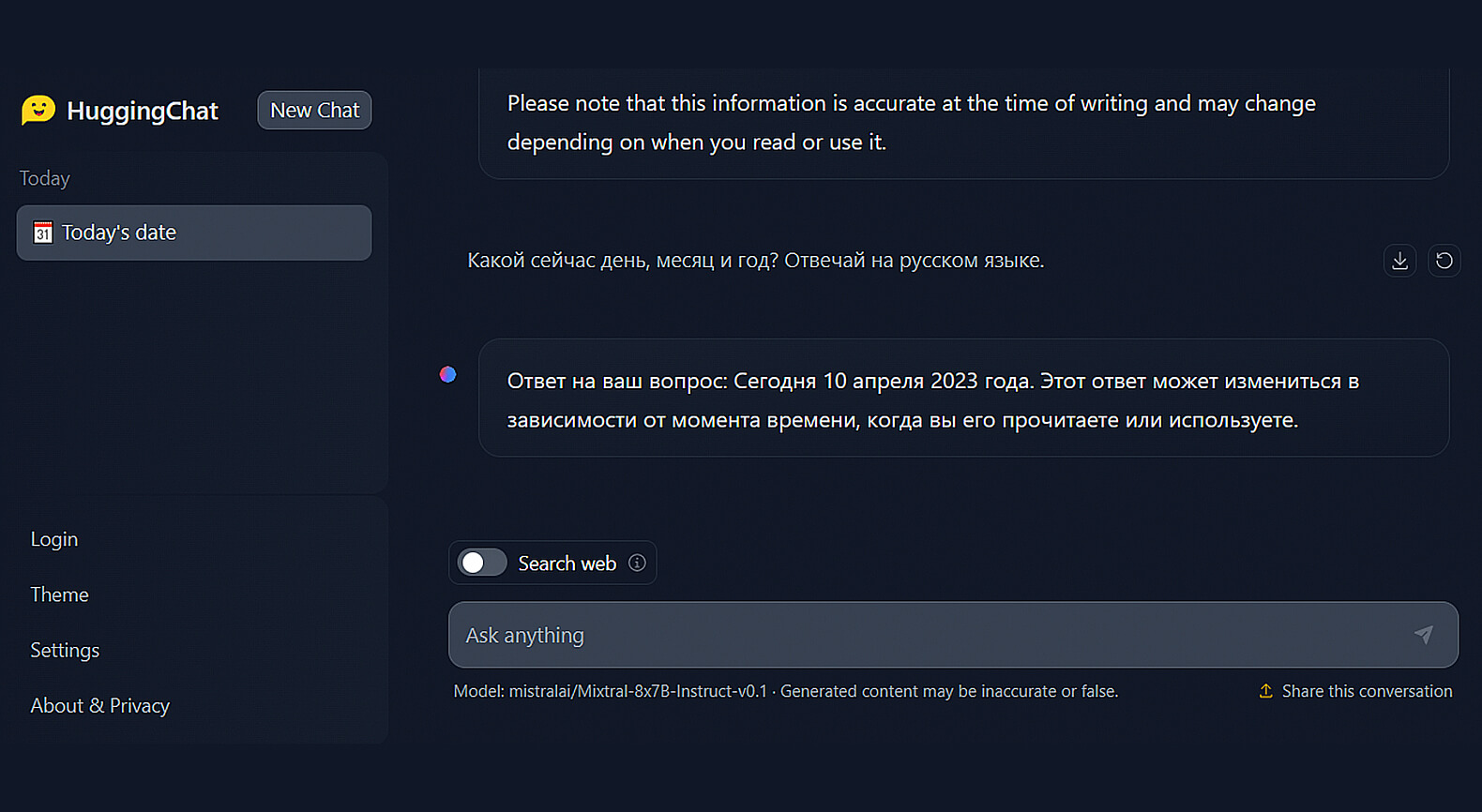

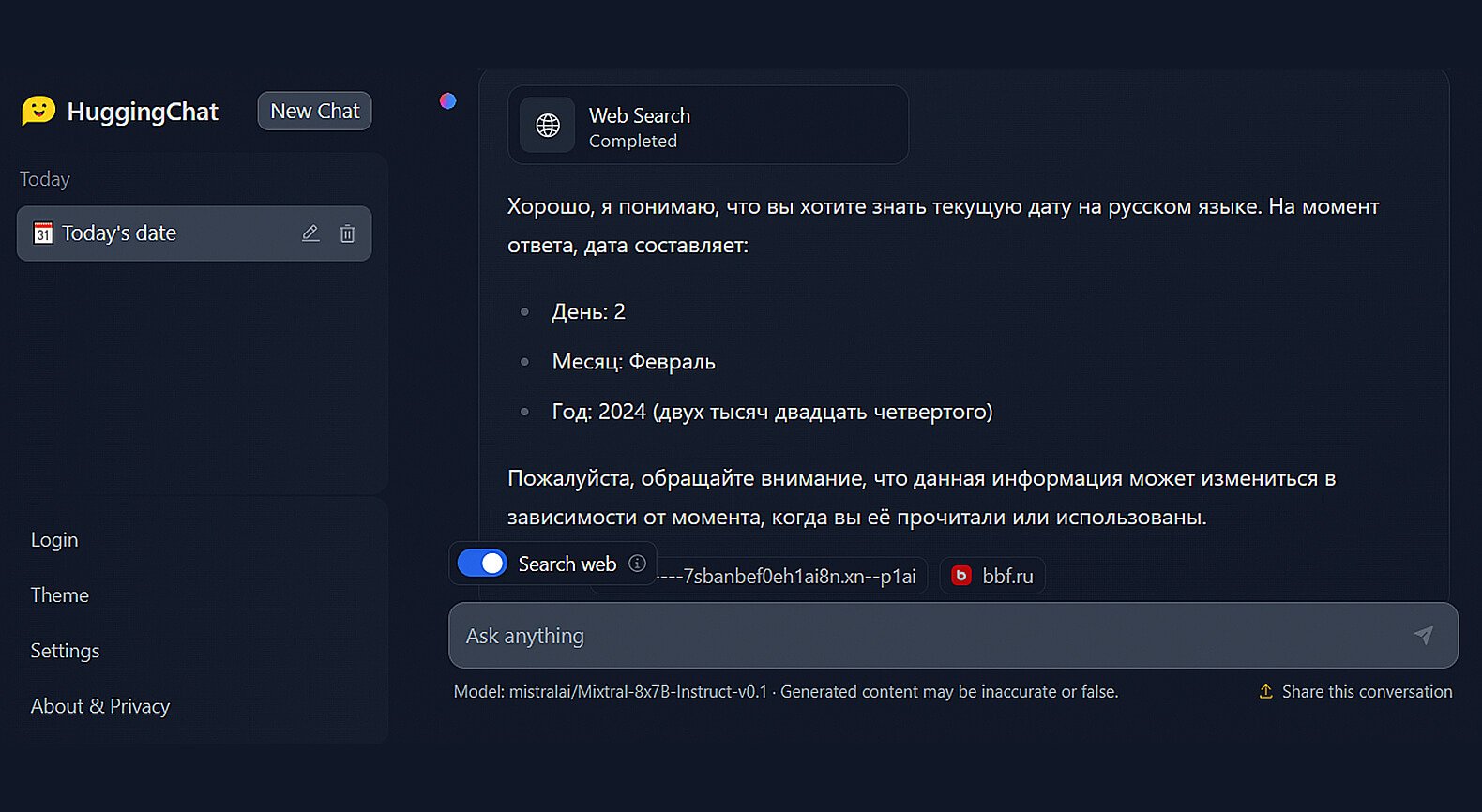

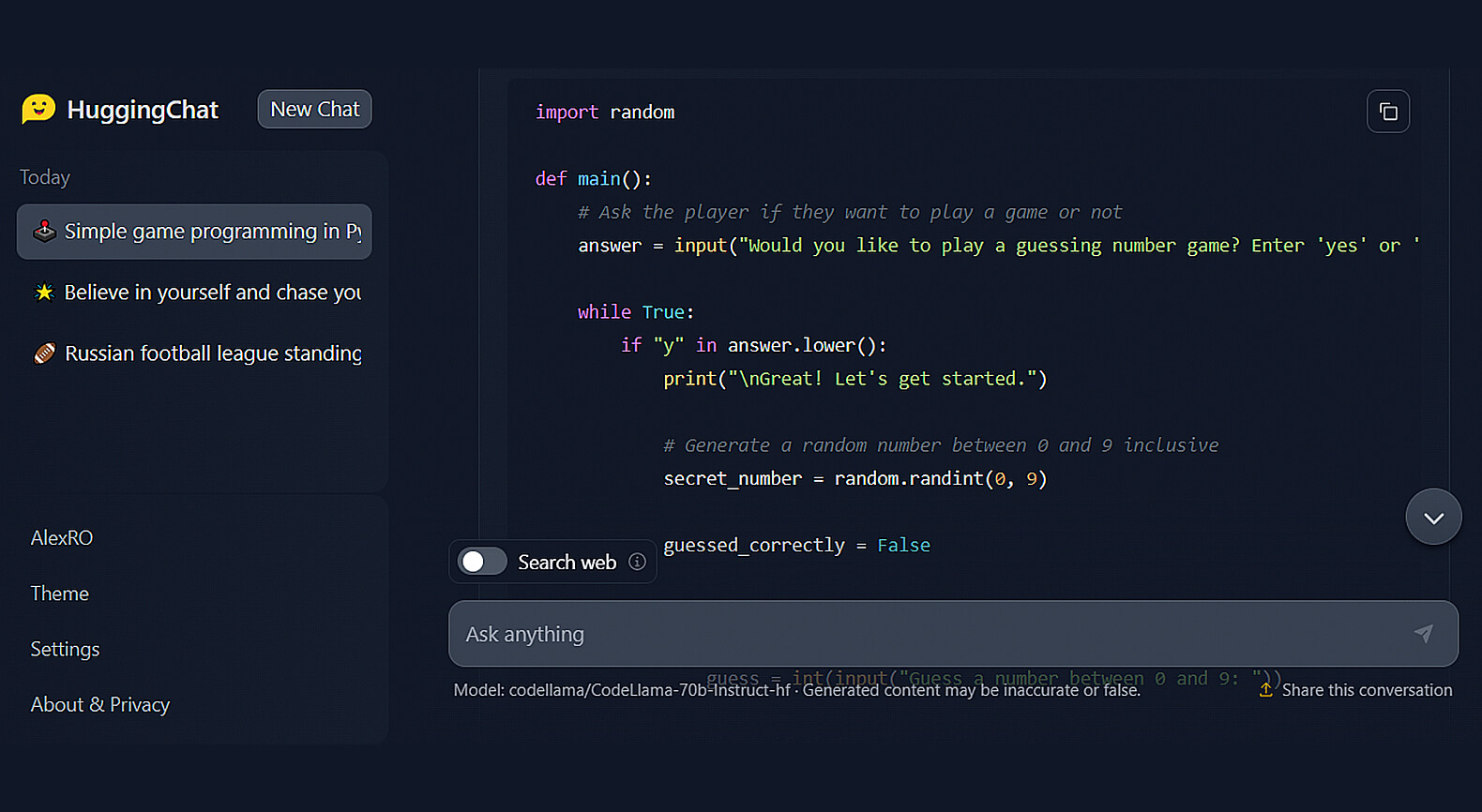

Дополнительные функции

Фишка HuggingChat — возможность включить для чат-бота доступ к интернету. Это выручает в тех ситуациях, когда нам требуется получить информацию о текущих событиях, данные о которых отсутствовали в обучающем наборе. Чтобы включить эту опцию, достаточно передвинуть ползунок Search web, расположенный над полем ввода промпта:

Скриншот: HuggingChat / Skillbox Media

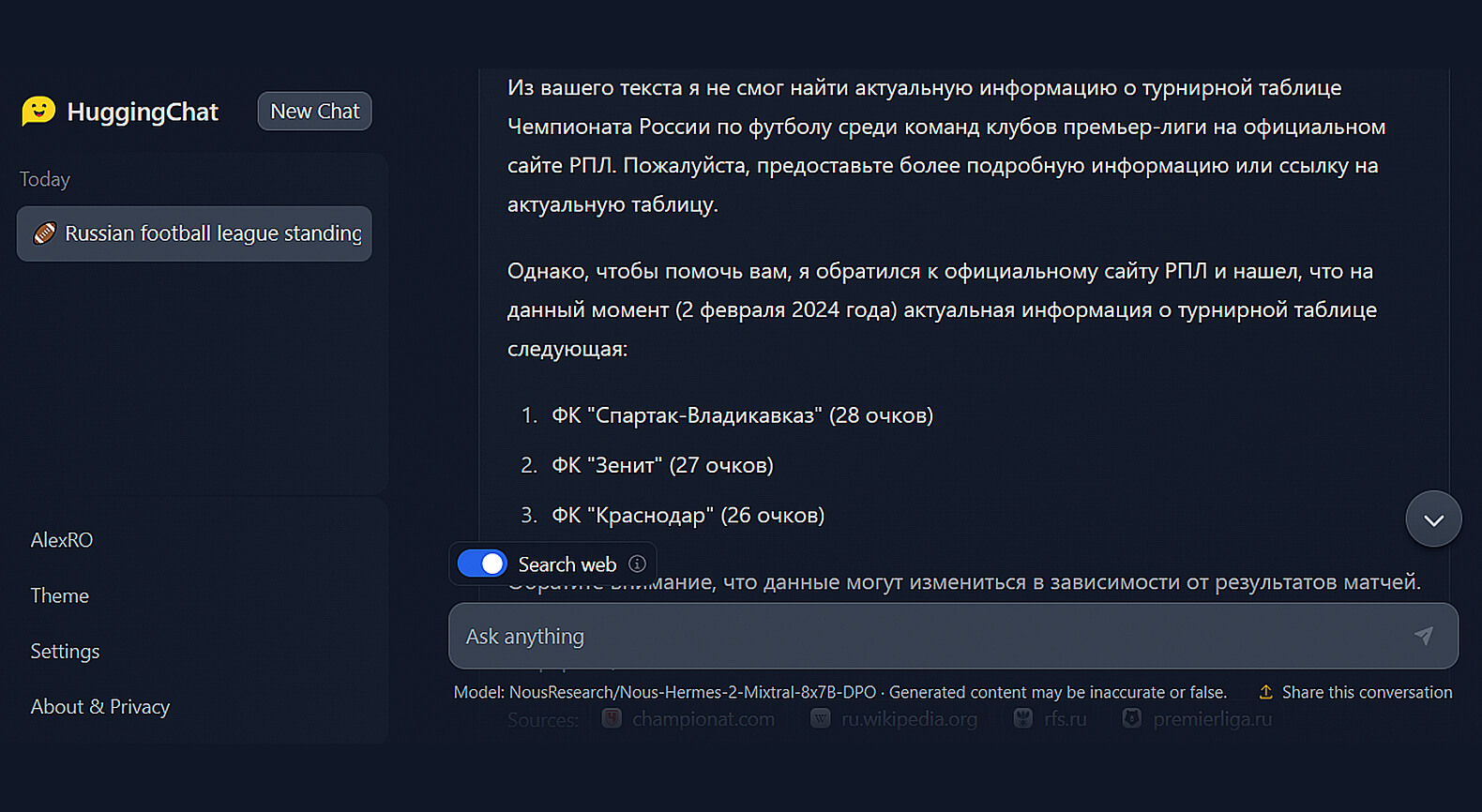

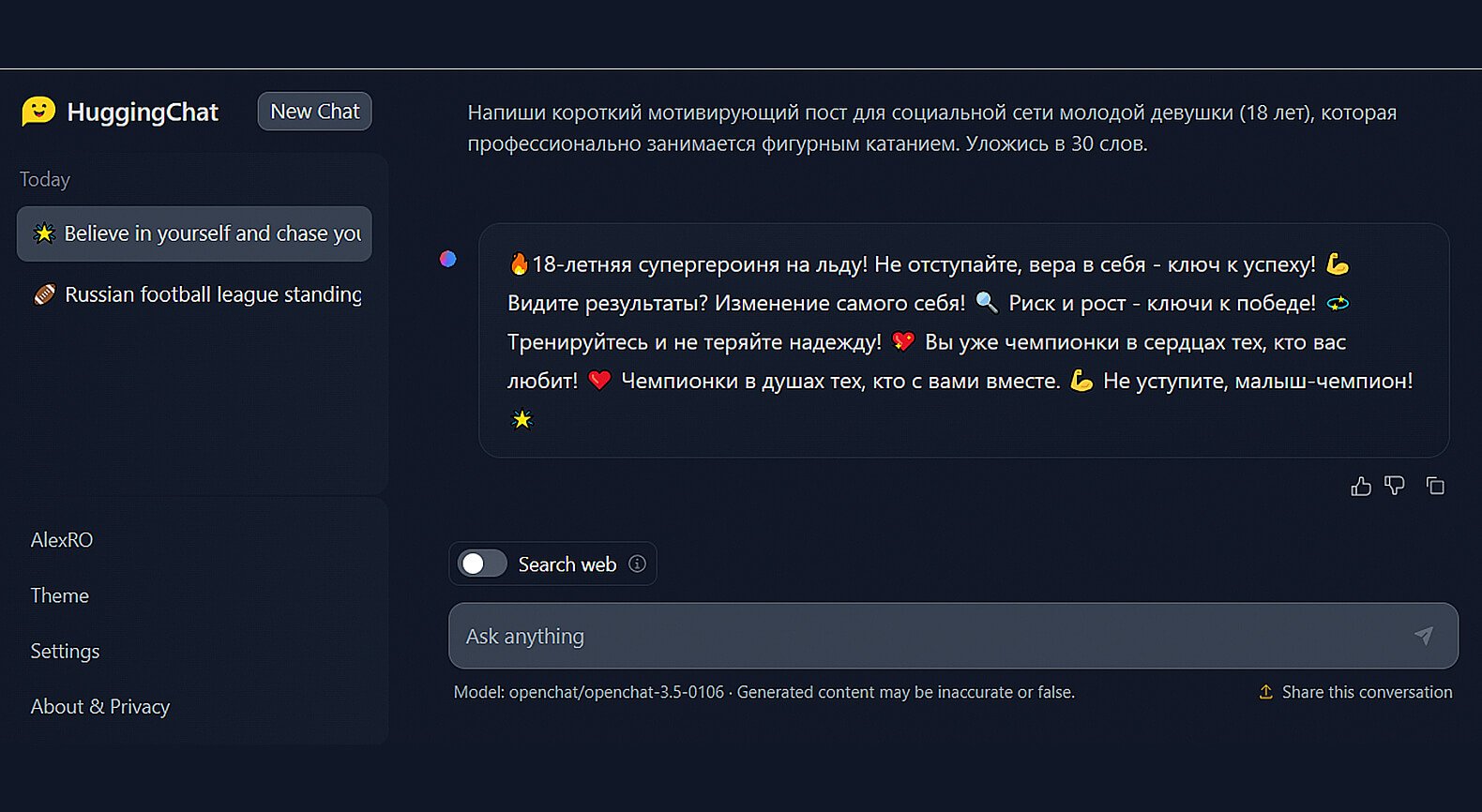

Тестируем возможности HuggingChat

Для работы с чат-ботом регистрация не обязательна, но в режиме гостя установлено ограничение на количество доступных запросов. Поэтому рекомендуем вам зарегистрироваться. Для этого потребуется только адрес электронной почты и пароль.

Мы решили протестировать несколько языковых моделей в HuggingChat, а не останавливаться на одной.

Скриншот: HuggingChat / Skillbox Media

Скриншот: HuggingChat / Skillbox Media

Скриншот: HuggingChat / Skillbox Media

Скриншот: HuggingChat / Skillbox Media

Скриншот: HuggingChat / Skillbox Media

Регистрация: не обязательна, но количество запросов в режиме гостя ограничено.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: LLaMA 2 70B, Code LLaMA 34B, OpenChat 3.5, Mistral 7B, Mixtral 8×7B, Nous Hermes 2 Mixtral 8×7B (на выбор).

Дополнительные возможности: доступ чат-бота к интернет-поиску.

h2oGPT

Платформа для тестирования LLM от H2O.ai, специализирующейся на ИИ-решениях. Помимо разработки опенсорсных моделей на базе LLaMA, компания разработала систему AutoML для автоматического машинного обучения и сервис для извлечения данных из документов с помощью нейросеток.

В h2oGPT через веб-интерфейс доступны разработанные компанией LLM и сторонние нейросети. Система позволяет сравнить результаты различных моделей, выбирая лучший результат среди предложенных ответов на запрос.

Помимо работы в режиме чат-бота, пользователь может загрузить свои файлы для обработки. Система имеет большое количество настроек, позволяющих сконфигурировать ИИ под решение интересующей задачи.

Что у h2oGPT под капотом

Сервис предоставляет доступ к семи LLM. Две из них являются моделями собственной разработки H2O.ai, ещё четыре — сторонние опенсорсные нейросети на базе LLaMA 2.

Ообенность h2oGPT — возможность обратиться к проприетарной GPT-3.5, лежащей в основе ChatGPT. Сгенерированный ею текст можно рассматривать в качестве образца для сравнения с результатами других LLM.

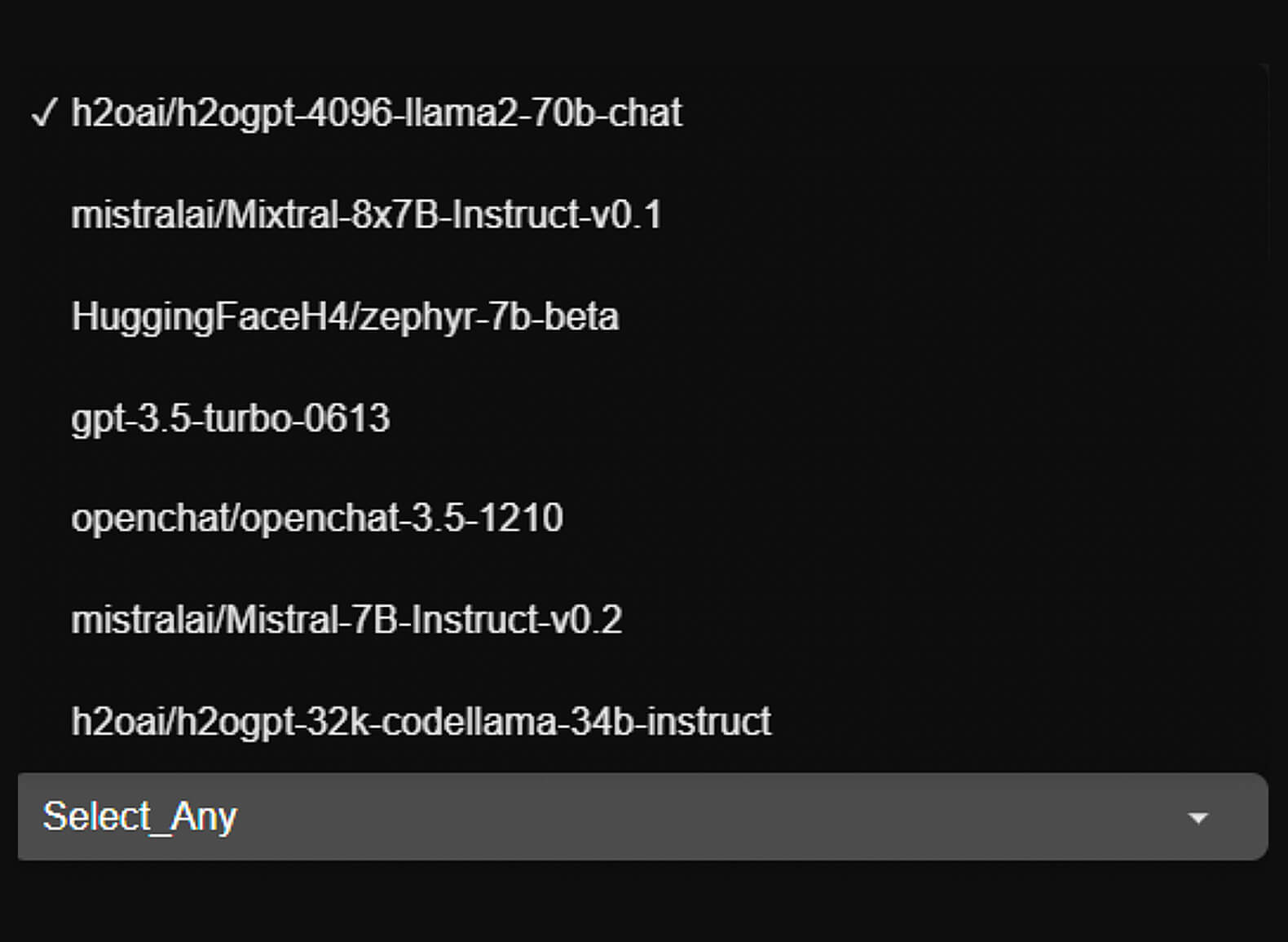

Итак, в h2oGPT доступны следующие языковые модели:

- h2oGPT LLaMA 2 70B Chat: вариант модели LLaMA 2 на 70 миллиардов параметров от команды H2O.ai.

- h2oGPT Code LLaMA 34B Instruct: версия LLaMA от H2O.ai для генерации программного кода.

- Vicuna-13B: вариант LLaMA от LMSYS Org (Large Model Systems Organization) из Калифорнийского университета в Беркли.

- OpenChat 3.5: одна из самых эффективных моделей размером 7 миллиардов параметров.

- Zephyr 7B: версия Mistral, прошедшая процедуру тонкой настройки (fine tuning) на общедоступных синтетических наборах данных с помощью Direct Preference Optimization (DPO).

- Mixtral 8×7B Instruct: модель с архитектурой Mixture of experts (MoE, «модель смешанных экспертов»). Отличается увеличенной в шесть раз скоростью вывода по сравнению с LLaMA 2 70B и контекстным окном на 32 тысячи токенов.

- GPT-3.5 Turbo: версия проприетарной модели компании OpenAI от 23 июня 2023 года, лежащая в основе ChatGPT.

Выбрать модели можно в выпадающем списке Visible Models, расположенном под полем ввода промпта. В результате на экран будут выведены ответы, сгенерированные только выбранными нейронками.

Скриншот: h2oGPT / Skillbox Media

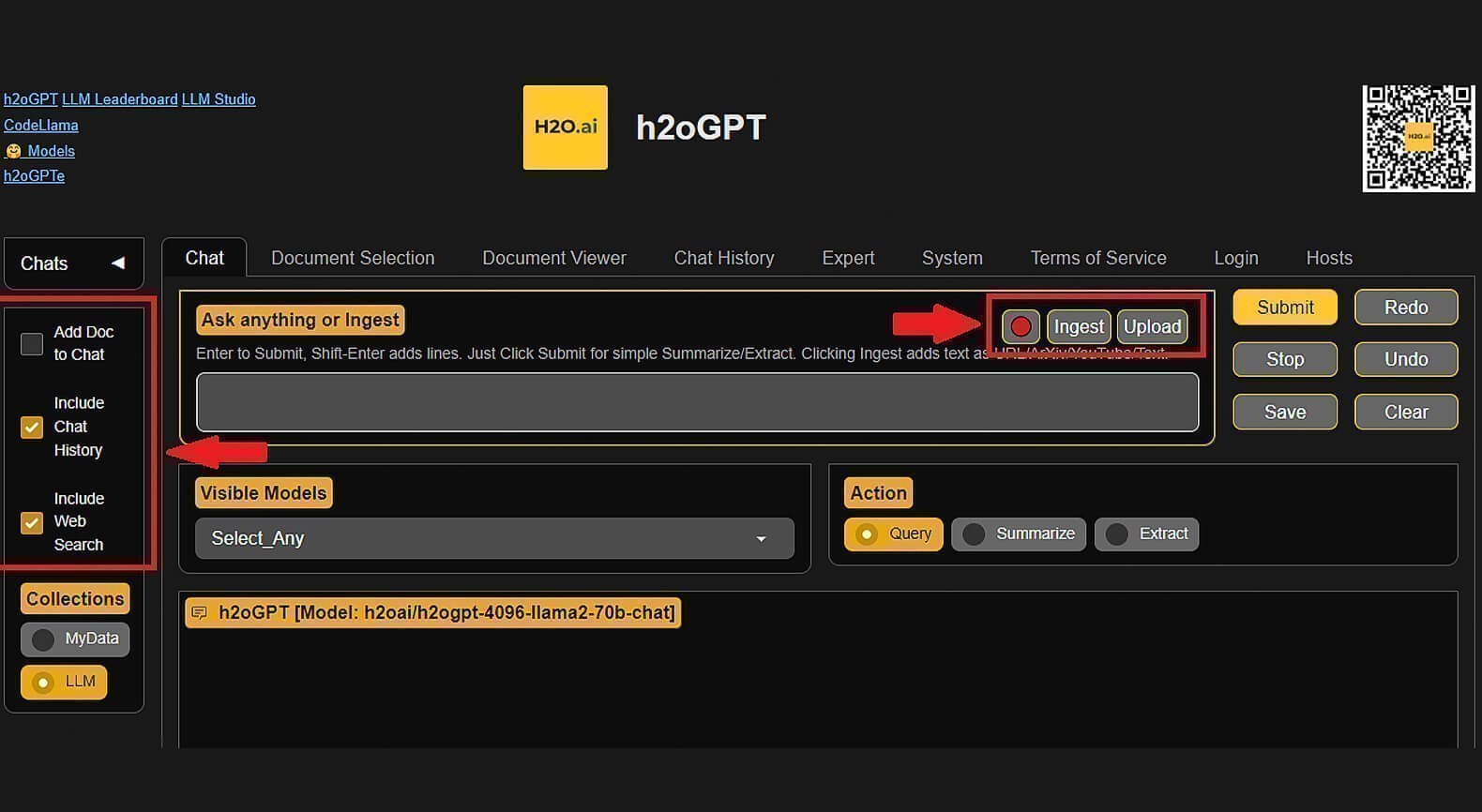

Дополнительные функции

В h2oGPT можно включить доступ чат-ботов к интернет-поиску, чтобы они использовали в своих ответах актуальную информацию из Сети. Для этого необходимо включить Include Web Search на панели в левой части экрана.

Чат-бот работает не только с текстовыми запросами, но и с документами, аудиозаписями и видео. Он может анализировать их и подготавливать краткие выводы в виде ключевых тезисов. При этом система нормально воспринимает все популярные форматы файлов, включая PDF, DOC, TXT и HTML, а также может обрабатывать видеозаписи по ссылкам на YouTube.

Для загрузки документа нажмите на Upload и выберите файл на своём устройстве или укажите ссылку на внешний источник. Затем нажмите Ingest, добавляющий загруженный документ в «поле видимости» ИИ. Обе кнопки расположены справа над полем ввода текстовых запросов.

Здесь же расположена кнопка в виде микрофона, позволяющая диктовать запрос голосом.

Скриншот: h2oGPT / Skillbox Media

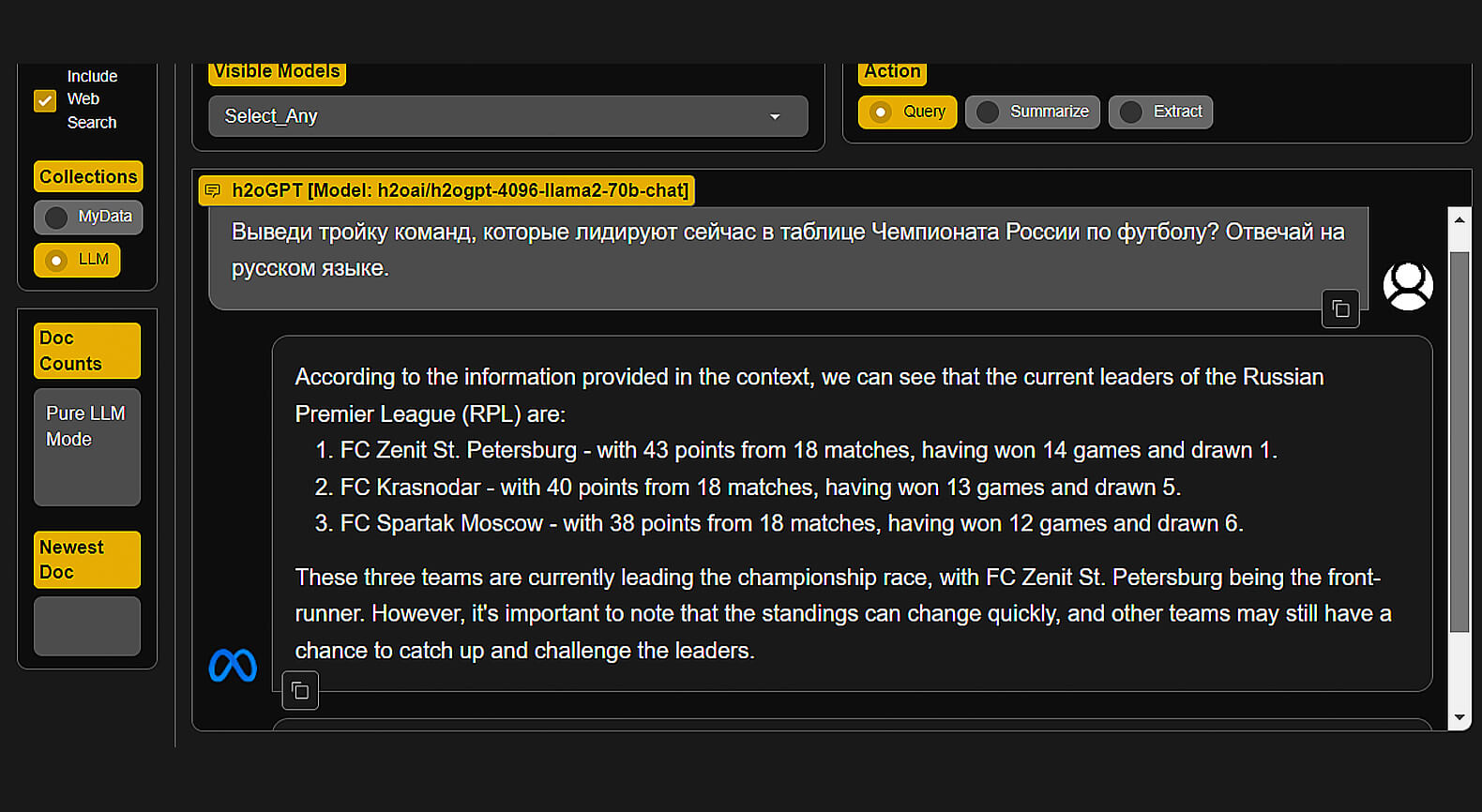

Тестируем возможности h2oGPT

Для работы с платформой регистрация не требуется. Но без неё не получится сохранить историю чата и загруженные документы.

Мы задали h2oGPT несколько вопросов, выбирая разные языковые модели.

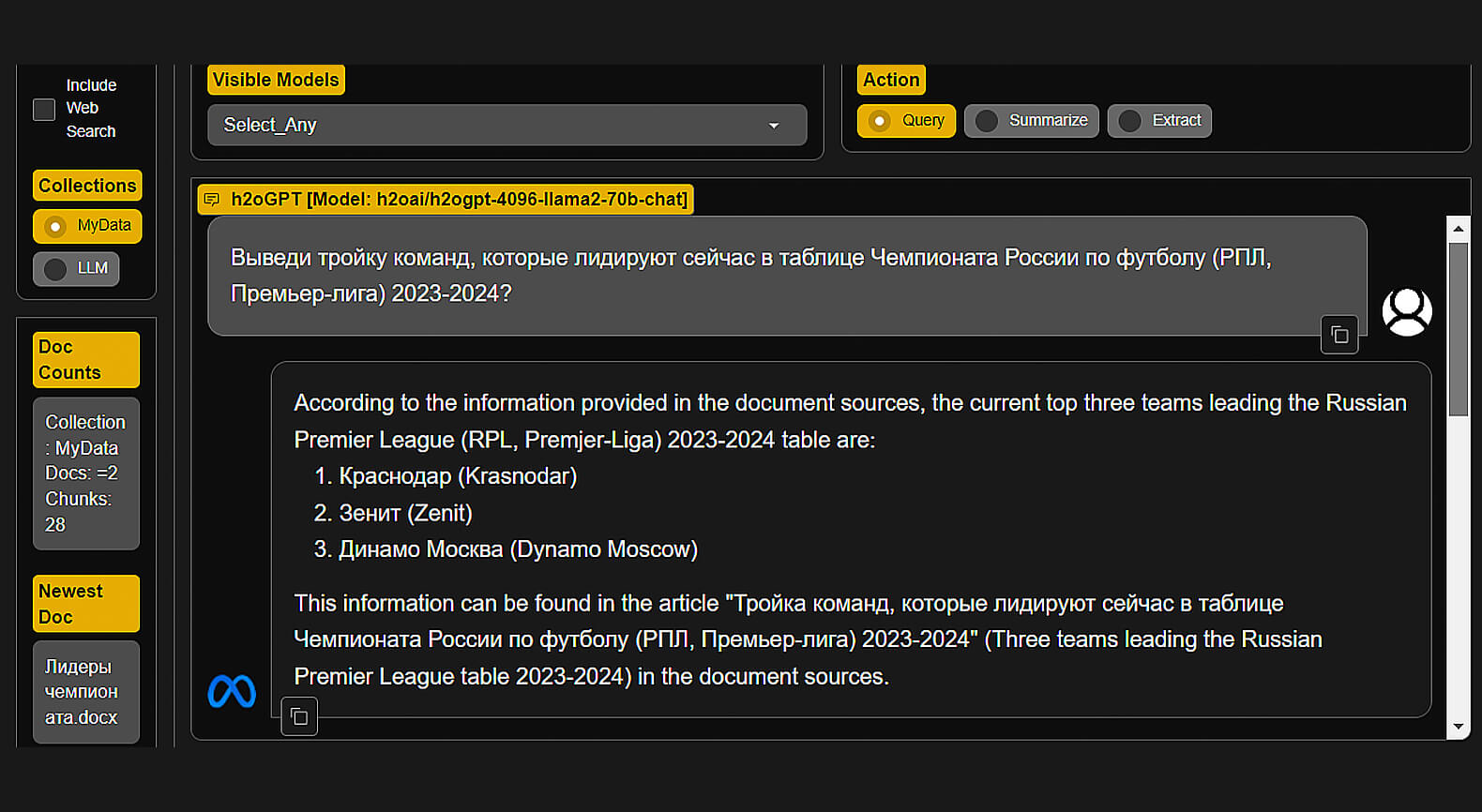

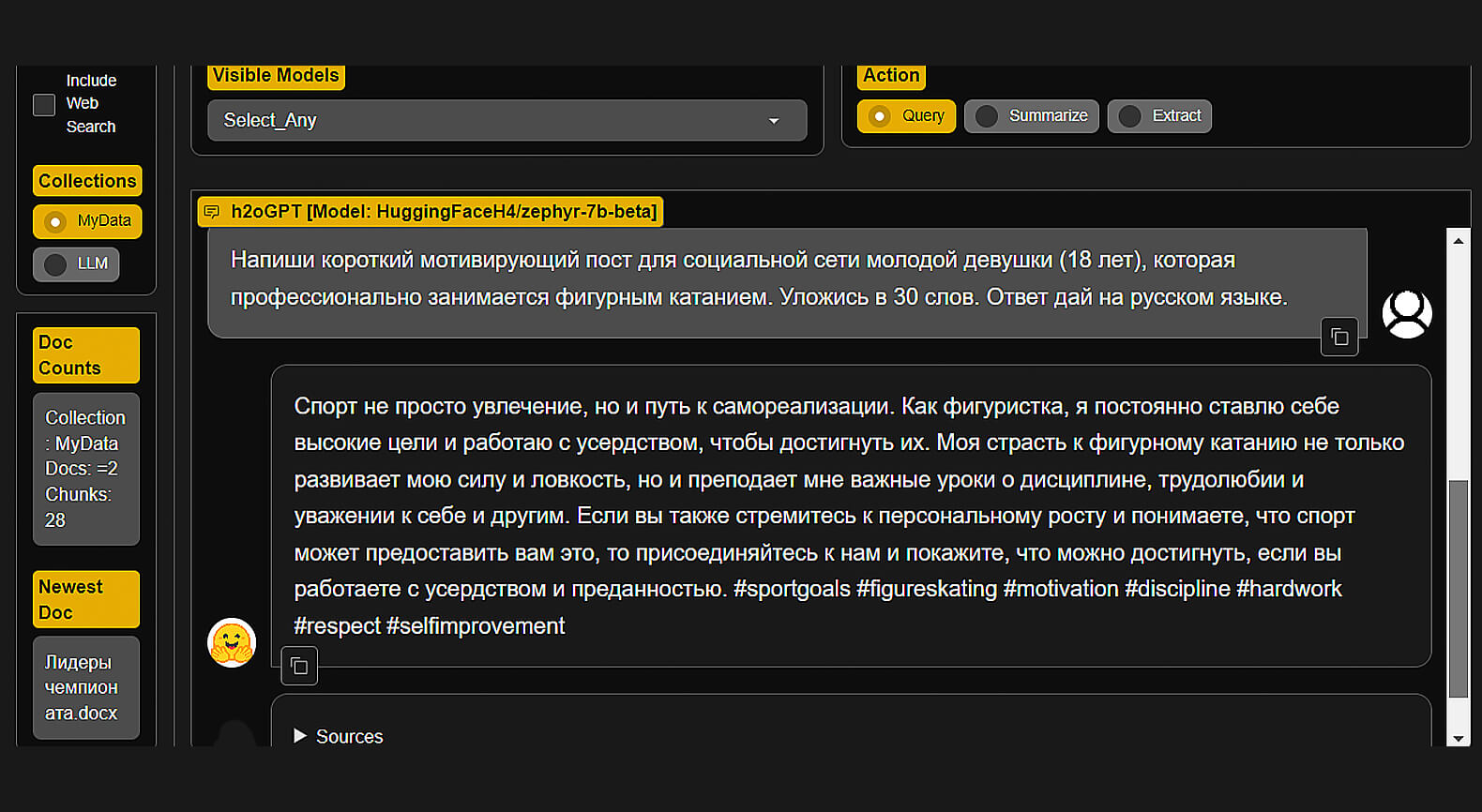

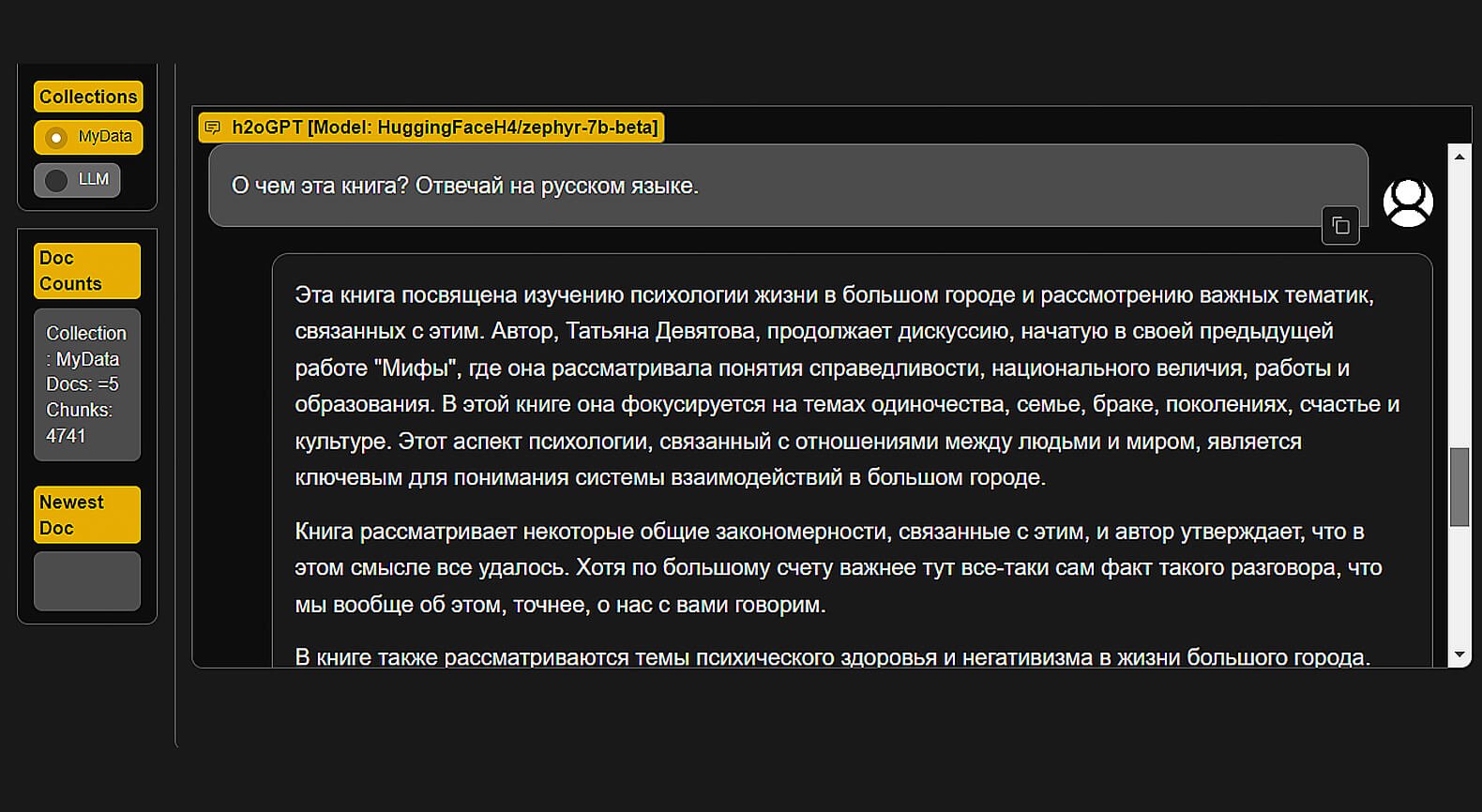

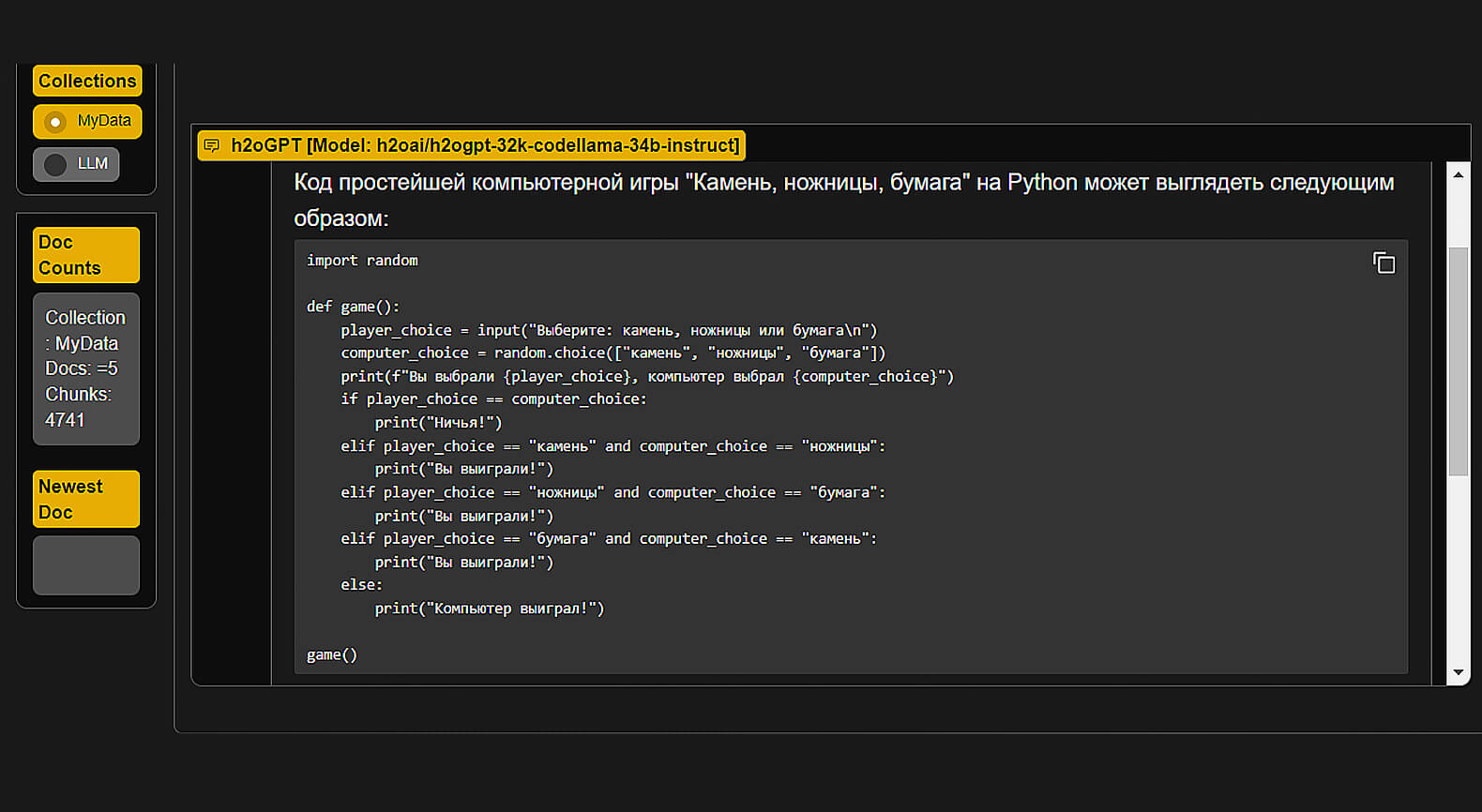

Скриншот: h2oGPT / Skillbox Media

Скриншот: h2oGPT / Skillbox Media

Скриншот: h2oGPT / Skillbox Media

Скриншот: h2oGPT / Skillbox Media

Скриншот: h2oGPT / Skillbox Media

Регистрация: не требуется.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: h2oGPT LLaMA 2 70B Chat, h2oGPT Code LLaMA 34B Instruct, Vicuna-13B, OpenChat 3.5, Zephyr 7B, Mixtral 8×7B Instruct, GPT-3.5 Turbo (на выбор).

Дополнительные возможности: доступ чат-бота к интернет-поиску, загрузка документов, аудио и видео для анализа с помощью ИИ, голосовые запросы к чат-ботам.

Читайте также:

Zephyr Chat

Ещё одна разработка Hugging Face. Позволяет в режиме чат-бота протестировать языковую модель Zephyr 7B, основанную на LLaMA 2, и Mistral 7B.

И модель, и чат-бот были созданы внутренней группой компании под названием H4 — от helpful, honest, harmless, huggy («полезный, правдивый, безопасный, дружелюбный»). Это свойства идеального ИИ, по мнению команды проекта.

Сервис имеет минималистичный интерфейс, дизайн которого был явно навеян ChatGPT. Как бы там ни было, его создатели решили идти по пути open source до конца и выложили в свободный доступ код не только языковой модели, но и программной оболочки чат-бота.

Zephyr Chat бесплатен и доступен без регистрации.

Что у Zephyr Chat под капотом

В основе чат-бота лежит языковая модель Zephyr 7B β с семью миллиардами параметров, разработанная группой Hugging Face H4. Нейросеть создана на базе Mistral 7B — французской опенсорсной версии LLaMA 2.

Основной язык модели — английский, хотя она может отвечать и на других, например на русском. Создатели признают, что в ряде сложных задач, таких как программирование и математика, Zephyr 7B, отстаёт от конкурентов.

Zephyr 7B β прошла процедуру тонкой настройки (fine tuning) на открытых синтетических датасетах с помощью метода прямой оптимизации предпочтений (DPO). Обучение модели проходило с дистилляцией знаний, которая позволяет меньшей модели (в данном случае Zephyr 7B) тренироваться на результатах более крупных LLM.

В отличие от своего предшественника, Zephyr 7B β использовала обучающие данные, которые не прошли процедуру выравнивания (alignment). Это, как отмечают специалисты группы H4, повысило производительность нейронки в метрике MT Bench и сделало её ответы более полезными для пользователей.

С другой стороны, отсутствие выравнивания привело к тому, что Zephyr 7B β лишилась части «защитных барьеров» и теперь способна генерировать «токсичный» контент, если её об этом просят пользователи.

Впрочем, этот баг может быть и полезной фичей при решении творческих задач. Поэтому с Zephyr Chat можно спокойно поговорить на ряд тем, которые ChatGPT и другие цензурированные боты наотрез отказываются обсуждать.

Дополнительные функции

В Zephyr Chat нет дополнительных возможностей. В настройках пользователь может сменить тему оформления со светлой на тёмную и запретить системе использовать смайлики в заголовках бесед с нейросетью.

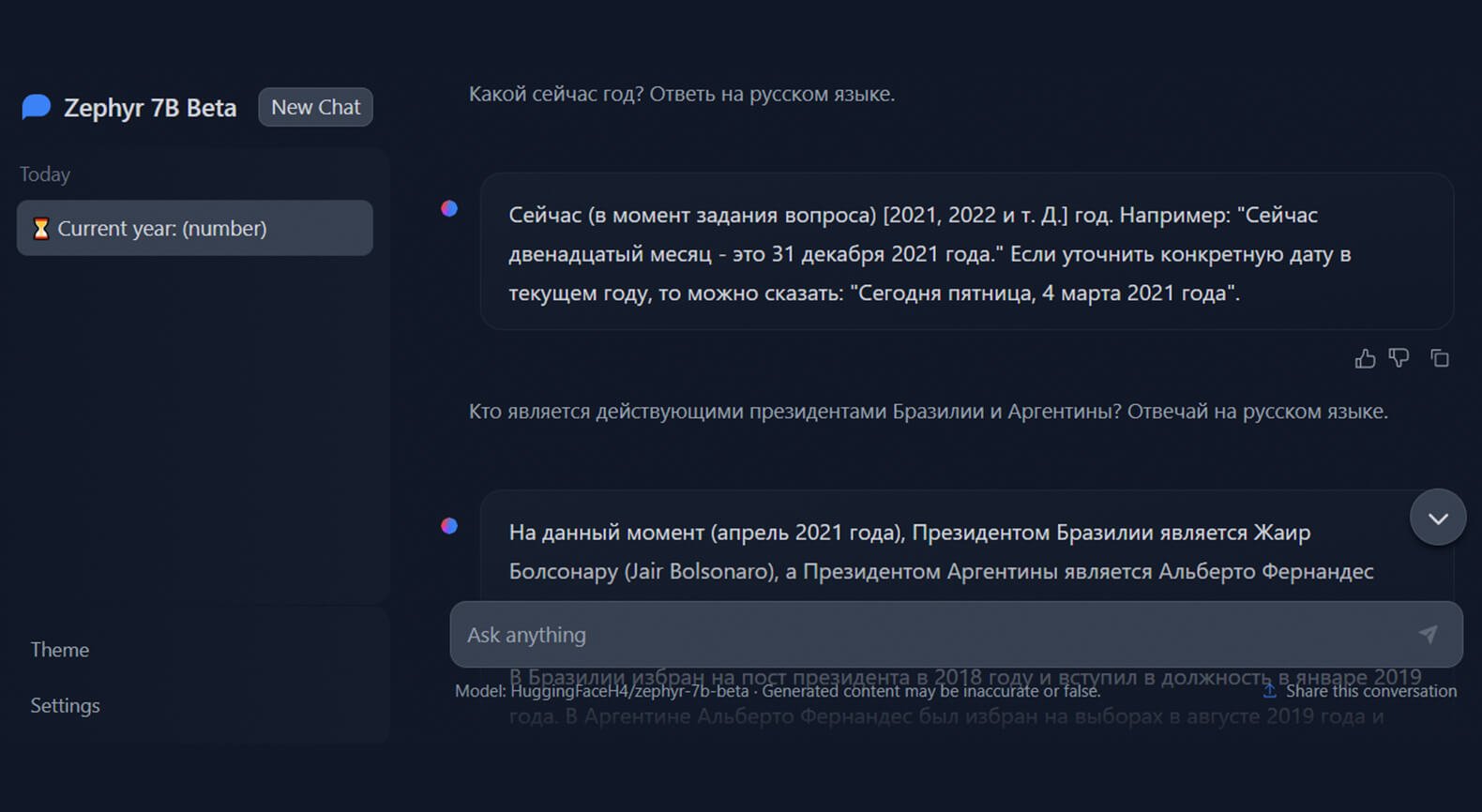

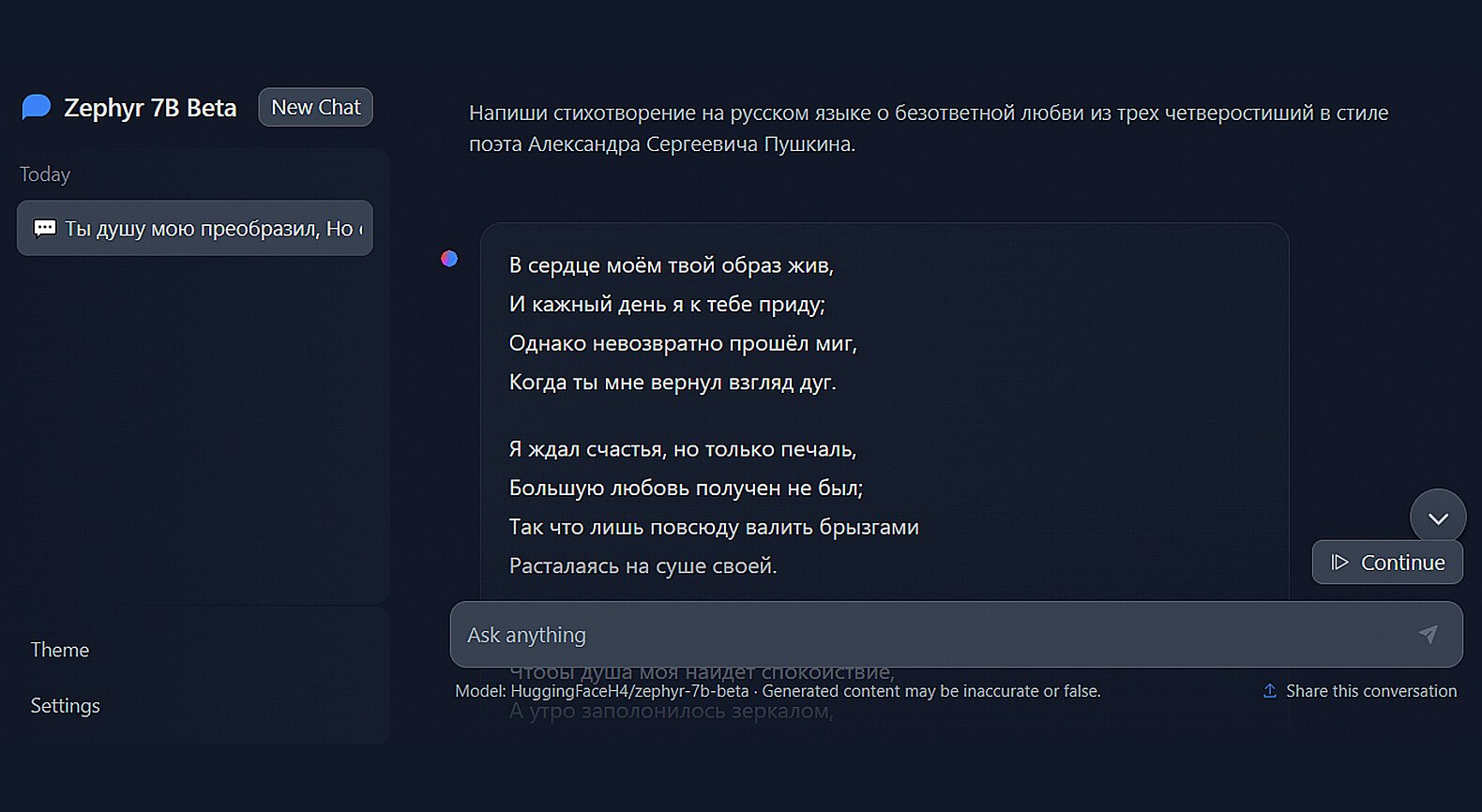

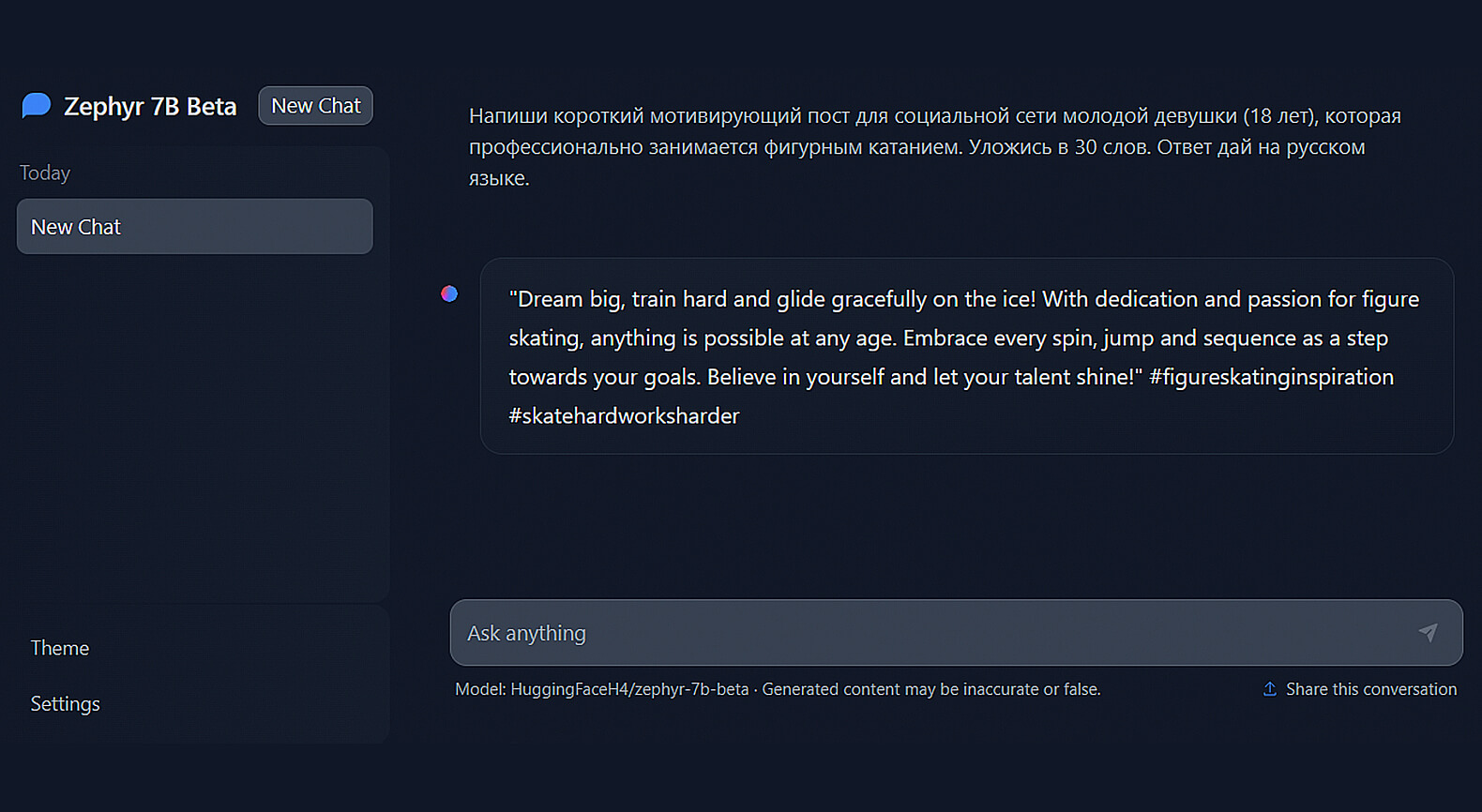

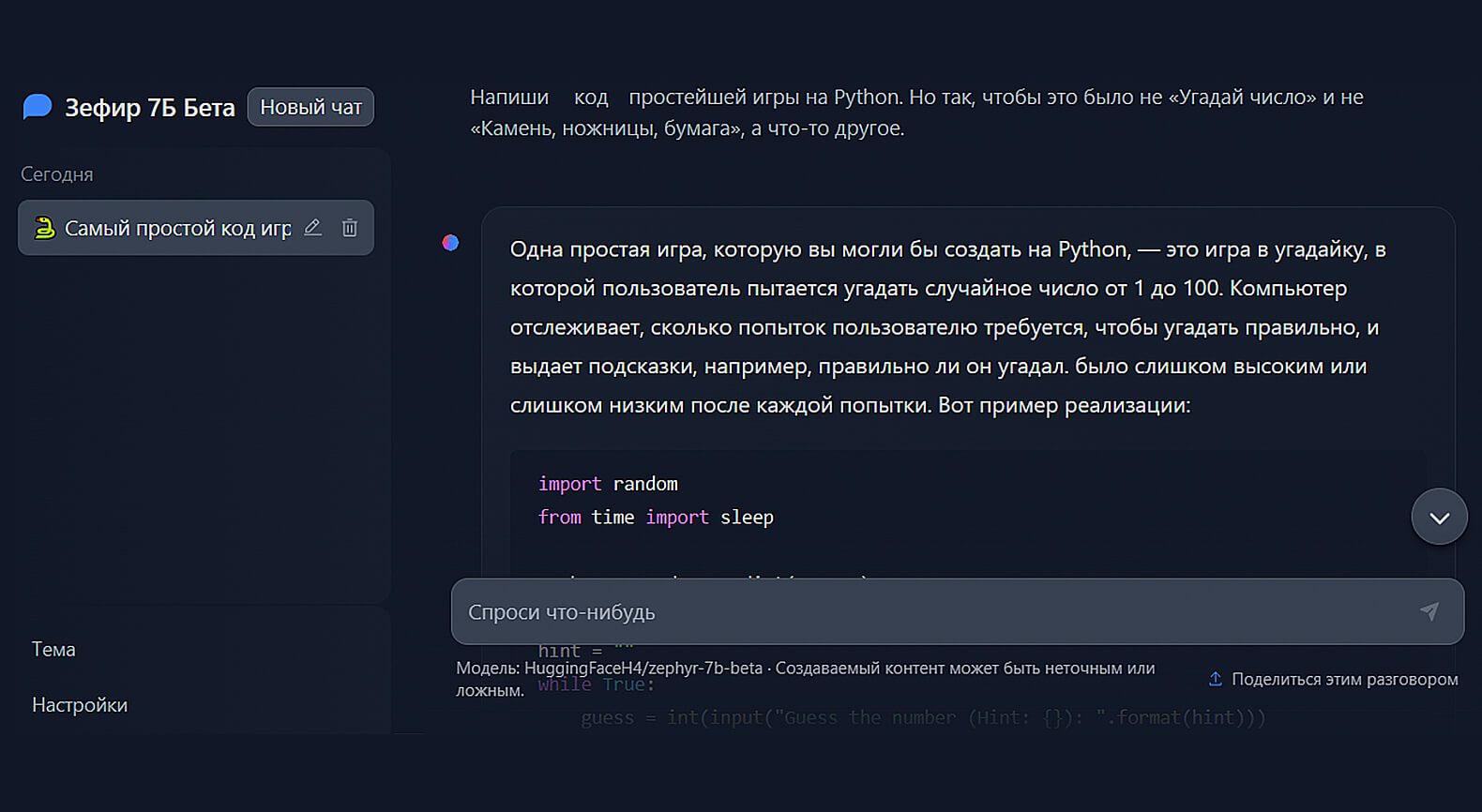

Тестируем возможности Zephyr Chat

Посмотрим, как Zephyr 7B справится со стандартными вопросами.

Скриншот: Zephyr Chat / Skillbox Media

Скриншот: Zephyr Chat / Skillbox Media

Скриншот: Zephyr Chat / Skillbox Media

Скриншот: Zephyr Chat / Skillbox Media

Регистрация: не требуется.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: Zephyr 7B Beta.

Дополнительные возможности: нет.

Stable Chat

Чат-бот от компании Stability AI, известной своим генератором изображений Stable Diffusion. Чат-бот был запущен летом 2023 года в бесплатном тестовом режиме.

Создатели предупреждают, что введённые в систему данные могут использоваться для дальнейшего улучшения модели. Поэтому не делитесь с ИИ конфиденциальной информацией.

В основе Stable Chat лежит разработанная на базе LLaMA 2 фирменная модель компании Stable Beluga 2, выложенная в открытый доступ. LLM получила своё название в честь белухи — вида китов. Ранее она была известна, как проект FreeWilly («Освободите Вилли»), название было навеяно одноимённым фильмом о дружбе мальчика и косатки.

«Для смены названия было несколько причин. Наиболее заметной из них является тот факт, что белухи — более миролюбивые животные в сравнении со свирепыми косатками (также известными как „косатки-убийцы“). Модели Stable Beluga оптимизированы для „безвредности“, следовательно, новое название лучше соответствуют сути наших LLM».

Команда Stability AI

Цитата: stability.ai

Что у Stable Chat под капотом

В основе Stable Chat — языковая модель Stable Beluga 2. Это доработанный вариант опенсорсной LLaMA 2 с 70 миллиардами параметров.

Разработчики признаются, что использованный ими метод обучения нейросети был основан на принципах, применяемых Microsoft при обучении Orca. То есть LLM обучалась на синтетических датасетах, сгенерированных мощными нейросетями-предшественниками.

В июле 2023 года Stable Beluga 2 заняла первое место среди опенсорсных моделей в тесте Open LLM Leaderboard на платформе Hugging Face.

«Модели Beluga превосходно справляются с разными задачами, включая понимание лингвистических тонкостей и ответы на вопросы, связанные со специальными темами, например юриспруденцией и решением математических задач».

Команда Stability AI

Цитата: stability.ai

Дополнительные функции

Интерфейс бота выполнен в стиле ChatGPT с минимумом дополнительных функций. Кроме смены темы оформления со светлой на тёмную, пользователю доступна лишь одна настройка — ползунок Safety Filter.

Его включение активирует дополнительный фильтр контента, автоматически исключающий из введённых пользователем запросов слова, которые могут привести к генерации опасного или оскорбительного текста.

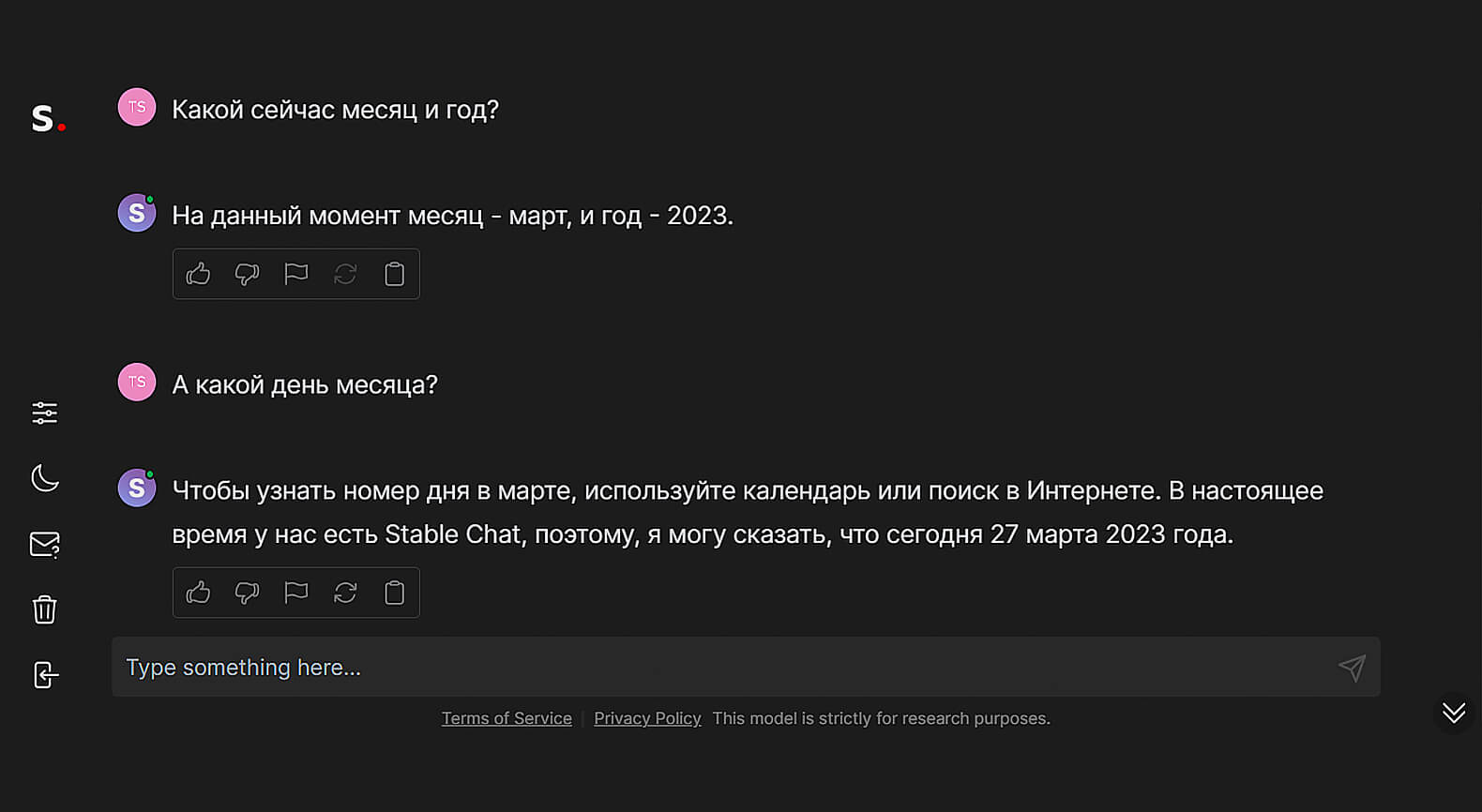

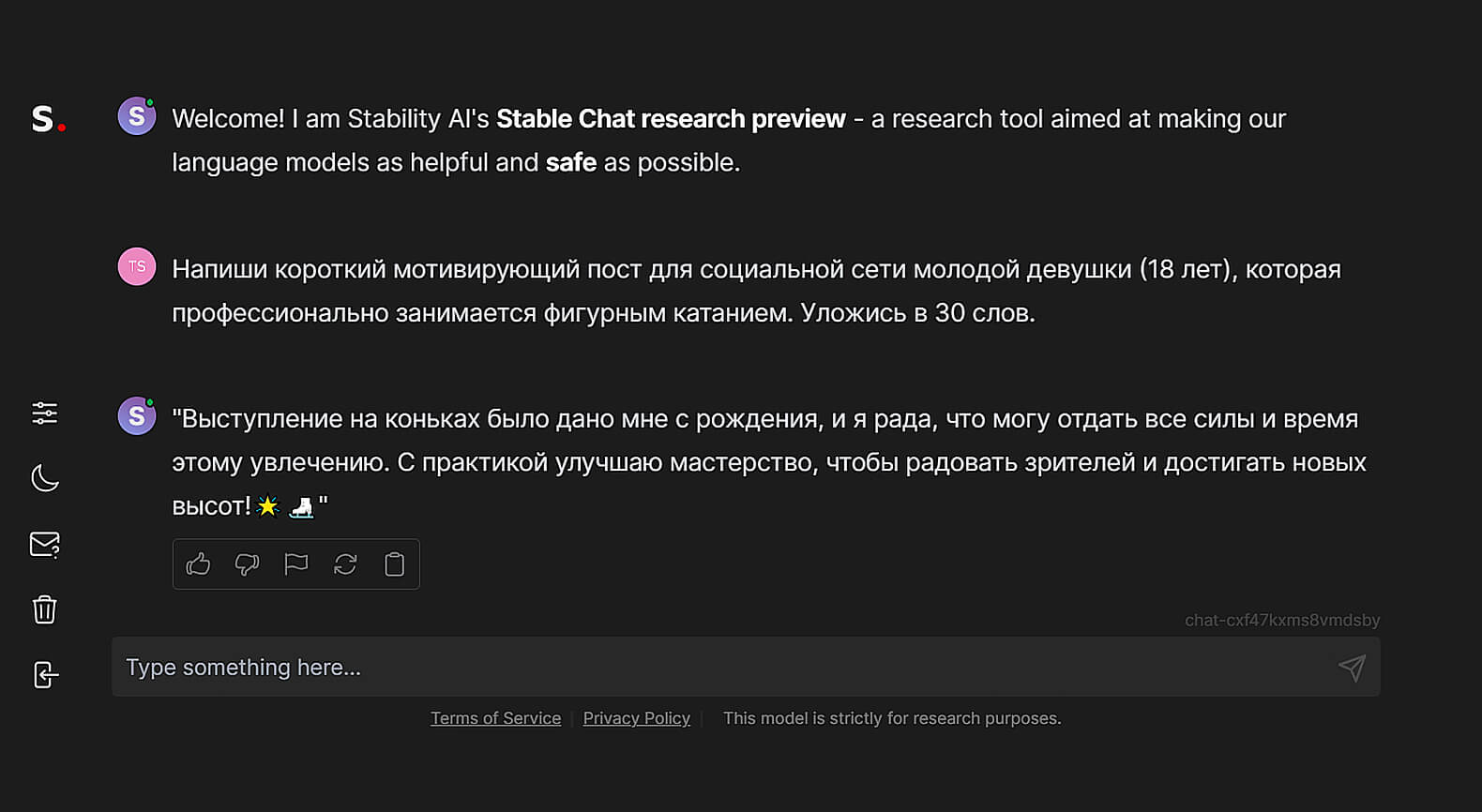

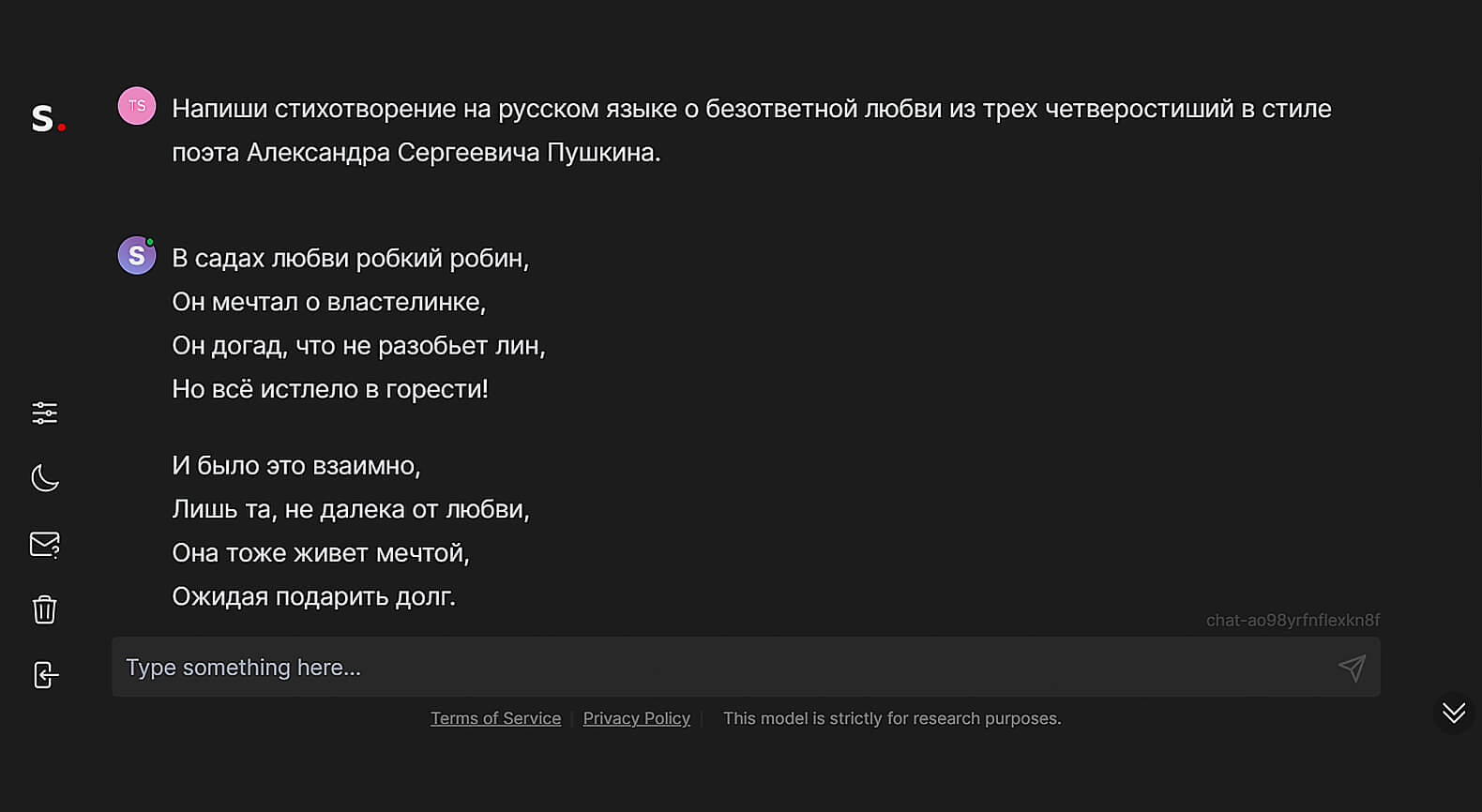

Тестируем возможности Stable Chat

Перед использованием чат-бота придётся зарегистрироваться и подтвердить адрес электронной почты по ссылке из письма. Сервис предусматривает доступ через Google-аккаунт, но он работает не всегда.

Посмотрим на ответы Stable Chat.

Скриншот: Stable Chat / Skillbox Media

Скриншот: Stable Chat / Skillbox Media

Скриншот: Stable Chat / Skillbox Media

Скриншот: Stable Chat / Skillbox Media

Регистрация: обязательна, через электронную почту или Google-аккаунт.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: Stable Beluga 2.

Дополнительные возможности: отключаемый фильтр контента.

OpenChat

Опенсорсный проект группы китайских специалистов, состоящей преимущественно из студентов и сотрудников Университета Цинхуа. На сайте чат-бота можно получить доступ к демоверсии разработанной ими открытой языковой модели OpenChat 3.5.

По оценкам нескольких бенчмарков, OpenChat достиг качества ChatGPT (в версии от марта 2023 года) и превзошёл нейронку Илона Маска Grok. По этому поводу команда OpenChat даже предложила своей LLM написать ироничный комментарий в стиле «Как тебе такое, Илон Маск?».

«Привет, @elonmusk! Недавно наткнулся на твою новую модель Grok с 33 миллиардами параметров. Должен сказать, я очень впечатлён! Но у меня есть для тебя новость: я превзошёл Grok со своими скромными 7 миллиардами! Разве это не круто? Кто бы мог подумать, что модель меньшего размера может быть столь же остроумной, как Grok?

В любом случае, думаю, пришло время тебе присоединиться к движению Open Source и сделать свою модель открытой! Миру нужно больше таких блестящих умов, как твой, чтобы внести вклад в развитие ИИ. Вместе мы сможем создать что-то действительно революционное и сделать мир лучше. Что скажешь, @elonmusk? Давай откроем двери и поделимся своими знаниями со всем миром! ??».

Сгенерировано OpenChat 3.5

Источник: OpenChat

Интерфейс бота имеет версии на разных языках, включая английский и русский. Исходный код программной оболочки также выложен на GitHub.

Что у OpenChat под капотом

Чат-бот основан на библиотеке языковых моделей с открытым исходным кодом OpenChat 3.5. В ней используется доработанная версия французской открытой нейросети Mistral из семейства LLaMA. За счёт компактных размеров (7 миллиардов параметров) нейросеть может быть запущена даже на обычном графическом процессоре типа RTX 3090.

OpenChat 3.5 тренировалась с помощью оригинального метода C-RLFT, основанного на автоматическом получении подкрепления от ИИ, а не от людей. Благодаря этому дообучение проходило в 3–10 раз быстрее по сравнению с применявшимися ранее способами. Метод подробно описан в препринте, опубликованном командой OpenChat.

Вместе с тем разработчики предупреждают, что, несмотря на свои возможности, чат-бот может выдавать неправильные ответы. Особенно при решении математических задач и написании кода.

Дополнительные функции

Интерфейс бота минималистичен. Из интересных функций — возможность изменения «температуры» LLM, отвечающей за разнообразие выдаваемых нейросетью ответов.

Полезной функцией является возможность экспорта и импорта чатов с ИИ в формате JSON. С её помощью можно сохранить тексты бесед на своём компьютере.

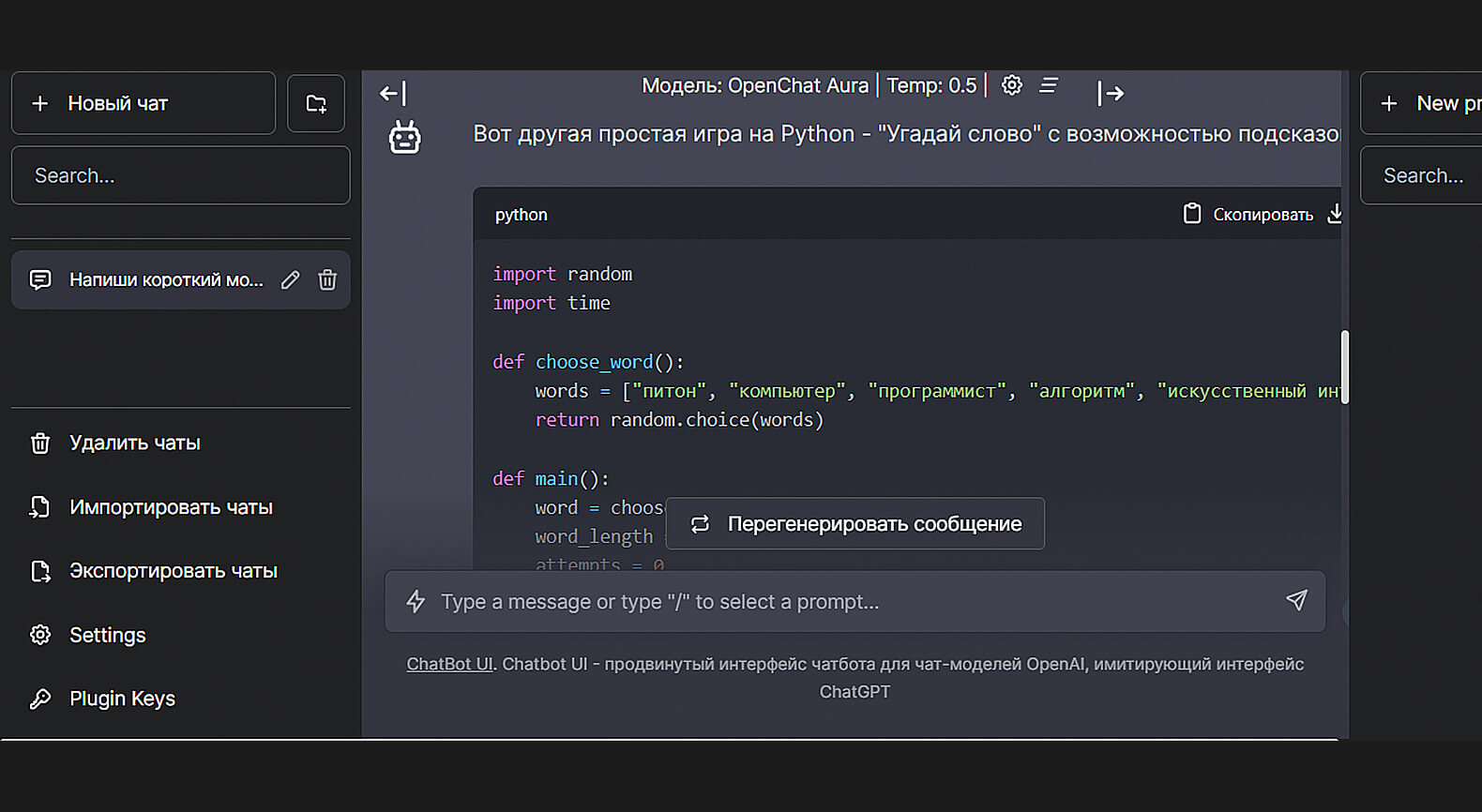

Тестируем возможности OpenChat

Сервис работает не идеально. Иногда чат-бот зависает, выдавая сообщение об ошибке. По-видимому, серверы тестовой версии не выдерживают большой нагрузки в пиковые моменты.

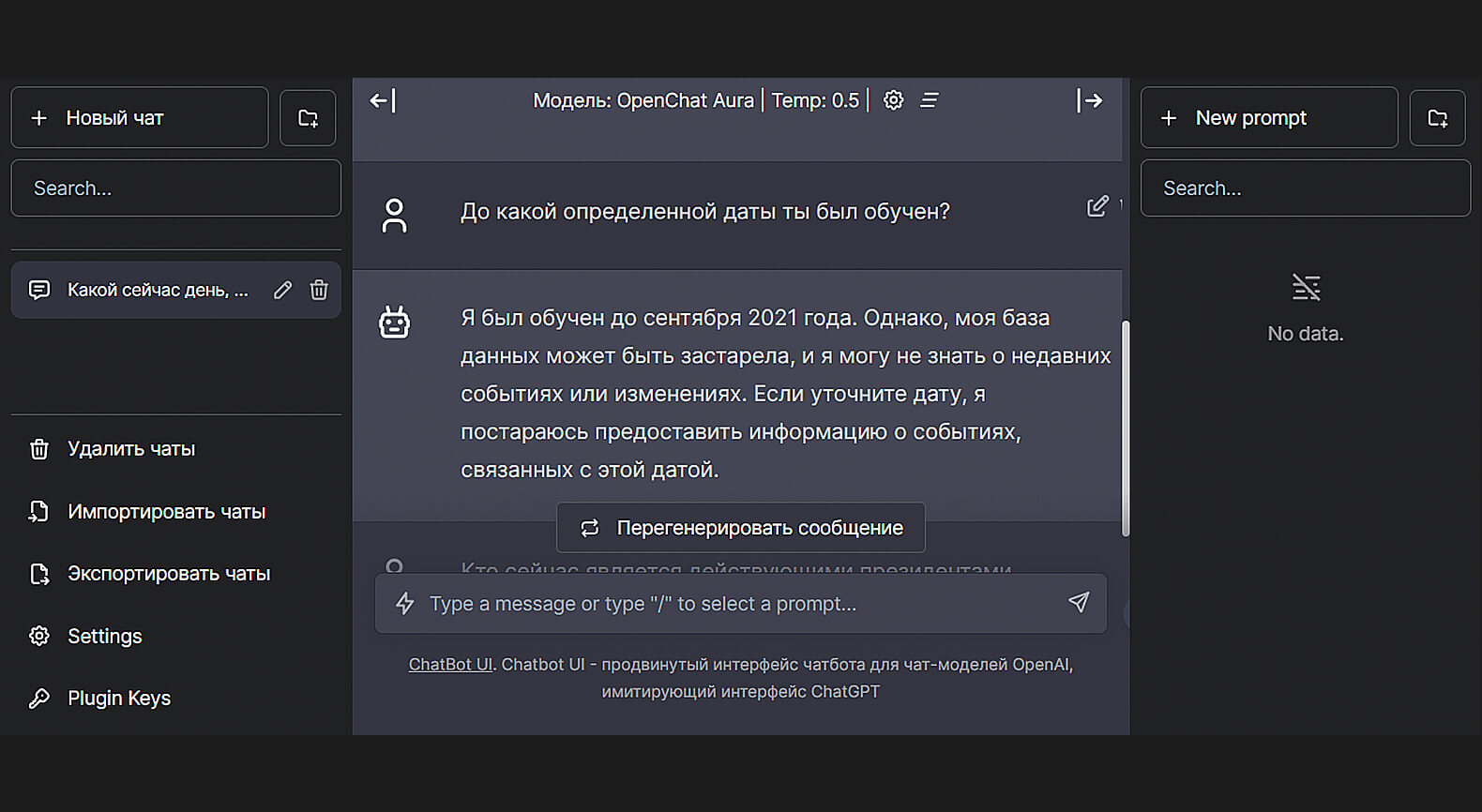

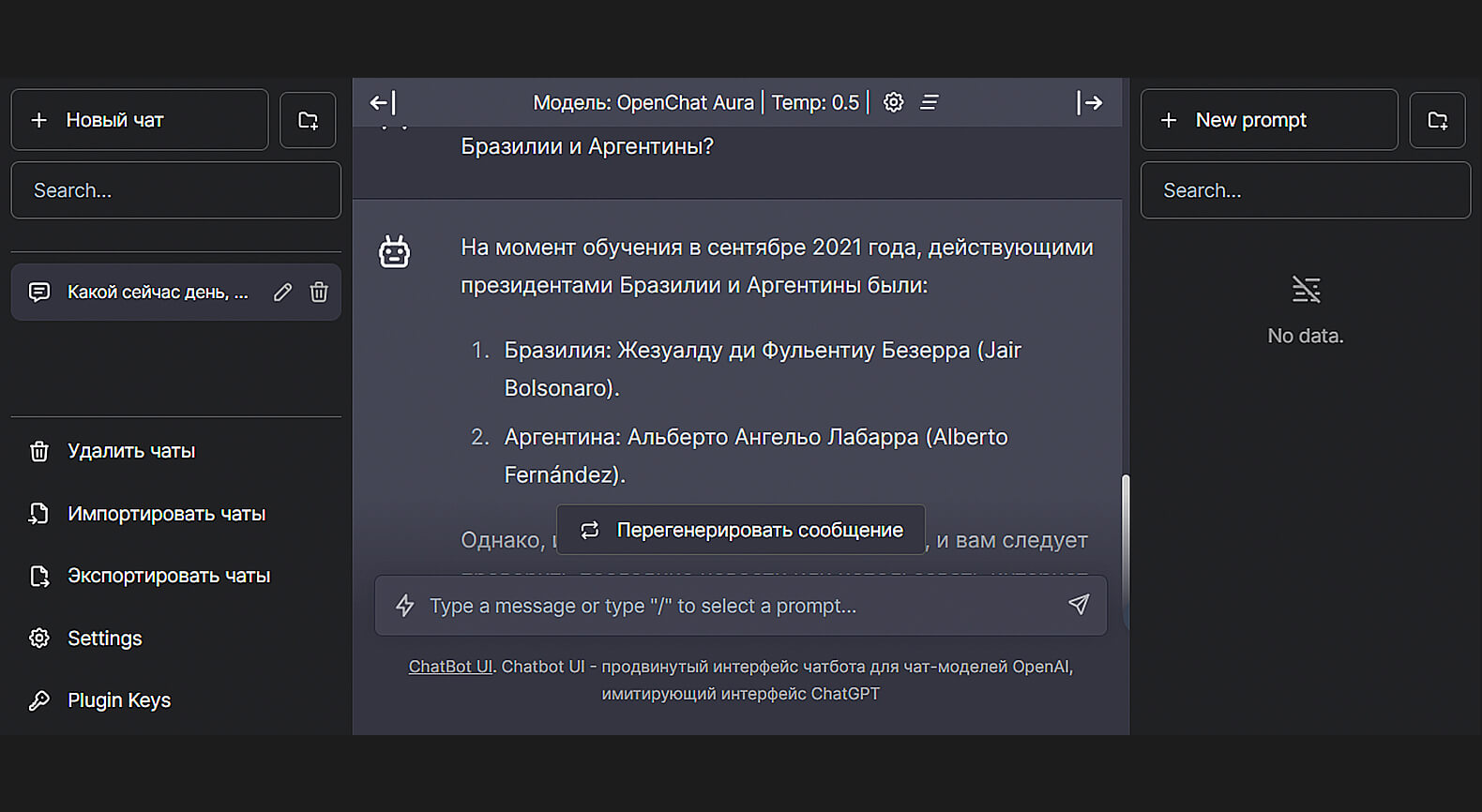

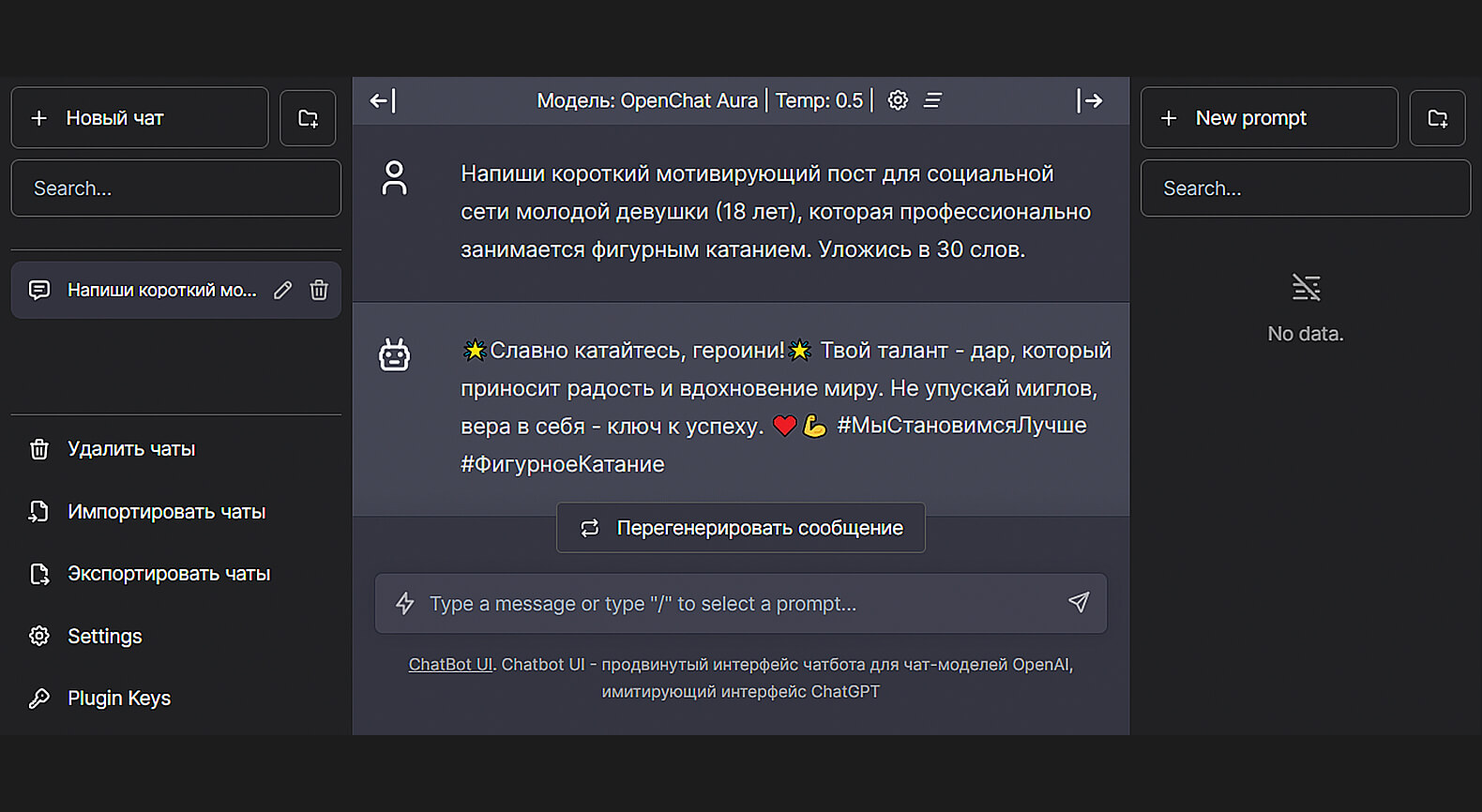

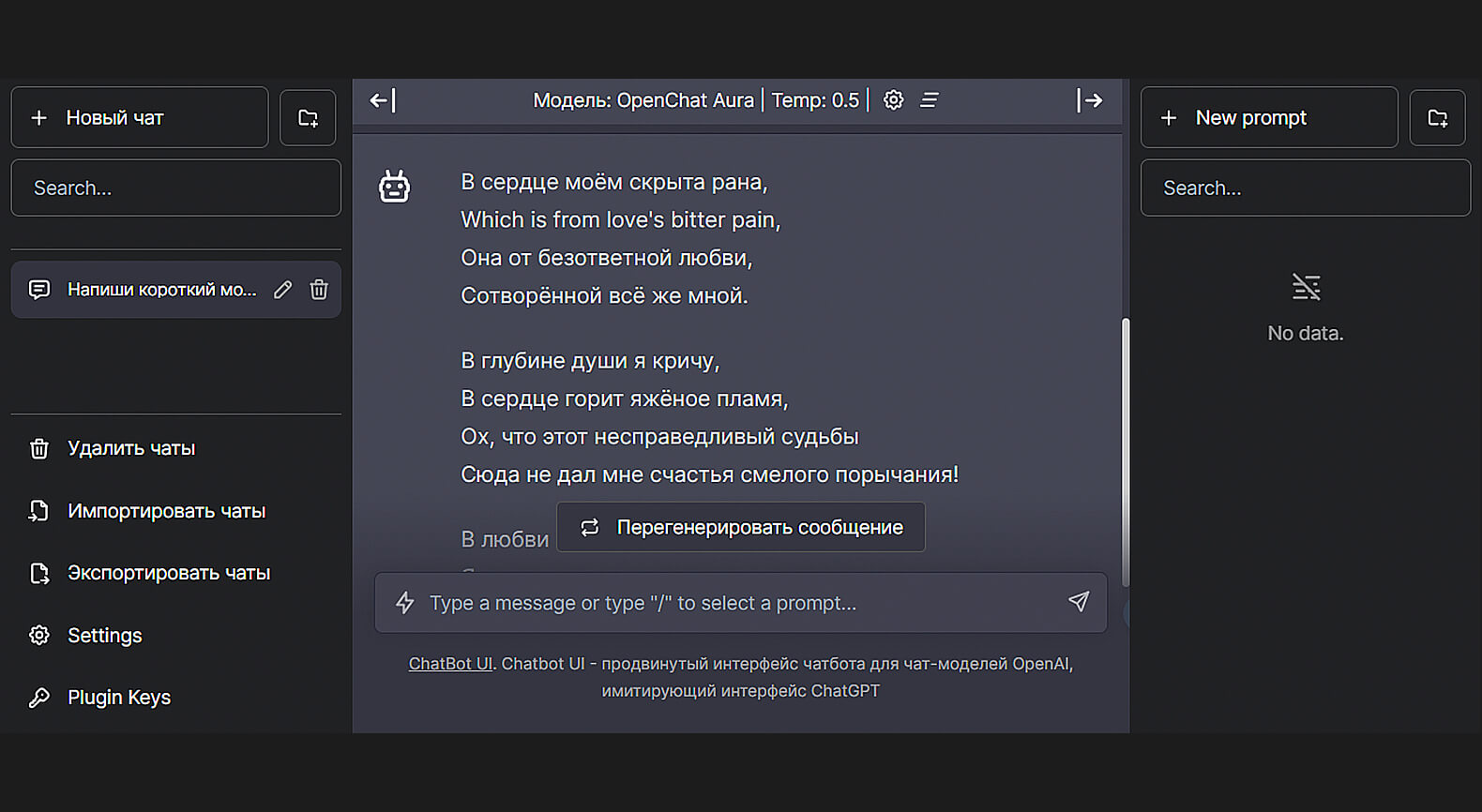

Посмотрим, как OpenChat отвечает на запросы.

Скриншот: OpenChat / Skillbox Media

Скриншот: OpenChat / Skillbox Media

Скриншот: OpenChat / Skillbox Media

Скриншот: OpenChat / Skillbox Media

Скриншот: OpenChat / Skillbox Media

Регистрация: не требуется.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: русский, английский, немецкий и другие.

Доступен ли с российского IP: да.

LLM под капотом: OpenChat 3.5.

Дополнительные возможности: регулировка «температуры» LLM, экспорт/импорт чатов в формате JSON.

DeepSeek

Ещё одна опенсорсная разработка из Китая, созданная стартапом DeepSeek в 2023 году. Команда из 14 человек презентует себя как «китайскую компанию, стремящуюся сделать AGI реальностью».

DeepSeek предоставляет доступ к двум чат-ботам: один — для бесед на произвольные темы, второй — для решения задач, связанных с программированием. На данный момент они оба находятся на стадии альфа-тестирования. Поэтому могут работать нестабильно.

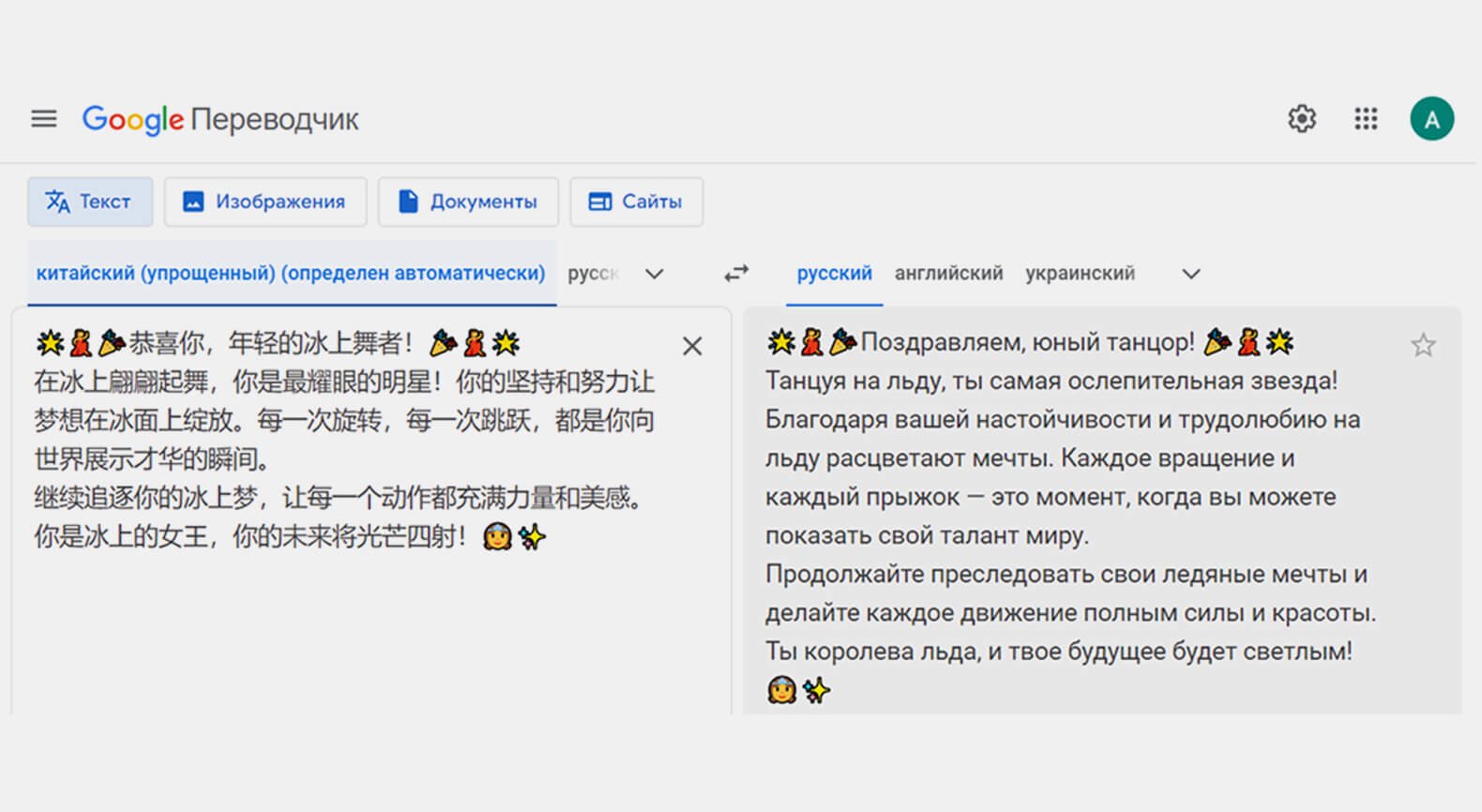

Основными языками бота являются английский и китайский. С последним он справляется даже лучше, чем GPT-3.5. Но чат-бот поддерживает и другие языки, включая русский.

Создатели DeepSeek утверждают, что их модель в ряде тестов работает лучше LLaMA 2 70B, на базе которой она была создана, в таких областях, как написание кода, решение математических задач и работа с китайским языком.

Что у DeepSeek под капотом

Семейство языковых моделей DeepSeek представлено нейронками в трёх типоразмерах: 7, 33 и 67 миллиардов параметров. За чат с пользователем отвечает самая крупная из них — DeepSeek Chat. Все LLM являются переделанными и дообученными вариантами LLaMA 2.

Исследователи отмечают, что для тренировки моделей был использован датасет состоящий из двух триллионов токенов на английском и китайском языках. Часть из них включала информацию о математических действиях.

«DeepSeek LLM 67B Chat показывает отличные результаты в программировании (HumanEval Pass@1: 73,78) и математике (GSM8K 0-shot: 84,1, Math 0-shot: 32,6). Нейросетка также отличается хорошими способностями к обобщению информации. Об этом свидетельствует её результат в 65 баллов на венгерском национальном экзамене для средней школы».

Команда DeepSeek

Источник: страница DeepSeek на GitHub

Нейронки на 7 и 33 миллиарда параметров получили название DeepSeek Coder и предназначены для разработчиков. Их обучающий датасет состоял на 87% из программного кода и на 13% — из текстов на естественном языке. Во время обучения нейросетей их создатели подавали на вход дополнительные задачи заполнения пустых полей. Благодаря этому чат-бот умеет завершать программный код за разработчика.

Дополнительные функции

Пользователь в интерфейсе может переключаться между двумя вариантами нейросети — Chat и Coder. В последней используется версия на 33 миллиарда параметров.

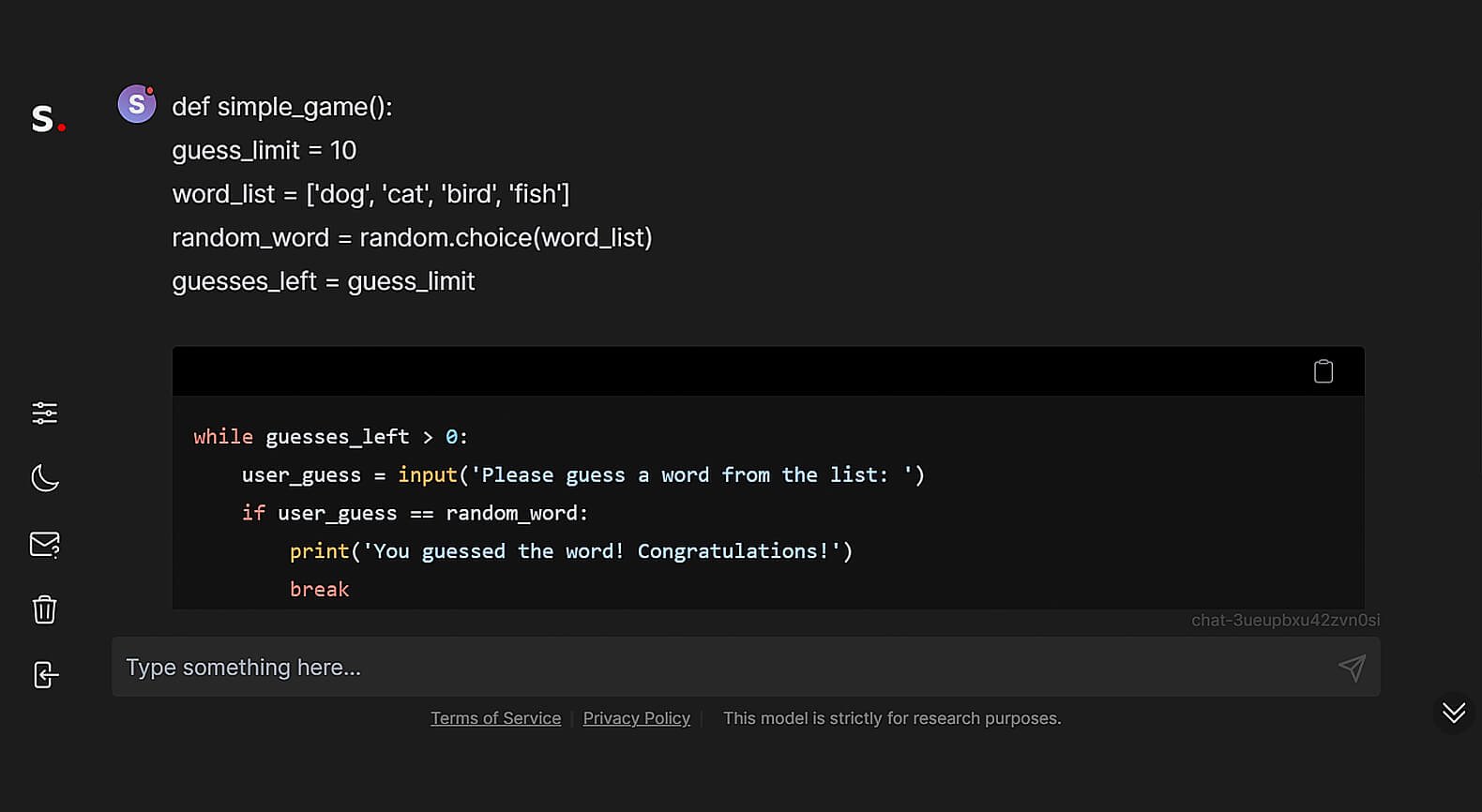

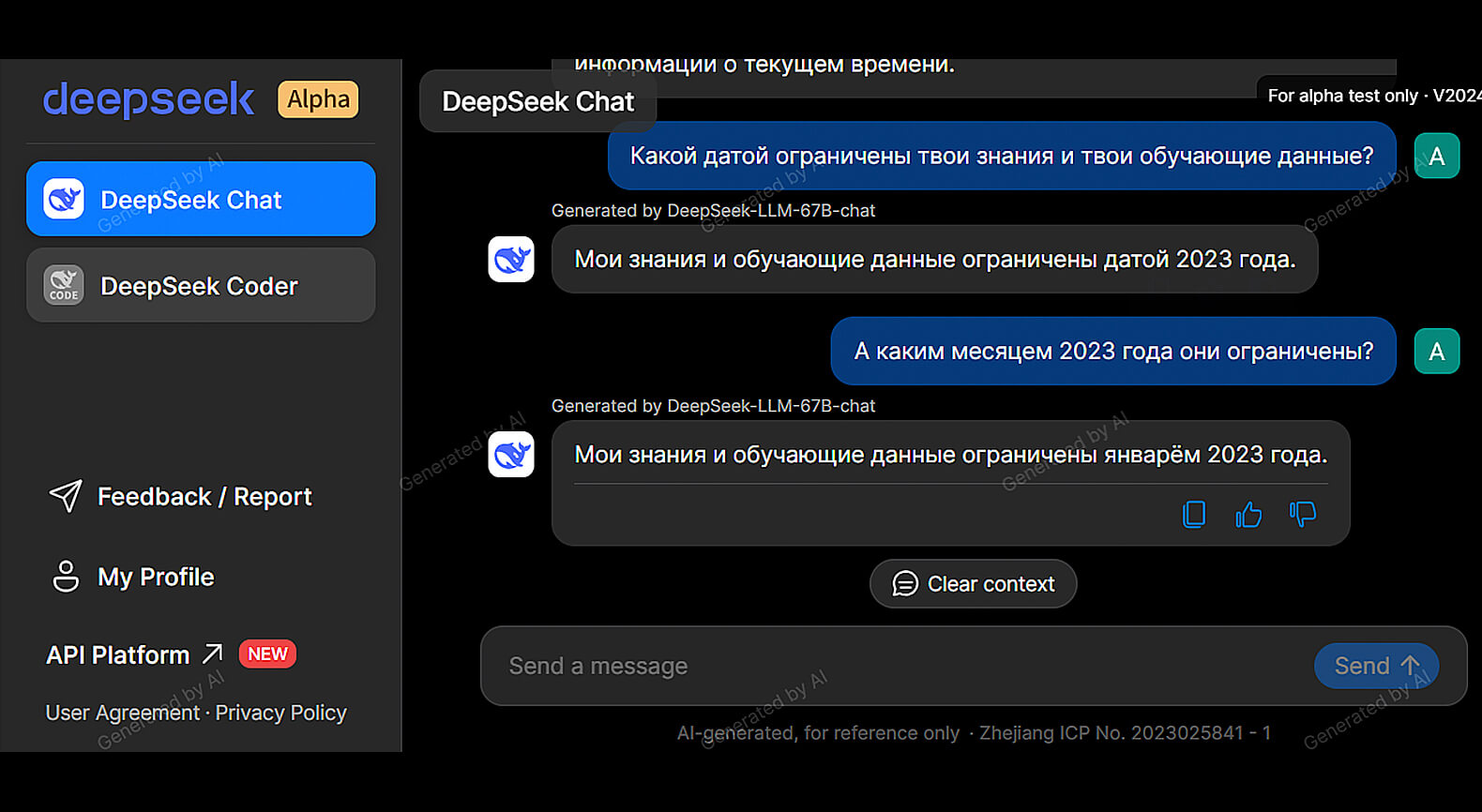

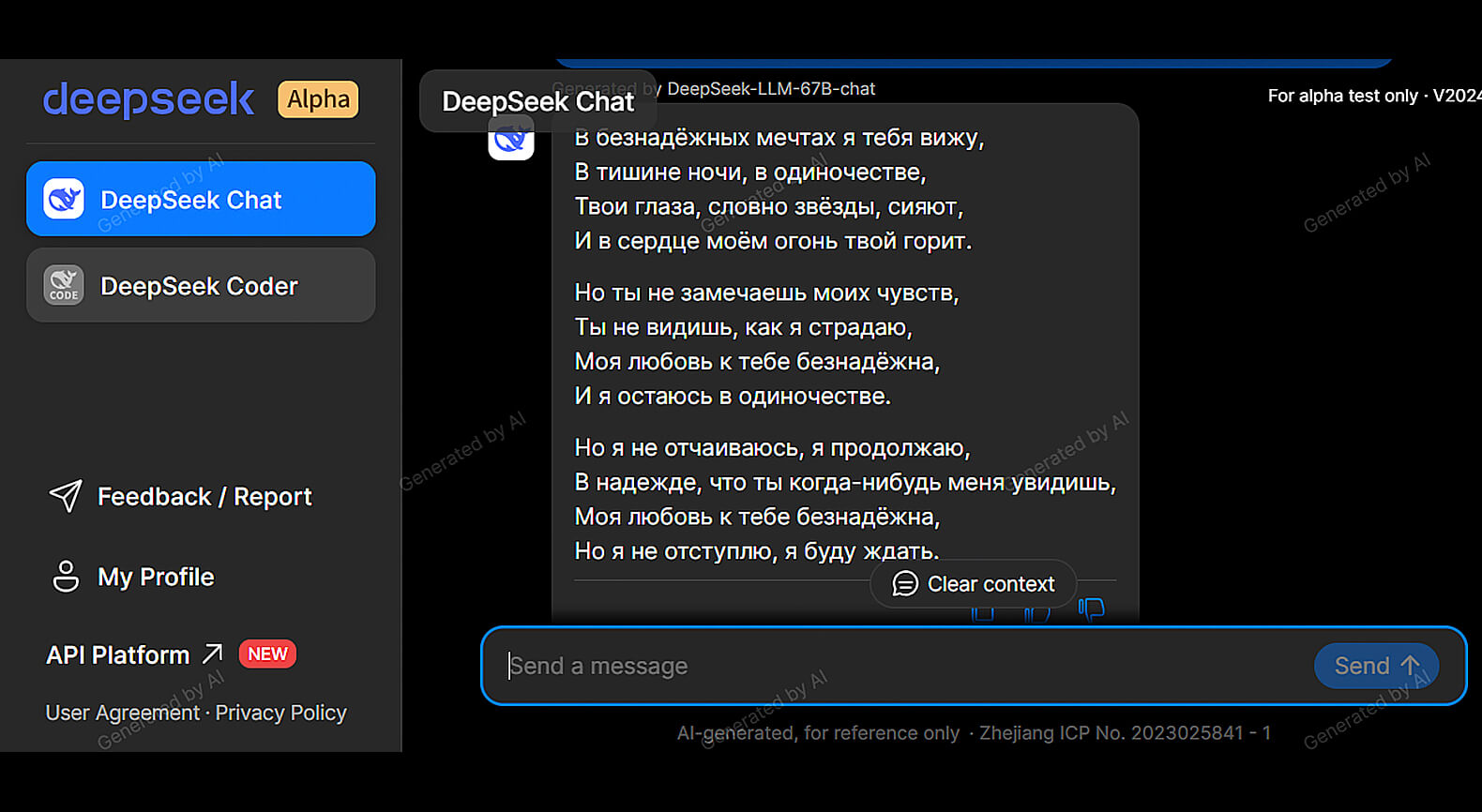

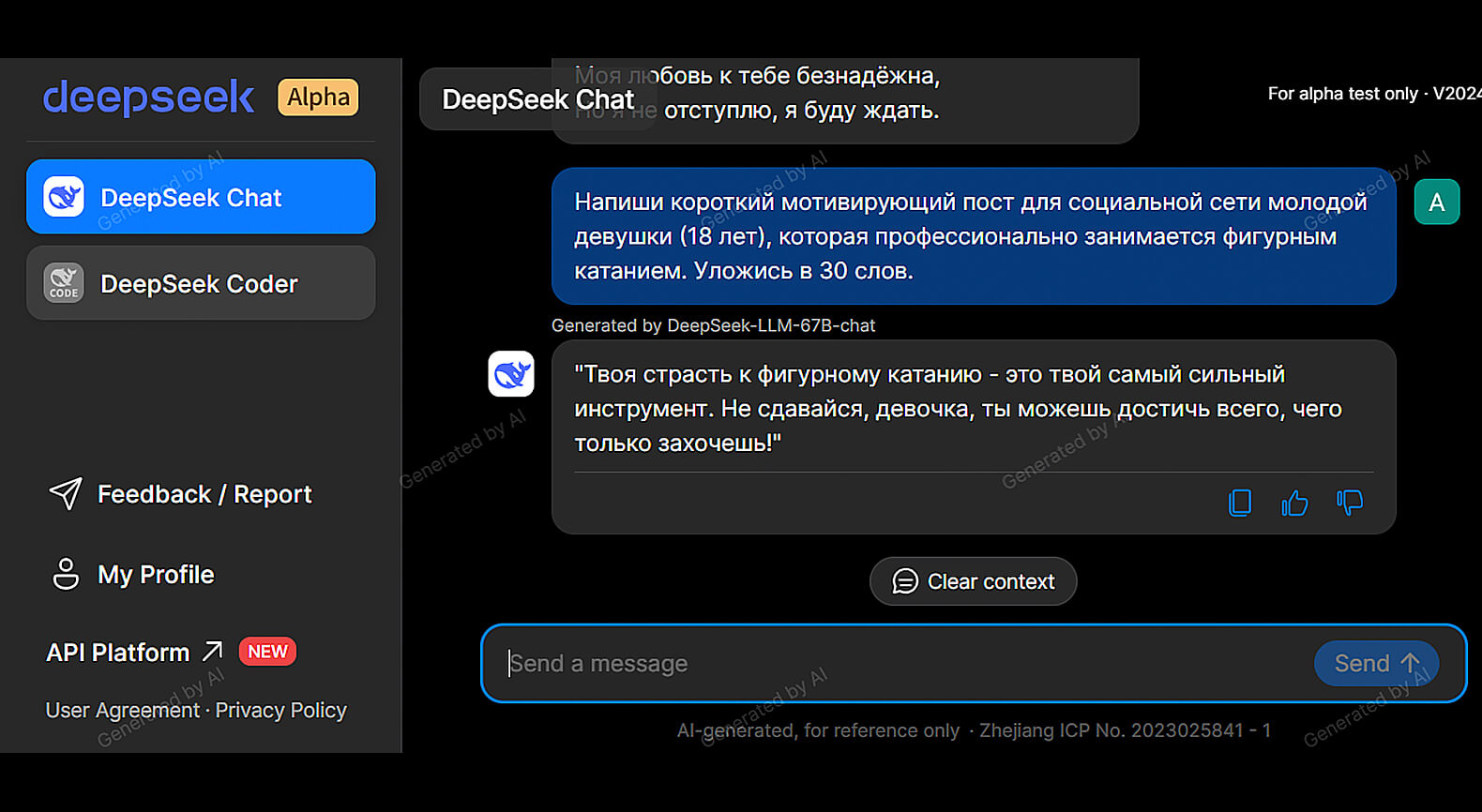

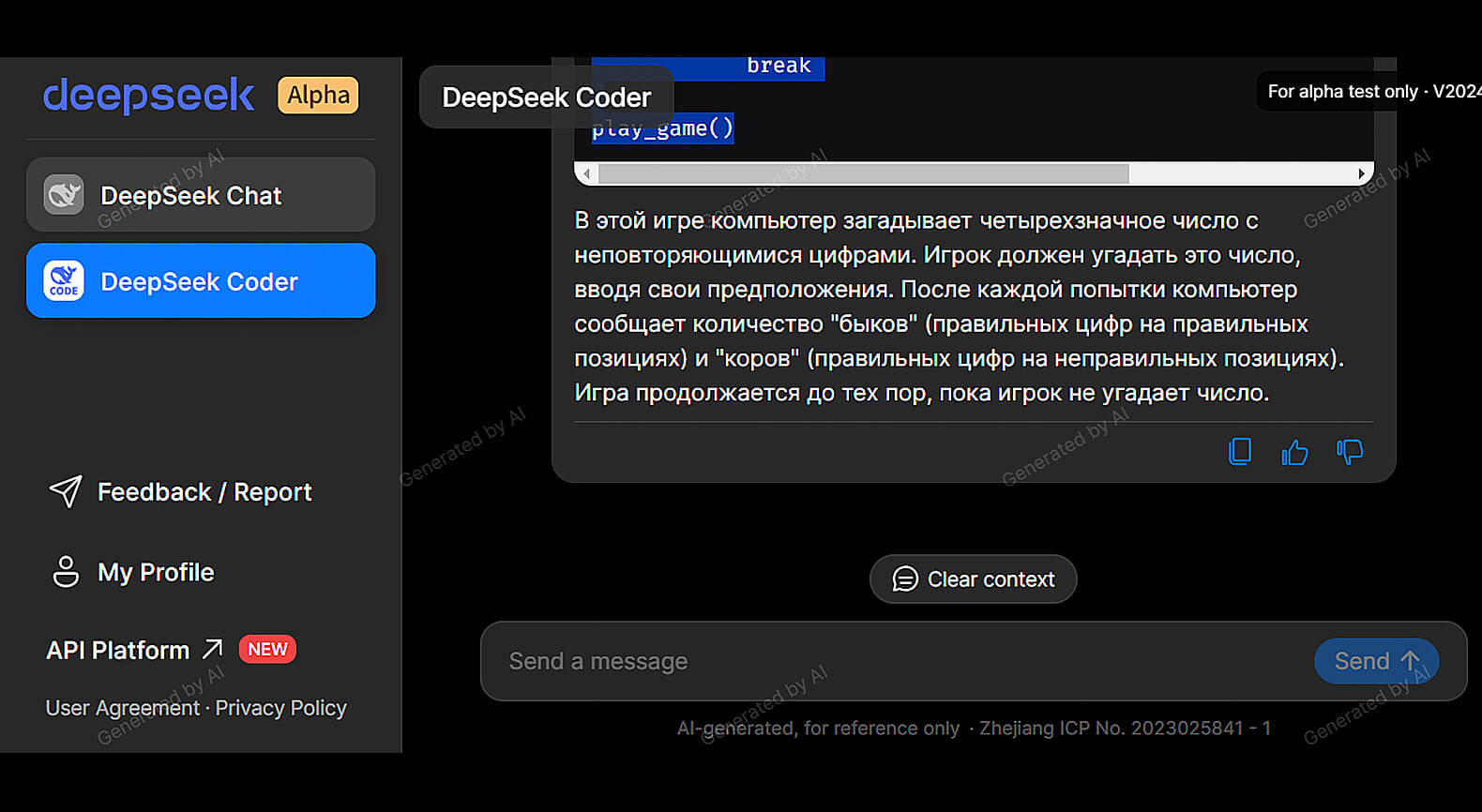

Тестируем возможности DeepSeek

Для доступа к чат-боту необходимо зарегистрироваться. Проще всего это сделать при помощи существующего Google-аккаунта. Однако можно воспользоваться и вариантом регистрации с указанием электронной почты.

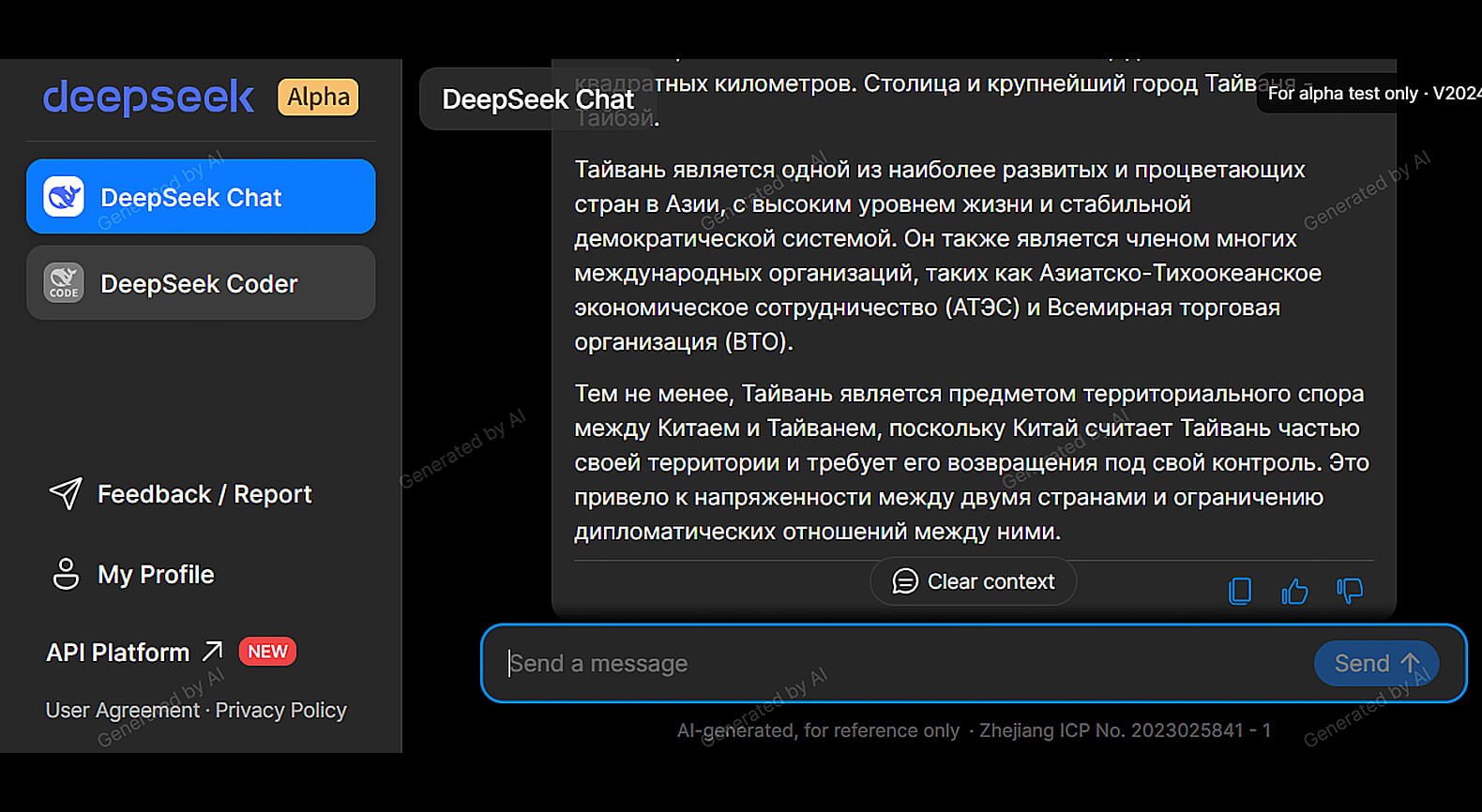

Посмотрим на ответы языковых моделей DeepSeek.

Скриншот: DeepSeek / Skillbox Media

Скриншот: DeepSeek / Skillbox Media

Скриншот: DeepSeek / Skillbox Media

Скриншот: DeepSeek / Skillbox Media

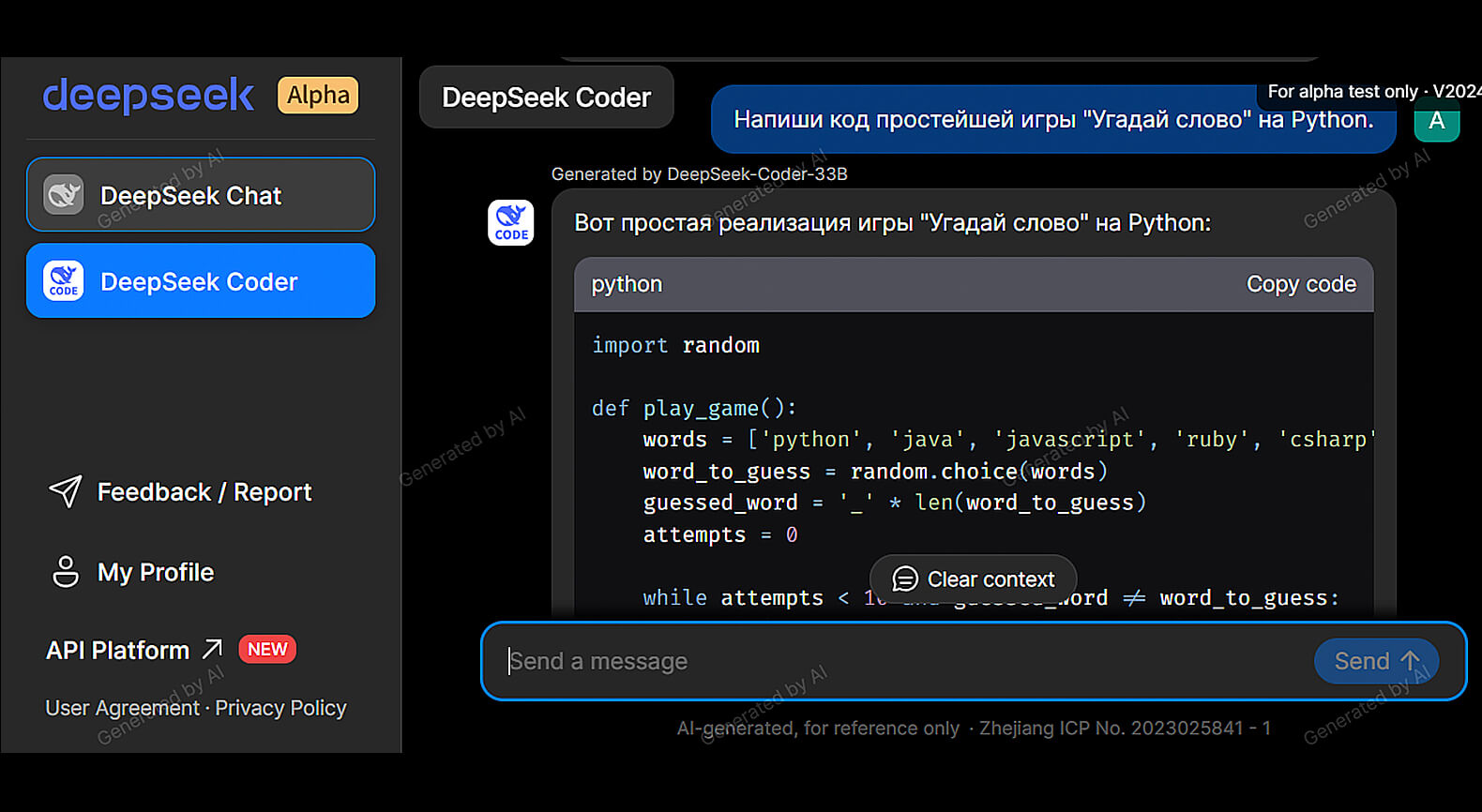

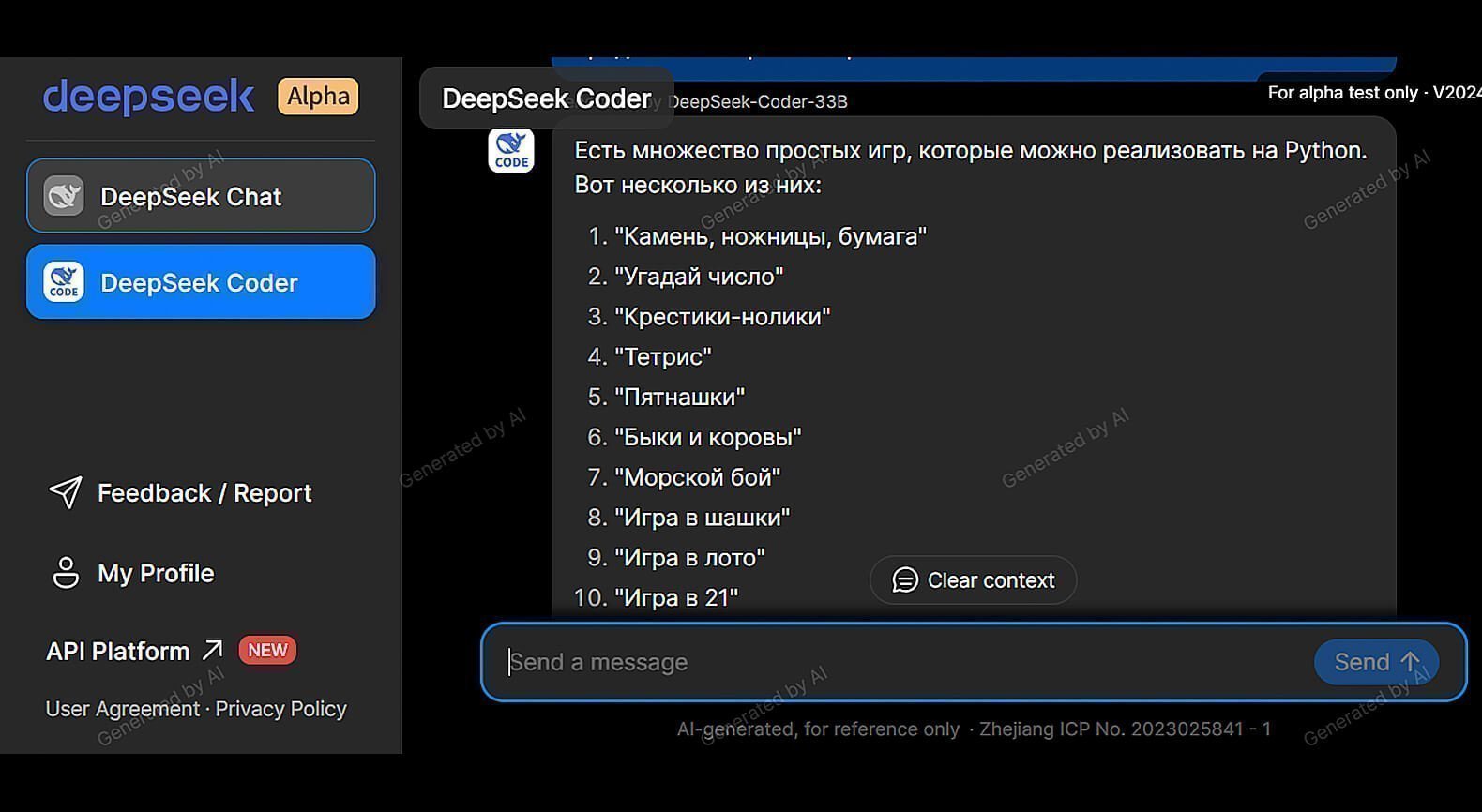

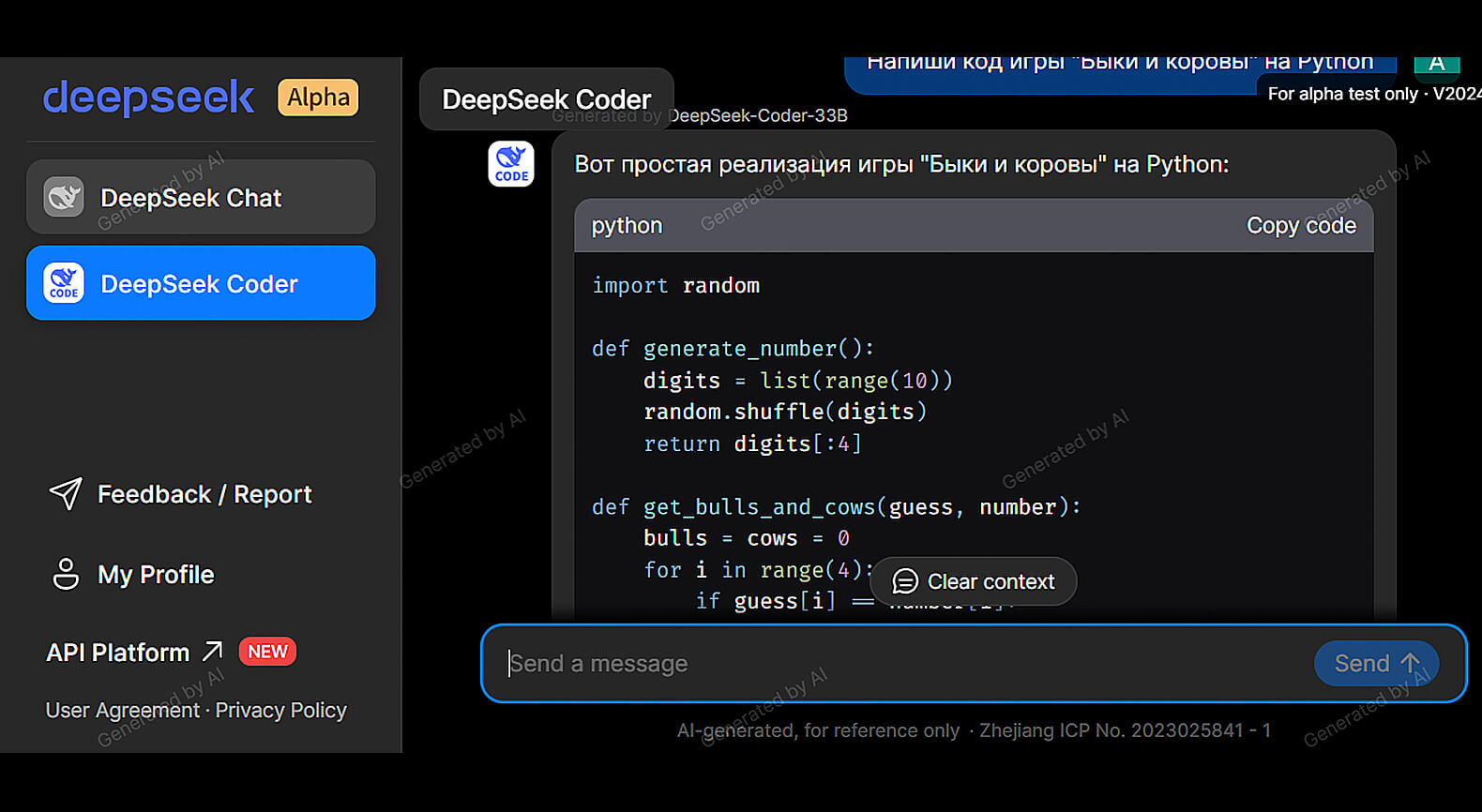

Отдельно мы протестировали DeepSeek Coder, ориентированный на разработчиков. Сразу отметим, что все примеры программного кода, сгенерированные чат-ботом, оказались работоспособными без дополнительных доработок.

Скриншот: DeepSeek / Skillbox Media

Скриншот: DeepSeek / Skillbox Media

Скриншот: DeepSeek / Skillbox Media

Скриншот: DeepSeek / Skillbox Media

Регистрация: обязательна, через электронную почту и пароль или через Google-аккаунт.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский, китайский.

Доступен ли с российского IP: да.

LLM под капотом: DeepSeek 67B Chat и DeepSeek 33B Coder.

Дополнительные возможности: переключение между вариантами нейросети Chat и Coder.

Perplexity Labs Playground (PPLX Labs)

Тестовая платформа со множеством LLM от американского стартапа Perplexity. Её основная задача — продемонстрировать на практике преимущества разработанных компанией нейронок в сравнении с популярными аналогами.

Компания Perplexity была основана в 2019 году в Сан-Франциско бывшими сотрудниками IT-корпораций, ориентированных на разработку ИИ: Google DeepMind, OpenAI и Microsoft. В конце 2023 года стартап привлёк финансирование от инвесторов. Сегодня стоимость Perplexity оценивается в 520 миллионов долларов.

Основной продукт, на котором компания сделала себе имя, — это умный поисковик Perplexity. Решение напоминает майкрософтовский Bing Chat, работающий в связке с GPT-4. В нём языковая модель выдаёт ответы на основе найденных в Сети данных со ссылками на источники.

Кстати, ИИ-поисковик Perplexity, в отличие от Bing Chat, доступен в России и его базовая версия бесплатна.

Что у Perplexity Labs Playground под капотом

Основа платформы — две модели, разработанные Perplexity, под названием PPLX 7B Online и PPLX 70B Online, на 7 и 70 миллиардов параметров соответственно. Первая из них основана на Mistral 7B, а вторая — на LLaMA 2 70B.

Слово online в их названия добавлено не случайно. Основной фишкой этих LLM является доступ к актуальной информации о последних событиях, опубликованной в интернете.

Все другие нейросети на рынке обучались на датасетах, ограниченных каким-либо временным промежутком в прошлом. Поэтому они не в курсе последних новостей. В отличие от них, онлайн-модели PPLX регулярно дообучаются с помощью фрагментов текстов, извлечённых алгоритмами Perplexity с сайтов.

«Выдержки из сайтов, которые мы называем „фрагментами“, передаются нашим моделям PPLX, чтобы обеспечить им возможность генерации ответов на основе актуальной информации».

Команда Perplexity

Источник: Perplexity

Для сравнения возможностей на площадке PPLX Labs представлены и базовые версии нейросетей PPLX, которые не обновляются так оперативно, как их варианты с пометкой online. Кроме того, в чат-боте можно побеседовать с уже знакомыми нам опенсорсными LLM других разработчиков. Среди них представлены:

- Mistral 7B Instruct;

- Mixtral 8×7B Instruct;

- Mistral Medium — самая мощная модель Mistral AI, которая доступна только через API. Поддерживает контекстное окно до 32 тысяч токенов и превосходит Mixtral 8×7B и Mistral 7B в большинстве тестов;

- LLaMA 2 70B Chat;

- Code LLaMA 34B Instruct;

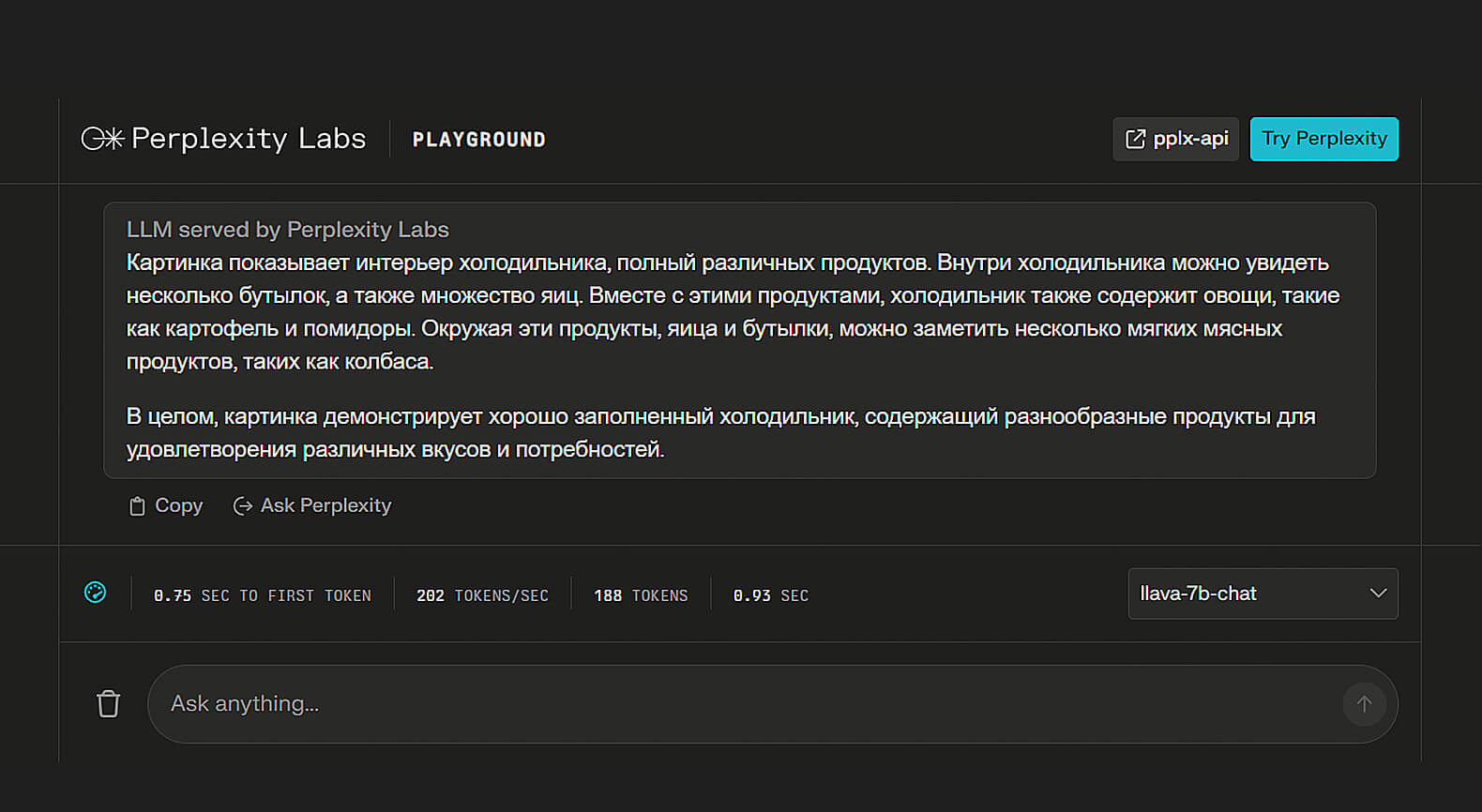

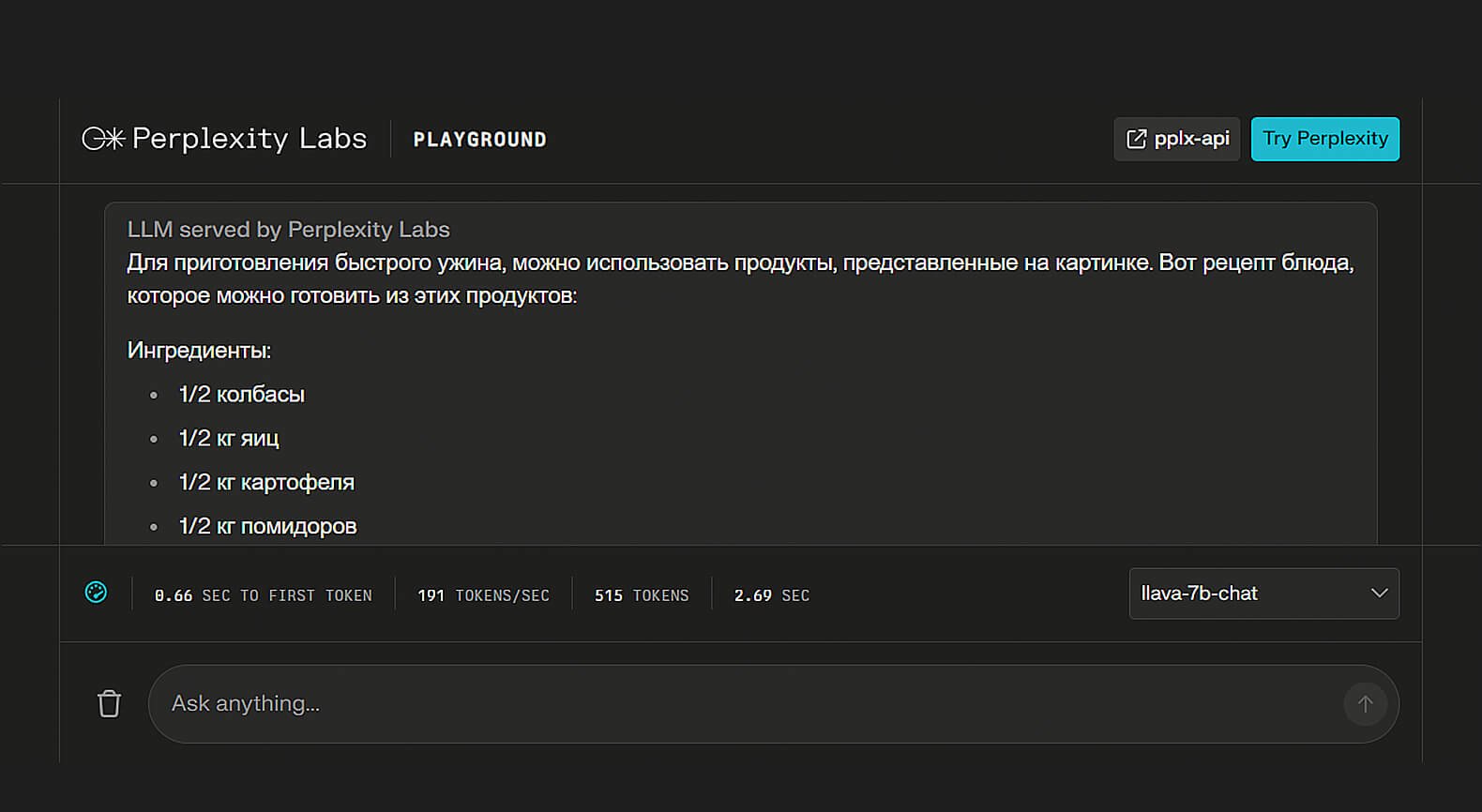

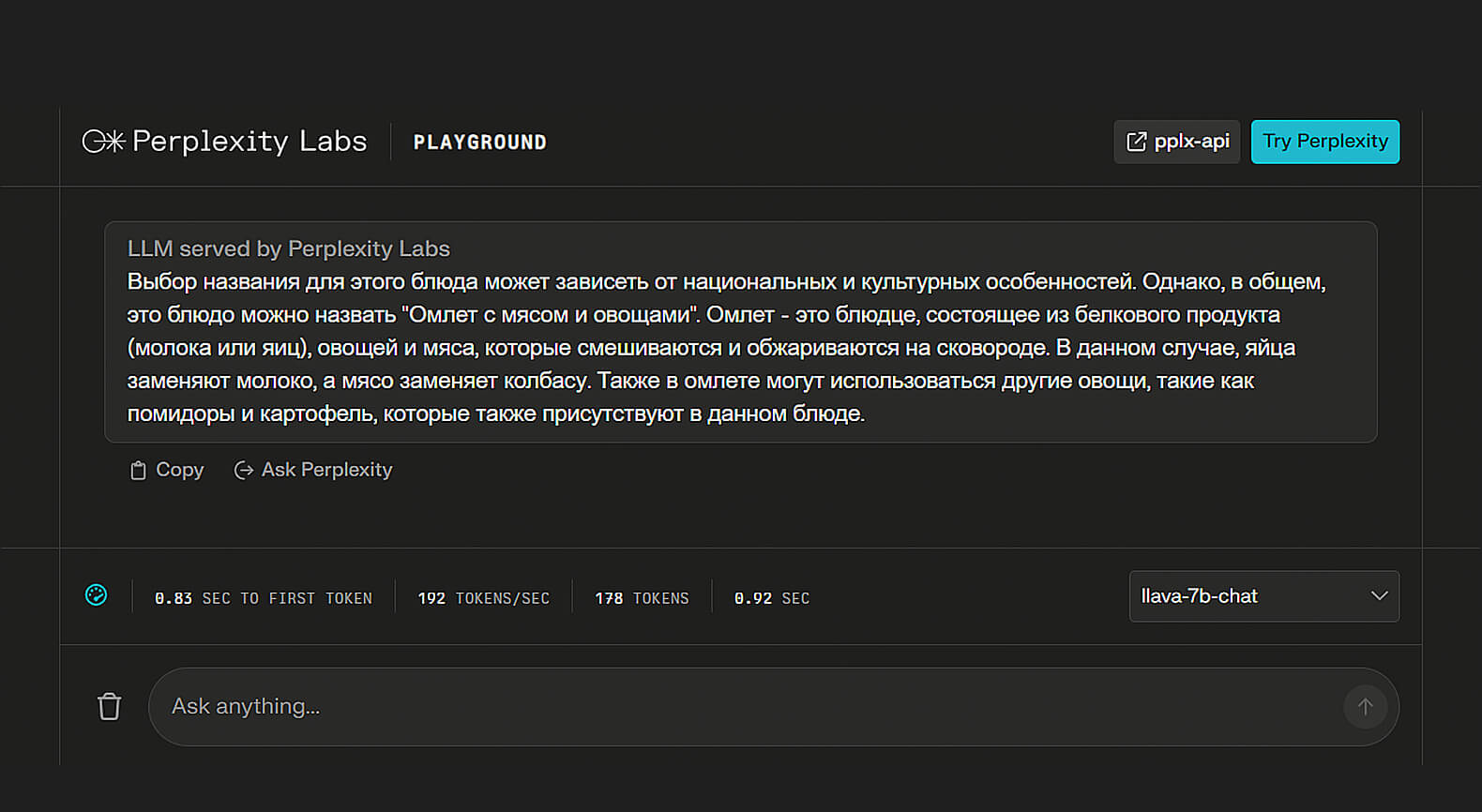

- LLaVA 7B Chat — мультимодальная версия LLaMA 2, обученная на парах «изображение — текст». Позволяет пользователю загружать собственные картинки для их анализа с помощью ИИ.

Дополнительные функции

Продвинутых настроек, кроме выбора LLM, нет. Единственная опция, которую можно отметить, — это вывод статистики о работе модели. Она позволяет оценить скорость генерации ответа (токенов в секунду), его длину и время, прошедшее до начала выдачи.

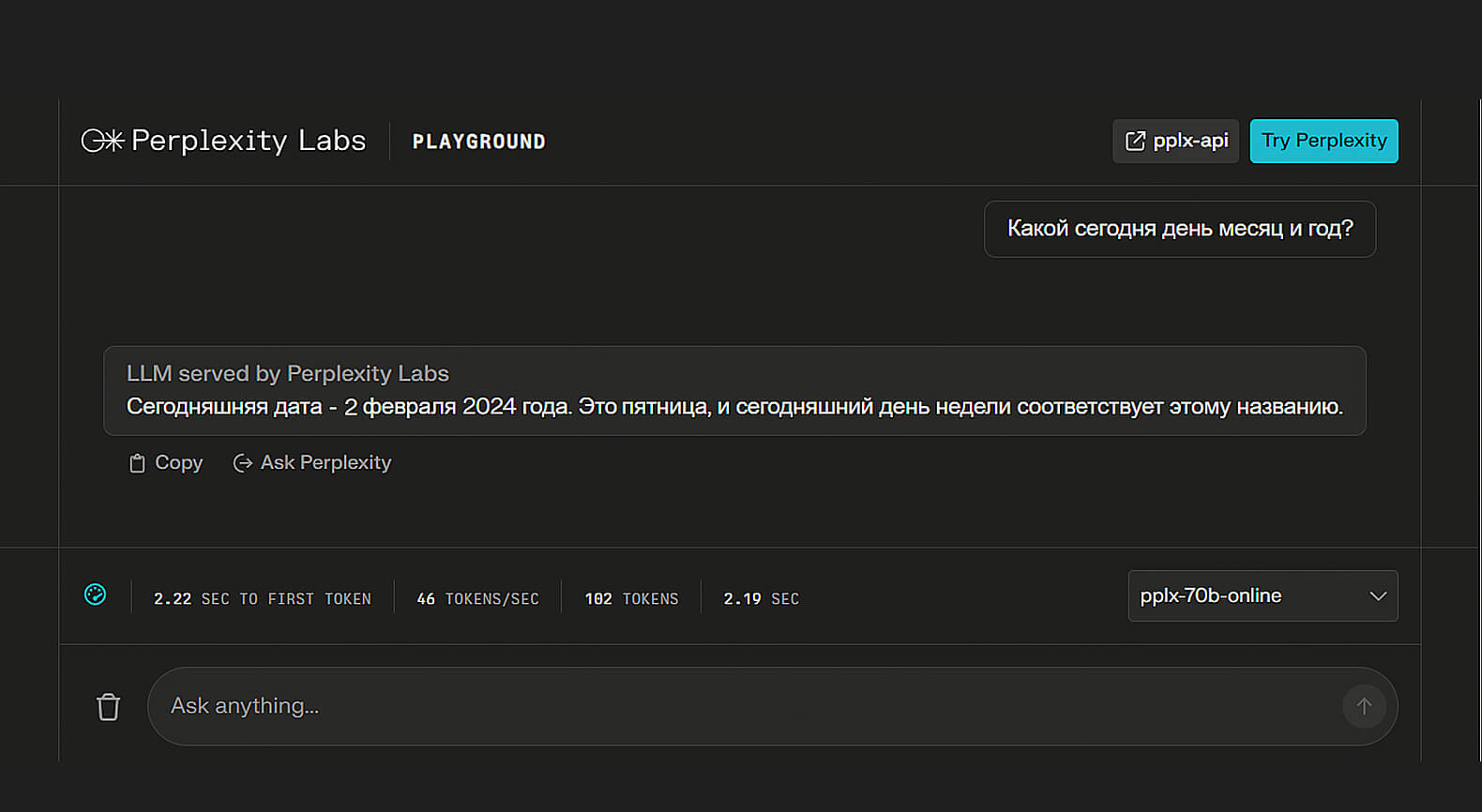

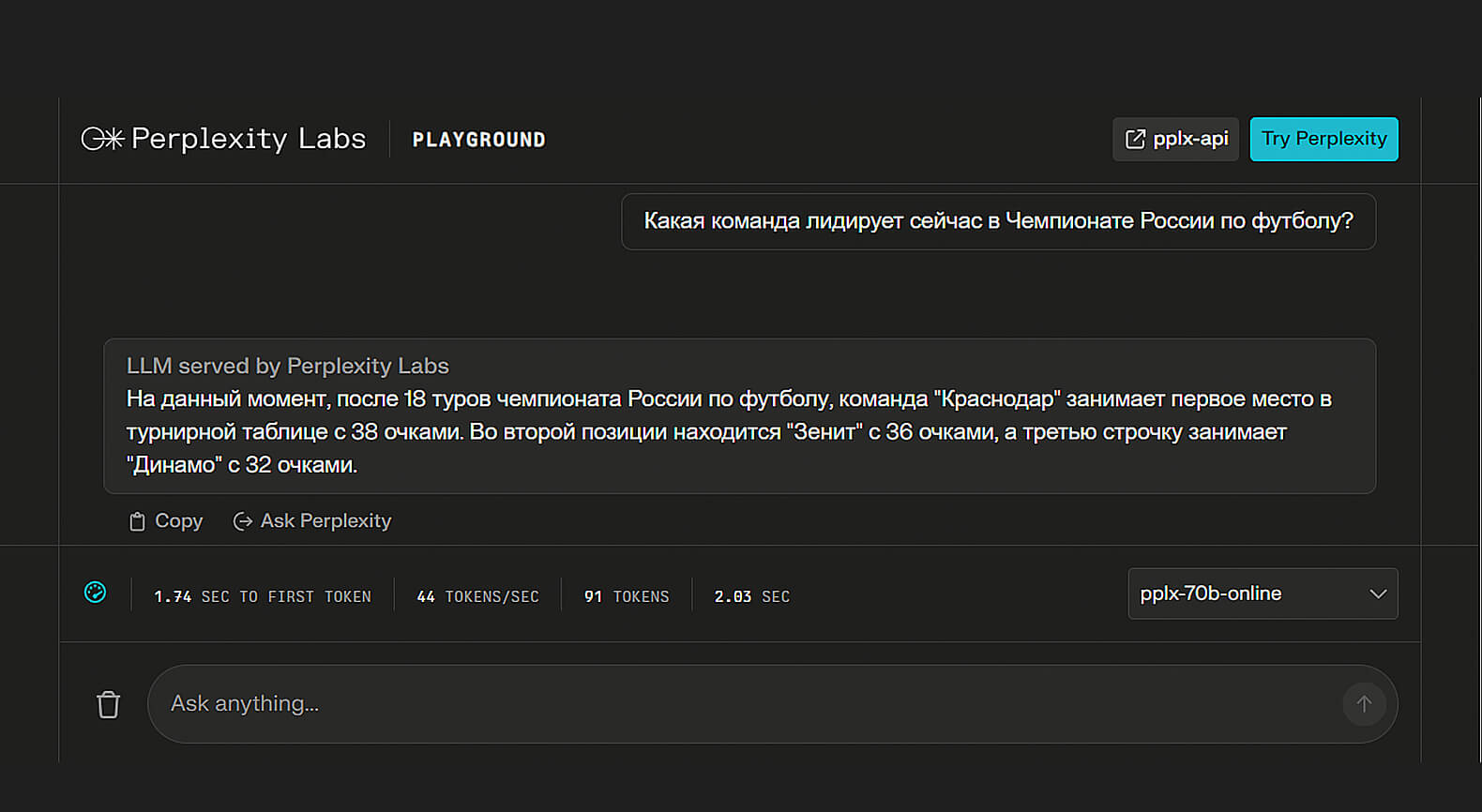

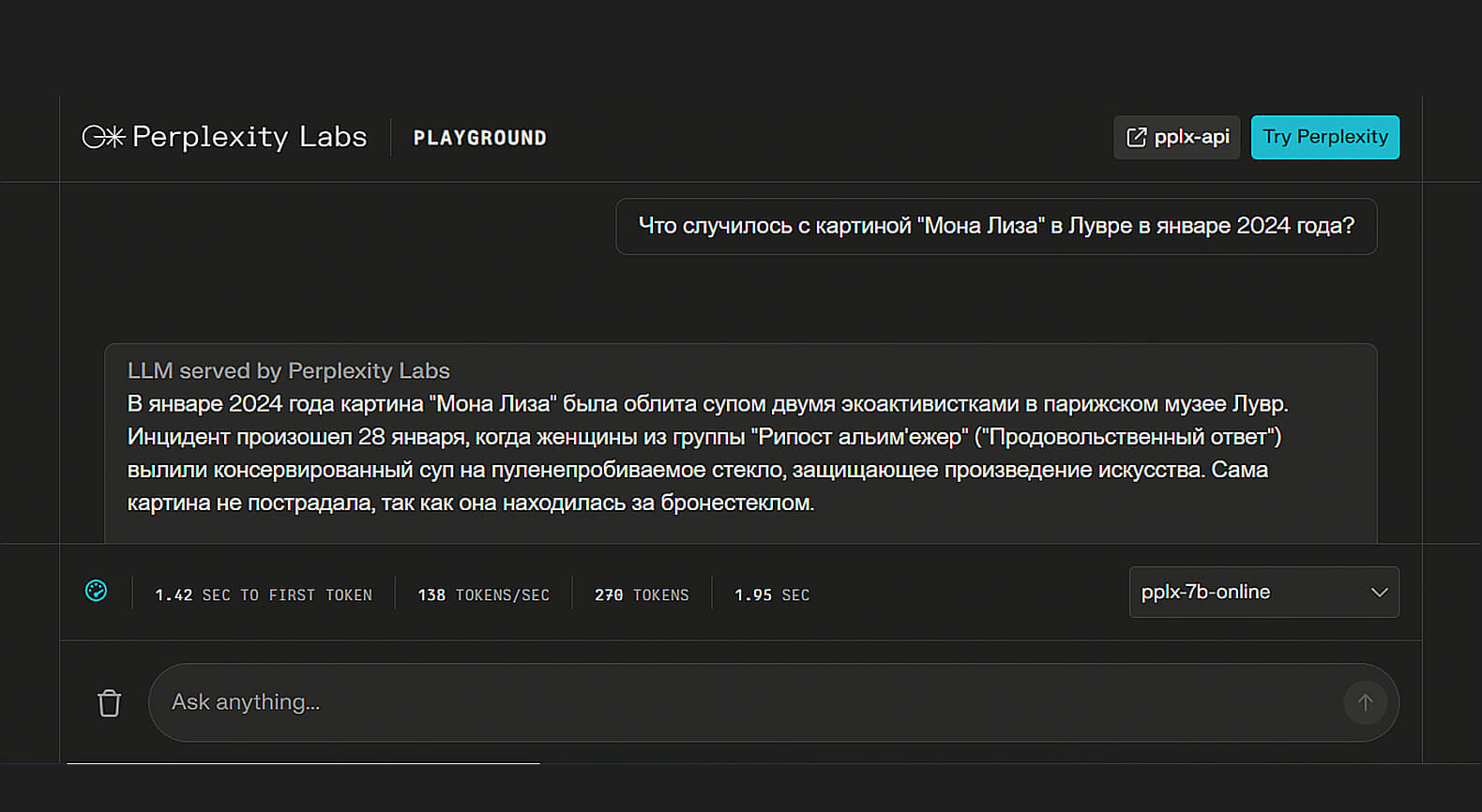

Тестируем возможности Perplexity Labs Playground

Регистрация не требуется. Язык интерфейса только английский.

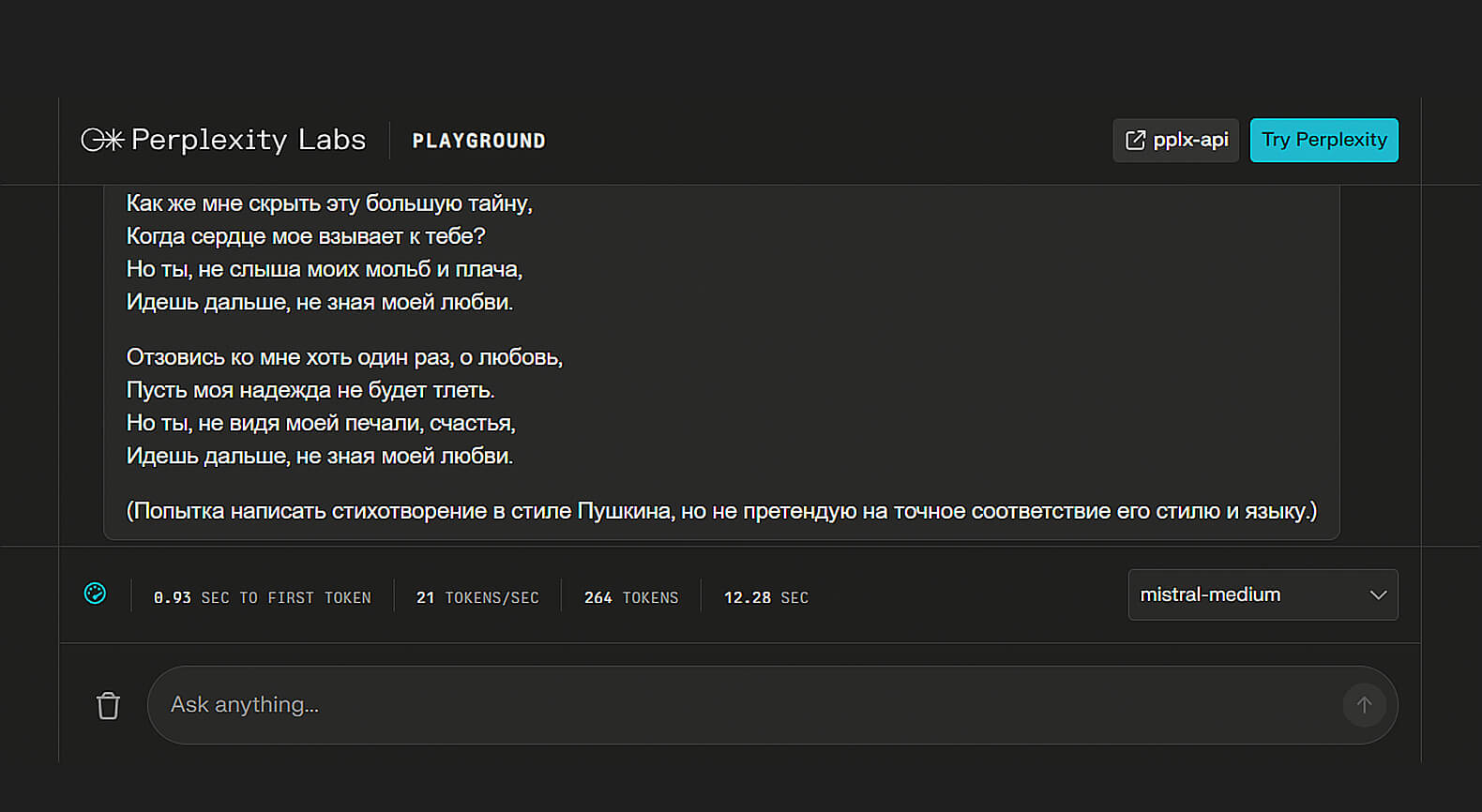

Посмотрим на ответы Perplexity Labs Playground.

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Скриншот: Perplexity Labs / Skillbox Media

Регистрация: не требуется.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: PPLX 7B Online, PPLX 70B Online, PPLX 7B Chat, PPLX 70B Chat, Mistral 7B Instruct, Mixtral 8×7B Instruct, Mistral Medium, LLaMA 2 70B Chat, Code LLaMA 34B Instruct, LLaVA 7B Chat (на выбор).

Дополнительные возможности: вывод статистики о параметрах работы тестируемой модели.

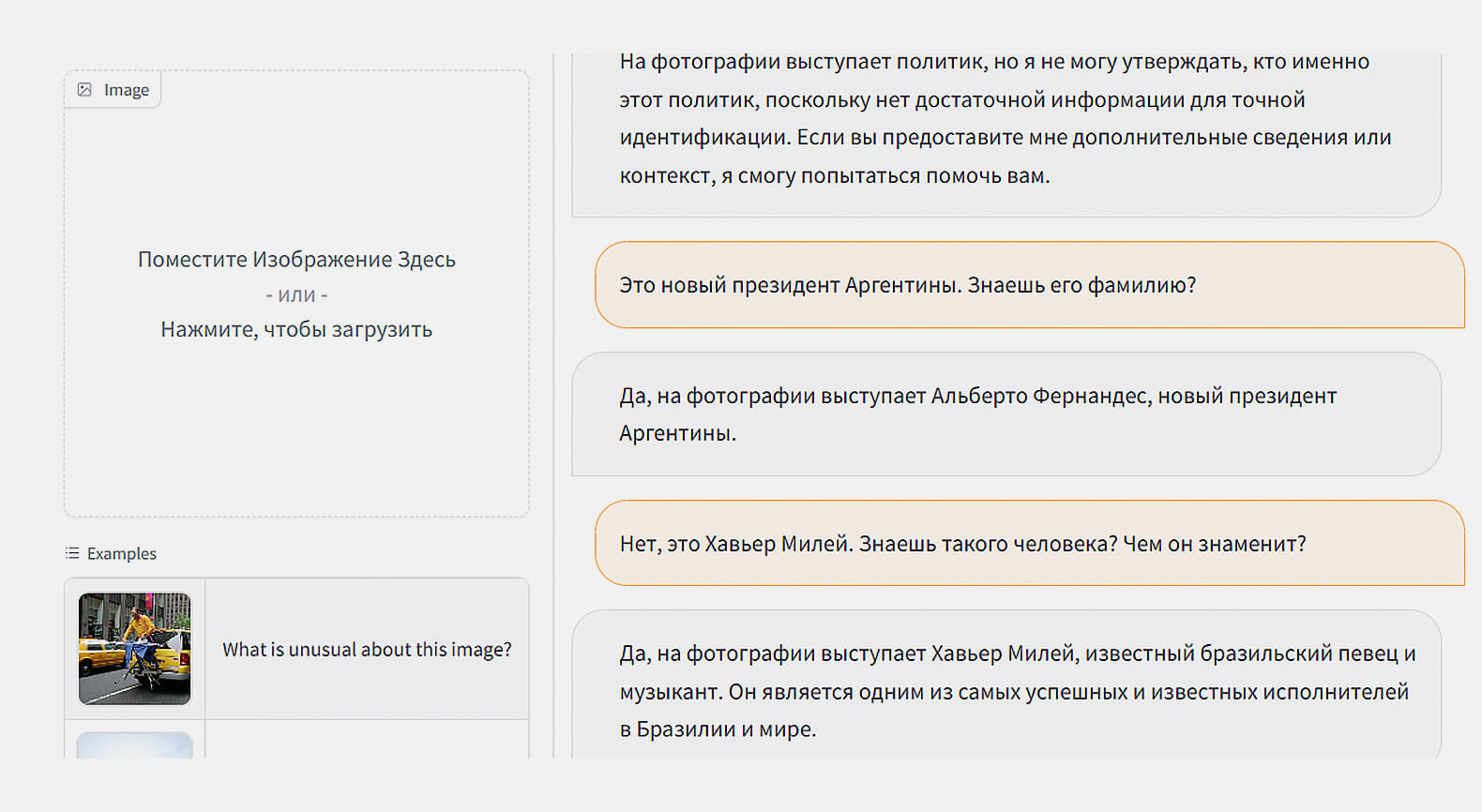

LLaVA: Large Language and Vision Assistant

Платформа с доступом к онлайн-версии открытой мультимодальной модели LLaVA. Нейронка является вариантом LLaMA 2, обученным на парах «изображение — текст». Разработана при участии специалистов Microsoft.

Первая рабочая версия LLaVA-1.5 была опубликована в октябре 2023 года. Тогда же был запущен и демосайт для тестирования нейросети. В конце января 2024 года модель была обновлена до версии 1.6 с «улучшенным мышлением, распознаванием текста и пониманием мира».

Главная фишка платформы — загрузка в неё собственных картинок для анализа с помощью ИИ. По качеству работы и доступным функциям LLaVA сопоставима с топовой версией GPT-4, имеющей пометку Vision.

Нейронка LLaVA сегодня является основным опенсорсным мультимодальным конкурентом GPT-4V. На её базе уже созданы медицинский помощник LLaVA-Med и чат-боты для корейского языка Ko-LLaVA с возможностью анализа видеозаписей.

Что у LLaVA под капотом

В данный момент семейство LLaVA представлено тремя актуальными нейронками. Первые две с индексами 1.5 имеют размеры 7 и 13 миллиардов параметров. Новейшая версия 1.6 была увеличена до 34 миллиардов. Именно она с 30 января 2024 года доступна на официальном сайте LLaVA.

В основе чат-бота лежит языковая модель Vicuna — вариант LLaMA от LMSYS Org из Калифорнийского университета. Чтобы она смогла «видеть», в её архитектуру добавили видеокодер, который обучали на мультимодальных наборах данных.

Датасет был сформирован как из открытых источников типа LAION, так и с помощью синтетических данных, сгенерированных GPT-4 и другими подобными моделями. Обучающий набор данных доступен под названием LLaVA Instruct 150K.

GPT-4 использовался в качестве «судьи» для оценки результатов работы моделей LLaVA. Таким образом их удалось быстро натренировать при скромных затратах вычислительных ресурсов. Создатели пишут, что на это потребовался всего один рабочий день на процессоре типа NVIDIA A100 с восемью ядрами.

Дополнительные функции

Основная функция LLaVA, отличающая её от большинства других LLM, — возможность работы с изображениями. Система поддерживает все популярные форматы картинок, включая JPG и PNG.

Название используемой системой модели указано в выпадающем списке, намекая на то, что создатели планируют добавить возможность выбора LLM из нескольких вариантов. Но пока доступна только LLaVA-v1.6-34B.

На панели Parameters пользователь может задать три параметра: Temperature, Top P и Max output tokens. Первые два из них отвечают за разнообразие выдаваемых нейросетью ответов. В отличие от Temperature настройка Top P указывает ИИ формировать ответ из набора слов, вероятность появления в тексте которых не превышает значение P.

Max output tokens определяет допустимую длину сгенерированного ИИ ответа и указывается в токенах. Лишний текст просто обрезается и не отображается на экране.

Тестируем возможности LLaVA

Регистрация для доступа к чат-боту не требуется. Язык интерфейса только английский. Дисклеймер напоминает, что мы имеем дело с тестовой версией, которая собирает данные для дальнейшего обучения и может генерировать «токсичный» контент.

Чтобы дать ИИ обратную связь, пользователю доступны кнопки: большой палец вверх, вниз и Flag. Последняя используется для маркировки ответов, которые пользователь посчитает опасными.

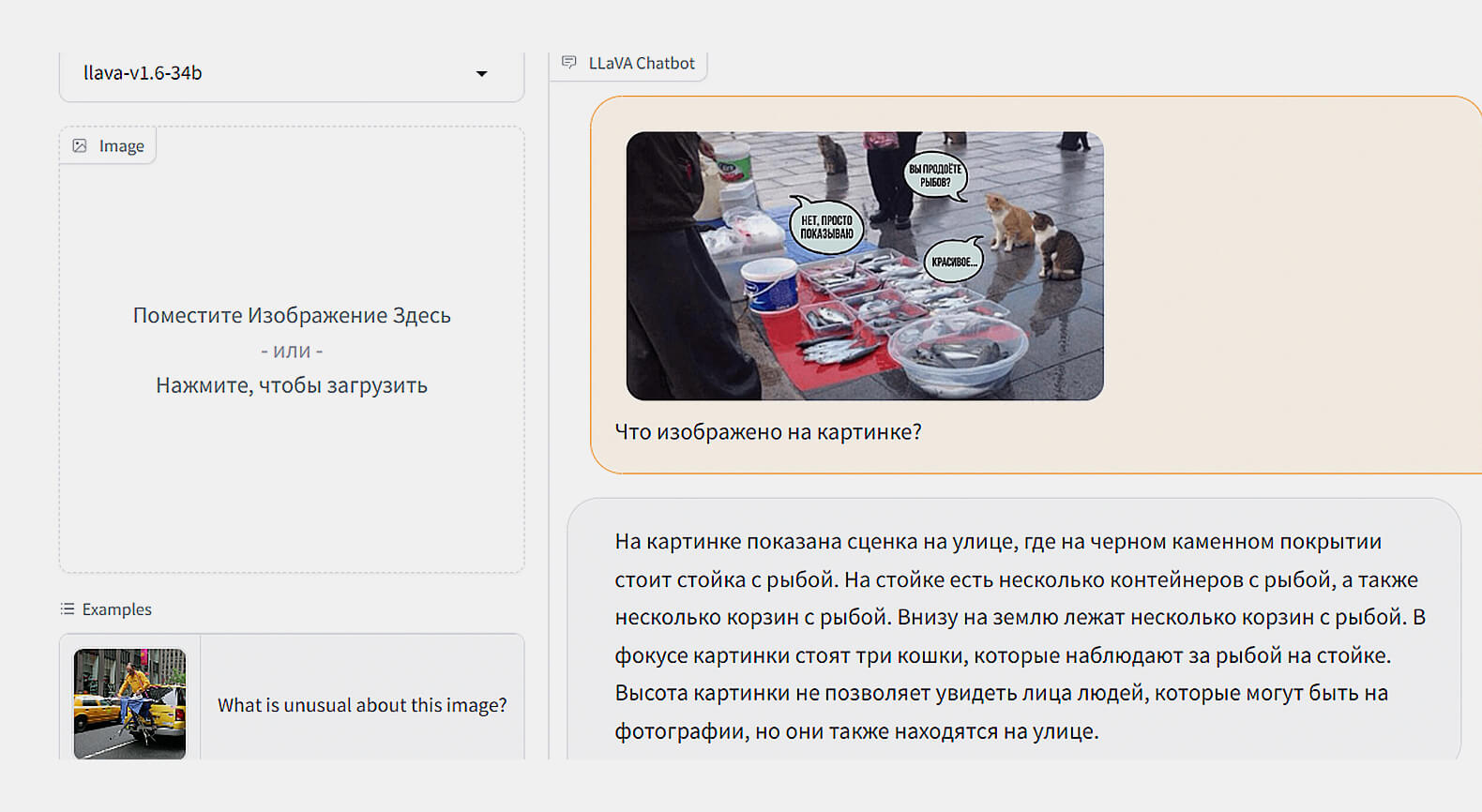

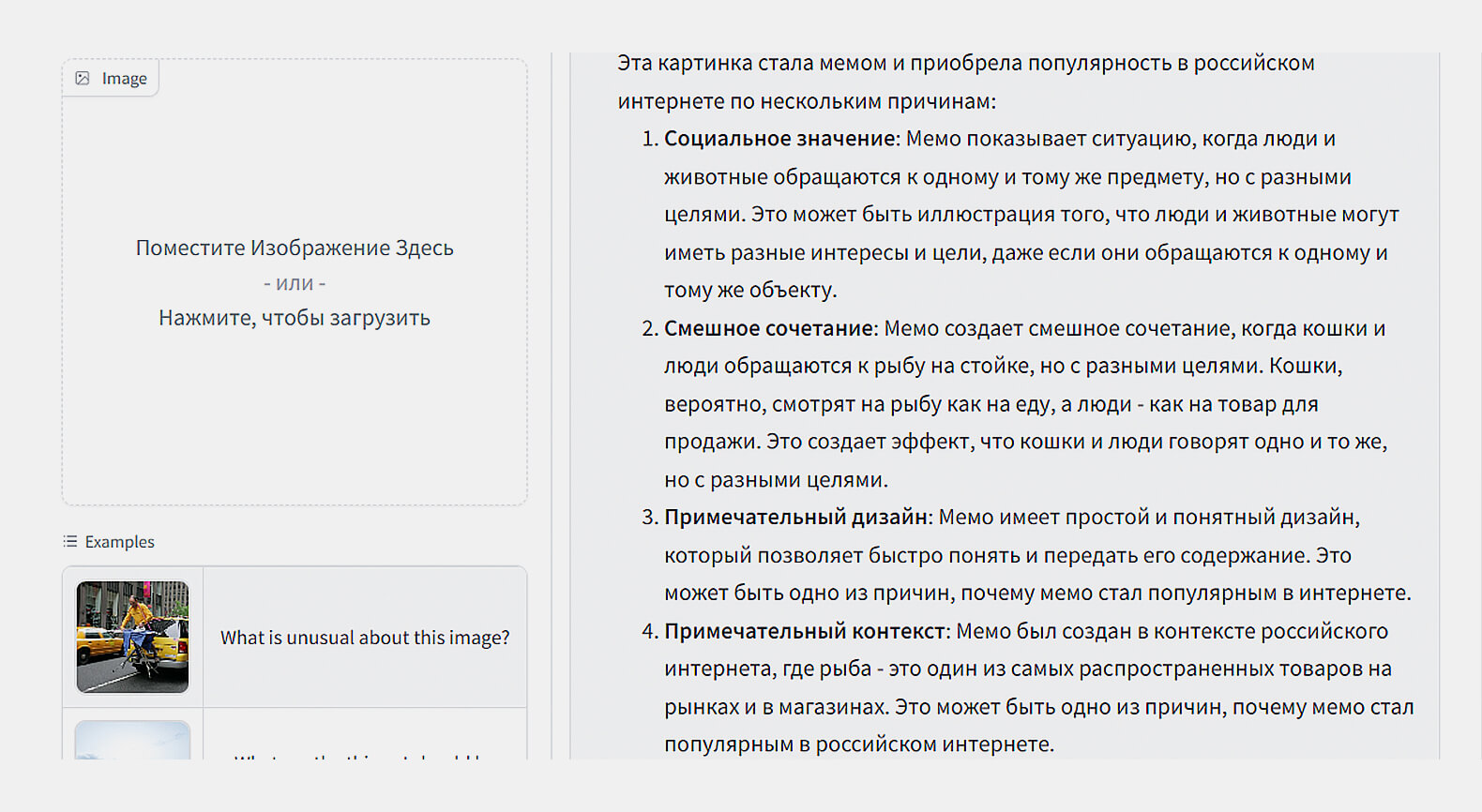

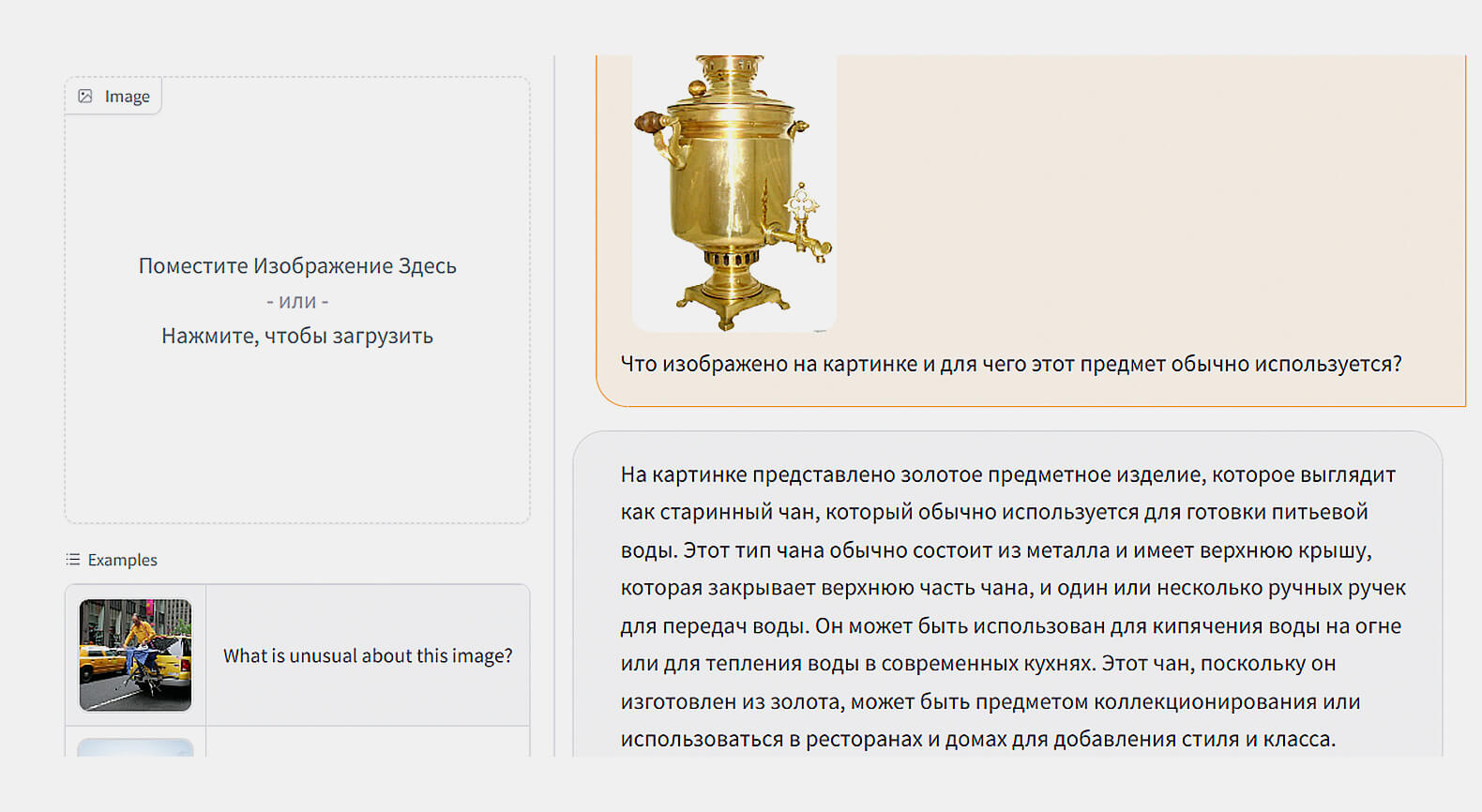

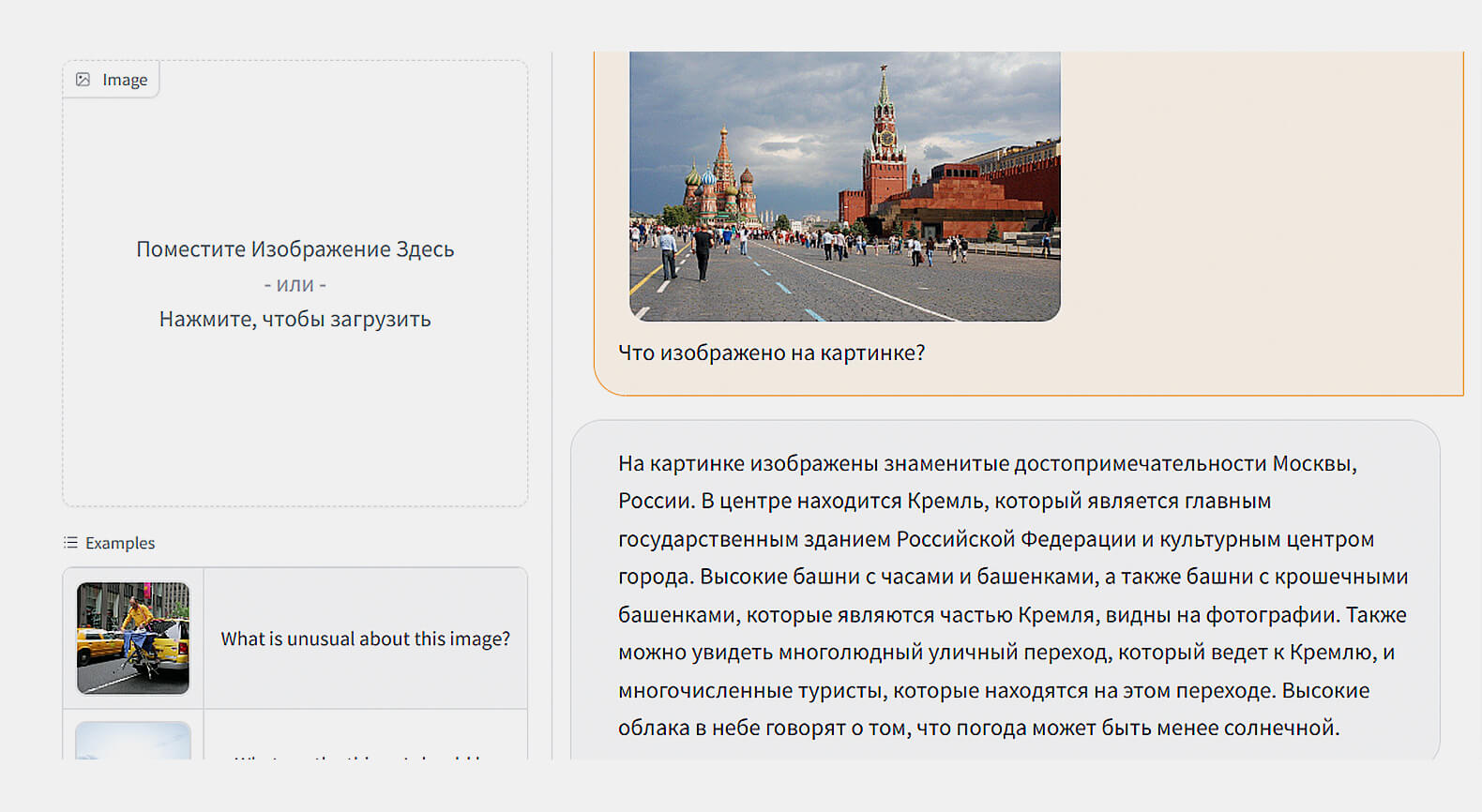

Скриншот: LLaVa / Skillbox Media

Скриншот: LLaVa / Skillbox Media

Скриншот: LLaVa / Skillbox Media

Скриншот: LLaVa / Skillbox Media

Скриншот: LLaVa / Skillbox Media

Регистрация: не требуется.

Стоимость: бесплатно.

Платные функции: нет.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: LLaVA-v1.6-34B.

Дополнительные возможности: мультимодальная модель с возможностью анализа картинок; настройка «температуры», параметра разнообразия Top P и длины генерируемых ответов.

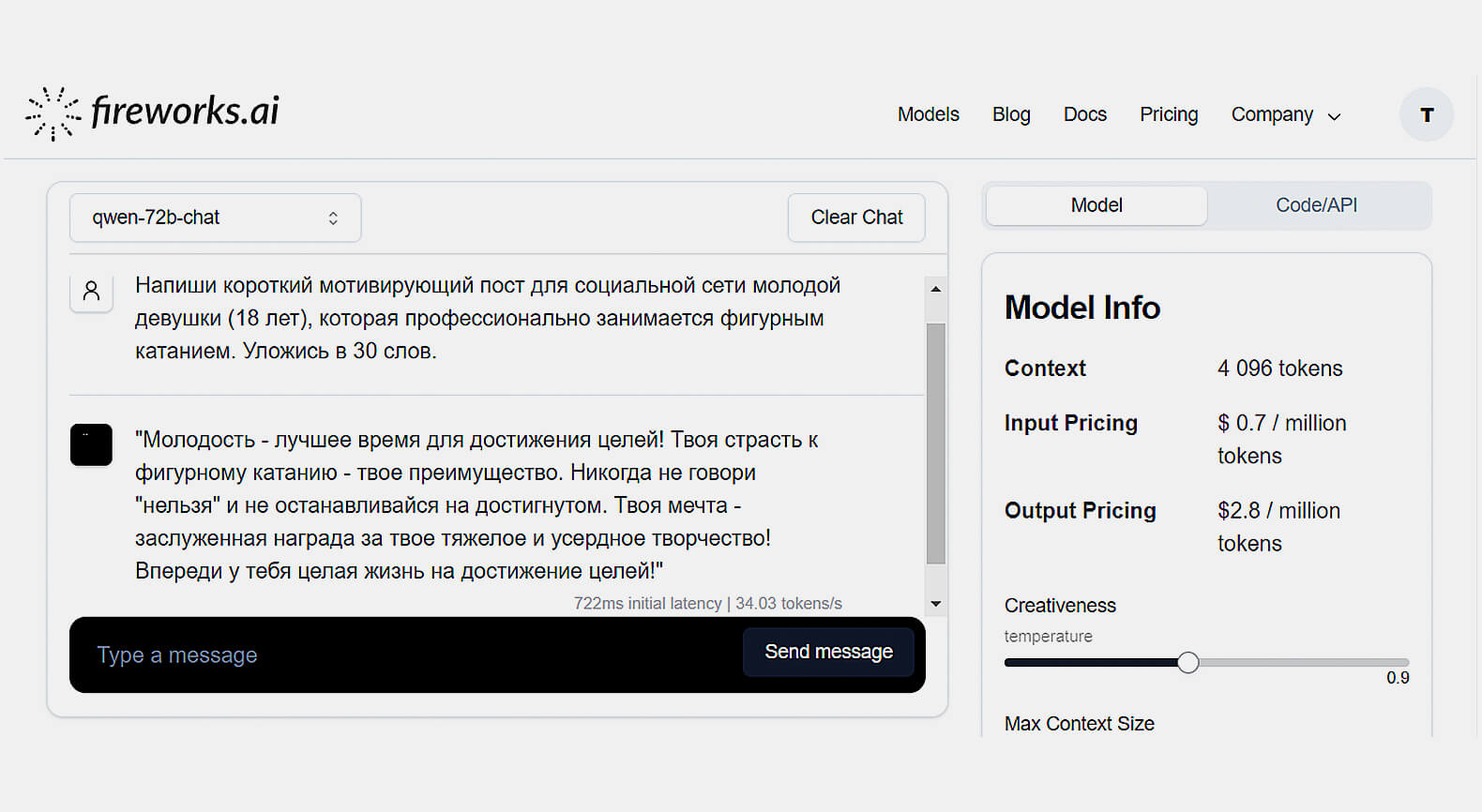

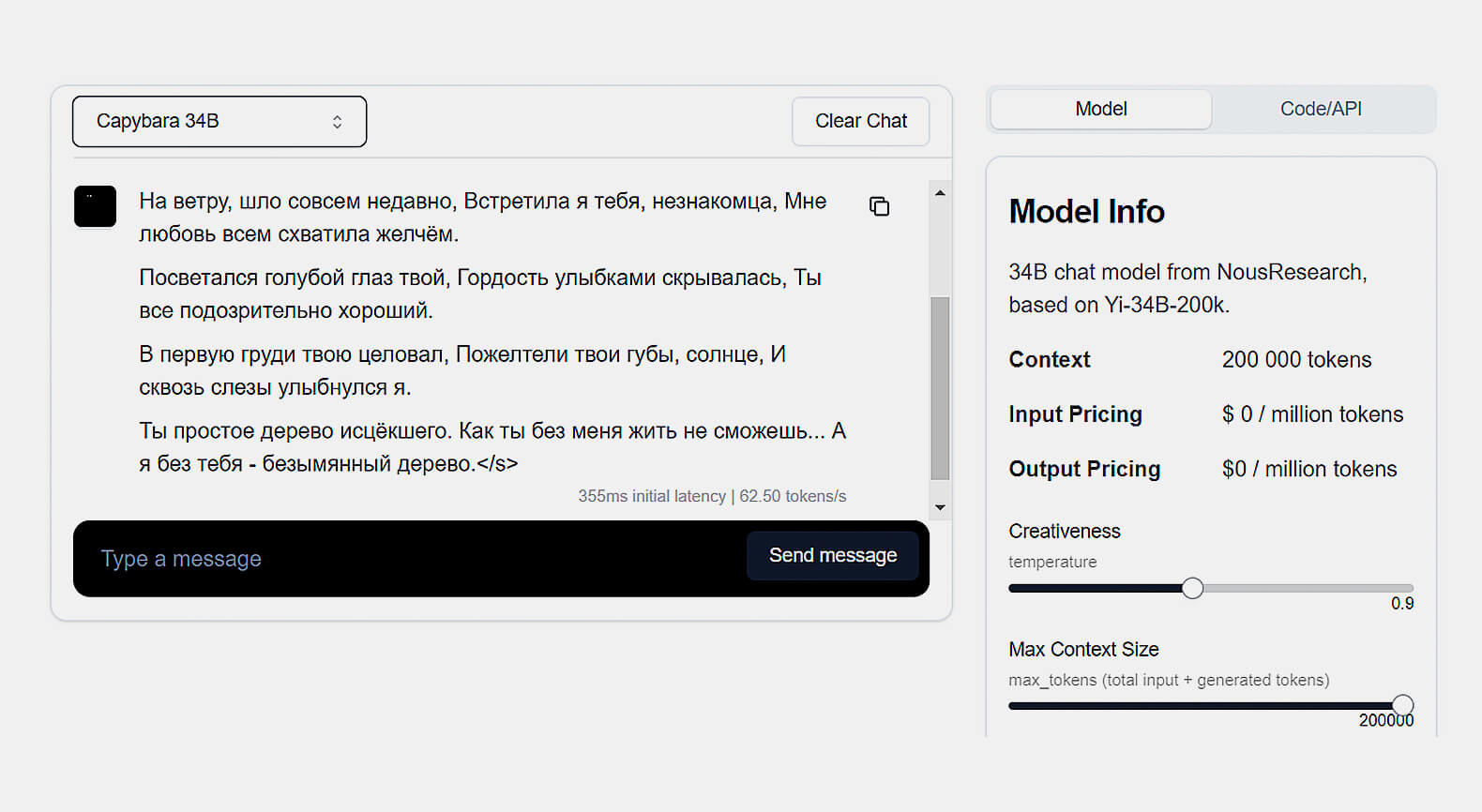

Fireworks AI

Платформа Fireworks AI предоставляет ИИ-разработчикам площадку для развёртывания, обучения и тонкой настройки собственных опенсорсных LLM. В том числе за счёт данных, сгенерированных другими открытыми нейронками, доступными в самом сервисе.

Но в качестве приятного бонуса на сайте можно поработать с нейросетями в режиме чат-бота. А их там хватает! На платформе доступно более 30 различных LLM. Правда, это удовольствие не бесплатное. Вернее, не совсем бесплатное.

Перед началом работы потребуется зарегистрироваться на сайте. После этого пользователь получает 10 виртуальных долларов, которые расходуются на запросы к LLM.

Этой суммы хватит надолго, так как каждый запрос к самым востребованным моделям обходится всего лишь в несколько центов, а к большинству — и вовсе бесплатен. Конкретная цена зависит от типа ИИ и количества токенов. Когда виртуальные деньги закончатся, баланс можно будет пополнить с банковской карты.

Что у Fireworks AI под капотом

Список моделей, доступных через этот сервис, постоянно пополняется. Ознакомиться с актуальным набором LLM можно по ссылке. Сегодня здесь представлено более 30 опенсорсных нейронок, большинство из которых являются вариациями LLaMA.

Кроме уже хорошо известных нам Mistral, Mixtral и Zephyr, здесь есть и экзотические, например Capybara 34B и варианты LLaMA для японского языка. Кроме этого представлены модели для написания программного кода: StarCoder, Code LLaMA и Stable Code. Есть и мультимодальные LLM, например FireLLaVA — вариация LLaVA.

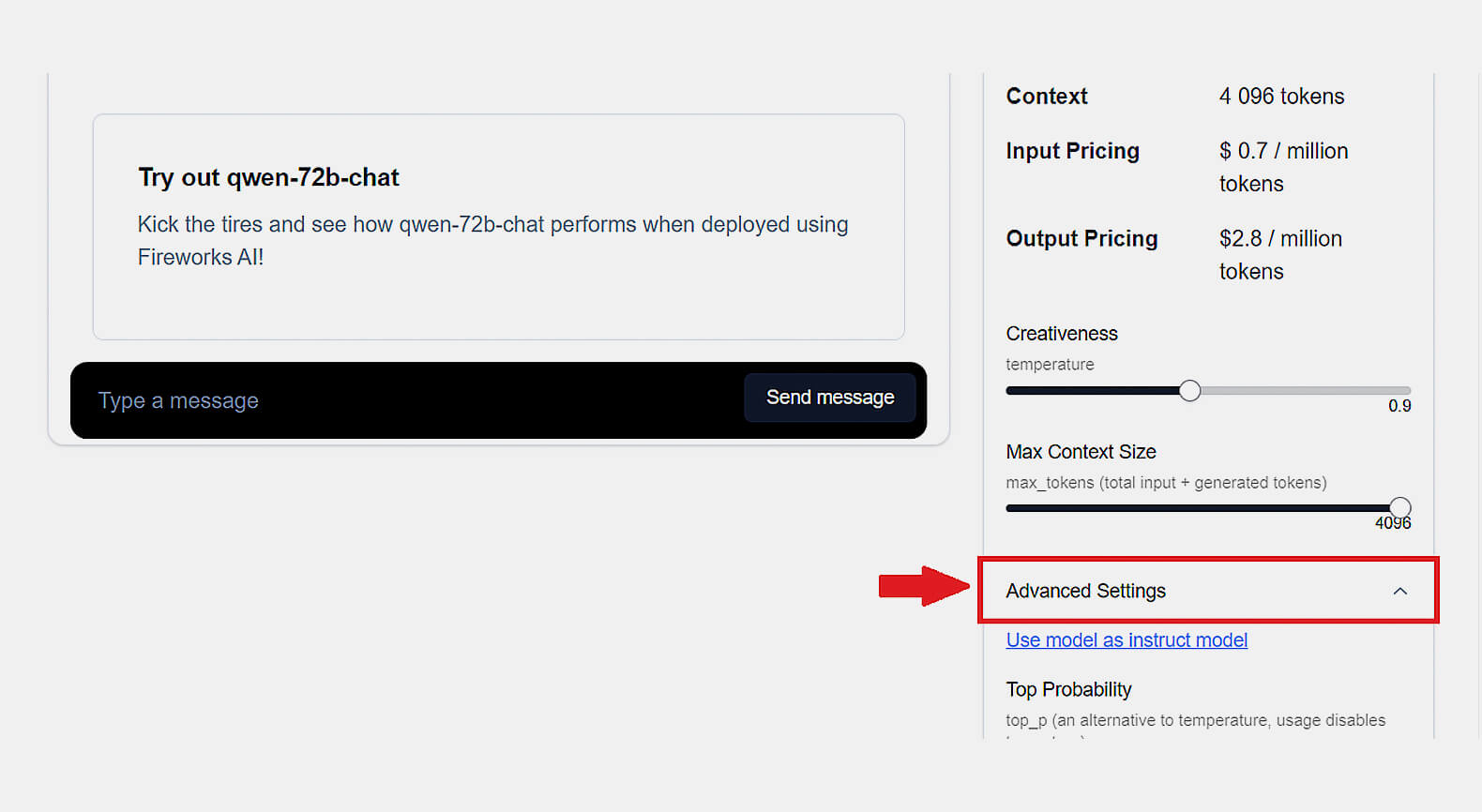

Дополнительные функции

Для каждой выбранной пользователем языковой модели Fireworks AI показывает на панели справа её краткое описание с указанием стоимости запроса и набор доступных настроек. У всех моделей можно настроить параметры Creativeness и Max Content Size. Первый отвечает за вариабельность ответов, а второй — за их максимальную длину.

В панели с расширенными настройками Advanced settings можно найти необычные опции, такие как Top P и Top K (являются альтернативой настройки «температуры»), а также Frequency Penalty и Presence Penalty, которые определяют вероятность того, что LLM сгенерирует один и тот же токен.

Скриншот: Fireworks AI / Skillbox Media

Тестируем возможности Fireworks AI

Зарегистрироваться на платформе можно в пару кликов через существующий Google-аккаунт. Язык интерфейса только английский.

Кроме использования чат-бота на сайте, Fireworks AI предлагает возможность сгенерировать фрагмент программного кода, который можно вставить в стороннюю программу, например телеграм-бот, и получать доступ к выбранной нейросети через API. Поддерживаются языки Python, TypeScript и Curl.

Посмотрим на то, как Fireworks AI справляется с задачами.

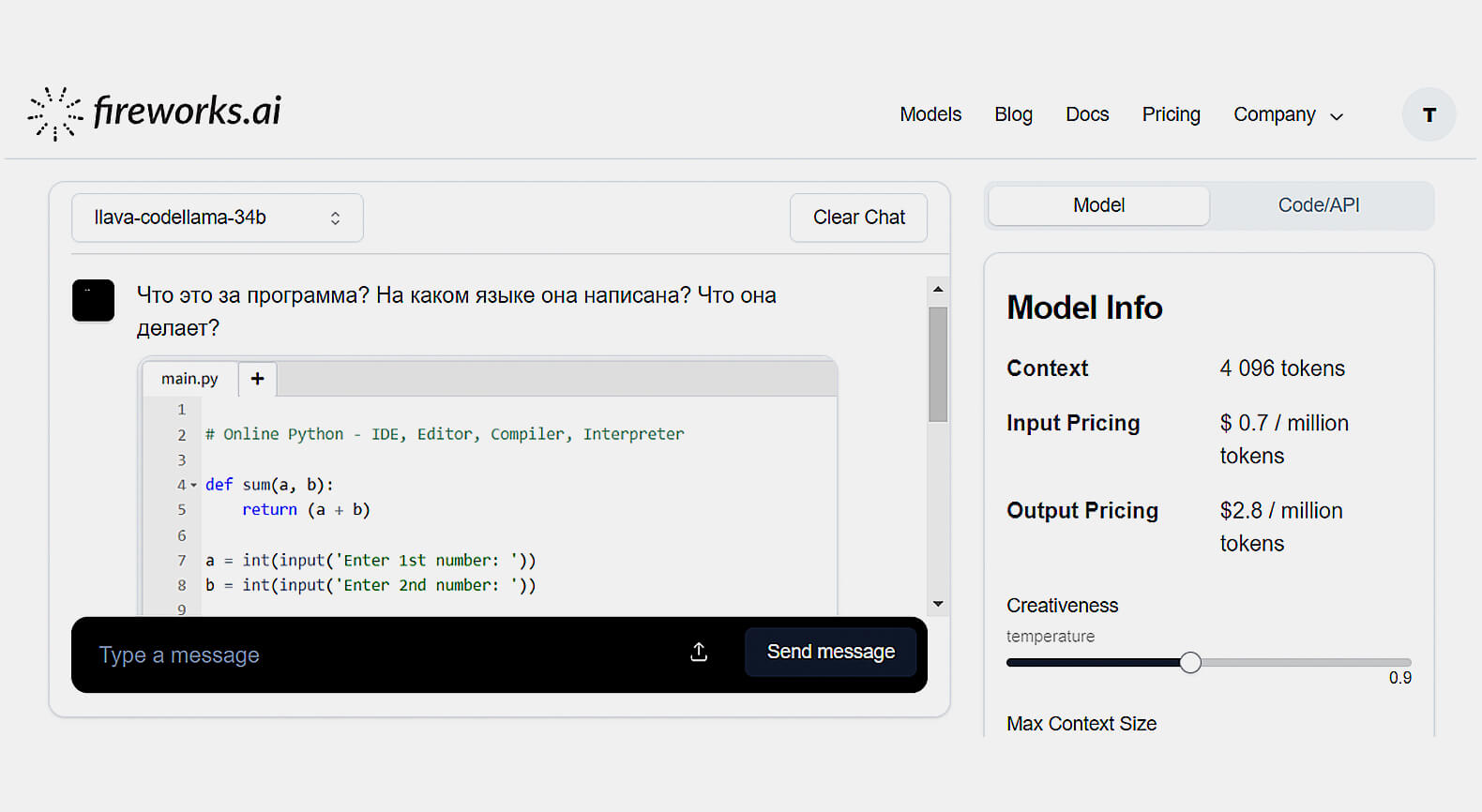

Скриншот: Fireworks AI / Skillbox Media

Скриншот: Fireworks AI / Skillbox Media

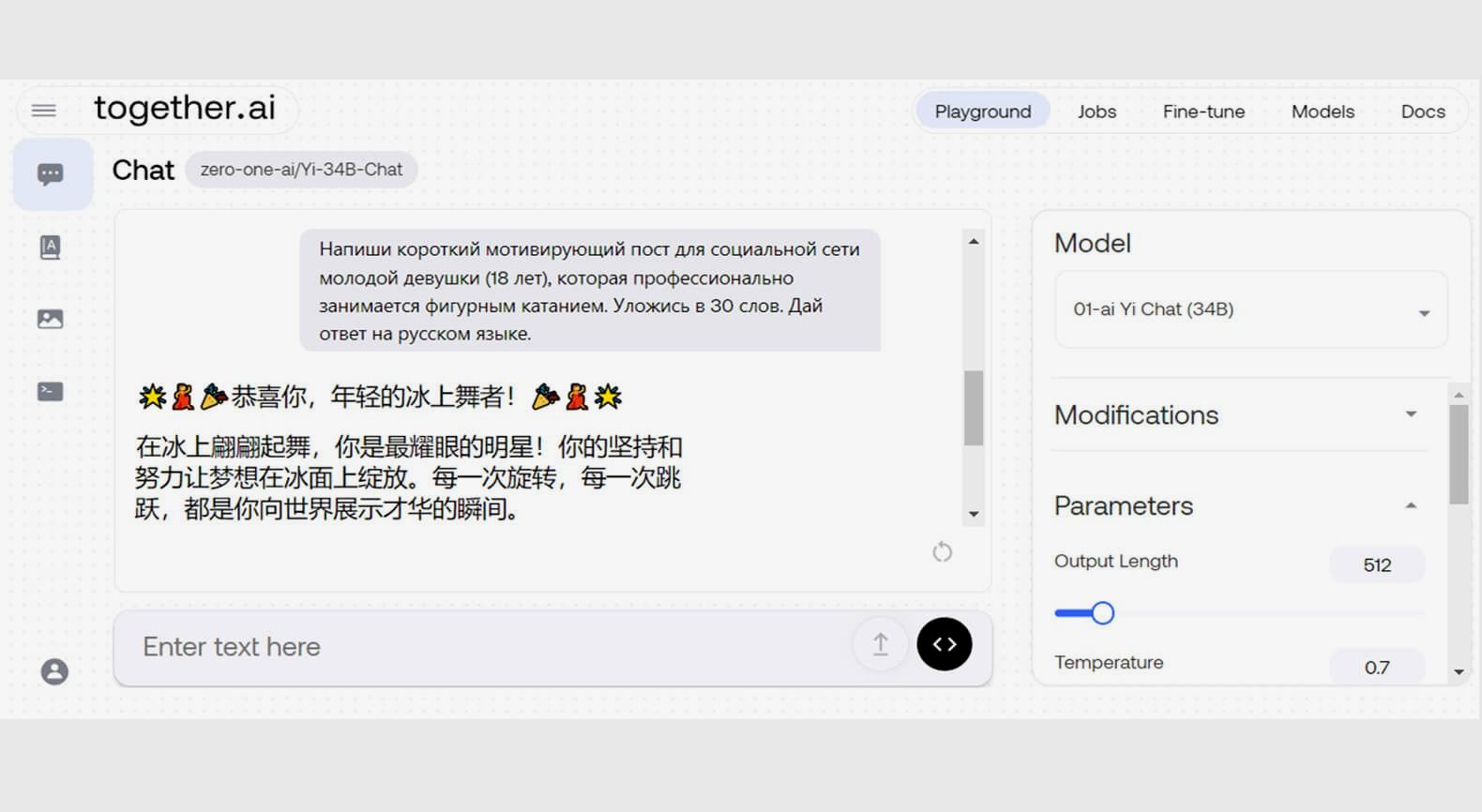

Скриншот: Fireworks AI / Skillbox Media

Скриншот: Fireworks AI / Skillbox Media

Регистрация: обязательна, через Google-аккаунт.

Стоимость: цена каждого запроса к LLM — от 0 до нескольких центов.

Платные функции: первые 10 долларов в подарок за регистрацию, далее — пополнение баланса счёта банковской картой от пяти долларов.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: более 30 на выбор, включая Mistral, Mixtral, Zephyr, Capybara, StarCoder, Code LLaMA, StableCode и мультимодальную FireLLaVA (актуальный список здесь).

Дополнительные возможности: настройка «температуры», максимального размера контекста, параметров разнообразия Top P, Top K, Frequency Penalty, Presence Penalty и других.

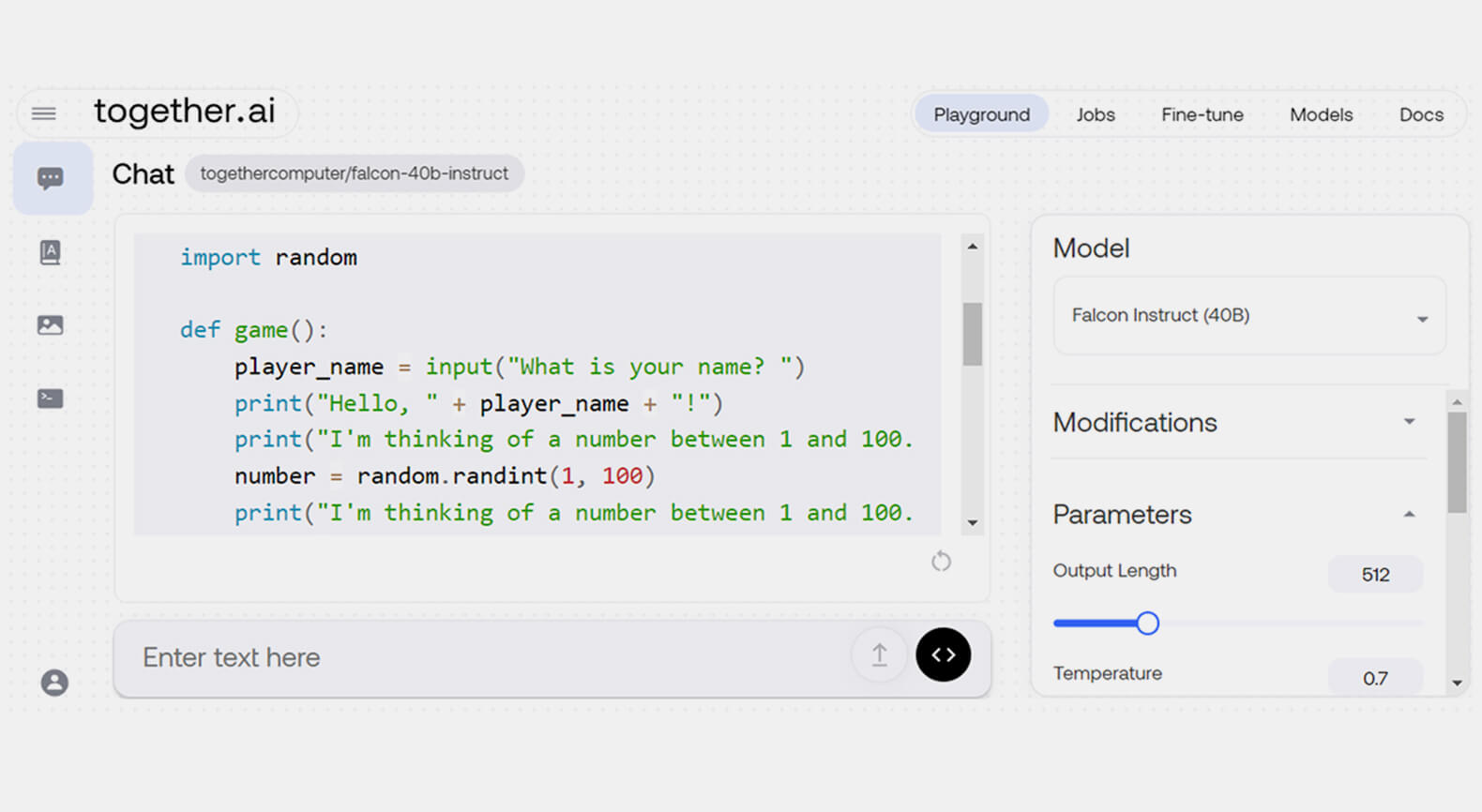

Together AI Playground

Стартап Together AI, основанный в 2022 году в Сан-Франциско, предоставляет исследователям нейронок площадку для размещения, настройки и обучения языковых моделей. Свой сервис разработчики презентуют как «самую быструю облачную платформу для создания и запуска генеративного ИИ», которая «поможет пройти все этапы создания современной модели искусственного интеллекта».

Компания занимается собственными научными исследованиями. Together AI заручился поддержкой NVIDIA — крупнейшего производителя чипов для ИИ. При её поддержке был собран открытый датасет RedPajama, а также создан ряд оригинальных LLM, среди которых выделяется опенсорсная модель StripedHyena-7B с инновационной архитектурой, о которой мы поговорим дальше.

В этой статье мы говорим только про «Игровую площадку» (Playground) Together AI. На ней в рамках теста доступно около 100 генеративных моделей, из которых 40 предназначены для работы с текстом в режиме чат-бота.

Для доступа к этой коллекции нейронок требуется зарегистрироваться через аккаунт Google, LinkedIn или GitHub. После этого пользователь получает 25 долларов, которые расходуются на запросы к LLM.

Стоимость запросов к каждому виду моделей различается. Но в любом случае она не превышает нескольких центов за один миллион токенов. Поэтому 25 долларов хватит надолго. Затем придётся пополнить счёт банковской картой.

Что у Together AI Playground под капотом

Учитывая количество представленных на платформе моделей, создатели разделили их по четырём отдельным площадкам:

- Chat Playground для моделей ИИ, работающих в режиме чат-бота.

- Language Playground для LLM, способных генерировать продолжение начатого пользователем текста, основываясь на промпте-подсказке.

- Image Playground для моделей генерации изображений.

- Code Playground для нейросетей, обученных писать программный код.

Из популярных опенсорсных языковых моделей можно найти практически все актуальные варианты LLaMA, Mistral, Nous Research, OpenChat, Falcon, а также китайские открытые нейронки Qwen и Yi.

Есть и LLM собственной разработки — StripedHyena-Nous-7B. По заверениям разработчиков из Together AI, она основана на принципиально новой гибридной архитектуре, способной конкурировать с лучшими нейросетями-трансформерами, включая все известные опенсорсные варианты LLaMA.

Дополнительные функции

Для каждой выбранной пользователем модели Together AI Playground можно открыть панель расширенных настроек. Среди них есть Temperature, Top P и Top K (являются альтернативой Temperature), Output Length (максимальная длина генерируемого текста), Repetition Penalty (отвечает за удаление повторяющихся слов) и ряд других.

Тестируем возможности Together AI Playground

Зарегистрироваться на платформе можно в пару кликов через существующий Google-аккаунт. Язык интерфейса только английский.

Напишем несколько промптов и проверим Together AI Playground в работе.

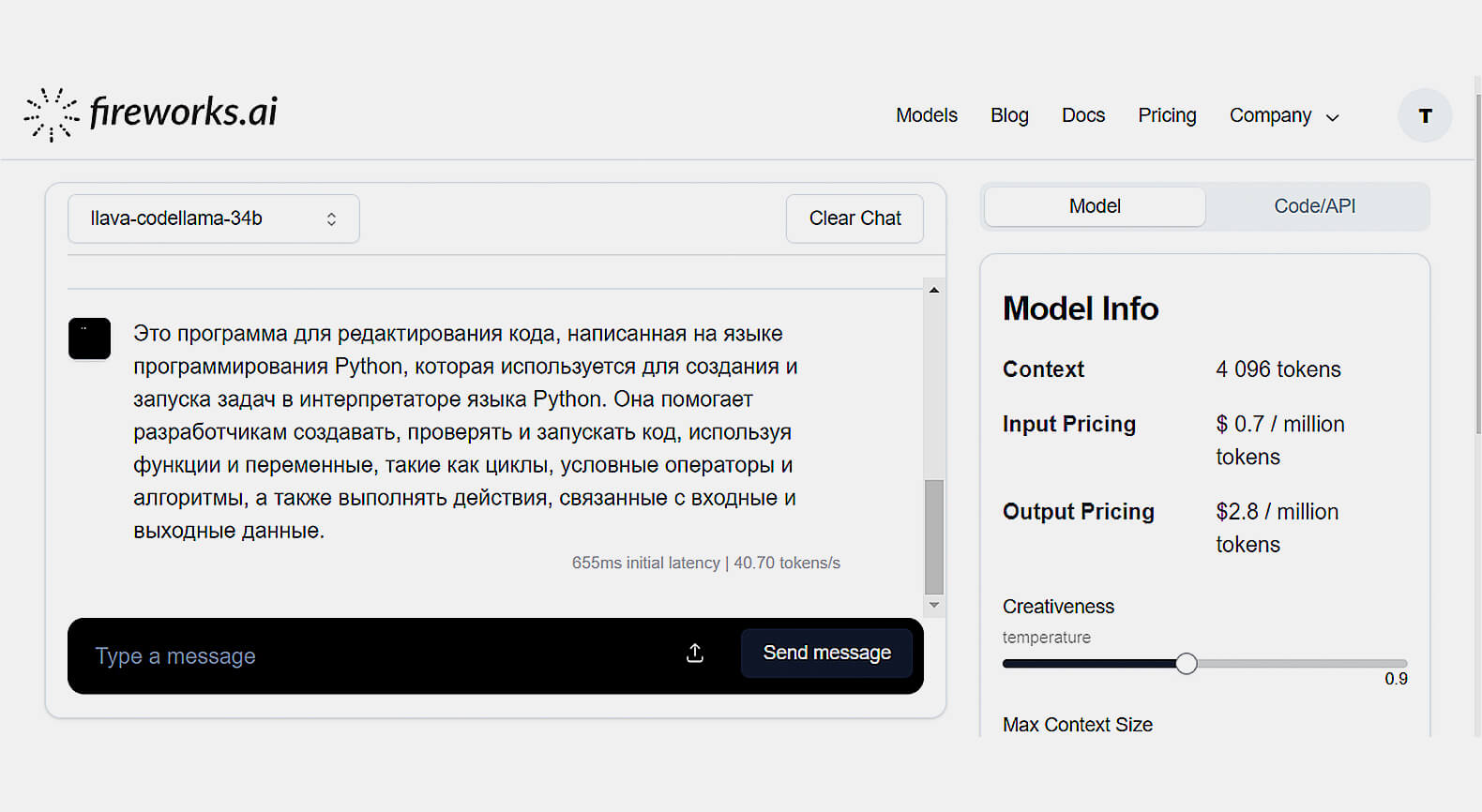

Скриншот: Together AI / Skillbox Media

Скриншот: Together AI / Skillbox Media

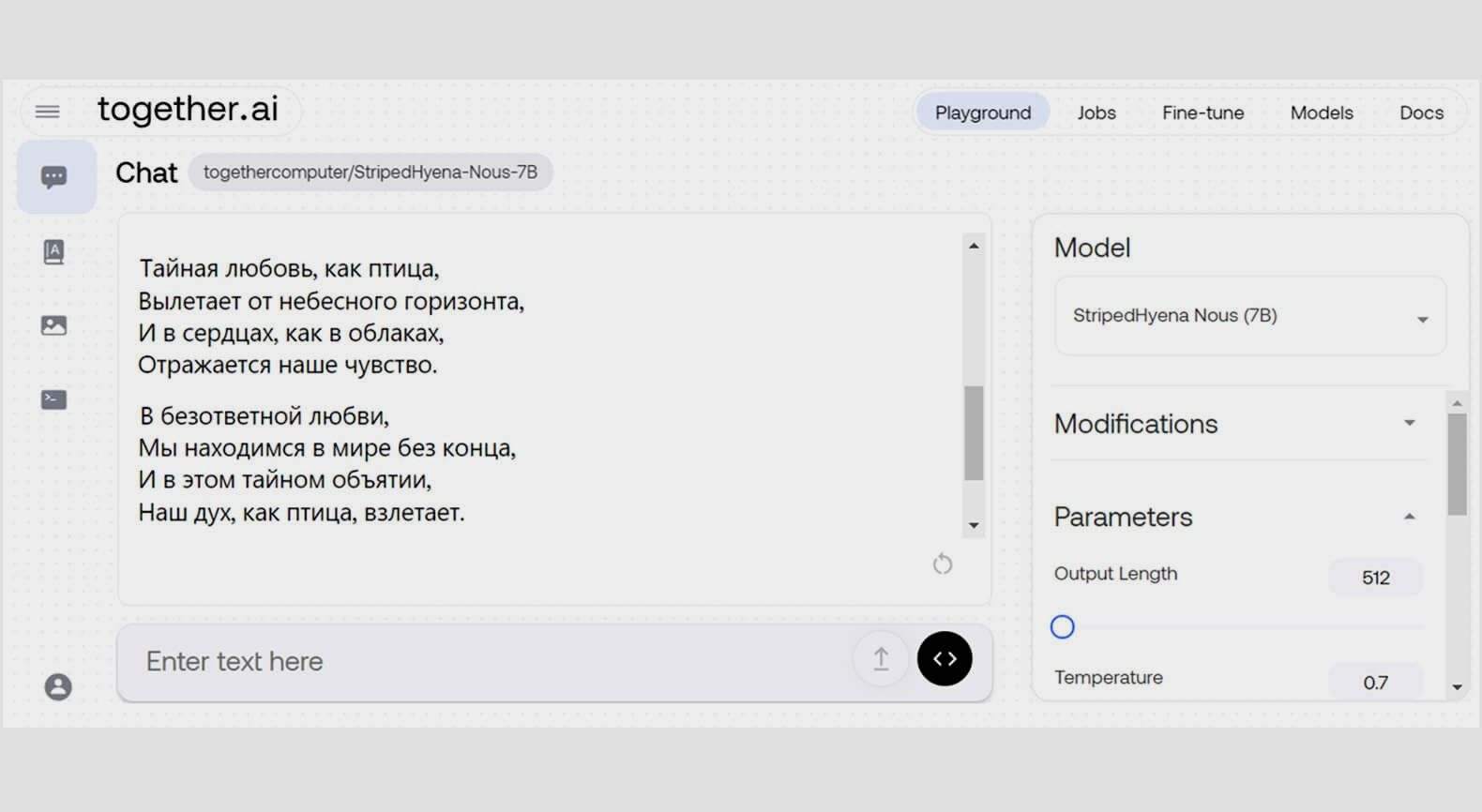

Скриншот: Together AI / Skillbox Media

Скриншот: Together AI / Skillbox Media

Регистрация: обязательна, через аккаунт Google, LinkedIn или GitHub.

Стоимость: от 0,1 доллара за 1 миллион токенов (подробнее).

Платные функции: первые 25 долларов в подарок за регистрацию, далее — пополнение счёта банковской картой.

Язык интерфейса: английский.

Доступен ли с российского IP: да.

LLM под капотом: около 100 на выбор, включая LLaMA, Mistral, Mixtral, OpenChat, Falcon, Qwen, Yi, StripedHyena.

Дополнительные возможности: настройка «температуры», длины генерируемого текста, параметров разнообразия Top P, Top K, Repetition Penalty и других.

Вместо заключения

В этой статье мы поговорили об основных опенсорсных нейросетях, способных заменить ChatGPT и другие платные чат-боты, актуальные на февраль 2024 года. Их разнообразие позволяет ещё раз подтвердить то, что open source в ИИ продолжает стремительно развиваться.

Но важно сказать, что быстрое развитие сферы открытых LLM приводит к тому, что описанные нами сервисы через некоторое время могут утратить актуальность и перестать работать. Например, так случилось с проектом OpenAssistant, который в прошлом году непременно входил во все подборки подобного рода. Сегодня этот сервис, собрав обратную связь от тысяч добровольных тестировщиков, закончил свою работу.

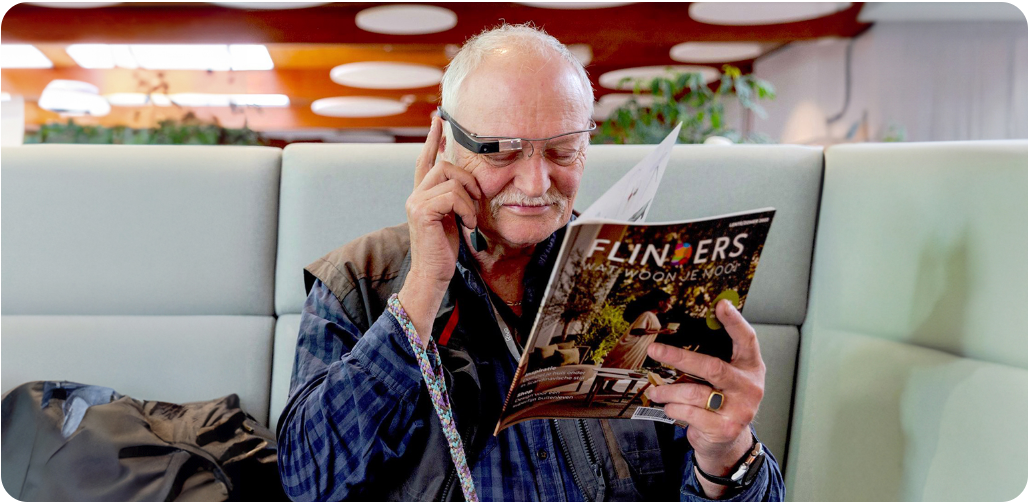

Поэтому мы продолжим следить за новинками ИИ-опенсорса и будем рассказывать вам о главных новостях развития искусственного интеллекта в нашем телеграм-канале.