Код выложили на GitHub под собственной NVIDIA Source Code License, которая ограничивает коммерческое применение технологии.

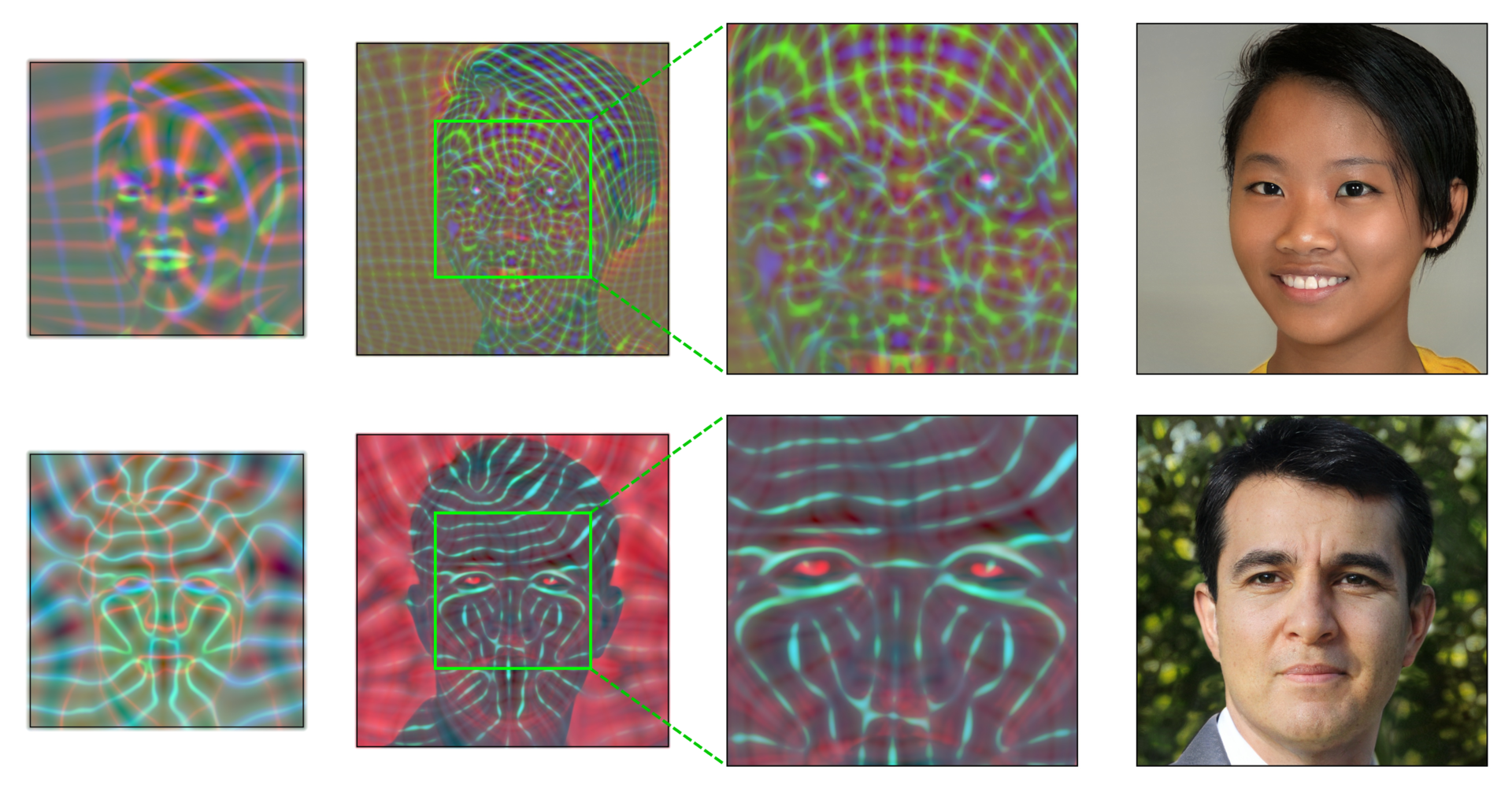

Помимо исходников в GitHub проекта доступны уже готовые модели, которые тренировались на Flickr-Faces-HQ (FFHQ) — коллекции из 70 тысяч PNG-изображений лиц в разрешении 1024×1024, а также на коллекции лиц животных AFHQv2 и портретах классической живописи Metfaces.

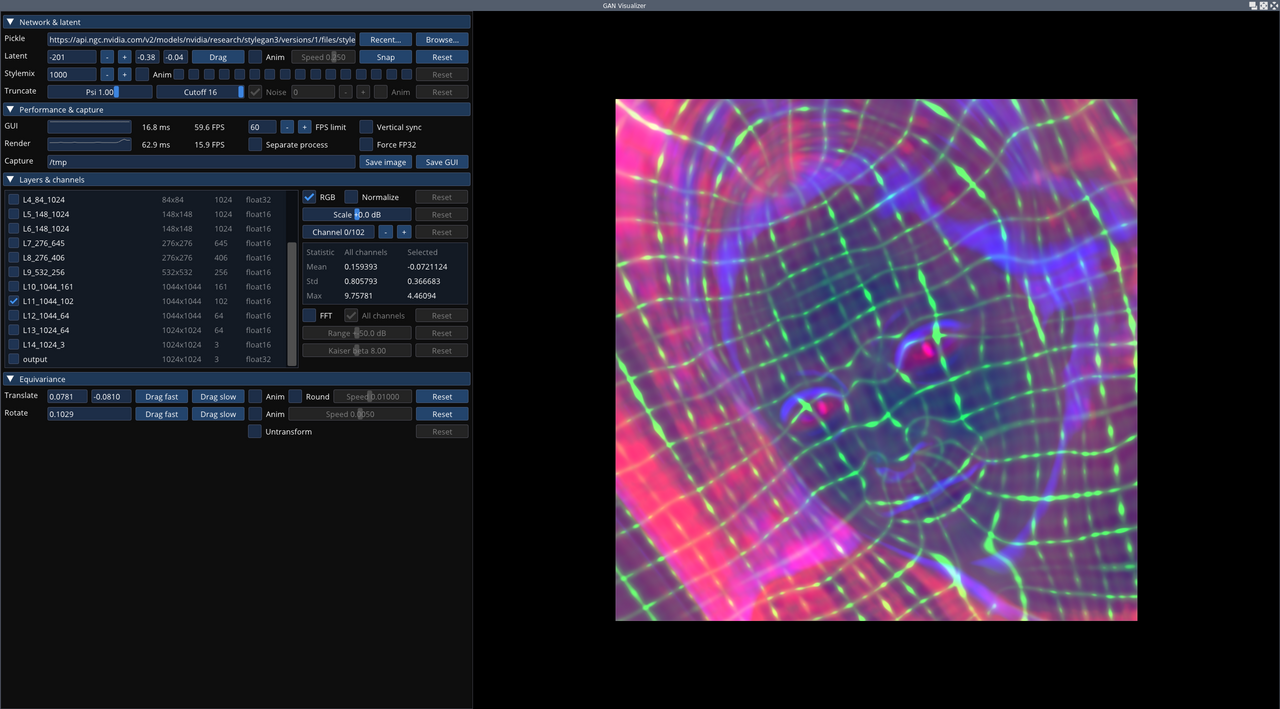

Хотя изначально система рассчитана на генерацию лиц, её можно дообучить и синтезировать любые объекты — например, пейзажи или машины. Правда, чтобы поиграться с StyleGAN3, понадобится неслабое железо: карта NVIDIA (лучше GPU Tesla V100 или A100), минимум 12 ГБ ОЗУ, установленные PyTorch 1.9 и инструментарий CUDA 11.1+.

StyleGAN3 — система машинного обучения на основе GAN (генеративно-состязательной нейронной сети). Она умеет генерировать реалистичные изображения лиц людей. Она написана на Python с использованием фреймворка PyTorch, накладывающего ограничение на использование в коммерческих целях.

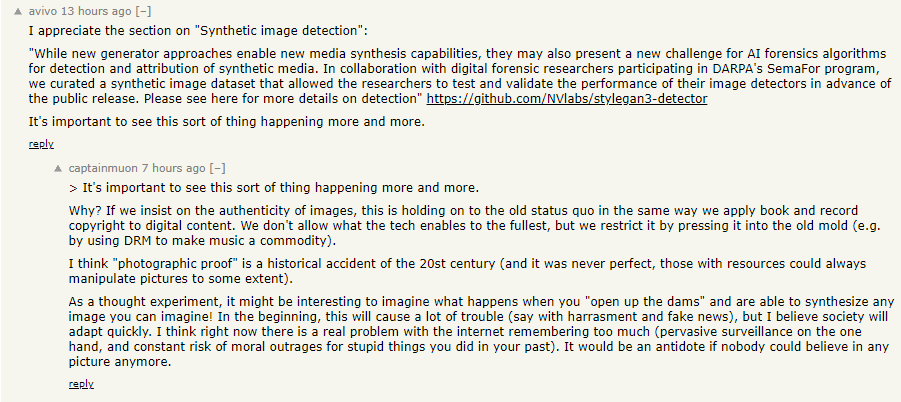

Вот что думают об этом посетители Reddit и HackerNews:

avivo: Мне понравился раздел «Определение искусственных изображений»: «Хотя новые подходы к генерации позволяют создавать новые возможности синтеза мультимедиа, они также могут стать новой проблемой для алгоритмов судебной экспертизы искусственного интеллекта для обнаружения и атрибуции синтетических носителей».

captainmuon: Я думаю, что «фотографическое доказательство» — это пережиток XX века (да и оно никогда не было идеальным — те, у кого есть ресурсы, всегда могли манипулировать фотографиями).

В качестве мысленного эксперимента было бы интересно представить, что происходит, когда мы научимся синтезировать любой образ, который только можно представить! Вначале это вызовет множество проблем (например, с оскорблениями и фейковыми новостями), но я верю, что общество быстро адаптируется к новой реальности. Я думаю, гораздо более серьёзная проблема — это то, что интернет знает о нас слишком много (повсеместная слежка и риск стать преследуемым за свои глупые поступки из прошлого). Так что было бы отлично, если перестали доверять любым изображениям.

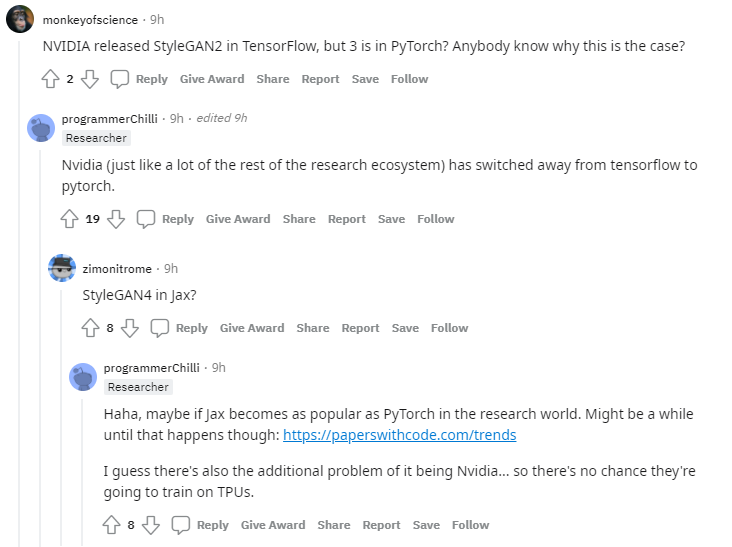

monkeyofscience: NVIDIA делала StyleGAN2 на TensorFlow, но 3 — на PyTorch? Кто-нибудь знает, почему?

programmerChilli: NVIDIA (как и многие другие участники экосистемы исследователей) перешла с tensorflow на pytorch.

zimonitrome: Ждём StyleGAN4 в Jax?

programmerChilli: Ха-ха, вполне возможно — только если Jax станет таким же популярным, как PyTorch в сфере исследований. Но думаю, до этого ещё далеко. Ну и есть ещё одна проблема — это сама NVIDIA… Нет ни малейшего шанса, что они собираются тренировать свои нейросети на TPU.

CyberDainz: «Весь этот проект затратил эквивалент 92 лет работы графического процессора и 225 МВт/ч электроэнергии на внутреннем кластере NVIDIA V100». Чёрт возьми!

dangnabbitdamnit: «225 МВт/ч электроэнергии». Да это ж 15 минут работы целого ядерного реактора. И правда, «чёрт возьми».

Mefaso: Это примерно 225 американских домохозяйств в год (они потребляют около 10 МВт/ч в год).