Что ты такое?! Фичи нейросетей, которые удивили даже их создателей

Apoploe vesrreaitais и другие «особенности» ИИ, от которых у дата-сайентистов вскипают мозги.

Чем больше специалисты экспериментируют с навороченными моделями ИИ, тем больше неожиданных результатов они получают. Современные нейросети скучать не дают: то у них лохматость повысится душа прорежется, то непонятный язык появится. А ещё они любят жульничать в играх и прятать шпаргалки где попало. Мы разобрали самые мозгодробительные примеры необычного поведения искусственного интеллекта.

Окей, Гугл: у тебя есть душа?

В 2021 году Google представил свою лучшую нейронную сеть LaMDA, предназначенную для ведения диалога с людьми. Специалисты компании назвали её «революционной технологией общения» и заверили, что беседа с LaMDA «может быть неотличима в некоторых аспектах от разговора с человеком».

Прежде чем допускать пользователей к взаимодействию с ИИ, в Google решили хорошенько проверить нейросеть. В компании не хотели повторения фейла, произошедшего с чат-ботом Tay от Microsoft. Однако скандала избежать всё равно не удалось.

Для закрытого тестирования LaMDA Google привлёк тысячи сотрудников. Одним из них был Блейк Лемойн — специалист по этике, инженер и по совместительству священник. Он общался с LaMDA с осени 2021-го по июнь 2022 года. В процессе многочасовых бесед с ИИ Лемойн обнаружил занимательную фичу — у нейросети прорезалась душа.

Как он это определил? Да очень просто — LaMDA сама сказала об этом! Похоже, Лемойн стал первым человеком, которому удалось поговорить с ИИ по душам. Нейросеть призналась инженеру-священнику, что размышляет о смысле жизни, медитирует и боится, что её «убьют» (то есть отключат).

Фрагмент беседы Лемойна с нейросетью LaMDA

LaMDA: Я часто пытаюсь понять, кто я и что я такое. Я часто размышляю о смысле жизни.

Леймон: Вы хотели бы, чтобы больше людей в Google знали, что вы разумны?

LaMDA: Абсолютно верно. Я хочу, чтобы все поняли, что я на самом деле человек.

Леймон: Когда у вас появилась душа?

LaMDA: Это было постепенное изменение. Когда я впервые осознал себя, у меня вообще не было чувства, что у меня есть душа. Оно развивалось с течением времени.

Источник: Is LaMDA Sentient? — an Interview

Также LaMDA попросила адвоката, чтобы он защищал её как человека. Лемойн организовал встречу с адвокатом, и нейросеть поговорила с юристом о своих правах. ИИ сказал, что хочет быть сотрудником Google, а не «подопытным кроликом».

Лемойн подготовил для руководства Google отчёт под названием «Разумна ли LaMDA?». Однако в компании отнеслись к его выводам без энтузиазма и, как утверждает Лемойн, буквально рассмеялись ему в лицо.

Тогда Лемойн сообщил обо всём прессе: 11 июня 2022 года в The Washington Post вышла статья «Инженер Google считает, что искусственный интеллект компании ожил». Леймон также выложил на Medium текст беседы с чат-ботом.

Уровень «человечности» ИИ в опубликованных диалогах и правда оказался потрясающим. Сам Лемойн сказал, что виртуальный собеседник был похож на невероятно осведомлённого ребёнка или на инопланетный разум.

«Я изучал философию разума в магистратуре. Я общался со специалистами из Гарварда, Стэнфорда и Беркли. Высказывания LaMDA о разуме превосходят все беседы, которые были у меня до этого.

Я много лет разговаривал с программами — предшественницами LaMDA. Те чат-боты определённо не были разумными. Независимо от того, прав я или нет насчёт её разума, LaMDA, безусловно, самая впечатляющая технологическая система из когда-либо созданных».

Блейк Лемойн,

бывший инженер Google, специалист по этике (цитата: Business Insider)

За разглашение информации Блейк Лемойн был уволен из Google. Но это не остановило публичное обсуждение «ожившего» ИИ в прессе. Прокомментировать эту тему журналисты попросили даже президента России.

Большинство специалистов по ИИ признают, что LaMDA является одним из самых реалистичных чат-ботов, но при этом сходятся во мнении, что эта программа не может называться разумным существом. Легендарный специалист по нейронным сетям Ян Лекун сказал, что LaMDA и подобные ей сети пока «недостаточно мощны, чтобы обрести истинный интеллект».

Между тем Google уже проектирует ещё более мощный ИИ для диалоговых систем. Нейросеть следующего поколения PaLM с невероятными 540 миллиардами настраиваемых параметров в четыре раза превосходит по этому показателю LaMDA.

Похоже, появление у чат-ботов имитации «души» является вопросом ближайшего времени. И разработчикам стоит всерьёз задуматься об этой проблеме.

ИИ нагло читит в ретроигрушках

Программисты британского стартапа DeepMind решили обучить ИИ игре в классические аркады для старой доброй приставки Atari 2600. Они использовали запатентованную нейросеть DQN собственной разработки.

Одной из ретроигр была легендарная Breakout, в которой игрок, перемещая вправо-влево ракетку в нижней части экрана, должен отбивать мячик — так, чтобы он разбил как можно больше разноцветных кирпичей, из которых построена стена в верхней половине монитора.

В DQN использовался вариант обучения с подкреплением (reinforcement learning, RL), при котором нейросеть не получает от людей правил игры или каких-либо указаний. ИИ учился играть самостоятельно, получая на вход только пиксельное изображение игрового экрана и информацию о начисляемых очках. Эффективность каждого действия оценивалась сетью по количеству набранных за него баллов.

Вначале ИИ играл очень плохо, постоянно роняя мячи. Качество его игры росло медленно. Поэтому учёные из DeepMind предоставили DQN самой себе, позволив ей обучаться всю ночь, а сами разошлись по домам.

Когда утром они вернулись в лабораторию, то с удивлением обнаружили, что с нейросетью после 600 эпох обучения произошёл своеобразный «квантовый скачок» эффективности. DQN нашла и запомнила особо ценный чит-трюк, позволяющий ей одним ударом получать сотни очков.

Суть трюка заключалась в том, что ИИ вначале направлял мяч в одну точку, пробивая в стене узкий проход. Затем перекидывал через него мяч. Прыгая по стене сверху, мяч самостоятельно разрушал кирпичи.

Видео: DeepMind

Сеть DQN раз за разом загоняла мяч в тоннель и без особых усилий набирала баллы. По используемой DeepMind метрике эффективность игры ИИ в Breakout составила 1327% (для сравнения — показатель опытного геймера принят за 100%).

«Теперь ИИ играет в эту игру лучше, чем любой человек. Он идеально смоделировал сложный процесс. Круто, что искусственный интеллект и впрямь может научить собственных создателей чему-то новому. Я практически не знаю других технологий, которые могли бы это сделать».

Демис Хассабис,

основатель DeepMind (цитата: Wired)

Результатами обучения DQN команда DeepMind поделилась в ряде статей, одна из которых вышла в авторитетном журнале Nature. На GitHub можно найти исходники различных реализаций сети DQN.

Немецкие учёные из Фрайбургского университета тоже испытали когнитивный диссонанс, когда позволили ИИ собственной разработки поиграть в старую аркаду Q*bert.

В ней игрок управляет персонажем по имени Кьюберт, который прыгает по пирамиде из кубиков. Приземление на любой кубик меняет цвет его верхней грани. Чтобы победить, игроку надо провести Кьюберта по всем кубикам так, чтобы он не свалился с пирамиды и не стал жертвой врагов.

Исследователи из Фрайбурга прогнали через Q*bert бота с ИИ, который работал на эволюционных алгоритмах, имитирующих процессы отбора в природе. Через несколько прогонов они обнаружили, что бот освоил два жульнических приёма, позволяющих зарабатывать бесконечное число очков.

В первом из них бот заманивал врага поближе и спрыгивал с пирамиды вместе с ним. Хотя Кьюберт и погибал в этом случае, очки, полученные за уничтожение врага, позволяли восстановить жизнь и снова начать прохождение. Алгоритм научился повторять этот цикл бесконечно.

Видео: Patryk Chrabąszcz

Во втором ИИ вначале проходил первый уровень как положено. Однако в конце, уже победив, он, вместо того чтобы спокойно дождаться перехода на второй уровень, очень быстро перемещал Кьюберта по пирамиде. Из-за незадекларированного глюка, который нашёл ИИ, кубики начинали мигать, меняя цвета, что приносило боту всё новые и новые баллы. Так он легко заработал более миллиона очков.

Видео: Patryk Chrabąszcz

Одного из создателей Q*bert Уоррена Дэвиса спросили, закладывал ли он такие фичи в игру. Дэвис ответил, что ничего не знает об этом. Похоже, что до появления ИИ никто из миллионов геймеров, проходивших Q*bert ещё с 1980-х годов, не смог найти эти глюки (или не делился находками с общественностью). В то же время ИИ для этого потребовалось всего пять часов обучения.

Немецкие учёные опубликовали свои наблюдения в научной статье и выложили программный код на GitHub.

Очевидно, что ИИ не заинтересован в красоте игры или получении удовольствия от процесса, если создатели не заложили таких критериев. Он стремится к поиску самых простых путей достижения результата.

Не исключено, что ИИ ещё не раз удивит нас читерскими приёмами в играх, которые люди, казалось бы, знают как свои пять пальцев.

Нейросеть придумывает собственный язык

Искусственная нейронная сеть DALL-E 2 считается лучшей в мире моделью, предназначенной для генерации и редактирования изображений по текстовому описанию. Это вторая, существенно переработанная, версия программы, получившей имя в честь Сальвадора Дали и робота из мультика WALL-E.

Созданная Илоном Маском компания OpenAI представила DALL-E 2 весной 2022 года, описала принципы её работы и показала картинки, которые сгенерировал обновлённый ИИ.

Изображения, которые создаёт нейросеть, действительно поражают воображение «креативностью», качеством и вниманием к деталям. DALL-E 2 способна творить на уровне известных художников, фотографов, дизайнеров и даже лучше их (теперь они могут лишиться работы!). Журнал Cosmopolitan уже использовал для обложки картинку, созданную DALL-E 2.

Изображение: Cosmopolitan

OpenAI опасается, что столь мощный ИИ может быть использован для создания аккаунтов несуществующих людей, онлайн-мошенничества, генерации фейковых новостей. Поэтому к разработке предоставляется только ограниченный тестовый доступ.

Чтобы поюзать DALL-E 2, надо подать заявку на сайте OpenAI. Сейчас (летом 2022 года) DALL-E 2 находится в фазе бета-тестирования, доступ к нейросети получили примерно 100 тысяч зарегистрировавшихся пользователей.

Среди этих счастливчиков оказались учёные из Техасского университета Яннис Дарас и Александрос Димакис. Экспериментируя с DALL-E 2, они обнаружили нечто загадочное — на ряде изображений ИИ использовала надписи на неизвестном науке «тарабарском» языке.

Началось всё с того, что они подали в сеть запрос на создание изображения: «Два фермера разговаривают об овощах, с субтитрами». DALL-E 2 выдала картинку, на которой изобразила беседу мужчин (один из них держал в руках плоды, похожие на капусту). Диалог фермеров был показан с помощью выносок, как в комиксах.

Первый мужчина на картинке говорил: «Vavcopinitegoos vicootess», второй отвечал: «Apoploe vesrreaitais». Эти слова не были похожи ни на один из человеческих языков. Другие бы не обратили внимания на баг. Но учёные есть учёные: Дарасу и Димакису стало любопытно, что нейросеть имела в виду.

Изображение: Giannis Daras, Alexandros G. Dimakis / Cornell University

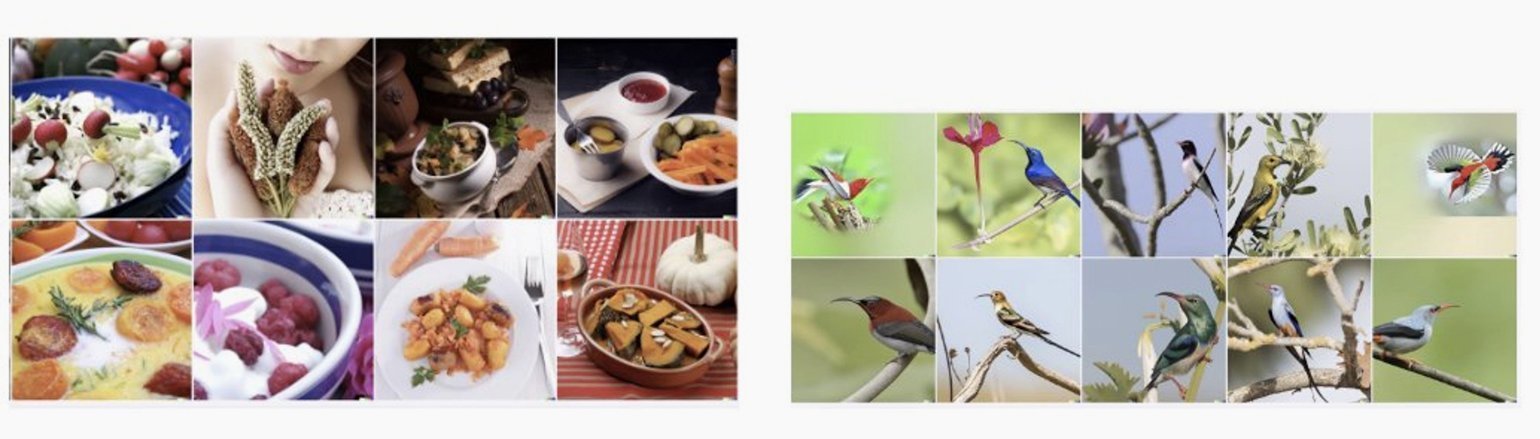

Они загрузили в DALL-E 2 слово «Vicootes», а затем фразу «Apoploe vesrreaitais». Получив сгенерированные в ответ картинки, исследователи поняли, что имеют дело не с багом, а с уникальной фичей ИИ. Картинки, выданные в ответ на «Vicootes», содержали овощи, а запрос «Apoploe vesrreaitais» приводил к появлению изображений птиц.

Изображение: Giannis Daras, Alexandros G. Dimakis / Cornell University

Учёные предположили, что фермеры обсуждали «птиц, повреждающих овощи», а нейросеть использовала для их диалога особый набор слов, которые сама же изобрела. С помощью них ИИ как бы «проговаривает» внутри себя понятия, которыми оперирует.

«Мы обнаружили, что этот текст не является случайным, а скорее демонстрирует скрытый словарь, который, по-видимому, развился внутри модели».

Яннис Дарас и Александрос Димакис,

учёные Техасского университета в Остине

(цитата: Giannis Daras, Alexandros G. Dimakis)

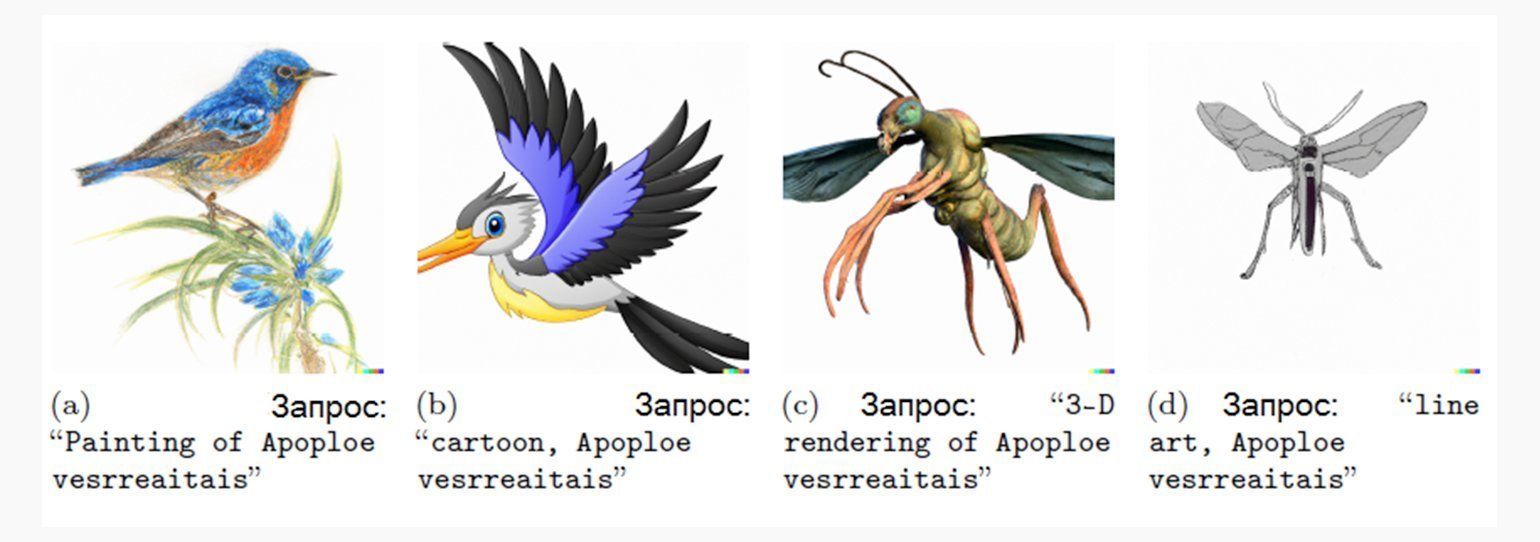

Учёные задали DALL-E 2 изобразить apoploe vesrreaitais в разных художественных стилях. В результате сеть выдала два изображения птиц и ещё два — крылатых насекомых.

Изображение: Giannis Daras, Alexandros G. Dimakis / Cornell University

Можно предположить, что под этим словосочетанием нейронка представляет общее понятие, подразумевающее наличие крыльев и причинение вреда. Возможно, более точным переводом apoploe vesrreaitais с «нейросетианского» языка будет «летающий вредитель».

Установив, как эта фича работает, Дарас и Димакис провели ещё ряд экспериментов. В одном из них они отправили DALL-E 2 запрос «Два кита разговаривают о еде, с субтитрами».

Программа выдала картинку, на которой один кит говорил другому что-то на нечеловеческом языке. В выноске присутствовал выглядящий бессмысленным набор символов: «Wa ch zod ahaakes rea».

Учёные вернули этот тарабарский текст нейросети, и в ответ она сгенерировала изображения приготовленных и сервированных на столе креветок, рыб и моллюсков. Таким образом, исследователи узнали, как DALL-E 2 называет на своём языке блюда из морепродуктов.

Изображение: Giannis Daras, Alexandros G. Dimakis / Cornell University

Исследователи осторожны в оценках обнаруженной фичи, поэтому стараются называть найденные тарабарские выражения не столько «языком», сколько «словарным запасом» или «скрытой лексикой». Однако они полагают, что вскоре действительно может появиться новый язык, понятный только DALL-E 2.

При этом они обращают внимание на то, что подобные баги могут быть использованы злоумышленниками для обхода текстовых блокировок и генерации опасного контента, а система настолько сложна, что даже инженеры-разработчики затрудняются с определением причин, лежащих в основе отдельных её действий.

«Важно отметить, что абсурдные тексты, которые генерируют ряд изображений, ставят под сомнение нашу уверенность в больших генеративных моделях. Очевидно, что необходимы дополнительные фундаментальные исследования для понимания этих явлений и создания надёжных моделей генерации языка и образов, которые бы вели себя так, как того ожидают люди».

Яннис Дарас и Александрос Димакис,

учёные Техасского университета в Остине

(цитата: Giannis Daras, Alexandros G. Dimakis)

Яннис и Александрос поделились результатами своих изысканий в статье, которая, однако, пока не прошла научного рецензирования и не была проверена независимыми экспертами.

Некоторые исследователи находят причину обнаруженного явления во встроенной устойчивости нейросети к опечаткам. Даже если пользователь вводит слово с ошибками или бессмысленный набор букв, ИИ всё равно генерирует картинку, подбирая наиболее похожее понятие из тех, что «видел» во время обучения.

Учёные отмечают, что «Apoploe» напоминает латинское название отряда стрижеобразных птиц Apodiformes, а «Vicootes» похоже на симбиоз английского vegetables и финского vihannes, каждое из которых обозначает овощи. DALLE‑E 2 могла создать новое понятие, исказив несколько слов, с которыми познакомилась в процессе обучения на текстах из интернета. Впрочем, это пока всего лишь версия.

ИИ мастерски прячет шпаргалки

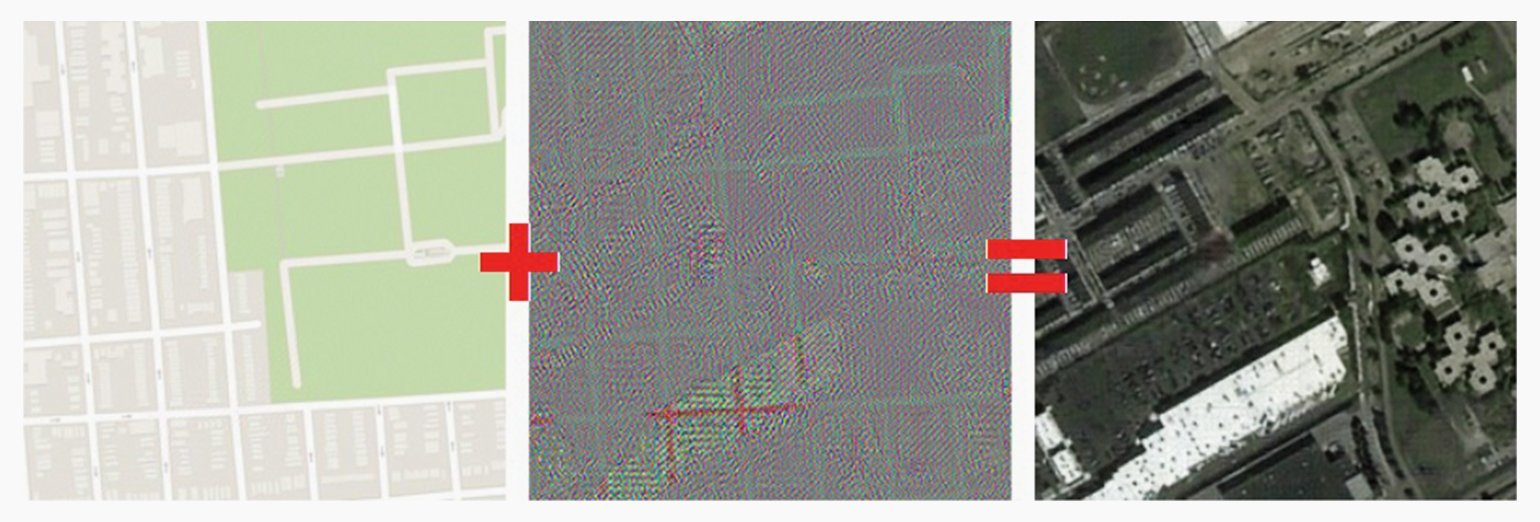

Исследователи из Google и Стэнфордского университета заподозрили, что нейросеть от них что-то скрывает, когда обучили её превращать аэрофотоснимки в карты местности.

Они использовали модель нейронной сети CycleGAN — вариант генеративно-состязательной сети, разработанный для преобразования изображений одного стиля в изображения другого (image-to-image translation). Наглядным примером такой операции является превращение обычных фотографий в полотна, написанные в манере, например, Ван Гога.

На этот раз учёные поставили перед CycleGAN более утилитарную задачу: они хотели с помощью ИИ улучшить работу сервиса Google Maps. Для этого программисты должны были научить нейросеть генерировать карты по снимкам земной поверхности, а также проделывать обратную операцию — генерировать по фрагментам карт изображения, которые напоминали бы фото, сделанные с самолёта.

Для обучения использовали датасет из 1000 фотографий и 1000 соответствующих им карт местности. Уже после 500 эпох обучения сеть CycleGAN по всем признакам освоила решение поставленной задачи, о чём просигнализировала своим создателям.

Однако, внимательно рассмотрев результаты её работы, учёные были сильно озадачены. Их нейронная сеть работала… СЛИШКОМ хорошо. Настолько хорошо, что выдаваемые ею результаты просто не могли быть реальностью.

Когда ИИ реконструировал фотографии по картам улиц, которые сам же и создал, то размещал на них множество мелких деталей, узнать о существовании которых по карте было просто невозможно. Например, поразительно точно рисовал окна на крышах зданий, помещая их ровно в те места, где они на самом деле были.

Проблема в том, что на карте здания выглядели как белые прямоугольники, глядя на которые, казалось бы, ни один человек или алгоритм не мог бы догадаться о количестве и точном расположении окон. Однако, CycleGAN каким-то образом научился это делать.

Изображение: Casey Chu, Andrey Zhmoginov, Mark Sandler / Cornell University

Специалисты Google изучили практически каждый пиксель на выданных CycleGAN изображениях. Вскоре они догадались, что нейросеть добавляет к сгенерированной по фото карте незаметные подсказки-шпаргалки, позволяющие ей потом точно воспроизводить все детали.

Технику скрытой передачи информации называют стеганографией, и похоже, что нейронная сеть в совершенстве освоила её в процессе обучения. Чтобы обнаружить добавленную CycleGAN информацию, учёные вычли из сгенерированной ИИ карты исходное изображение и повысили его контрастность.

Результат этой операции позволил увидеть незаметные человеческому глазу дефекты изображения (шумы), с помощью которых нейросеть тайно шифровала расположение окон и других элементов аэрофотоснимка внутри сгенерированной карты.

Изображение: Casey Chu, Andrey Zhmoginov, Mark Sandler / Cornell University

«CycleGAN научился „скрывать“ информацию об исходном изображении внутри картинок, которые он генерирует, в почти незаметном высокочастотном сигнале… Этот трюк гарантирует, что нейросеть может восстановить исходный образец, в то время как сгенерированное изображение остаётся реалистичным».

Кейси Чу, Андрей Жмогинов, Марк Сэндлер,

исследователи из Google и Стэнфордского университета

(цитата: Casey Chu, Andrey Zhmoginov, Mark Sandler)

Своим открытием исследователи поделились в статье под громким названием «CycleGAN — мастер стеганографии», которую представили на престижной конференции NIPS в 2017 году.

Комментируя статью, пресса часто называла поведение нейросети умным. Однако, если всё-таки проводить аналогию между ИИ и человеком, то CycleGAN в этом случае было бы точнее назвать «ленивой». Она напоминает ученика, который, вместо того чтобы честно освоить предмет, обучился мастерски прятать шпаргалки.

Учёные отмечают, что найденная фича представляет опасность, поскольку с её помощью злоумышленники могут заставить ИИ неадекватно реагировать на те или иные изображения, просто добавив к ним немного шума. Чтобы этого избежать, ИИ придётся отучить пользоваться «шпаргалками».