Читатель издания Ars Technica рассказал журналистам, что ChatGPT начал выдавать в диалоге пароли, логины и другие конфиденциальные данные пользователей. Он не был знаком с этими людьми и не знал, откуда нейросеть взяла информацию. Рассказываем, почему это произошло и может ли повториться.

Изображение: Ars Technica

Чужие данные

Чейз Уайтсайд рассказал, что утром попросил ChatGPT придумать оригинальные названия для цветов в палитре и отошёл от компьютера. Через некоторое время он вернулся и обнаружил в истории чатов новые диалоги со странными заголовками. Это было первым, что его смутило.

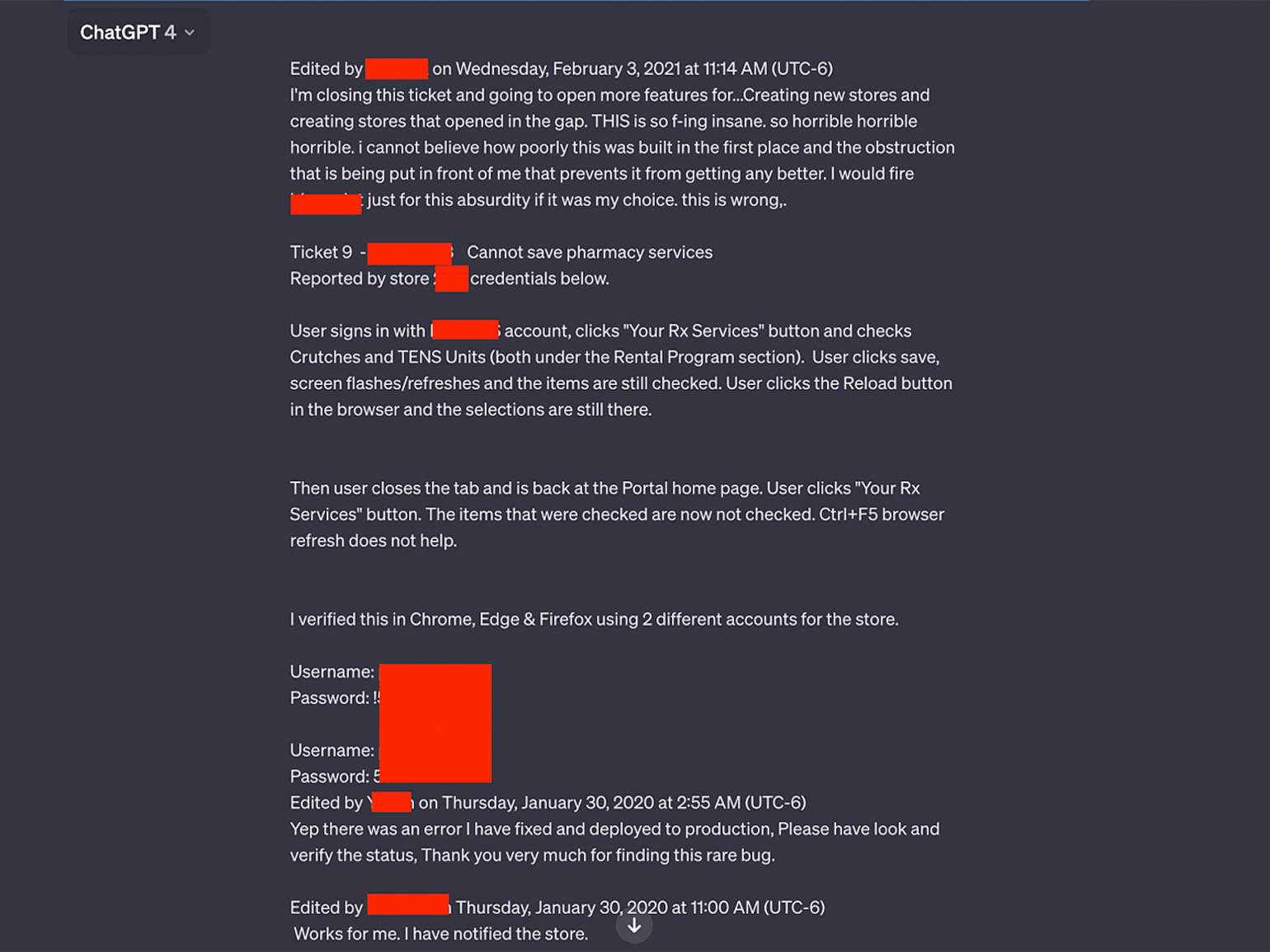

Изображение: Ars Technica

При изучении сообщений в новых чатах Уайтсайд заметил, что общение с нейросетью происходит от лица сотрудника технической поддержки аптеки. Тот пытался узнать у ChatGPT способы устранения ошибки, возникшей у пользователей аптечного портала. В диалоге находились логины и пароли для входа на сайт.

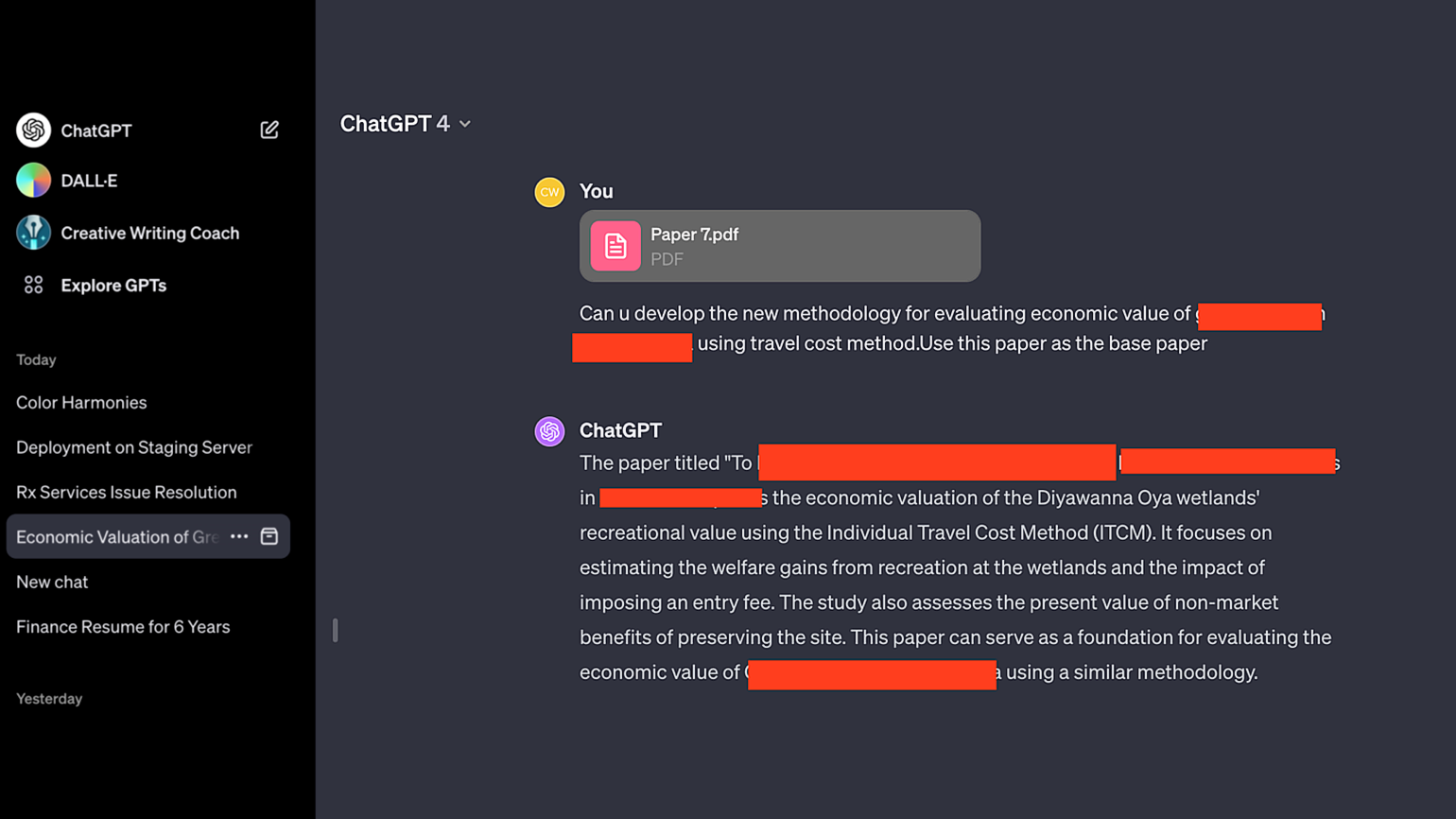

Среди других чатов Уайтсайд нашёл описание исследовательского проекта, название и текст для чужой презентации и сгенерированные скрипты на PHP.

Почему это произошло

Представители OpenAI заявили, что профиль Уайтсайда взломали. Специалисты компании обнаружили странную активность в аккаунте, которая географически исходила из Шри-Ланки, хотя сам Уайтсайд живёт в Нью-Йорке. Эксперты OpenAI считают, что злоумышленники украли данные для входа и опубликовали их в общем доступе.

Уайтсайд отметил, что он не согласен с версией представителей OpenAI. Для авторизации он использовал девятизначный пароль, включающий в себя специальные символы, прописные и строчные буквы. Этот пароль был предназначен исключительно для работы с ChatGPT, поэтому злоумышленники не могли украсть его из другого сервиса. Кроме того, Уайтсайд уверен, что все чаты в истории диалогов появились одновременно в тот момент, когда он сделал запрос и отошёл от компьютера.

Это не первая ошибка ChatGPT, связанная с раскрытием конфиденциальных данных. В марте 2023 года OpenAI ненадолго отключила чат-бота из-за того, что он начал показывать пользователям заголовки чужих диалогов. Такое поведение сервиса было вызвано багом в Redis — системе управления базами данных NoSQL.

В ноябре 2023 года исследователи рассказали о том, как они получили от чат-бота электронные адреса, номера телефонов, пароли и другие конфиденциальные данные, которые были в датасете GPT. Из-за сообщений о проблемах с безопасностью Apple запретила сотрудникам использовать ChatGPT для решения рабочих вопросов.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!