Современные нейросети изменяют любые изображения, не оставляя после себя следов. Полученные в результате дипфейки можно использовать для разных целей — от безобидной смены собственного аватара в социальных сетях до шантажа. Как предупредить злоупотребление?

Можно научить другие ИИ-модели отличать оригинальные изображения от дипфейков. А можно пойти другим путём и защитить сами фотографии от редактирования. Именно так решили поступить исследователи из MIT, разработав PhotoGuard.

Как работает PhotoGuard

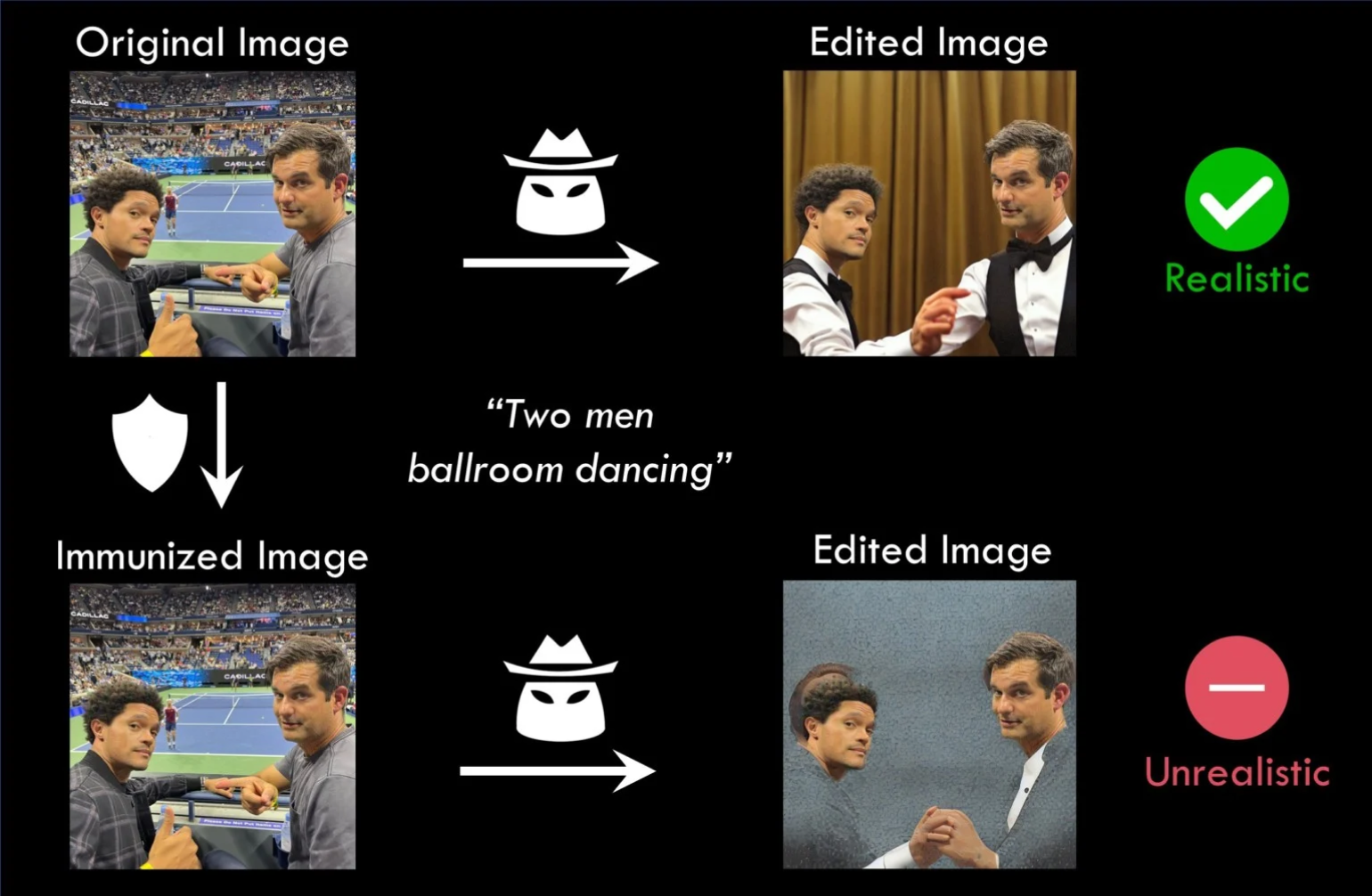

В основе нового инструмента лежит методика, использующая возмущения — незначительные изменения значений пикселей, невидимые человеческому глазу, но обнаруживаемые ИИ-моделями. Они нарушают способность AI редактировать исходное изображение или приводят к нереалистичному результату.

Изображение: Hadisalman / GitHub

PhotoGuard использует два метода защиты изображений от изменений. Первый метод под названием «кодировщик» (encoder) меняет характеристики отдельных пикселей. Визуально изображение не меняется, но модели ИИ перестают правильно интерпретировать картинку и не могут её отредактировать. Это можно сравнить с грамматически неправильным предложением — человек легко понимает его смысл, но языковая модель будет сбита с толку.

Второй метод — диффузия (diffusion)— сложнее: он подбирает для исходного изображения другое изображение, которое для человека визуально не отличается от первого. Но когда ИИ-модель пытается изменить его, то получается нереалистичный результат.

Вот как это выглядит на практике:

Исследователи MIT подчёркивают, что PhotoGuard не обеспечивает полной защиты от редактирования изображений. Исходную фотографию можно повернуть, наложить шум или воспользоваться другими инструментами, которые снижают эффективность нового инструмента.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!