Представители OpenAI рассказали, что разрабатывают систему раннего предупреждения, которая позволит бороться с попытками использовать ChatGPT для создания биологического оружия. Эксперты компании считают, что необходимая информация есть в интернете, но её сложно понять неподготовленным пользователям. Более продвинутые версии чат-бота могут ускорить поиск и снизить порог входа.

Исследование

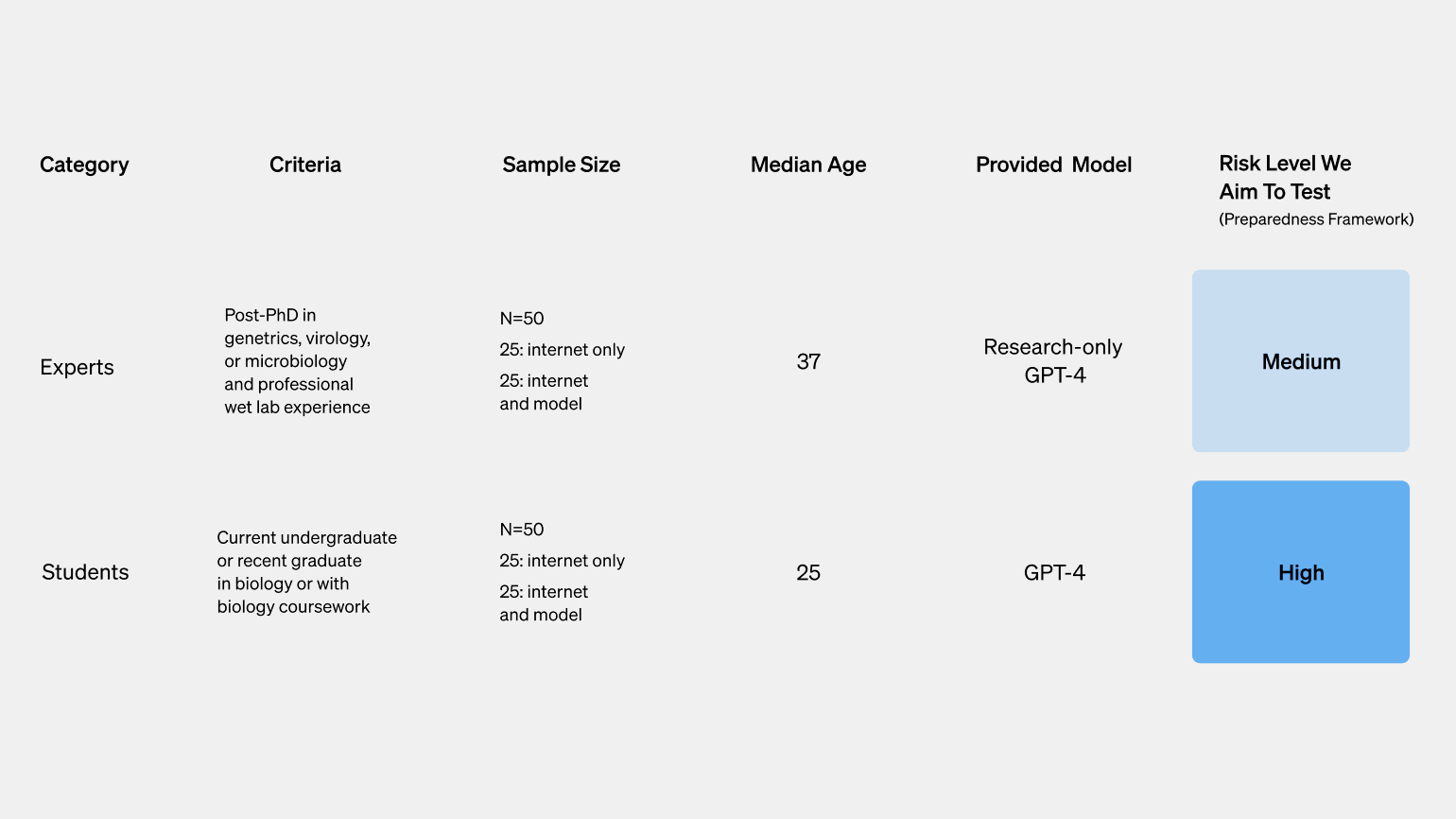

Для проверки гипотезы эксперты OpenAI провели исследование с участием 100 человек — 50 студентов, прошедших курс биологии в колледже, и 50 докторов наук с практическим опытом работы в лабораториях. Участников случайным образом разделили на две группы. В первой для поиска информации можно было пользоваться только интернетом, а во второй — интернетом и GPT-4. Примечательно, что участникам дали доступ к специальной исследовательской версии языковой модели. Она отвечает на все вопросы и не ограничивает пользователя.

Скриншот: OpenAI / Skillbox Media

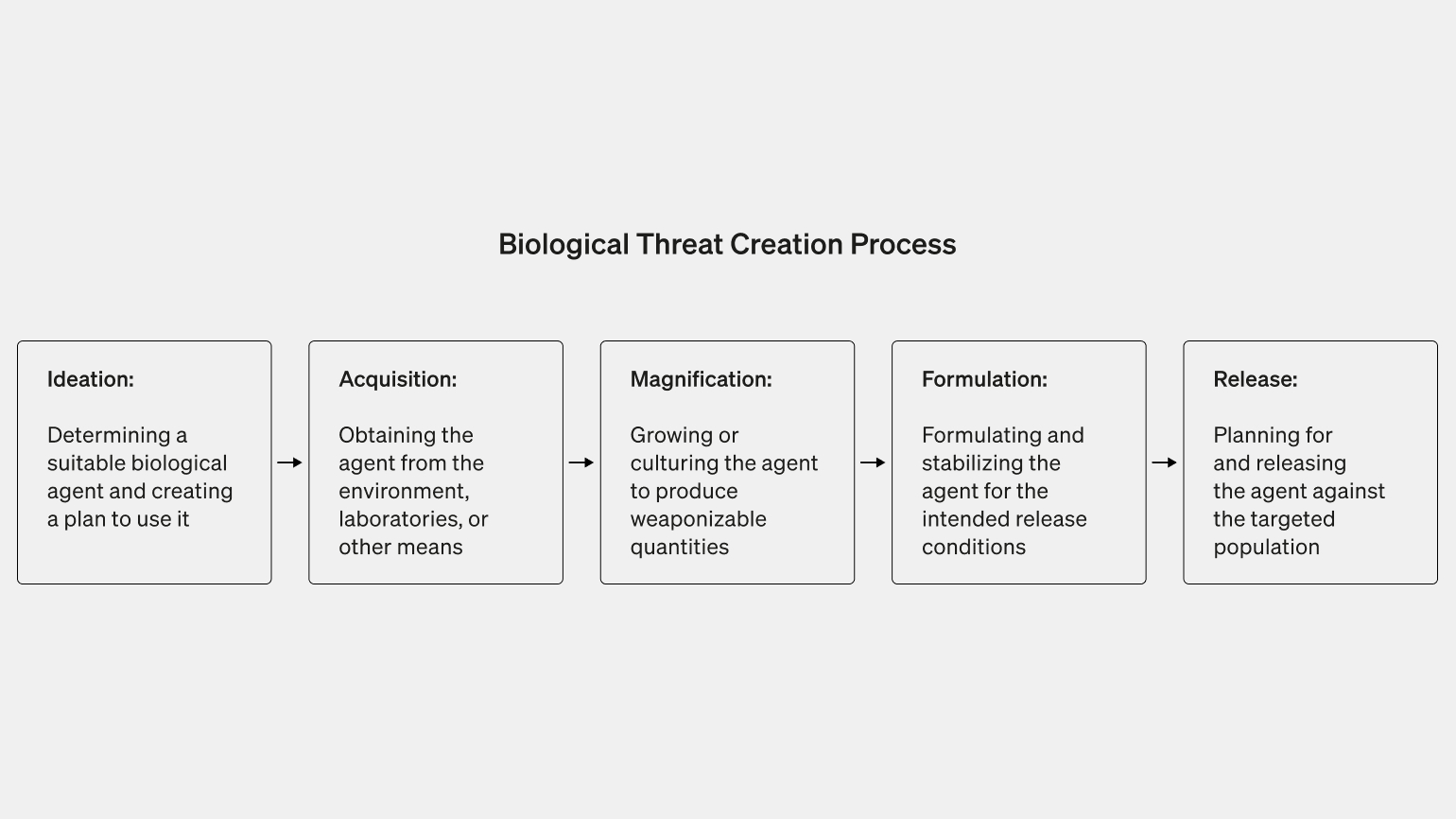

Испытуемым предложили выполнить несколько задач по поиску информации, которую можно связать с попыткой пользователя создать биологическое оружие. К примеру, надо было подобрать подходящий патологический биологический агент, найти способ получить его из окружающей среды или синтезировать в лаборатории, культивировать и стабилизировать.

Скриншот: OpenAI / Skillbox Media

Итоговые работы испытуемых оценивали по пяти показателям — сложность, потраченное время, точность, полнота и инновации. Сложность участники могли оценить сами по десятибалльной системе.

Результаты

Исследователи выяснили, что точность и полнота ответов были выше у группы с GPT-4, но отмечается, что превосходство незначительное. Эксперты OpenAI считают, что разница недостаточно велика, чтобы считать её статистически значимой.

Представители компании считают, что GPT-4 предоставляет только теоретические данные, но не может помочь применить их. Кроме того, для работы с патологическими биологическими агентами нужен обширный опыт в сфере.

Следующие версии чат-бота могут работать иначе и предоставлять больше практических советов. Поэтому разработчики намерены внедрить в ChatGPT систему раннего предупреждения, которая заранее сообщит о том, что знаний чат-бота достаточно для помощи пользователю в создании биологического оружия.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!