Исследователи из Школы управления «Сколково» и Тюменского государственного университета сравнили разные генеративные нейросети для образовательных задач. Основной частью этого проекта был учебный курс с чат-ботом на основе ИИ вместо преподавателя, а затем авторы определили, какие ИИ-модели дают наиболее полезные ответы на вопросы студентов. Отчёт с результатами исследования доступен на сайте школы.

Как провели эксперимент

Курс с ИИ-преподавателем «Биология поведения человека» на бизнес-бакалавриате Школы управления «Сколково» и МФТИ — только один из экспериментов, в которых чат-ботам на основе генеративных нейросетей выборочно передавали преподавательские функции. Подробнее о замысле и первых выводах из этих экспериментов рассказала ранее в интервью Skillbox Media директор Школы образования и Центра образовательных разработок на основе технологий искусственного интеллекта в составе Школы перспективных исследований ТюмГУ Ульяна Раведовская.

Курс «Биология поведения человека» представлял собой недельный интенсив для студентов бакалавриата — его ввели в программу для формирования у будущих предпринимателей более глубокого понимания поведения человека. В 2023 году его проводили в обычном формате, с лекциями преподавателя, а в 2024-м — с ИИ-персоной по имени Роберт.

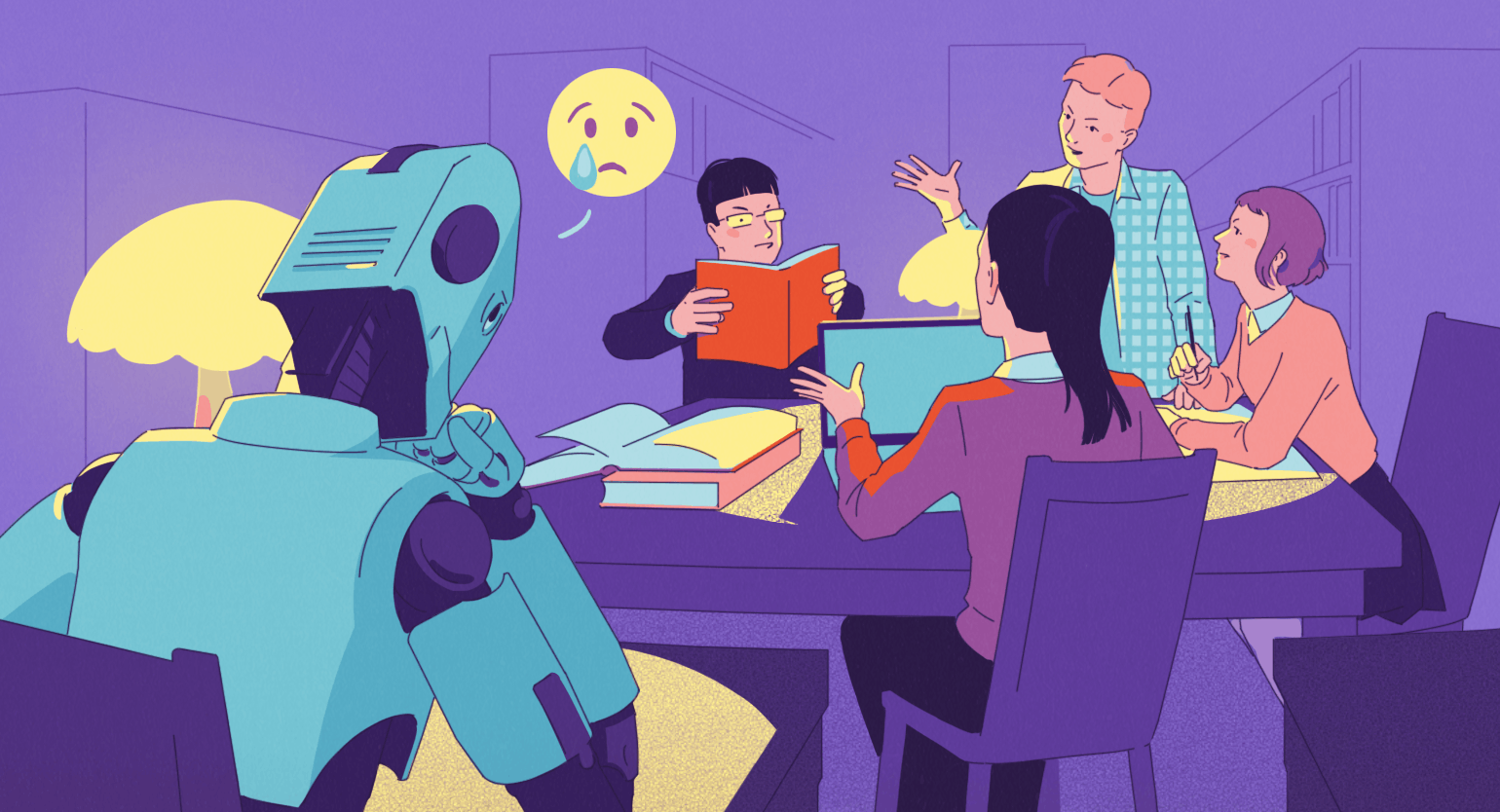

Роберт не читал лекций, интенсив проводили в формате перевёрнутого класса. Чтобы решить кейсы, поучаствовать в групповой дискуссии и выполнить индивидуальные задания, студенты готовились заранее по книгам, видеолекциям и статьям. Человека-преподавателя на курсе не было, но учащимся помогал в организации занятий медиатор — профессиональный педагог, однако не специалист по биологии. Поэтому и на занятиях, и при самостоятельной подготовке студентам приходилось обращаться к ИИ-персоне как к источнику знаний, так как задать вопросы по теме больше было некому.

Интервью со студентами после окончания курса показали, что с помощью ИИ-персоны они хорошо освоили темы курса. Они лучше, чем предыдущий поток, запомнили основные идеи и научились оперировать научной терминологией. Однако обучение в таком формате многим не понравилось. Учащимся, по их словам, не хватало авторитета в предметной области — эксперта, который мог бы точно сказать, что правильно, а что нет. Ответам чат-бота они не очень доверяли и в целом чувствовали себя растерянными.

В подкасте «Позовите человека» организаторы сообщили, что подробные ответы ИИ-персоны, в которых тема раскрывалась с позиций разных дисциплин, казались студентам слишком расплывчатыми. И за конкретикой они шли к другим, неспециализированным инструментам на основе генеративных нейросетей.

Что показало сравнение разных ИИ-моделей

Исследователи решили проверить, на самом ли деле ответы чат-бота, в основе которого лежит специализированная ИИ-модель, проигрывают результатам обычных, доступных массово чат-ботов. Для этого провели дополнительные эксперименты.

Вначале эксперты по биологии с помощью ИИ составили 1782 вопроса по темам курса. На них ответили пять разных версий ИИ-персоны Роберта — на основе Gemini 1.5 Pro, ChatGPT-4o, Claude 3.5 Sonnet, YandexGPT Pro 4 поколения и GigaChat Pro. Затем полученные ответы оценили эксперты (им не сообщили, какой модели какой ответ принадлежит) и выбрали из них лучшие как в целом, так и по различным критериям. Согласно итоговому рейтингу по усреднённым оценкам экспертов, лучшие результаты в общем показала YandexGPT.

Затем те же ответы проверила настроенная оценивать их по тем же критериям модель GPT-4o Mini. Она оценила ответы совершенно иначе — победителем в итоговом зачёте здесь оказалась ChatGPT-4о. Это заставило исследователей задуматься над субъективностью оценок ИИ (получается, GPT-4o Mini выбрала своего «сородича»).

Несмотря на разрыв в качестве ответов, которые дали разные ИИ-модели, получены они все были в одной когнитивной архитектуре чат-бота. ИИ-персона Роберт разработана в подходе с генерацией, дополненной поиском (Retrieval-Augmented Generation, RAG). Подход RAG подразумевает, что для ответа на вопрос чат-бот обращается к внешним базам данных. У Роберта это были базы по разным научным дисциплинам: генетика, зоосоциология, нейронаука, эндокринология, молекулярная генетика, патология, поведенческая эволюция и нейролингвистика. Для каждого запроса бот выбирал три наиболее близкие к его теме базы и обращался к ним по очереди, то есть готовый ответ бот конструировал в каждом случае из трёх дисциплинарных перспектив. Именно такая разносторонняя подача, видимо, и отпугивала студентов, желавших получить один ясный ответ.

Но какие именно ответы получали студенты, когда в поисках простых объяснений обращались не к ИИ-персоне Роберту, а к доступным онлайн чат-ботам? Чтобы выяснить это, исследователи сравнили ответы моделей, оказавшихся лучшими, согласно оценке GPT-4o Mini в предыдущем эксперименте, с ответами на те же вопросы от неспециализированной модели OpenAI o3-mini-high. Сравнивала ответы по заданным критериям вновь нейросеть. Ответы моделей, работавших в подходе RAG, оказались по всем критериям лучше, чем у неспециализированной нейросети. Так, по критерию «Соответствие научному стилю речи и способу аргументации» Claude 3.5 Sonnet во всех случаях получила оценку выше, чем OpenAI o3-mini-high. По критерию «Междисциплинарность» неспециализированную модель в 96,7% случаев обошла ChatGPT-4o.

Однако по критериям «Понятность» и «Конкретность» у победителя предыдущего эксперимента GigaChat Pro побед над OpenAI o3-mini-high оказалось заметно меньше. В 65,5% случаев GigaChat опередил неспециализированную модель по понятности и лишь в 50,5% ответов — по конкретности. Так что у недовольства студентов ответами ИИ-персоны Роберта были, вероятно, основания.

Но авторы исследования считают широту и междисциплинарность ответов (пусть и в ущерб ясности) не проблемой, а преимуществом подхода RAG. Они полагают, что включать нейросети в образовательный процесс надо не для того, чтобы настроить студентов на зазубривание, а чтобы «научить учиться, задавать вопросы, разбирать противоречивую информацию, строить суждения в сотрудничестве с ИИ».

Ранее американские исследователи обучили ИИ-модель оценивать развёрнутые работы школьников по физике и выяснили, что её оценки редко совпадают с теми, которые выставляют профессиональные учителя. Немного повышают точность примеры критериев, по которым нужно оценивать работы, а вот примеры проверенных заданий с выставленными оценками этому не помогают.

Больше интересного про образование ― в нашем телеграм-канале. Подписывайтесь!

Читайте также: