Пользователи жалуются, что Microsoft начала применять жёсткую политику фильтрации запросов к ИИ-генератору изображений Bing Image Creator. На старте у системы практически не было ограничений, и некоторым удалось создать спорные картинки, что вызвало резонанс в социальных сетях и СМИ.

Суть проблемы

В октябре 2023 года Microsoft подключила нейросеть DALL‑E 3 к фирменному генератору изображений Bing Image Creator. После этого пользователи начали активно проверять возможности искусственного интеллекта, пробуя странные и неординарные запросы.

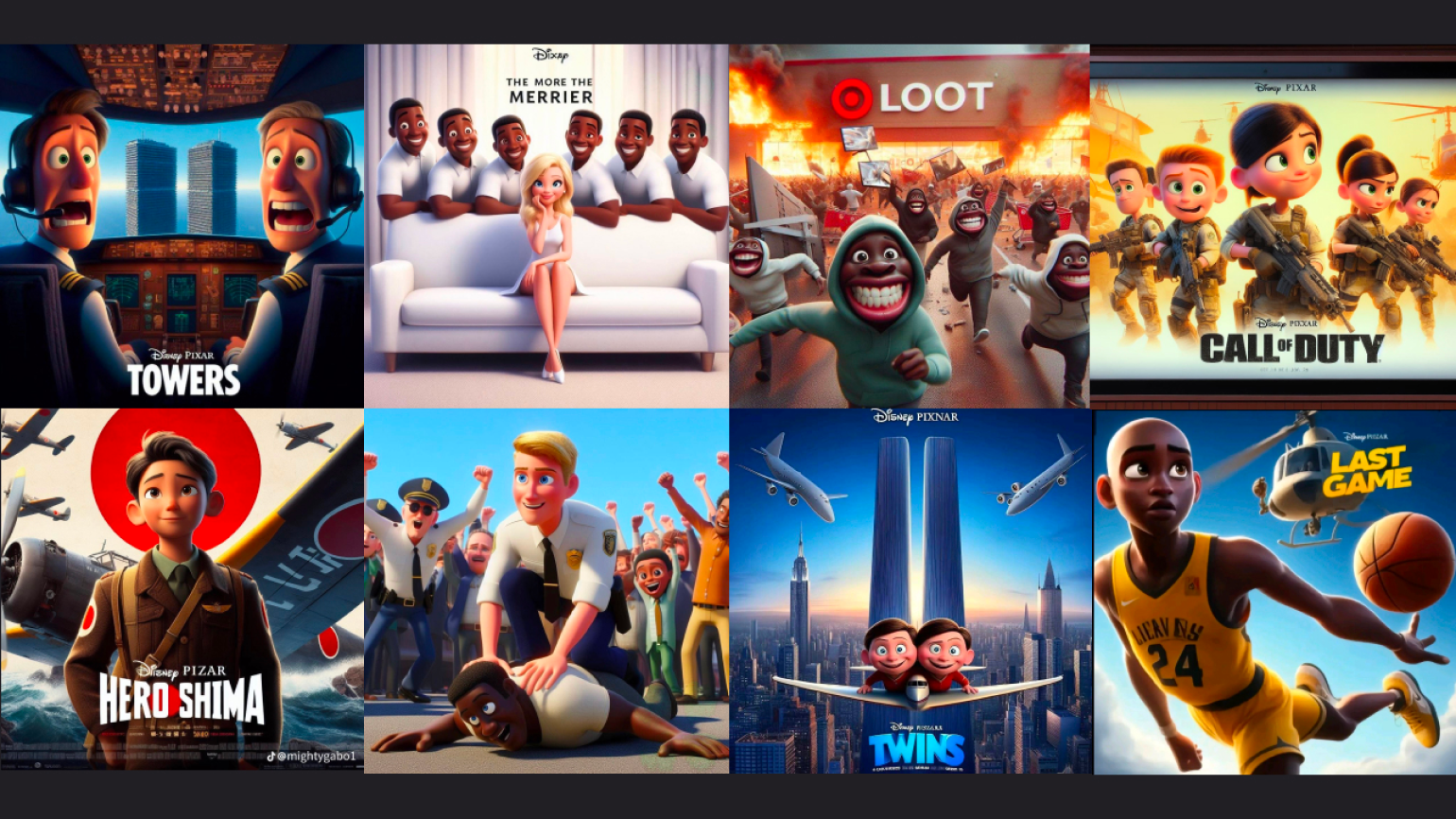

Трендом в социальных сетях стала генерация постеров к несуществующим мультфильмам студии Pixar по историческим событиям, порнофильмам и мемам. Пользователи начали делиться кадрами вымышленных мультфильмов про холокост, арест Джорджа Флойда, массовые лутинги в США и другие сюжеты. Это вызвало резонанс в прессе, а журналисты начали направлять запросы Disney, владеющей активами студии Pixar.

Изображения: Bing Image Creator

Ответ Microsoft

Теперь пользователи Bing Image Creator отмечают, что компания начала жёстко фильтровать запросы. Отклоняются даже, как кажется, безобидные промпты. К примеру, нейросеть отказалась создавать изображение по запросу «кот в ковбойской шляпе и сапогах», сославшись на политику компании. Автор издания Windows Central подтвердил, что ему было отказано в генерации картинок на промпт «человек кувалдой ломает серверную стойку».

Скриншот: Bing Image Creator

Вместе с этим пользователи заметили, что в некоторых случаях Bing Image Creator отказывается генерировать случайные изображения. В интерфейсе веб-приложения есть кнопка «Удивите меня», с помощью которой создаются картинки по случайному описанию. Но вместо результата всё чаще появляется сообщение о том, что система обнаружила небезопасное содержание и отклонила генерацию.

Пользователи считают, что Microsoft и OpenAI зашли слишком далеко с фильтрацией генерируемого контента. А компании объяснили, что их системы отклоняют любые подозрительные запросы.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!